もくじ

- 「HDDは“壊れる前提”の部品」なのに、なぜ現場は毎回つらいのか

- まず切り分ける:論理障害と物理障害は“別の事故”として扱う

- よくある故障原因:温度・振動・電源・経年劣化という地味な敵

- 兆候の読み取り:SMART、異音、遅延、CRCエラーは“例外ログ”

- やってはいけない初動:再起動・chkdsk・デフラグが被害を増やす理由

- 目的は復旧か継続運用か:最短で意思決定するための優先順位

- 現場向けの安全な手順:Write Block、イメージ取得、検証の型

- 復旧が難しくなる分岐:暗号化・TRIM・不良セクタ拡大・上書き

- 再発防止の設計:バックアップ、冗長化、監視、交換サイクルの現実解

- 帰結:HDD故障は“運用設計の不具合”として潰せる(そして相談先を持つ)

【注意】 ハードディスク故障の初動対応を誤ると、データの損失・流出が拡大し、復旧難易度とコストが跳ね上がることがあります。業務影響が大きい場合や判断に迷う場合は、株式会社情報工学研究所のような専門事業者へ早めに相談してください。

「HDDは“壊れる前提”の部品」なのに、なぜ現場は毎回つらいのか

サーバやNASの運用をやっていると、ハードディスク(HDD)は「いつか壊れる」こと自体は常識です。なのに、いざ故障っぽい挙動が出ると、現場は毎回しんどい。ここには、知識不足というより「現実の制約」があります。

たとえば、レガシーな業務システムほど停止できません。保守期限が切れかけている、構成が複雑、置き換えが難しい、影響範囲が読めない。そこにHDDの異常(遅い、I/Oエラー、異音、RAIDのDegradedなど)が混ざると、技術的には分かっていても心理的に焦ります。

心の会話はだいたいこうです。

- 「また夜間対応か……。誰が明日も回すんだっけ」

- 「“再起動したら直る?”って言われても、直らない方が怖いんだよな」

- 「バックアップはあるはず。でも“いまの状態”が取れてる保証は?」

こう感じるのは自然です。HDD故障の怖さは、単に部品が壊れることではなく、壊れ方が連続的で、判断の猶予を奪う点にあります。軽い読み取りエラーが、時間の経過や再試行で悪化し、気づいた時には「読めない領域が増えていた」ということが起きます。

最初に整理したい「目的」:復旧か、継続運用か

現場が最初に決めるべきは、正しさよりも「目的」です。目的が曖昧だと、対応がブレて被害最小化(ダメージコントロール)ができません。

- 最優先がデータ復旧:まず“現状を悪化させない”ことが勝ち筋。不要な書き込みや再試行を抑え、取り出しの成功率を上げる。

- 最優先がサービス継続:冗長化やフェイルオーバーを前提に、交換・再同期へ誘導。ただし「継続のための操作」が復旧の邪魔になることもある。

この二つは両立する場合もありますが、故障の種類や構成(単体HDD、RAID、仮想基盤、NAS、暗号化の有無など)によってはトレードオフが出ます。だからこそ、まずは“空気を落ち着かせる”ために、判断軸を一つ置くのが大事です。

この記事のゴール:原因の理解より「再現性のある初動」と「設計で潰す」

本記事は、HDD故障の原因を説明するだけでなく、現場で再現性のある初動(やる/やらない)と、再発を減らす運用設計までを一本の線でつなぎます。最終的な帰結はシンプルです。

HDD故障は“運用設計の不具合”として潰せる領域が多い。ただし、個別案件では状況依存が大きく、一般論だけで安全に結論を出せない場面があります。終盤ではその「一般論の限界」と、専門家へ相談すべき判断ポイントも整理します。

まず切り分ける:論理障害と物理障害は“別の事故”として扱う

HDDトラブル対応で最初に必要なのは、細かい原因究明よりも事故種別の切り分けです。大きくは「論理障害」と「物理障害」。この二つは“別の事故”で、適切な手順も、やってはいけないことも変わります。

論理障害:媒体は読めるが、意味が読めない

論理障害は、HDD自体の読み取りはできるのに、ファイルシステムやパーティション、メタデータが壊れていてOSが正しく解釈できない状態です。代表例は、誤削除、フォーマット、パーティションテーブル破損、ファイルシステム不整合などです。

ただしここで重要なのは、論理障害“に見える”だけで、裏に物理劣化が潜んでいることがある点です。読み取りエラーや遅延が出ているなら、論理修復を急ぐほど危険になります。

物理障害:媒体そのものが不安定、読めない・読むほど悪化する

物理障害は、ヘッド・プラッタ・モータ・基板などの故障、あるいは不良セクタの増大など、HDDの物理的な読み取りが不安定な状態です。症状としては、異音、認識不良、I/Oエラー、極端な遅延、SMARTの劣化指標、RAIDの頻繁なリビルド失敗などが挙げられます。

物理障害っぽいときにやるべきことは「復旧を急ぐ」ではなく、まず悪化を抑え込み、安全に取り出すルートを選ぶことです。

現場の初動をブレさせないための対応表

| 観点 | 論理障害が主 | 物理障害が疑い強 |

|---|---|---|

| 典型症状 | 認識は安定/特定フォルダだけ見えない/削除・上書きの心当たり | 異音/認識が揺れる/I/Oエラー/極端に遅い/SMART警告 |

| 最優先 | 書き込みを止め、現状維持。可能ならイメージ取得。 | 通電・再試行を増やさない。まずイメージ化方針(必要なら専門対応)。 |

| 避けたい操作 | 修復系コマンドの“ノリ実行”(状況確認前の修復) | chkdsk/fsck/デフラグ/クローンを無計画に連発、再起動連打 |

| 判断の鍵 | 読み取りが安定しているか/エラーが増えていないか | 読み取りエラー・遅延が増えるか/異音・温度・SMARTの変化 |

「やってはいけない」代表:修復を先に走らせる

現場でよく起きる事故は、状況が分からないまま、OSやツールが提案してくる「修復」を実行してしまうことです。修復系の処理は、メタデータ更新や再配置などの書き込みを伴う可能性があります。論理障害の復旧では、まず“読み出し優先”が基本ですし、物理障害が混ざっていると書き込み以前に読み取り自体が危険です。

ここでの合言葉は「まず現状を固定する」。つまり、書き込みを止め、取得できるならイメージ(セクタ単位の複製)を先に作る。これが後続の選択肢を増やします。

迷ったら、判断材料を増やす(ただし安全に)

「論理か物理か、判断がつかない」ことは普通にあります。健全な疑いです。そんなときは、やみくもに操作を増やすのではなく、安全に取れる情報だけ先に集めます。

- SMART情報(取得できる範囲で)

- OSログ(I/Oエラー、タイムアウト、再試行、CRCエラーなど)

- RAID/NASの状態(Degraded、Rebuild中、Failしたディスク番号など)

- 最近の変更(停電、移設、温度上昇、ケーブル交換、バックアップジョブ変更)

そして、業務影響が大きい/物理疑いが強い/暗号化や仮想基盤が絡む、といった条件があるなら、早めに専門家に相談するのが結果的に最短です。ここでの狙いは、場を整えて“取り返しのつかない一手”を避けることです。

よくある故障原因:温度・振動・電源・経年劣化という地味な敵

HDD故障というと、派手なクラッシュを想像しがちですが、現場で効いてくるのは地味な要因の積み重ねです。温度、振動、電源品質、そして経年劣化。ここを押さえると、対策が「精神論」ではなく「設計」に落ちます。

温度:高温も低温も、安定性を削る

HDDは回転体で、機械的な余裕が少ない部品です。温度が上がると、部品の劣化が進みやすくなり、読み取りの安定性も落ちます。一方で、極端な低温や急激な温度変化も結露など別のリスクにつながります。

対策はシンプルで、温度を見える化して、上限を運用で守ることです。ケース内温度・吸気排気・ラック内のホットスポットを監視し、しきい値を超えたらアラートを出す。ファン故障や埃詰まりは、静かに効いてきます。

振動・衝撃:ラックの“ちょい揺れ”が積み上がる

デスクトップ用途でも、HDD稼働中の移動や落下は致命傷になります。サーバ用途では「常に固定されている」ように見えても、ラックの振動、近接機器のファンや共振、移設作業時の取り扱いなど、細かい要因が積み上がります。

対策は、物理設置の標準化です。固定具、トレイ、ダンパ、ケーブルの取り回し。さらに、保守作業の手順(稼働中に触らない、交換時はラベルと順番、戻し忘れ防止)をルール化します。こういう“地味な統制”が、後から効きます。

電源:瞬断・電圧降下・ノイズは、ログに残りにくい

電源トラブルは、派手に落ちる場合だけでなく、瞬断・電圧降下・ノイズのように「なんとなく不調」を作る形でも現れます。HDDは書き込みキャッシュやヘッド退避など、電源品質に依存する動作があります。ここが乱れると、ファイルシステム破損(論理障害)として表に出ることもあります。

対策は、UPSの導入だけでは終わりません。UPS自体のバッテリ劣化、PDU、電源冗長、サージ保護、アース、そして停電時のシャットダウン連携まで含めて、設計として整える必要があります。

経年劣化:避けられないなら、交換サイクルに落とす

経年劣化は避けられません。だから“運が悪かった”で終わらせず、交換計画に落とします。現実的には、24/7稼働、負荷、温度、振動などで寿命は変動します。重要なのは「壊れてから慌てる」ではなく「壊れる前提で余裕を作る」ことです。

- 重要データは冗長化(RAIDだけでなくバックアップも別系統)

- 監視で兆候を拾う(SMART、I/Oエラー、再試行、遅延)

- 保守窓を確保し、計画交換できる体制を作る

原因に対する“現場で効く”予防チェックリスト

ここまでの内容を、現場で回しやすい形にまとめます。全部を一度にやろうとすると続かないので、まずは“歯止め”として最小セットを決めるのがコツです。

- 温度:ラック/筐体温度の監視とアラート、吸排気の詰まり確認

- 振動:ラック固定、ケーブル整線、保守作業の手順化(稼働中に触らない)

- 電源:UPS・PDU含む点検、停電時の安全停止、電源冗長の確認

- 経年:台帳(型番・導入日・稼働時間)と計画交換、予備ディスクの確保

次章では、これらの予防が「なぜ間に合わないのか」を、兆候(SMART、異音、遅延、CRCエラー)という観点で整理します。兆候は“仕様外入力”のように現れます。見えたときの読み方を揃えると、被害最小化がしやすくなります。

兆候の読み取り:SMART、異音、遅延、CRCエラーは“例外ログ”

HDD故障の厄介さは、「壊れた/壊れていない」が二値で出ないことです。多くの場合、最初は“挙動のにじみ”として現れます。ここを読み取れるかどうかで、被害最小化(ダメージコントロール)が効きます。

現場の感覚としては、アプリの例外ログに近いです。例外が一回出ただけで即死ではない。でも、例外の種類と頻度が変わってきたら、放置できない。HDDの兆候も同じで、兆候を「ログ」として扱い、判断ルールを揃えるのが重要です。

SMART:万能ではないが、見える指標は使う

SMARTは、HDDが内部的に持っている自己診断情報です。代表的な項目には、不良セクタに関するカウント、読み取りエラー、再試行、温度、通電時間などがあります。

ただし、SMARTは「これさえ見れば未来が分かる」ものではありません。故障が近いのにSMARTが静かな場合もありますし、逆にカウントが増えたままでも運用継続できているように見える場合もあります。だからこそ、SMARTは“単独で結論を出す”のではなく、他の兆候と合わせて扱うのが現実的です。

- SMARTの不良セクタ関連が増加している

- OSログのI/Oエラーやタイムアウトが増えている

- 体感レベルで遅延が出ている(バックアップやスキャンが極端に遅い)

このように複数が揃ったら、現場の行動は「原因究明」より「悪化を抑え込む」に寄せるべきです。

異音:音は“物理”のサインになりやすい

異音は、物理障害を疑う強い根拠になりやすいです。もちろん音の感じ方は主観も入りますが、普段と違う連続的な音、繰り返しパターンがある音、起動と停止を繰り返すような挙動がある場合は、通電・再試行の回数を増やすほど不利になりがちです。

ここでの心の会話はこうなります。

- 「でも、再起動で認識するかもしれないし……」

- 「一回だけ試してみる?」

この“ひと押し”が悪化要因になることがあります。物理障害の可能性が高いなら、まずはブレーキを踏む。そして、状況(構成、重要度、バックアップ状況、暗号化の有無)を整理したうえで、イメージ取得の可否や専門対応の要否を判断します。

遅延:最初に出ることが多い“現場の違和感”

遅延は、現場が最初に気づきやすい兆候です。バックアップが予定より伸びる、ファイル一覧表示が固まる、アプリがI/O待ちでタイムアウトする。こうした“体感”は、ログに残る前に出ることがあります。

遅延が出たときに重要なのは、次の二点です。

- 遅延が局所か全体か(特定ディレクトリや特定LBA付近で詰まるのか)

- 遅延が増えているか(数日単位で悪化傾向があるか)

局所的な遅延がある場合、不良セクタや読み取り再試行が起きていることがあります。この状態で「スキャン系」「整合性チェック系」「修復系」を走らせると、詰まりポイントに対して読み取りが集中し、状態が悪化することがあります。

CRCエラー:ディスクだけが犯人とは限らない

ログにCRCエラー(たとえばSATAのCRC error countなど)が出る場合、HDDの劣化だけでなく、ケーブルやコネクタ、バックプレーン、コントローラ側の問題も疑います。ここは“部品交換で直る”ケースもあり、原因の切り分けとして価値があります。

ただし、ケーブル交換や差し直し自体が、状態の悪いHDDにとってリスクになる場合もあります。特に、RAID構成や本番環境での作業は、手順のミスが即座に障害に直結します。作業するなら、

- どのディスク/どのポートかを明確化(ラベル、台帳、写真)

- 冗長性とリビルド条件を確認(ホットスワップ可否、再同期負荷)

- 作業前にバックアップ/スナップショットの状況確認

この“場を整える”工程が、結果的に最短になります。

兆候を「判断」へつなげる、実務向けルール例

兆候は、見えた瞬間に判断を強制します。だから、平時にルールを決めておくのが強いです。たとえば、次のように段階を定義します。

| レベル | 状態の例 | 推奨アクション |

|---|---|---|

| L1(注意) | SMARTの軽微な変化/単発の遅延/ログの軽微な警告 | 監視強化、バックアップの直近成功確認、保守窓の確保 |

| L2(警戒) | 遅延が継続/I/Oエラーが散発/不良セクタ関連が増加 | 書き込み抑制、イメージ取得検討、交換計画前倒し、専門相談の検討 |

| L3(危険) | 認識不安定/異音/I/Oエラー多発/RAID劣化+再同期失敗 | 通電・再試行を増やさない、現状固定、専門対応を優先 |

ここまでが「兆候を読む」章です。次章では、兆候が出たときに現場がついやりがちな“危険な初動”を、なぜ危険なのか(仕組み上の理由)とセットで整理します。要するに、焦りが操作を増やし、その操作が悪化要因になりやすい。ここにストッパーを入れるのがポイントです。

やってはいけない初動:再起動・chkdsk・デフラグが被害を増やす理由

HDD故障対応で一番の落とし穴は、「良かれと思った行動」が逆効果になることです。特に、再起動、chkdsk(Windows)やfsck(Linux)などの修復、デフラグ、そしてスキャン系のツール実行は、状況次第で復旧可能性を下げます。

ここで大事なのは、これらの操作が“悪い”のではなく、前提条件が揃っていない状態で実行すると危険だという点です。現場の焦りを否定する必要はありません。むしろ健全です。ただ、その焦りにブレーキをかけるために、理由を知っておくのが効果的です。

再起動:状態をリセットできるが、最後の読み取り機会を失うことがある

再起動は、OSやドライバの状態をリセットし、偶然うまく認識することがあります。だからこそ誘惑が強い。

- 「今だけ認識してくれれば、バックアップ取れるのに」

- 「一回だけなら……」

ただ、HDDが物理的に不安定な場合、再起動は“当たり”よりも“外れ”を引くリスクがあります。具体的には、起動時のスピンアップやキャリブレーションが負荷になり、認識しなくなる、異音が強くなる、読み取りがさらに遅くなる、といった事態が起き得ます。

再起動が有効なのは、原因がHDD以外(OSの一時不調、ドライバ、ケーブルの接触不良など)である可能性が高く、かつ再起動後に行う作業が明確(短時間でのイメージ取得など)な場合です。目的が曖昧なまま再起動を繰り返すのは、復旧可能性を削ります。

chkdsk / fsck:修復は「書き込み」を伴い得る

ファイルシステム修復は、整合性を回復させるためにメタデータを書き換えることがあります。論理障害が確定していて、かつ「復旧よりも正常運用の回復」が優先、さらにバックアップやイメージが確保できているなら、修復が合理的なケースもあります。

しかし、物理障害が混ざっている場合、修復は次の二重のリスクを持ちます。

- 読み取りが集中して悪化:不良セクタ付近にアクセスが集中し、再試行が増え、状態が悪化する。

- 書き込みで上書きが発生:復旧で必要になる情報(メタデータや残存領域)が書き換わる可能性がある。

「修復したら直るかも」は魅力的ですが、復旧という観点では“取り返しのつかない更新”になることがあります。だから、まずはイメージ化やバックアップ確保など、戻れる状態を作ってから判断するのが筋です。

デフラグ:最も避けたい“読み書きの総動員”

デフラグは、断片化を解消して性能を上げるために、データを大量に移動します。つまり大量の読み書きです。故障疑いのHDDに対してこれは、悪化を加速させる可能性が高い操作です。

特に、遅延やI/Oエラーが出ている状況でのデフラグは、被害最小化どころか「損失拡大」の方向に働きやすい。ここは明確にストッパーを入れてよいポイントです。

スキャン系・ウイルス対策・インデックス再構築:平時は良いが、緊急時は負荷

フルスキャン、バックアップの再試行、インデックス再構築、ログ収集ツールの全量取得なども、平時は正しいのに緊急時は負荷になり得ます。特に“遅い”兆候が出ている場合、スキャンは詰まりポイントに集中し、時間を奪い、状態を悪化させることがあります。

もちろん、セキュリティ事故が絡む場合は別の優先順位もあります。ただ、HDD故障対応としては、まず「現状を固定し、必要なものを最小限で取り出す」方針が安全です。

危険な初動を避けるための「最小手順」

ここまでを踏まえると、初動は極端に言えば次の3点に集約されます。

- 書き込みを止める(アプリ停止、サービス停止、マウントを読み取り専用へ、可能なら電源断の判断も含む)

- 状況を記録する(ログ、SMART、RAID状態、いつから、何をしたか)

- 取り出し方針を決める(イメージ取得/交換・再同期/専門対応)

この最小手順は、「いま操作したい」という衝動に対する“ブレーキ”になります。次章では、この方針を具体的な作業へ落とし込むために、Write Block(書き込み抑止)、イメージ取得、検証という“型”を紹介します。ここが、現場で再現性を作るポイントです。

目的は復旧か継続運用か:最短で意思決定するための優先順位

HDDの故障対応で現場が一番しんどいのは、技術よりも「意思決定の渋滞」です。判断が遅れると、やることが増え、確認が増え、関係者が増え、最後は“やれる人が燃え尽きる”形になりがちです。だから最初にやるべきは、正解探しではなく優先順位の固定です。

心の会話でいえば、こんな感じになります。

- 「復旧したい。でもサービスも止められない……どっちを優先する?」

- 「“早く直して”と言われても、直すほど悪化するケースがあるんだよな」

- 「バックアップは“ある”けど、“使える”のかは別問題」

こう感じるのは自然です。ここで大事なのは、HDD故障を“部品交換”ではなく、業務の継続条件(RTO/RPO)とデータの価値で整理することです。

最短で判断するための4つの質問

現場で会議を長引かせないために、次の4つだけ先に揃えると、意思決定が一気に進みます。

- 守る対象は何か:データ(整合性)か、サービス(可用性)か、証跡(監査・法令)か

- 戻れる地点はどこか:最後に成功したバックアップ/スナップショットはいつか

- 書き込みは続いているか:現状が悪化し続けていないか(ログ、トランザクション、同期)

- 暗号化・仮想化・冗長化の条件:BitLocker等の鍵、VM/RAID/NASの構造、再同期の可否

この4つが分かると、「復旧を優先して現状固定」か「継続運用を優先してフェイルオーバー」かの分岐が見えます。

実務で使える判断表(“今やること”を先に決める)

| 状況 | 優先 | まずやること | 避けたいこと |

|---|---|---|---|

| バックアップが直近で確実、復旧手順も検証済み | 継続運用 | 切替計画(フェイルオーバー/交換/再同期)を進める | 不安なまま本番で修復コマンド実行 |

| バックアップが古い/不明、データ価値が高い | データ復旧 | 書き込み停止、現状固定、イメージ取得を最優先 | 再起動連打、スキャン連発、デフラグ |

| RAID劣化で再同期が走るが、失敗し始めた | 被害最小化 | 再同期の停止可否検討、負荷抑制、専門相談を含め意思決定 | 状態不明のまま交換を繰り返す |

| 暗号化あり、鍵の所在が曖昧 | 証跡・手順 | 鍵/回復情報の確保、操作ログの記録、方針の合意 | 初動で上書き・初期化をしてしまう |

「技術の話」をする前に、合意しておくと楽になること

HDD故障対応は、技術議論が先行すると揉めやすいです。おすすめは、先に次を合意することです。

- 停止許容:何分/何時間まで止めてよいか(RTO)

- 許容損失:どこまでの更新が失われてもよいか(RPO)

- 判断責任:誰が“止める/進める”を決めるか(現場に押し付けない)

- 記録:何を・いつ・誰がしたか(後から説明できる形)

この合意があると、現場は“場を整える”ことに集中できます。次章では、そのための具体的な型として、Write Block(書き込み抑止)とイメージ取得、検証の流れを整理します。ここを押さえると、復旧作業が「勘」ではなく「手順」になります。

現場向けの安全な手順:Write Block、イメージ取得、検証の型

HDD故障対応を“再現性のある作業”にするなら、合言葉は「オリジナルに触らない」です。ここで言う「触らない」は、比喩ではなく技術的に「書き込み・過剰な再試行・無計画なスキャン」を避けるという意味です。安全側に倒して、後戻りできる手順を積む。それが結果的に最短になります。

手順の全体像:まずコピー(イメージ)を作り、作業はコピーに対して行う

典型的な型は次の通りです。

- 書き込み停止:サービス停止、マウント解除、可能なら読み取り専用へ

- 現状記録:症状、ログ、SMART、構成(RAID/VM/NAS)を控える

- Write Block:物理/論理的に書き込みを抑止(状況により手段は変える)

- イメージ取得:セクタ単位で別媒体へ複製(失敗に強い手段を選ぶ)

- 検証:ハッシュやサイズ、読み取り可能範囲を確認

- 復旧作業:ファイル救出、論理修復、解析は“イメージ側”で実施

この順序が崩れると、後で選択肢が減ります。特に「復旧作業を先にやる」「修復を先に走らせる」は避けたいパターンです。

Write Block:書き込みを“仕組みで止める”

書き込み停止は、気持ちだけでは守れません。OSやアプリが勝手にログを書いたり、マウント時にメタデータを更新したりすることがあります。だから、可能なら仕組みで“ブレーキ”をかけます。

- ハードウェアWrite Blocker:USB/SATA等で接続し、物理的に書き込みを遮断する機器

- 読み取り専用マウント:OS機能で読み取り専用にする(ただし万能ではない)

- 隔離環境:対象ディスクを本番から切り離し、解析専用環境で扱う

どれが正解かは、構成と緊急度次第です。たとえば、単体HDDをUSBケース越しに繋いで作業する行為は、ケース側の挙動や電源品質が不安定要因になることもあります。業務影響や重要度が高いほど、手順の選定自体を慎重にすべきです。

イメージ取得:失敗を前提にした“取り出し”を設計する

イメージ取得は、HDDが不安定でも「読めるところから先に確保する」ためのアプローチです。物理的に弱っている場合、全面を一気に読むよりも、失敗に強い読み取り戦略(読み飛ばし・再試行回数の制御・ログの保存など)が重要になります。

実務では、dd系のツールや、障害ディスクからの取得に強いツールが使われます。ただし、ツール名よりも大切なのは次です。

- 出力先は別の健全な媒体(十分な容量、安定したI/O)

- 取得ログを残す(どこで失敗したか、後で再開できるか)

- 再試行を増やしすぎない(不良部に固執すると全体が悪化する)

「全部救いたい」気持ちは分かります。でも、状態が悪いほど、まず“取れる範囲を最大化する”方が成功率は上がります。最初から100%を狙って固執すると、結果として0%になることがある。ここは現場が一番つらいところなので、方針を明文化しておくと揉めにくいです。

検証:イメージが取れたら、まず“安心できる状態”を作る

イメージが作れたら、次は検証です。ここでの目的は「復旧が完了した」ではなく、以後の作業を安全に進められる足場を作ることです。

- ファイルサイズ・ハッシュ等で整合性の確認(可能な範囲で)

- 読み取り不能領域の範囲確認(ログやマップ)

- 復旧作業はイメージ側で実施(オリジナルは保全)

心の会話としては、ここでやっとこう言えます。

- 「よし、これなら触っても戻れる」

- 「夜間に“もう一回試す”をやらなくて済む」

この“安心”が、運用を持続可能にします。次章では、復旧が難しくなる典型的な分岐(暗号化、上書き、劣化進行、構成の複雑化)を整理します。つまり、一般論の手順が通用しにくい領域です。そこを知っておくと、「どこから専門家へ相談すべきか」の線引きができるようになります。

復旧が難しくなる分岐:暗号化・不良セクタ拡大・上書き・構成の複雑化

ここまでの章は、できるだけ「再現性のある一般論」としてまとめました。ただ、現場で本当に困るのは、一般論が効きにくい分岐に入ったときです。復旧難易度が跳ね上がる典型パターンを先に知っておくと、無理な粘りで損失拡大を招く確率を下げられます。

暗号化:鍵が無いと“読めても意味が取れない”

BitLocker、FileVault、LUKSなど、ディスク暗号化が有効な環境では、復旧の前提条件が変わります。媒体としてセクタが読めても、鍵(回復キー、パスフレーズ、TPM連携情報など)が無ければ、取り出せるのは暗号文です。

ここでの落とし穴は、「HDD故障対応」と「鍵の管理」が別担当になっていて、初動で鍵の所在が曖昧なことです。

- 回復キーがどこに保管されているか(AD/Azure AD/台帳/紙)

- TPM+PINなど追加要素があるか

- OS起動不能時に鍵を取り出す手段があるか

暗号化が絡む場合、技術的な復旧以前に、鍵と運用の確認が必須です。ここは一般論だけで突っ込むと事故になりやすい領域なので、判断に迷った時点で専門家に相談する価値が高いポイントです。

不良セクタの拡大:時間と再試行が“敵”になる

不良セクタが増えている状況では、読み取りの再試行が増え、I/O待ちが長引き、全体の作業時間が伸びます。作業時間が伸びるほど、通電時間やアクセス回数が増え、さらに状態が悪化する、という悪循環が起き得ます。

このとき重要なのは、「全部取る」より「取れる範囲を確保する」へ方針を切り替えることです。現場の感情としてはつらいのですが、被害最小化(ダメージコントロール)としては合理的です。特に業務影響が大きい場合、粘り続けて何も残らないより、優先順位の高いデータだけでも確保する方が価値があります。

上書き:論理復旧の選択肢を削っていく

誤操作や自動処理でデータが上書きされると、論理復旧の難易度は上がります。典型は次のパターンです。

- 「容量不足解消」で不要ファイル削除やクリーンアップを実行した

- 障害対応中にアプリがログやDBを書き続けた

- 修復系ツールがメタデータを更新した(意図せず)

上書きが進むほど、復旧対象の痕跡は薄くなります。だからこそ、初動で書き込みを止めることが重要でした。これは精神論ではなく、仕組みの問題です。

構成の複雑化:RAID・仮想化・NASは“単体HDDの話”で終わらない

実務で多いのは、単体HDDではなく、RAID、仮想基盤、NAS、ストレージアプライアンスといった構成です。この場合、「壊れたディスクを抜いて別PCで読む」だけでは話が終わりません。

- RAIDのレベル、ストライプサイズ、順序、メタデータの位置

- リビルド中の負荷と、リビルド失敗時の扱い

- 仮想ディスク(VMDK/VHDX等)やスナップショットの整合性

- NAS固有のボリューム管理や暗号化設定

この領域では、一般的な手順が「安全」とは限りません。たとえば、ディスクの抜き差しや交換が、再同期をトリガーして負荷を上げ、別のディスクを巻き込むこともあります。現場で“雰囲気”で進めるほど事故になりやすいので、状況がこの分岐に入っているなら、早い段階で専門家に相談して、方針と手順を固定した方が結果的に速いことが多いです。

分岐を踏んだときの“相談判断”の目安

押し売りではなく現実の話として、次の条件が重なるほど、内製での判断は難しくなります。

- 暗号化があり、鍵の所在が不明確

- I/Oエラーや異音があり、物理障害の疑いが強い

- RAID/NAS/仮想化など、構成が複雑

- バックアップが古い/復旧手順が未検証

- 説明責任(監査・法令・顧客影響)が重い

こうした場合は、「自分たちで何とかする」より、「やってはいけない一手を避ける」ことに価値があります。株式会社情報工学研究所のような専門事業者に相談する意味は、まさにここにあります。次章では、こうした分岐を踏まえたうえで、再発防止を“設計と運用”に落とし込む方法(バックアップ、冗長化、監視、交換サイクル)を整理します。

再発防止の設計:バックアップ、冗長化、監視、交換サイクルの現実解

HDD故障は「いつか起きる」ので、原因分析だけで終わるとまた同じ苦しさが来ます。再発防止の本質は、“精神論”ではなく設計と運用の歯止めです。ここを整えると、障害が起きても「場が整っている」ので、被害最小化(ダメージコントロール)が効きます。

よくある誤解:RAIDがある=安心、ではない

RAIDは可用性の仕組みであって、バックアップの代替ではありません。RAIDは「ディスク1本の故障」には強い一方で、誤削除・論理破損・ランサムウェア・設定ミス・複数台同時劣化には弱いことがあります。現場でよく起きるのは、RAIDがあることで安心し、バックアップの検証が後回しになるパターンです。

| 仕組み | 守りやすいもの | 守りにくいもの |

|---|---|---|

| RAID(冗長化) | 単一ディスク故障への耐性、停止時間の短縮 | 誤削除、論理破損、暗号化被害、設定ミス、同時劣化 |

| バックアップ | 誤削除や論理破損からの復元、時点復元(RPOの確保) | 直近の更新、復元手順未検証、保管先の同時被害 |

| スナップショット | 短時間での巻き戻し、運用の手軽さ | 保持期間が短い運用、保管先が同一基盤だと同時被害 |

バックアップは「取っている」より「戻せる」が重要

バックアップで現場が詰むのは、次の瞬間です。

- 「バックアップはあるはず」→「最後に成功したの、いつだっけ?」

- 「戻せるはず」→「復元手順、誰が覚えてる?」

- 「検証したはず」→「その検証、今の構成でも通る?」

ここにストッパーを入れる現実解は、“定期的な復元テスト”を運用に組み込むことです。大規模にやらなくて構いません。たとえば、重要システムは月1回、代表データだけでも復元し、手順書と所要時間(RTO)を更新する。これだけで、障害時の判断が段違いに速くなります。

監視:SMARTだけでなく「遅延」と「エラー」を拾う

監視は、単にアラートを増やす話ではありません。目的は、現場が“気づいた時には手遅れ”を減らすことです。HDDは、完全に壊れる前に「遅延」「再試行」「I/Oエラー」「CRCエラー」などの兆候を出すことがあります。これらを拾えると、計画交換や負荷抑制に繋げられます。

- SMART(温度・不良セクタ関連・通電時間など)は“参考指標”として継続取得

- OSログ/ストレージログのI/Oエラー、タイムアウト、再試行の増加を監視

- バックアップジョブや整合性チェックの所要時間(遅延)をメトリクス化

ここでのコツは、アラートの“量”より“意味”です。L1/L2/L3のように行動へ結びつく運用ルールを決めると、警報疲れを避けやすくなります。

交換サイクル:台帳と保守窓をセットで持つ

経年劣化は避けられません。ならば、交換を“イベント”ではなく“定常運用”にします。そのために必要なのは、

- 台帳(型番、導入日、稼働時間、場所、用途、冗長構成)

- 予備部品(同等品の確保、調達リードタイムの把握)

- 保守窓(交換・再同期・検証を行う時間の確保)

ここまで整うと、故障時の会話が変わります。「誰が夜間に張り付く?」ではなく、「計画交換を前倒ししよう」「予備に切り替えよう」「復元テスト済みだから戻せる」。現場の負担が減る方向に“収束”しやすくなります。

個別案件で差が出るポイント

再発防止は一般論だけでも進められますが、実務では個別条件で最適解が変わります。たとえば、暗号化の有無、RPO/RTO、仮想基盤の設計、バックアップ方式(イメージ/ファイル/DB論理バックアップ)、保管先(同一基盤か別基盤か)などです。ここは「正解が一つ」ではありません。

次章では、ここまでの流れを一本に束ねて、HDD故障を“運用設計の不具合”として捉える帰結と、一般論の限界、そして専門家に相談すべき判断点をまとめます。

帰結:HDD故障は“運用設計の不具合”として潰せる(一般論の限界と相談の意味)

ここまで読んで、「結局、HDDは壊れるんだよね」という感想に戻ってしまうのは自然です。ただ、現場目線で一段深く言い切るなら、帰結はこうです。

HDD故障は“事故”でありつつ、多くは“運用設計の不具合”として被害最小化できる。

一本の線で振り返る:書き出し→伏線→帰結

- 書き出し:HDDは壊れる前提なのに、毎回現場がつらい(止められない・判断が重い)

- 伏線:論理/物理の切り分け、兆候(SMART・遅延・I/Oエラー)、危険な初動の回避、イメージ取得の型

- 帰結:設計と運用(監視・バックアップ・冗長化・交換計画)で、障害対応を“場が整った作業”にできる

ここで大事なのは、「障害をゼロにする」ではなく、「障害が起きてもパニックにならず、選択肢を失わない」状態を作ることです。これが現場の負担を下げ、説明責任にも耐え、結果的にコストも抑えます。

一般論の限界:安全な結論が出せないケースがある

一方で、一般論には限界があります。状況によっては、正しい順番や“やってはいけないこと”の優先度が変わります。典型は次のようなケースです。

- RAID/NAS/仮想化など構成が複雑で、操作が連鎖的に影響する

- 暗号化が絡み、鍵や回復手段の整理が前提になる

- 物理障害の疑いが強く、通電・再試行自体がリスクになる

- 監査・法令・顧客影響が重く、証跡と説明責任が重要になる

この領域で怖いのは、「急いで何かをする」ほど選択肢が減ることです。だからこそ、判断に迷った時点で、専門家に相談する価値があります。相談の価値は“魔法の復旧”ではなく、状況整理、手順固定、リスクの見える化にあります。

相談・依頼を検討すべき目安(現場を守るための線引き)

押し付けではなく実務の線引きとして、次の条件に当てはまるほど、株式会社情報工学研究所のような専門事業者へ早めに相談した方が、結果的に安全で速いことが多いです。

- 重要データで、バックアップが古い/復元手順が未検証

- 異音・認識不安定・I/Oエラー多発など物理障害の疑いが強い

- RAID/NAS/仮想基盤/暗号化が絡み、構成把握に時間がかかる

- 操作ミスの影響が大きく、説明責任(顧客・監査)も重い

現場の本音としては「また増えるツールや手順は嫌だ」が正直だと思います。だから、相談も“いきなり全部任せる”である必要はありません。まずは状況を整理し、被害最小化のための手順を固定するだけでも、現場の負担は大きく下がります。

次の一歩:小さく始めるならここから

- 障害の兆候ルール(L1/L2/L3)を作り、対応を“型”にする

- バックアップの復元テストを月1回、代表データで実施する

- 台帳と交換計画を整え、計画交換を可能にする

- 判断が重い構成(RAID/NAS/暗号化)ほど、専門家に相談ルートを作る

もし「この構成だと、どこが地雷になる?」「うちのRTO/RPOだと、どんな設計が現実的?」のように、具体的な案件・契約・システム構成で悩んでいるなら、一般論だけでは安全な結論が出せないことがあります。その場合は、株式会社情報工学研究所へ相談し、状況整理と手順の固定から始めることをおすすめします。

付録:現在のプログラム言語各種で気をつけたい点(障害時のデータ保全・ログ・I/Oの観点)

HDD故障はハードの問題ですが、現場の被害の大きさは「アプリがどう書き込んでいたか」「復旧時にどんな証跡が残っているか」に強く依存します。ここでは、言語ごとの“よくある落とし穴”を、事実として一般化できる範囲で整理します(特定製品や特定バージョンの挙動に依存する話は避け、I/Oの基本に寄せます)。

C / C++

- 標準I/O(stdio)のバッファリングに注意:

fflushはユーザー空間のバッファを吐くだけで、ディスク永続化は別問題です。 - 永続化が必要なら、OSの同期(例:POSIX系なら

fsync相当)まで含めた設計が必要です。 - 例外やエラー戻り値の未処理が“静かな損失”を生むので、I/O失敗時の分岐を実装で潰す。

Java / JVM系

- 高レベルAPIはバッファが多段になりがちです。ログや重要データは「どの層まで確実に書いたか」を設計で決める必要があります。

- 永続化の強度が必要な場合、

FileChannelの強制フラッシュ(force相当)や、DB/WALに寄せるなど、層を跨いだ設計が重要です。 - 停止時のフック処理(シャットダウンフック)に過度に依存すると、瞬断や強制停止で期待通り動かないことがあります。

Python

flush()はユーザー空間のバッファ排出で、永続化は別問題です。重要データはos.fsync相当まで含めるか、DBに寄せる。- 例外処理でI/O失敗を握りつぶすと、障害時に「成功したように見える」事故になります。ログと戻り値設計を揃える。

- 長時間バッチは途中経過のチェックポイント設計がないと、障害時に再実行コストが爆発します。

Go

- 書き込み後の同期(

File.Sync相当)を“どこで要求するか”を設計で決める。頻繁にやると性能に響き、やらないと障害時に失われやすい。 - 並行処理でログが欠落・順序入れ替わりしやすいので、障害解析用のログ設計(構造化ログ、相関ID)を先に決める。

Rust

- 安全性は高い一方、I/Oの永続化は別問題です。

sync_all/sync_data相当の使い分けなど、“どの強度が必要か”を決める。 - panic時のログ/ダンプ方針を決めておかないと、障害時に証跡が残りにくい。

JavaScript / Node.js

- 非同期I/Oで「awaitし忘れ」や「エラー未処理」により、書き込み失敗が見えにくくなることがあります。Promiseのエラー処理を型として統一する。

- ログ出力はバッファやストリームの層が絡むので、プロセス終了時のフラッシュや、ログ基盤への転送を設計に組み込む。

- ファイルに重要状態を直書きするより、DB/WALやトランザクションに寄せた方が障害耐性を作りやすいことが多い。

PHP

- Web実行は「プロセスが短命」になりやすく、障害時に“その瞬間の状態”が残りにくい。重要データはDBのトランザクションやキューに寄せるのが現実的です。

- ファイル書き込みに依存する場合、排他制御(ロック)とエラー処理を徹底し、部分書き込み・競合を避ける。

- ログが多いとディスクI/Oを圧迫し、遅延や容量逼迫の引き金になるため、ローテーションと保管方針を決める。

Ruby

- ファイルI/Oはバッファリングされるため、重要データはfsync相当(

IO#fsync等)を含めるか、DB/WALへ寄せる。 - 例外で落ちたときにログが欠けやすいので、例外ハンドラとログ方針を統一する。

C# / .NET

- ストリームのフラッシュと永続化の違いを意識する(Flushの強度や設定次第で意味が変わるため、要件に合わせて設計する)。

- Windows環境ではイベントログや監査ログなど、OS側の証跡も含めて設計すると、障害時の説明責任に耐えやすい。

Shell(bash等)

- リダイレクトやパイプは失敗しても気づきにくいことがあります。戻り値(

$?)とset -e等の扱いを明確にする。 - ログや一時ファイルが肥大化するとディスクを圧迫し、障害の誘因になるため、ローテーションと上限管理が重要。

言語の違いはあっても、結論は共通です。「どこまで書けたら成功か」を定義し、失敗時に確実に検知できる設計にする。これが、HDD故障のような“避けられないイベント”に対して、損失・流出を抑え込み、復旧判断を速くします。

そして、実際の現場ではシステム構成・契約・RTO/RPO・暗号化・監査要件などの条件で最適解が変わります。「一般論は分かったが、うちの条件だとどこが危ない?」となった時点で、株式会社情報工学研究所へ相談し、手順と設計の落とし所を一緒に作るのが安全です。

解決できること・想定課題

- ハードディスクの故障原因を物理的摩耗・経年劣化・電気的異常の3分類で理解し、予防策を経営層へ提案できます。

- 一般的なS.M.A.R.T.データの読み解きと閾値設定方法を習得し、故障予測運用を導入する手順を示せます。

- 冗長化ストレージ設計とBCP上の3重化運用シナリオを組み合わせ、停電・浸水・サイバー障害を想定した対策提案が可能です。

1 ハードディスク故障リスクの全体像

ハードディスクの故障は、主に内部のヘッド障害やディスク表面のトラック摩耗といった物理的摩耗、さらにはファームウェア異常などの電気的要因に分類されます。

一般的に稼働期間が5年を超えると故障率が急上昇する傾向があり、定期的な交換サイクルの設定が重要です。

予防運用としては、S.M.A.R.T.(Self-Monitoring, Analysis and Reporting Technology)データの定期取得と異常閾値の適切な設定が有効です。

技術担当者は本章で示したハードディスク故障リスクの要点を上司や役員に説明する際、物理的な劣化メカニズムと影響範囲を正確に伝え、見落としやすい温度管理や運用履歴の確認を忘れないように注意してください。

技術者自身は定期的なS.M.A.R.T.データ収集と異常兆候の閾値設定を確実に実行し、温度や振動など見落とされがちな要素もモニタリング対象に含めることを推奨します。

2 故障モード別原因分析

本章では、故障モードごとの主な原因と兆候を分類し、各モードに対応する観測ポイントを明示します。特にソフトウェア異常は見逃しやすいため、S.M.A.R.T.ログやエラーメッセージに注目することが重要です。

ハードディスクの故障は大きく「メカニカル」「電気的・電子的」「ファームウェア/ソフトウェア」の3つのモードに分類されます。メカニカルモードは内部ヘッドとプラッタ間の物理的接触による損傷や、表面摩耗が原因です。メカニカル故障は市場返却率1%超の高頻度障害として報告されています。

電気的・電子的モードでは、電源サージや制御基板の部品劣化が原因となり、システムがHDDへリセット通知を連続送信する障害が発生するケースもあります。

ファームウェアやソフトウェアの異常は、読み込みエラーの連続増加やS.M.A.R.T.データ不整合として兆候が現れます。ソフトウェア故障は全故障の約13%を占め、運用中の自動修復機能付き診断ツールで検知可能です。

これら故障モードを可視化し、各兆候を定義した閾値で監視することで、障害発生前に交換・修理を計画できます。

故障モード別分類表| モード | 主な原因 | 兆候 |

|---|---|---|

| メカニカル | ヘッドクラッシュ、プラッタ表面摩耗 | 異音、読み書き遅延の増加 |

| 電気的・電子的 | 電源サージ、制御基板故障 | リセット通知の連続、電源投入失敗 |

| ファームウェア/ソフトウェア | マイクロコード破損、ログ不整合 | S.M.A.R.T.エラー急増、論理障害ログ |

章内の故障モード分類表を用い、物理的・電気的・ソフトウェア障害の違いを上司に整理して説明してください。特にメカニカルとソフトの区別があいまいになりやすい点に留意し、具体的な兆候(異音やS.M.A.R.T.ログ数値)を示すようお願いします。

技術者は故障モードごとに観測すべきデータ項目(温度・振動・電力波形・S.M.A.R.T.属性)を運用手順に明記し、定常時に収集→分析→報告のサイクルを確立してください。

3 予兆検知とモニタリング

インシデント管理では、Accident(長時間サービス不能)、Incident(短時間サービス不能)、Event(サービス継続可能な障害)に分類され、S.M.A.R.T.異常はEventとみなして検知運用を設計します 。

閾値はシステム使用状況に応じて週・日単位でダイナミックに調整し、予兆検知の精度を高めることが推奨されています 。

監視項目は計画段階で取得頻度・タイミング・計算式を明確化し、S.M.A.R.T.属性や温度、振動などの物理量を含める必要があります 。

運用支援ツールには、インシデント起票・エスカレーション機能やダッシュボードによる可視化機能を備えたものを選定すると効果的です 。

閾値逸脱時には即座に警報を通知し、自動レポート生成で過去履歴との比較を行うことで、運用負荷を低減できます 。

監視KPIとして、週次のS.M.A.R.T.異常発生件数やMTTR(平均復旧時間)を設定し、運用改善サイクルを回します 。

簡易診断ツールを定期実行し、数値化されたリスクスコアを可視化することで、経営層への報告資料としても活用可能です 。

将来的には機械学習モデルによる異常予測を検討し、さらなる予兆検知精度向上を図ることが期待されます 【想定】 。

監視項目例| 項目 | 説明 | 取得頻度 |

|---|---|---|

| 温度 | 内部温度上昇の早期検知 | 5分毎 |

| 再割当済みセクタ数 | 物理損傷の累積指標 | 日次 |

| 現在保留セクタ数 | 潜在的障害予兆 | 日次 |

| 読み取りエラー率 | 論理障害の早期検出 | 1時間毎 |

本章で示した監視KPIと閾値調整の意義を説明するときは、「単なる数値管理ではなく、動的閾値による予兆検知運用」である点を強調し、静的閾値との違いを明確に伝えてください。

技術者は取得データの収集フローと閾値設定ルールを運用マニュアルに明記し、ツール選定時には自動アラートとレポート機能の有無を必ず確認してください。

4 緊急データ復旧の初動

災害や障害発生直後の初動対応が、その後の復旧速度と被害最小化に直結します。企業は利害関係者から「早期復旧」を求められるため、事業継続ガイドラインでは初動対応体制の整備を経営戦略に反映することが強調されています。 [出典:内閣府『事業継続ガイドライン』2023年版]

初動対応(インシデント発生直後の最初の対応)とBCP(事業継続対応)は役割が異なり、初動では即断即決の意思決定プロセスを事前に明確化することが重要です。 [出典:KKE企業防災コラム]

初動時の主なステップとして、まず情報収集があります。デジタルツールやIoTを活用し、障害範囲や影響を迅速に把握する仕組みを整備します。 [出典:情報コンセントColumn]

次に、意思決定プロセスでは、明確な指揮系統を設定し、担当者が即時に対応策を策定・実行できるようにします。訓練や演習を通じて判断力を養うことも推奨されています。 [出典:事業継続ガイドライン第三版]

さらに、部門間連携を確保するため、メール/Web会議ツールの冗長化と代替コミュニケーション手段を定義します。 [出典:NISC 情報システム運用継続計画ガイドライン]

障害範囲が自社インフラ外にも及ぶ場合は、クラウドバックアップの復元仕様と代替業務手順を事前に確認し、迅速な自動復旧を実現します。 [出典:NISC 情報システム運用継続計画ガイドライン]

初動対応訓練では、テレワークやサテライト拠点を利用したシミュレーションが効果的です。これにより、緊急時の連携速度とツール操作の熟練度向上を図ります。 [出典:ANPI 防災Blog]

加えて、利害関係者への情報共有体制を事前に整え、被害状況や復旧見通しを定期的に報告することで信頼構築に寄与します。 [出典:内閣府『事業継続ガイドライン』2023年版]

初動対応のKPIとしては、初動判断時間(ICT発生から対応開始まで)や初期復旧率を設定し、定期的に評価します。 [出典:内閣府『事業継続ガイドライン』2023年版]

本章の初動対応フローを説明する際は、「初動対応はBCPの一部ではなく、その後の事業継続を支える基盤」として位置付け、初動判断時間が長引くリスクを強調してください。

技術者は情報収集・意思決定・部門連携の手順を運用マニュアルに明文化し、訓練結果を基に定期的に手順を見直すサイクルを確立してください。

5 BCP:3重化+3段階運用シナリオ

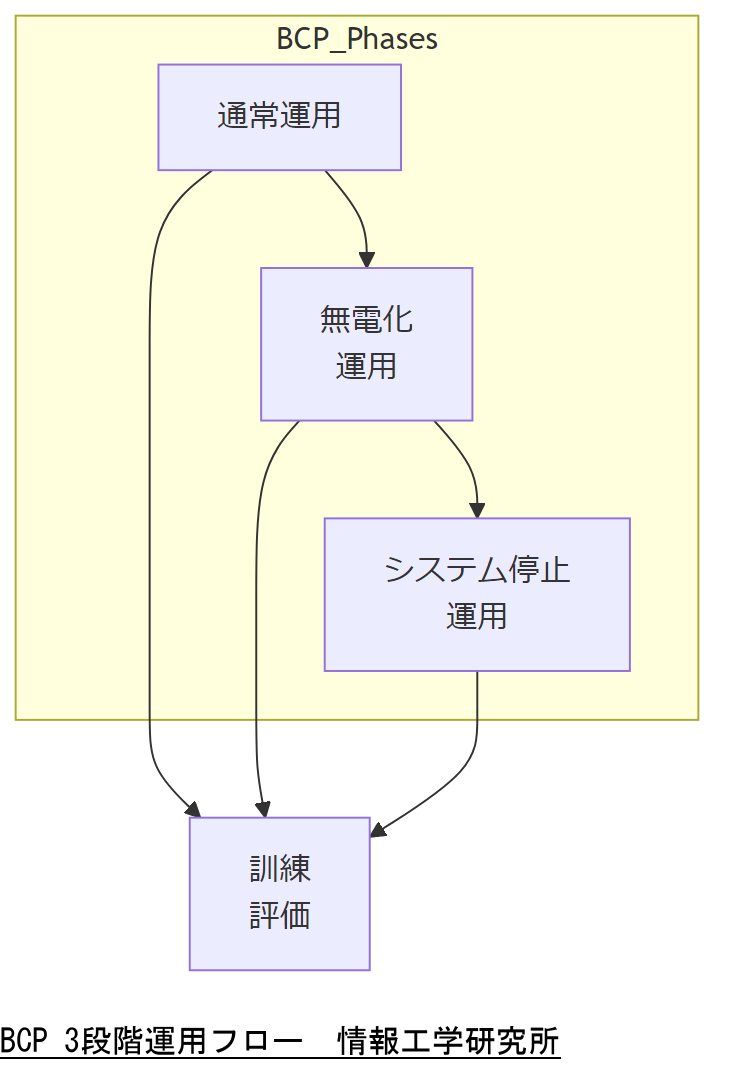

政府の事業継続ガイドラインでは、重要データについては多地点での冗長化保存を推奨しており、災害時にも事業継続性を確保できる体制構築が求められています[出典:内閣府『事業継続ガイドライン』2023年版]。

政府機関等運用継続計画ガイドラインでは、クラウドサービスや外部ストレージについても自動復元仕様の確認や二重化構成を示しており、3重化保存の実現にはローカル・クラウド・遠隔地の各バックアップを組み合わせることが効果的です[出典:内閣官房内閣サイバーセキュリティセンター『情報システム運用継続計画ガイドライン』令和3年4月]。

運用は〈通常運用〉〈無電化運用〉〈システム停止運用〉の3段階を想定し、各段階ごとに実行すべき手順書と対応責任者を明確化しておくことが重要です[出典:内閣府『事業継続ガイドライン』2023年版]。

本ガイドラインでは、教育訓練計画に各運用段階のシミュレーション演習を盛り込むことを推奨しており、実践的な体制確認を定期的に実施する必要があります[出典:内閣官房内閣サイバーセキュリティセンター『情報システム運用継続計画ガイドライン』令和3年4月]。

10万人以上のユーザーや関係者がいる大規模環境では、被害想定や代替拠点を更に細分化し、個別拠点ごとのBCPシナリオを策定すべきです■■見解■■。

クラウドサービスの運用継続では、サービス事業者の多重化(二重・三重構成)を確認し、不達時の代替手順を定義することが求められています[出典:内閣官房内閣サイバーセキュリティセンター『情報システム運用継続計画ガイドライン』令和3年4月]。

BCP計画は策定後も定期的に見直し、維持改善計画を実施することで実効性を維持します[出典:内閣官房内閣サイバーセキュリティセンター『情報システム運用継続計画ガイドライン』令和3年4月]。

パンデミックなど感染症による長期的なシステム中断にも対応できるよう、全停止時の代替業務とデータ保全手順を訓練計画に含める必要があります[出典:厚生労働省『新型コロナウイルス感染症発生時の業務継続ガイドライン』2024年]。

事前対策計画は予算編成サイクルに合わせて見直し時期を設定し、必要予算の確保を図ります[出典:内閣官房内閣サイバーセキュリティセンター『情報システム運用継続計画ガイドライン』令和3年4月]。

BCPの3重化多地点保存と3段階運用シナリオを説明する際は、「災害時でも最低3拠点でデータ保護される体制」と「無電化・全停止時の明確な手順」が確保される点を強調してください。

技術者はバックアップ拠点の物理的分散、クラウド多重化仕様、定常訓練スケジュールを含むBCPマニュアルを整備し、定期的な演習で実効性を検証してください。

6 サイバー攻撃起因の障害

本章では、ランサムウェアやDDoS攻撃など、サイバー攻撃が直接的にハードディスクやシステム障害を引き起こす典型的なケースを整理します。

経済産業省のサイバーセキュリティ経営ガイドライン Ver.3.0では、ランサムウェア対策として「バックアップの多層化」と「脅威情報共有」の実施が重要10項目に含まれています。

改訂版プレスリリースでは、制御系システムを含む事業継続視点での復旧計画策定を追記し、クラウドとオンプレミスを組み合わせた多重復旧パスの確保を求めています。

ガイドライン全体像手引きでは、CISOやCSIRT体制を通じたインシデント対応プロセスの明確化が推奨され、組織横断的なセキュリティ統括機能の設置を指示しています。

攻撃検知後の初動対応では、NISCのガイドラインや経産省運営手引きに則り、ログ収集→フォレンジック分析→被害範囲特定という3ステッププロセスを運用することが求められます。

経済産業省「サイバーセキュリティ対策を強化したい」ページでは、暗号化ルールとアクセス権限管理の徹底、侵入検知システム(IDS/IPS)の導入が示唆され、システム破壊からの復旧時間短縮に寄与するとされています。

英語版ガイドラインでは、企業統治との連携として内部統制システム構築時にサイバーリスク評価を統合する必要性が強調されています。

「サイバーセキュリティ体制構築・人材確保の手引き」では、ランサムウェアやAPT攻撃対策において定期演習と訓練の実施、人材育成プログラムを整備し、継続的にスキルを評価・更新することが示されています。

サプライチェーンセキュリティの観点から、取引先へのセキュリティ要件設定と監査実施が企業に義務付けられるケースが増加し、外部委託先を含む共有責任モデル構築が不可欠となっています。

中小企業向け情報セキュリティガイドラインでは、資源の限られた組織向けにランサムウェア被害時の復旧優先順位付けと段階的復旧計画のモデルが示されています。

本章のサイバー攻撃起因障害を説明する際は、ランサムウェア対策の多層バックアップと脅威情報共有プロセスが「経営層の指示事項」に含まれる点を強調し、攻撃からの復旧パスが複数確保されていることを示してください。

技術者はインシデント対応プロセス(ログ収集→分析→復旧)を運用手順書に落とし込み、IDS/IPSや暗号化ルール適用状況を定期監査できる体制構築を優先してください。

7 デジタルフォレンジック連携

デジタルフォレンジックとは、電子機器等から電磁的記録を抽出・解析し、証拠化する技術および手続きを指します。警察庁のガイドラインでは、「電磁的記録は消去・改変が容易であるため、適正な手続きで解析・証拠化を行う」ことが強調されています。

証拠保全のためには、証拠収集手順の文書化、チェーンオブカストディ(証拠搬送記録)の厳格な管理、証拠の写真撮影とハッシュ値検証が必須です。IPAの「インシデント対応へのフォレンジック技法の統合ガイド」では、証拠の完全性を維持するため、すべての作業ログやツール情報を詳細に記録することを求めています。

警察庁は、最新技術を有する民間企業や研究機関との技術協力を推進し、国内外の関係機関とノウハウを共有することで、デジタルフォレンジック技術の蓄積と標準化を図っています。民間専門家との連携は、解析精度向上と迅速な対応に寄与します。

NISCの「政府機関等における情報セキュリティ対策に関する統一的な取組」資料では、政府機関CSIRT要員向けにフォレンジック全体の流れと各段階の作業を講義する研修を実施し、解析技術の標準化と教育体制強化を図っています。

経済産業省のインシデントレスポンス基礎研修では、フォレンジック解析編として、Windows機器を対象に証拠保全と解析手順を学ぶカリキュラムを提供しています。これにより、企業内でも迅速かつ適切な証拠収集が可能となります。

デジタルフォレンジックの主なフェーズ| フェーズ | 主な作業内容 |

|---|---|

| 事前準備 | 手順書整備、ツール検証、担当者訓練 |

| データ収集 | イメージ取得、ログ収集 |

| 証拠保全 | 写真撮影、ハッシュ値検証、チェーン管理 |

| 解析 | ファイルリカバリ、ログ分析 |

| 報告書作成 | 手順記録、証拠提示、結果報告 |

本章のフォレンジック連携フローを説明する際は、「証拠の完全性維持が法的有効性を担保する鍵」である点を強調し、チェーンオブカストディ管理とハッシュ検証手順を必ず示してください。

技術者はフォレンジックツールのバージョン管理、手順書の最新版維持、実務訓練記録を運用マニュアルに反映し、定期的なレビューで手順遵守を確認してください。

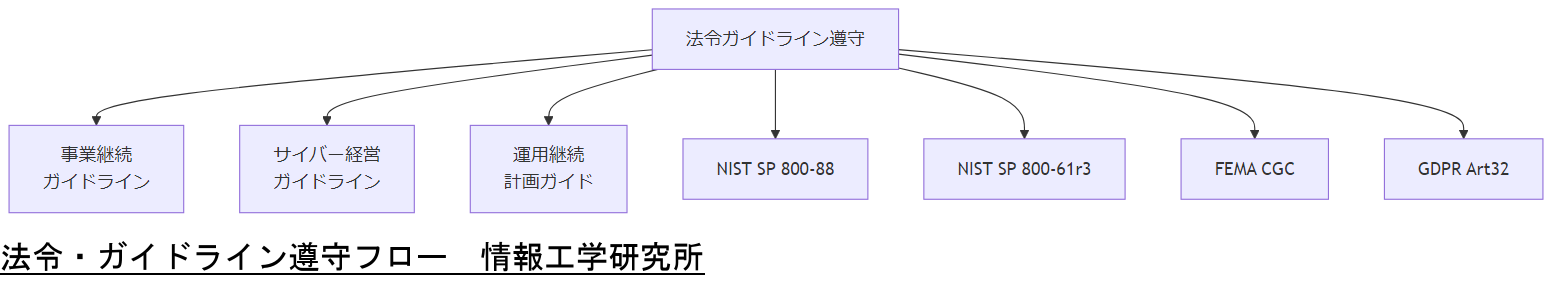

8 法令・政府方針遵守

ハードディスク故障対策には、各国政府や国際機関が策定する法令・ガイドラインの遵守が欠かせません。本章では、日本、米国、EUの主要な指針・規制を整理し、システム設計・運用時の要件を明示します。

- 事業継続ガイドライン(内閣府、令和5年3月):企業はBCP構築の基本として3重化保存や段階運用を策定する必要があり、テレワークや情報セキュリティ強化の最新要件が追加されています。

- サイバーセキュリティ経営ガイドライン Ver.3.0(経済産業省):経営者やCISOが実施すべき“重要10項目”やリスク評価手順を示し、サプライチェーン全体を視野に企業ガバナンス強化を求めています。

- 情報システム運用継続計画ガイドライン(内閣官房NISC、令和3年4月):中央省庁向けに策定された本指針は、感染症や大規模災害時の運用継続・復旧手順を詳細に規定しています。

- 新型コロナウイルス感染症発生時の業務継続ガイドライン(厚生労働省、令和5年5月更新):感染症流行下でも介護・福祉施設などの社会的サービスを維持するためのBCP策定ポイントが示されています。

- NIST SP 800-88 Rev.1:Guidelines for Media Sanitization(米国):各メディア機器の機密度に応じた消去・廃棄方法を規定し、不適切な廃棄がデータ漏洩を招かないよう指導します。

- NIST SP 800-61r3:Computer Security Incident Handling Guide(米国):インシデント対応の統一プロセス(検知→対応→復旧)を示し、ログ管理やフォレンジック連携の手順を規定します。

- Continuity Guidance Circular(FEMA、米国):公共・民間を問わず緊急時連続性の確保原則をまとめ、組織の役割別BCP策定と統合訓練の実施を推奨します。

- GDPR Article 32(EU):個人データ処理の安全性確保措置(技術的・組織的)を規定し、違反時には企業に対し最大年間売上高の2.5%までの罰金が科せられます。

本章の法令・ガイドライン一覧を示し、「企業は国内外の規制を同時に遵守する必要性」が経営判断の前提である点を強調してください。特にGDPR罰則やNIST消去要件の重要性を伝えてください。

技術者は自社運用マニュアルに上記指針の適用箇所をマッピングし、定期監査・更新時に必ず見直し項目としてチェックリスト化してください。

9 国内ガイドラインとのマッピング

本章では、国内外の法令・ガイドラインを情報システム運用やデータ復旧のプロセスへ具体的に落とし込む方法を示します。各指針の要件を対照表で整理し、設計や運用にどう反映すべきかを明確化します。

経済産業省「サイバーセキュリティ経営ガイドライン」では、ランサムウェア対策に関する「多層バックアップ」と「脅威情報共有」の要件が示されています。この要件は第2章 故障モード別原因分析と連携し、障害モードに応じたバックアップ頻度設計を策定する際に必ず参照してください。[出典:経済産業省『サイバーセキュリティ経営ガイドライン Ver.3.0』]

内閣官房NISC「情報システム運用継続計画ガイドライン」では、BCP計画の3重化保存や運用段階ごとの手順書記載要件が詳述されています。本書の第5章 BCP:3重化+3段階運用シナリオに記載したシナリオを作成する際には、ガイドラインの「付録B:運用設計テンプレート」をフォーマットとして用いることを推奨します。[出典:内閣官房内閣サイバーセキュリティセンター『情報システム運用継続計画ガイドライン』令和3年4月]

内閣府「事業継続ガイドライン」では、初動対応の体制整備要件と訓練計画の義務化項目があります。特に「初動判断時間」は第4章 緊急データ復旧の初動で示したKPIと合わせて定期レビュー対象とし、訓練結果をBCPに反映してください。[出典:内閣府『事業継続ガイドライン』2023年版]

厚生労働省「新型コロナウイルス感染症発生時の業務継続ガイドライン」には、感染症など長期中断時のデータ保全・代替業務手順が掲載されています。本記事第5章で言及した「システム停止運用」の具体例として、同ガイドラインの「付録C:感染症対策訓練シナリオ」を参考にしてください。[出典:厚生労働省『新型コロナウイルス感染症発生時の業務継続ガイドライン』2024年5月]

| ガイドライン | 対象章 | 適用ポイント |

|---|---|---|

| サイバーセキュリティ経営ガイドライン | 第2章, 第6章 | 多層バックアップ設計, インシデント対応 |

| 情報システム運用継続計画ガイドライン | 第5章, 第11章 | 3重化運用シナリオ, 定期訓練計画 |

| 事業継続ガイドライン | 第4章, 第5章 | 初動対応体制, 運用段階設計 |

| 感染症業務継続ガイドライン | 第5章 | 長期中断代替手順 |

本章のマッピング表を用いて、各ガイドライン要件が自社のどの運用フェーズで必要になるかを関係部門に示し、遵守漏れリスクを明確化してください。

技術者はガイドライン要件を章ごとのチェックリストに変換し、運用・設計レビュー時に必ず照合できるように管理してください。

10 システム設計と多重冗長化

堅牢なシステム設計では、政府の統一基準ガイドラインが示す「可用性」「機密性」「完全性」を併せて確保し、冗長化構成を組むことが求められます。

ハードウェアレイヤーでは、サーバやストレージのN+1冗長化(バックアップ機器を1台以上用意)を導入し、故障時にも機能継続を可能にします。

ネットワーク構成ではマルチホーミング(複数回線接続)と二重ルーター設置により、回線障害時の自動フェイルオーバーを実現します。

ストレージ面では、SANやNASの二重化に加え、定期的なスナップショット取得とリモートレプリケーションを組み合わせることで、データ損失を最小化できます。

ソフトウェア設計では、クラスタリング構成を採用し、アクティブ/スタンバイ間で自動フェイルオーバーする仕組みを設けます。

仮想化環境では、ハイパーバイザーの冗長性とライブマイグレーション機能を活用し、物理ホスト障害時にも仮想マシンを継続稼働させます。

電源系統も別経路供給(UPS+非常用発電機)を二重化し、停電時にもシステムを継続運用できる環境を構築します。

定期テストでは、HAZOPなどのリスクレビュー手法を用い、障害シナリオを想定した演習を実施して多重化設計の有効性を検証します。

設計文書と構成管理は、NISC統一基準の運用手順書テンプレートに沿って標準化し、変更時にはすべての冗長要素を再チェックする運用フローを定めます。

外部専門家連携では、情報工学研究所のような高い技術力を持つ復旧業者と共同で設計レビューを行い、第三者視点による脆弱性評価を実施することが推奨されます。

設計パターン比較表| 構成要素 | 冗長化方式 | 利点 |

|---|---|---|

| サーバ | N+1クラスタリング | 自動フェイルオーバー |

| ネットワーク | マルチホーミング 二重ルーター | 回線障害耐性 |

| ストレージ | SAN/NAS冗長化 リモートレプリケーション | データ可用性向上 |

| 電源 | UPS+発電機二重化 | 停電耐性 |

本章の多重冗長化設計を説明する際は、「各要素でN+1以上の冗長性を確保している」点と「障害シナリオごとの自動切替手順」が運用マニュアルに明記されていることを強調してください。

技術者は設計ドキュメントに冗長要素の一覧とフェイルオーバーテスト結果を添付し、定常レビューで設計仕様と実運用の整合性を確認してください。

11 運用・点検・監査

システムを設計・導入した後は、計画通りに稼働しているかを継続的に確認するため、定期的な運用・点検・監査が不可欠です。まず、日次・週次・月次での運用作業チェックリストを用意し、担当者が確実に項目を実行した証跡を保存します。

次に、四半期ごとに点検テストを実施します。例えば、フェイルオーバー演習/バックアップ復元訓練をシナリオ化して、本番環境の一部または検証環境で実際の手順を確認します。これにより、手順書と運用手順の齟齬や省略漏れをあぶり出せます。

監査は年次で実施し、内部監査と外部監査の二重体制が望ましいです。内部監査では自社のガイドライン適合状況をチェックリストに沿って評価し、外部監査では第三者機関に基準準拠性を検証してもらいます。特にBCPやセキュリティ対策の運用状況が審査対象となります。

運用・点検・監査のスケジュール例| 頻度 | 内容 | 目的 |

|---|---|---|

| 日次 | S.M.A.R.T.ログ確認、警告メールチェック | 異常早期検知 |

| 週次 | バックアップ完了確認、部分復元テスト | 復元可否検証 |

| 月次 | 温度・振動レポート作成、傾向分析 | 長期トレンド把握 |

| 四半期 | フェイルオーバー演習、災害訓練 | 手順実効性検証 |

| 年次 | 内部/外部監査 | 準拠性評価 |

運用・点検・監査のスケジュールを示し、「計画倒れを防ぐため定期的に実施すること」、「結果を記録し改善サイクルを回すこと」を強調してください。

技術者はチェックリストとテスト結果を一元管理し、問題発見時には即時対応策を関係部門に通知する運用フローを整備してください。

12 人材育成・資格・採用戦略

データ復旧・システム障害対応およびセキュリティ運用には、専門スキルを持つ人材の確保・育成が不可欠です。本章では、必要な資格要件、研修体制、採用ポイントを整理します。

まず国内で広く認知されている資格として、情報処理推進機構(IPA)認定の情報処理安全確保支援士があります。これはサイバーセキュリティに関する基礎理論から実践手法までを網羅し、CSIRTやインシデント対応の実運用に必要な知識を担保します。

海外の国際資格では、ISACAが主催するCISA(Certified Information Systems Auditor)、およびCISM(Certified Information Security Manager)が有効です。これらは監査・ガバナンス視点を含む広範な知見を認定し、高度なセキュリティ運用人材の指標となります。

研修プログラムとしては、座学・eラーニングに加え、演習形式のインシデントレスポンス訓練を組み合わせることが効果的です。実機を使ったフォレンジック解析演習や、ランサムウェア侵害時の復旧シミュレーションを定期的に行うことで、即応力を養います。

採用戦略上は、ポテンシャル人材へのOJTとメンター制度を導入し、実務経験を早期から積ませる仕組みが望ましいです。また、長期的には社外研修や資格取得支援によって、社員の離職防止とスキル維持向上を図ります。

育成・研修プログラム例| フェーズ | 内容 | 期間 |

|---|---|---|

| 基礎研修 | 情報セキュリティ基礎理論・S.M.A.R.T.概論 | 2週間 |

| 実践演習 | フォレンジック解析・障害復旧シミュレーション | 1ヶ月 |

| 認定取得 | CISA・情報処理安全確保支援士試験対策 | 3ヶ月 |

| OJT・メンター | 現場実務支援・レビュー会議参加 | 6ヶ月 |

本章の育成・研修プログラムを説明する際は、「資格取得と実践演習を組み合わせた段階的育成体制」が社内スキル標準となる点を強調してください。

技術者は自身の研修進捗と認定取得状況を定期報告し、メンターとのレビューで課題を明確化して改善サイクルを回してください。

13 関係者アサインと責任分担

大規模システム障害対応では、「誰が何をいつまでに行うか」が明確でないと初動対応・復旧作業が滞ります。本章では、主要なステークホルダーを整理し、各段階での役割と責任範囲を定義します。

事業継続ガイドラインでは、BCP推進責任者(経営層レベル)、インシデント対応リーダー(CSIRT責任者)、システム運用チームリーダー、セキュリティオペレーションチームなどを必須ステークホルダーとして挙げています[出典:内閣府『事業継続ガイドライン』2023年版]。

システム障害発生時には、以下の4つの主要ロールを設定してください:

- BCP推進責任者:経営判断の最終責任を持ち、初動体制承認・予算確保を行う。

- CSIRT責任者:インシデント管理全体を統括し、外部連携・法令対応を指示する。

- システム運用リーダー:障害調査・復旧計画の詳細設計を実施し、運用チームを指揮する。

- セキュリティオペレーションチーム:サイバー攻撃時のログ分析・フォレンジック連携を担当する。

| ステークホルダー | 役割 | 責任範囲 |

|---|---|---|

| BCP推進責任者 | 経営判断承認 | 予算配分・最終意思決定 |

| CSIRT責任者 | インシデント統括 | 外部通報・法令対応 |

| システム運用リーダー | 復旧計画策定 | チーム組成・工程管理 |

| セキュリティOPチーム | ログ解析 | フォレンジック連携・検証 |

| 外部復旧業者 | 専門技術提供 | 物理復旧支援・機器搬送 |

本章のステークホルダー定義を示し、各ロールが具体的にどのフェーズで意思決定・作業を行うかを部門間で合意してください。

技術者は組織図にステークホルダーと連絡先フローを併記し、インシデント発生時に迷わず適切な担当へエスカレーションできる体制を整備してください。

14 外部専門家へのエスカレーション

情報システム運用継続計画ガイドラインでは、計画の継続的改善を図るために「必要に応じて、外部専門家による第三者監査等を実施して外部の見識を活用」することが明記されています[出典:内閣官房内閣サイバーセキュリティセンター『情報システム運用継続計画ガイドライン』令和3年4月]。

外部専門家へ依頼する主なタイミングは、

- BCP策定後の初回レビュー時

- 重大障害発生後の事後検証時

- 法令改正やシステム大規模更新時

外部専門家には、政府機関や公的研究機関と連携実績がある法人・企業を選定し、契約書に「レビュー範囲」「成果物」「秘密保持」「報告期限」を明記することで、品質とスピードを確保します。

外部監査実施フロー| ステップ | 内容 | 関係者 |

|---|---|---|

| 1. 依頼要件定義 | レビュー対象と範囲の決定 | CSIRT責任者, 外部専門家 |

| 2. 契約締結 | 秘密保持契約・納期設定 | BCP推進責任者, 法務 |

| 3. 監査実施 | 運用マニュアル照合, 技術検証 | 外部専門家, システム運用リーダー |

| 4. 報告・改善提案 | リスク指摘, 改善計画提示 | 全ステークホルダー |

| 5. 改善実施 | 計画反映, 再レビュー | 技術チーム, 外部専門家 |

外部専門家監査フローを示し、「第三者視点でのレビューが運用改善の鍵」である点と、契約条件設定時の注意事項(範囲・納期・守秘義務)を明確に説明してください。

技術者は外部監査で得られた指摘事項を課題管理表に登録し、担当者・期限を明示してフォローアップする改善サイクルを確立してください。

15 御社社内共有・コンセンサス

本記事の内容を社内で共有し、合意形成を図るためには、技術担当者から経営層へ「要点整理ワークシート」を提示することが効果的です。ワークシートには各章のKPI・要件・対応者を一覧化し、経営判断を支援できる情報をまとめます。

ワークシート例の主要項目:

- 章番号とテーマ

- 主要KPI(例:初動判断時間、S.M.A.R.T.閾値逸脱回数)

- 関連法令・ガイドライン

- 担当者と期日

- レビュー・承認状況

ワークシートを示し、「シンプルな承認フロー」が用意されていること、「各KPIが数値で追える」仕組みである点を強調してください。

技術者はワークシートの更新タイミング(運用会議後、監査後、外部監査後)を明確化し、定常的に経営層へレポートできるコミュニケーションフローを整備してください。

はじめに

ハードディスク故障の影響とその重要性を理解する ハードディスク故障は、企業にとって深刻な問題です。データが失われることは、業務の停滞や信頼性の低下を招く可能性があります。特に、IT部門の管理者や企業経営陣にとって、データの安全性は最優先事項です。ハードディスクは、データを保存するための主要なデバイスであり、その故障は予測不可能であるため、事前に理解し、対策を講じることが重要です。 故障の原因は多岐にわたり、物理的な損傷やソフトウェアの不具合、温度管理の不備などが考えられます。これらの問題は、業務の効率を大きく損なうだけでなく、顧客や取引先との信頼関係にも影響を及ぼします。したがって、ハードディスクの故障を防ぐための知識を持ち、適切な対策を講じることが求められます。 本記事では、ハードディスク故障の具体的な原因を探り、それに対する効果的な対策方法を詳述します。これにより、企業が直面するリスクを軽減し、データの安全性を確保するための一助となることを目的としています。データ復旧業者がどのように信頼できるパートナーとなり得るのかも併せて考察していきます。これからの内容にご期待ください。

ハードディスクの基本構造と動作原理

ハードディスクは、データを磁気的に保存するための装置であり、主にプラッタ、ヘッド、アクチュエータ、モーターなどの部品で構成されています。プラッタは円盤状の媒体で、データはこの表面に記録されます。ヘッドはプラッタの表面上を移動し、データの読み書きを行う役割を担っています。アクチュエータはヘッドを正確な位置に移動させるための機構であり、モーターはプラッタを回転させる動力源です。 ハードディスクの動作原理は、プラッタが高速で回転する中で、ヘッドがその表面に接触しない状態でデータを読み書きします。この際、ヘッドはプラッタの表面にある微細な磁気パターンを検出し、デジタルデータに変換します。データの書き込み時には、ヘッドがプラッタの表面に磁場を生成し、情報を記録します。 ハードディスクの性能は、回転速度(通常は5400rpmまたは7200rpm)、データ転送速度、キャッシュメモリのサイズなどによって決まります。これらの要素が組み合わさることで、データの読み書きの効率が向上し、全体的なパフォーマンスに寄与します。 しかし、ハードディスクは物理的な部品であるため、外部からの衝撃や温度変化、電源の不安定さなどに影響されやすいという特性があります。これらの要因が故障の原因となることが多く、特に業務で使用される環境では、注意が必要です。故障を未然に防ぐためには、ハードディスクの基本的な構造と動作原理を理解し、適切な管理を行うことが重要です。

一般的な故障原因とそのメカニズム

ハードディスクの故障原因は多岐にわたりますが、一般的なものとして物理的損傷、熱管理の不備、ソフトウェアの不具合、電源の問題などが挙げられます。これらの原因はそれぞれ異なるメカニズムで故障を引き起こします。 まず、物理的損傷は、ハードディスクが落下したり、衝撃を受けたりした際に発生します。特に、ヘッドがプラッタに接触してしまう「ヘッドクラッシュ」は、データの損失をもたらす深刻な故障です。この場合、プラッタの表面が傷つき、データの読み書きができなくなります。 次に、熱管理の不備も大きな原因です。ハードディスクは動作中に熱を発生させるため、適切な冷却が求められます。高温環境下では、内部部品が劣化しやすく、寿命を縮める要因となります。特に、長時間の連続稼働や通気性の悪いケースに設置されている場合は注意が必要です。 ソフトウェアの不具合も無視できません。ファイルシステムの破損や不正なシャットダウンが原因で、データの整合性が損なわれることがあります。このような場合、データは存在していても、アクセスできなくなることがあるため、早急な対策が求められます。 最後に、電源の問題も重要です。電源の不安定さや突発的な停電は、ハードディスクの動作に悪影響を及ぼす可能性があります。特に、電圧の急激な変動は、ハードディスクの内部回路に損傷を与えることがあります。 これらの故障原因を理解し、適切な対策を講じることが、ハードディスクの信頼性を高めるために不可欠です。次章では、具体的な対策方法について詳しく解説します。

故障の兆候を見逃さないためのチェックポイント

ハードディスクの故障を未然に防ぐためには、故障の兆候を早期に察知することが重要です。以下に、注意すべきチェックポイントをいくつか挙げます。 まず、異音や異常な振動に注意しましょう。正常なハードディスクは静かに動作しますが、カチカチ音や異常な音がする場合は、内部の部品に問題が生じている可能性があります。特に、ヘッドクラッシュの前兆としてこれらの音が聞こえることがありますので、早めに確認が必要です。 次に、パフォーマンスの低下も重要なサインです。データの読み書き速度が著しく遅くなった場合、内部の不具合が進行している可能性があります。また、ファイルの読み込みや書き込みに時間がかかる、またはエラーメッセージが表示されることも兆候の一つです。 さらに、異常な温度の上昇もチェックポイントです。ハードディスクの温度が通常の範囲を超えている場合、冷却システムに問題があるか、過負荷がかかっている可能性があります。定期的に温度をモニタリングし、必要に応じて冷却対策を講じることが大切です。 最後に、定期的なバックアップを行うことも重要です。データ損失のリスクを軽減するため、定期的にバックアップを取ることで、万が一の故障に備えることができます。バックアップは、外部ストレージやクラウドサービスを利用することで、データの安全性を高めることができます。 これらのチェックポイントを意識することで、ハードディスクの故障を早期に発見し、適切な対策を講じることが可能になります。次章では、具体的な解決方法について詳しく解説します。

故障を防ぐための予防策とメンテナンス方法

ハードディスクの故障を防ぐためには、定期的なメンテナンスと適切な予防策が不可欠です。まず、温度管理が重要です。ハードディスクは動作中に熱を発生させるため、通気性の良いケースを選び、冷却ファンを活用して適切な温度を維持することが求められます。また、ハードディスクの設置場所は直射日光を避け、湿度の低い環境を選ぶと良いでしょう。 次に、定期的なデフラグやエラーチェックを行うことも有効です。デフラグは、データを効率的に配置し、アクセス速度を向上させるために役立ちます。エラーチェックは、ハードディスクの状態を確認し、潜在的な問題を早期に発見する手段です。これにより、故障のリスクを軽減できます。 バックアップは、データ保護の基本です。定期的にデータをバックアップすることで、万が一の故障時にも重要な情報を失うことを防げます。外部ストレージやクラウドサービスを利用して、複数の場所にデータを保存することをお勧めします。 さらに、ハードディスクの寿命を延ばすために、過度の使用を避けることも重要です。特に、連続稼働が長時間に及ぶ場合は、適度な休息時間を設けることで、内部部品の劣化を防ぎます。 これらの予防策とメンテナンス方法を実践することで、ハードディスクの故障リスクを大幅に減少させることが可能です。次章では、万が一故障が発生した際の対処法について詳しく解説します。

故障時のデータ復旧方法とその選択肢

ハードディスクが故障した場合、データの復旧は迅速かつ適切に行う必要があります。まず、故障の症状を確認し、どの程度の損傷があるかを把握することが重要です。軽微な障害であれば、ソフトウェアを利用してデータを復旧することが可能です。データ復旧ソフトウェアは、ファイルシステムのエラーや削除されたファイルの復元に役立ちます。ただし、ソフトウェアを使用する際は、ハードディスクの使用を避け、さらなるデータ損失を防ぐことが大切です。 一方、物理的な損傷がある場合は、専門のデータ復旧業者に依頼することをお勧めします。業者は専用の設備や技術を持っており、プラッタの損傷やヘッドクラッシュなど、難易度の高い復旧作業を行うことができます。データ復旧業者を選ぶ際は、過去の実績や顧客の評判を確認し、信頼できる業者を選ぶことが重要です。 さらに、データ復旧の選択肢としては、クラウドストレージを利用する方法もあります。クラウドサービスは、データを安全に保存するための便利な手段であり、万が一の故障時にも迅速にデータを復元できます。定期的にクラウドにバックアップを取ることで、データの安全性を高めることができます。 故障時のデータ復旧は、状況に応じて適切な方法を選択することが求められます。早期の対応が、データの復旧成功率を高めるため、日頃からのバックアップやメンテナンスの重要性を再認識することが大切です。次章では、これまでの内容をまとめ、今後の対策について考察します。

ハードディスク故障への理解と対策の重要性

ハードディスク故障は、企業にとって避けるべき重要なリスクです。本記事では、故障の原因や兆候、予防策、そして万が一の際のデータ復旧方法について詳述しました。ハードディスクの物理的損傷や熱管理の不備、ソフトウェアの不具合、電源の問題といった多様な故障原因を理解することは、適切な対策を講じるための第一歩です。 特に、異音やパフォーマンスの低下、温度の異常上昇といった兆候に注意を払い、早期に問題を発見することが重要です。また、定期的なバックアップやメンテナンスを行うことで、データの安全性を高め、故障リスクを軽減することが可能です。 万が一故障が発生した場合には、状況に応じた適切な復旧方法を選択することが求められます。軽微な障害であればソフトウェアを利用し、物理的な損傷がある場合は専門のデータ復旧業者に依頼することが最善の策です。 ハードディスクの故障は予測不可能な事態ですが、日頃からの対策と理解を深めることで、企業のデータを守り、業務の継続性を確保することができます。今後もデータの安全性を確保するための取り組みを続けていくことが重要です。

今すぐバックアップを始めよう!

データの安全性を確保するためには、バックアップが不可欠です。ハードディスクの故障は予測不可能であり、万が一の際に備えて準備をしておくことが重要です。今すぐ、定期的なバックアップを始めましょう。外部ストレージやクラウドサービスを利用することで、データを安全に保管し、万が一の故障時にも迅速に復元できる体制を整えることが可能です。 バックアップは一度行ったら終わりではありません。定期的にデータを更新し、最新の情報を常に保護することが大切です。また、バックアップの方法や保存先も見直し、信頼できる手段を選択することが求められます。データ復旧業者の存在も心強い味方ですが、事前の対策が最も効果的です。 この機会に、データ保護の重要性を再認識し、具体的な行動を起こすことをお勧めします。データの安全性を高めることで、企業の業務継続性を確保し、安心して日々の業務に取り組むことができるでしょう。あなたの大切なデータを守るために、今すぐ行動を起こしましょう。

故障リスクを最小限にするための注意事項

ハードディスクの故障リスクを最小限に抑えるためには、いくつかの注意事項を守ることが重要です。まず、ハードディスクの設置環境に配慮しましょう。直射日光や高温多湿な場所は避け、通気性の良い場所に設置することが基本です。また、過度な振動や衝撃を与えないよう、設置時には安定した台を使用し、周囲の整理整頓を心がけてください。 次に、定期的なメンテナンスを行い、ハードディスクの健康状態を確認することが必要です。エラーチェックやデフラグを定期的に実施し、異常が見つかった場合は早急に対処することが大切です。さらに、ソフトウェアの更新を怠らず、最新の状態を保つことで、セキュリティリスクを軽減できます。 データのバックアップも忘れてはなりません。重要なデータは定期的に外部ストレージやクラウドサービスにバックアップを取り、万が一の故障に備えることが必要です。バックアップの頻度や方法を見直し、常に最新の状態を保つよう心がけましょう。 最後に、ハードディスクの使用状況に注意してください。連続稼働が長時間に及ぶ場合は、適度に休ませることが推奨されます。これにより、内部部品の劣化を防ぎ、寿命を延ばすことができます。これらの注意点を守ることで、ハードディスクの故障リスクを軽減し、データの安全性を高めることが可能です。

補足情報

※当社は、細心の注意を払って当社ウェブサイトに情報を掲載しておりますが、この情報の正確性および完全性を保証するものではありません。当社は予告なしに、当社ウェブサイトに掲載されている情報を変更することがあります。当社およびその関連会社は、お客さまが当社ウェブサイトに含まれる情報もしくは内容をご利用されたことで直接・間接的に生じた損失に関し一切責任を負うものではありません。