もくじ

- その夜、HEALTHが赤くなった—「またか…」から始まるCeph障害の現実

- 何が壊れたかより「何が遅いか」—復旧時間を支配する時間軸の見方

- まず集めるべき3つの数字—HEALTH/PG state/レイテンシで全体像を掴む

- MON/MGRの揺らぎが“復旧の成功率”を下げる理由

- OSD障害とPG地獄—degraded/undersized/remappedの読み解きで迷子にならない

- backfill・recoveryが終わらない—優先度・制限・ネットワークが作るボトルネック

- 触る順番で結果が変わる—成功率を上げる「やること/やらないこと」

- 復旧時間を短くする設計—CRUSH・故障ドメイン・容量計画・地味な監視

- 次が楽になる事後分析—ログとメトリクスで“説明できるタイムライン”を作る

- 結論:Ceph復旧は「運」ではなく「数字と手順」で再現できる

【注意書き】本記事は、Linux上で運用されるCephクラスター障害と復旧(分散ストレージ復旧)の考え方について、一般的な情報提供を目的としてまとめたものです。実際の復旧可否(成功率)や所要時間は、クラスター規模、レプリカ数/EC設計、故障ドメイン、OSDの状態、ネットワーク帯域、ディスク性能、運用ポリシー、変更履歴などの条件で大きく変わります。障害対応はリスクが高く、誤操作で復旧率を下げることもあるため、個別案件では株式会社情報工学研究所のような専門家に相談のうえで判断してください。

その夜、HEALTHが赤くなった—「またか…」から始まるCeph障害の現実

夜間、通知が鳴ってダッシュボードを見ると、HEALTH_ERR。現場の頭の中はだいたい同じ流れになります。「よりによって今?」「結局、誰がどこまで見ればいいの?」「止めたら怒られる、でも放置もできない」。Cephは“分散ストレージ”であるがゆえに、単体サーバ障害の直感がそのまま通用しません。コンポーネントも障害の姿も多層で、復旧の成功率と復旧時間を左右する変数が多いからです。

まず事実として、Cephのデータ実体はRADOSに格納され、オブジェクトはOSD上に分散配置されます。その配置はCRUSHルール(および故障ドメイン)に従い、レプリケーション(複製)またはErasure Coding(EC)で冗長化されます。したがって「ディスクが1本死んだ」だけでも、クラスター全体としては 再配置(remap)・回復(recovery/backfill)・整合性確認(scrub) の負荷が連鎖します。ここでのボトルネックは、単に“残りのディスクが頑張る”ではなく、ネットワーク、OSDのスロットリング、PG(Placement Group)の状態遷移、MON/MGRの安定性、そしてクライアントI/Oの要求が絡み合って決まります。

「成功率」と「時間」を分けて考えると、判断がブレにくい

復旧対応の現場では、成功率(復旧できる見込み)と時間(いつ戻るか)を混同しがちです。たとえば、PGがdegradedでもクライアントI/Oが継続できる場合は「時間はかかるが成功率は高い」ことがあります。一方、複数OSD喪失でPGがinactiveやincompleteに入ると、データの可用性が落ち、場合によってはデータ欠損のリスクが現実になります。つまり、同じ“赤い”でも意味が違います。

この差を早い段階で見抜くために、最初に揃えるべきは「ログを全部読む」ではなく、クラスターが今どの状態遷移にいるかを把握することです。Cephは内部で状態機械のように進みます。手順が曖昧だと、焦って設定をいじり、回復を遅らせたり、最悪の場合は復旧率を下げる操作(たとえば状況に合わない強制操作)をしてしまいます。

心の会話:現場の本音を、いったん認める

「また“分散”のせいで原因が散らかってる…」

「ceph -s を見ても、結局“何をすればいいか”が書いてない」

「復旧って言われても、復旧してるのか悪化してるのか、数字が読めない」

こう感じるのは自然です。Cephは“自動回復”を持ちますが、自動回復=自動で最短復旧ではありません。自動回復はあくまで「可能な状態遷移に入る」ことであって、帯域・優先度・制限・障害範囲によっては、何時間も何十時間もかかりえます。

この章の結論:最初のゴールは「復旧を始める」ではなく「状態を固定する」

第1章の結論はシンプルです。障害直後にやるべきは、根性論で復旧を“加速”させることではなく、現状の状態(HEALTH・PG・遅延)を固定し、悪化要因を止めることです。次章以降で、復旧時間を支配する“時間軸”を分解し、どの数字を見れば成功率と時間の見通しが立つのかを具体化します。

何が壊れたかより「何が遅いか」—復旧時間を支配する時間軸の見方

Ceph障害対応で「原因は何ですか?」と聞かれる場面は多いのですが、実務的には、原因の確定より先に復旧時間の見通しが要求されます。上司・顧客・関係部門に説明する必要があるからです。ただ、Cephの復旧は“直線的に進む修理”ではなく、複数のフェーズが重なりながら進みます。だからこそ「いま何が遅いか」を時間軸で捉えると、説明も判断もブレにくくなります。

Ceph復旧をフェーズに分ける(現場向けの実用モデル)

障害発生から通常運転に戻るまでを、現場向けに分解すると概ね次のようになります。

- 検知・初動:HEALTHの変化、OSD down/out、MONのクォーラム変動、クライアント影響の有無を確認

- 影響範囲の確定:どのプール/サービスが影響を受けているか、PG状態で可用性を評価

- 安定化:MON/MGRの安定、ネットワーク飽和の抑制、誤操作リスクの排除

- 回復フェーズ:recovery/backfillの進行(データ再配置と複製/EC再構成)

- 整合性フェーズ:scrub/deep-scrubの追いつき、再発防止の監視指標整備

- 説明・再設計:原因と再発防止、運用ルール(変更管理、容量管理、故障ドメイン)の見直し

多くの現場で詰まるのは4番の回復フェーズです。ここは“自動”で進みますが、速度は自動では最適化されません。回復はクライアントI/Oと資源(CPU/ディスク/ネットワーク)を奪い合うため、闇雲に回復速度を上げると業務サービスが死にます。逆に慎重になりすぎると復旧が終わらず、障害が長期化します。

「何が遅いか」を切り分ける観測点(表)

| 遅さの正体 | 現象として見えるもの | 観測ポイント(例) | 対処の方向性(原則) |

|---|---|---|---|

| ネットワーク飽和 | 回復が進まない/クライアント遅延が増える | クラスタ間/ラック間帯域、NICエラー、スイッチ輻輳 | 回復優先度と帯域制限の調整、ボトルネック区間の特定 |

| OSD性能不足 | backfillが頭打ち/IOPSが出ない | OSDのディスク待ち、journal/WAL、DBサイズ、デバイス劣化 | 劣化OSDの隔離、回復対象の順序設計、性能不均衡の是正 |

| PG遷移の停滞 | peeringが終わらない/activeにならない | PG stateの偏り、stuck PG、OSDのflap | まず“揺れ”を止める(安定化)、原因OSD/ネットワークを潰す |

| 設定の過不足 | 回復が遅すぎる/速すぎてサービスが死ぬ | 回復関連の制限値、優先度、同時実行数 | “クライアント優先”を守りつつ段階的に調整(固定値の乱用は避ける) |

この章の結論:復旧時間は「障害の大きさ」より「ボトルネックの種類」で決まる

同じ“OSDが落ちた”でも、ネットワーク飽和が支配しているのか、OSD性能が支配しているのか、PG遷移が停滞しているのかで、時間の見積もりはまったく変わります。だから、まずは「原因のラベル付け」ではなく、遅さの正体を1つに絞るのが実務上の勝ち筋です。次章では、そのために最初に集めるべき“3つの数字”を具体化します。

まず集めるべき3つの数字—HEALTH/PG state/レイテンシで全体像を掴む

Cephの障害対応で最初にやることは、情報収集です。ただし、いきなりログの海に潜ると、判断が遅れます。最初の5〜10分で揃えるべきは、復旧可否(成功率)と復旧時間の見通しに直結する“3つの数字”です。ここが揃うと、上司や顧客への説明も、次の手も、格段に安定します。

数字1:HEALTHの種類と内訳(まず“赤の理由”を言語化する)

CephはHEALTH_OK / HEALTH_WARN / HEALTH_ERRのように健康状態を出しますが、重要なのはラベルではなく内訳です。たとえば、単に「OSDがdown」なのか、「MONクォーラムが不安定」なのか、「PGがinactive」なのかで意味が違います。特に、データ可用性に直結するのはPG関連の指摘です。

- OSD down/out:冗長性が残っていれば回復可能性は高いが、回復負荷が発生する

- PG degraded/undersized:冗長性が欠けた状態。可用性は保てることも多いが、追加障害に弱い

- PG inactive/incomplete:必要なピースが揃わずI/Oできない状態が発生しうる。データ欠損リスク評価が必要

ここで大事なのは、“いまデータが失われた”と決めつけないことです。CephはPGの状態により一時的にアクセス不能になっても、OSDが戻れば復旧することがあります。一方で、物理故障や人的ミスでOSDが完全に失われ、冗長性も失っているなら、欠損が現実になります。最初の段階では「事実として何が起きているか」を押さえます。

数字2:PG stateの偏り(回復が進む状態か、停滞する状態か)

復旧時間の見通しに最も効くのがPG stateです。PGはCephの“配置と回復の単位”で、PGの状態遷移が回復の進み具合を表します。ここで見るべきは、単発のPGではなく「状態の分布」です。

- remapped が多い:再配置の最中。回復がこれから増えるサイン

- degraded が多い:複製/ECピース不足。回復が走れば減っていくはず

- backfill_wait が多い:回復対象があるのに順番待ち。制限値や資源不足が疑わしい

- peering が長い:OSDのflapやネットワーク不安定などで状態が固まらない可能性

ここでの“現場のコツ”は、PG stateを見たら、すぐに「増えているのか、減っているのか」を追うことです。Cephの回復は時間とともに状態分布が変わります。減るべきものが減っていないなら、ボトルネックがある。逆に減っているなら、回復は進んでいる。これだけで、復旧時間の説明が現実的になります。

数字3:クライアントレイテンシ(“回復を速める”前に、サービス影響を測る)

回復が遅いと、つい回復設定を上げたくなります。しかし、Cephは回復処理がクライアントI/Oと同じ資源を使います。特に、RBDやCephFS、RGWなどの利用があるクラスターでは、回復を優先しすぎるとアプリ側の遅延が増え、障害が“二次災害”化します。

そのため、初動で必ず押さえるべき事実は「クライアントI/Oはどれくらい遅いか」です。現場の会話としてはこうです。

「回復は進めたい。でも、業務のDBが死んだら、結局もっと怒られるんだよな…」

この判断を支えるのがレイテンシです。レイテンシが既に悪化しているなら、回復速度を上げる前に、まずボトルネック(ネットワーク/特定OSD/フラップ)を潰し、安定化してから段階的に調整するのが原則です。

この章の結論:「3つの数字」が揃うと、復旧の“筋”が見える

HEALTHの内訳で「何が危険か」を言語化し、PG stateの分布で「進んでいるか停滞しているか」を判断し、レイテンシで「回復をどこまで攻めてよいか」を決める。この3点が揃うと、復旧の成功率と時間に関して、少なくとも“根拠のある説明”が可能になります。次章では、MON/MGRの揺らぎがなぜ成功率を下げやすいのか、そして“状態を固める”ために何を優先すべきかを掘り下げます。

MON/MGRの揺らぎが“復旧の成功率”を下げる理由

Ceph障害対応で意外と見落とされがちなのが、MON(Monitor)とMGR(Manager)の“揺らぎ”です。ディスクが壊れた、OSDが落ちた、という分かりやすい故障より先に、MON/MGRの不安定さが復旧の成功率や時間に影響することがあります。理由はシンプルで、Cephのクラスタ状態(OSDMap、PGMap、CRUSH mapなどの各種Map)はMONが正として配布し、MGRは統計・モジュール・運用可視化の中心になるからです。

現場の心の会話は、だいたいこうです。

「OSDが死んだのは分かる。でも、なんか全体がフワフワしてる…」

「復旧を進めたいのに、Mapが安定しない。見てる数字が信用できない」

こういう状態は、復旧手順を正しく踏んでも結果がブレやすく、“成功率が下がる”方向に働きます。なぜなら、OSDがdown/upを繰り返す(フラップ)状況や、ネットワーク分断に近い状況では、PGのpeeringが進まず、回復対象の再配置が何度もやり直しになり、復旧に必要な帯域とI/Oが無駄に消費されるからです。

MONの本質:クォーラムが揃わないと「判断」そのものが揺れる

MONはクォーラム(過半数)で合意してクラスタの“正しい状態”を決めます。クォーラムが不安定だと、たとえば「OSDをoutにする/しない」「OSDMapの更新」「障害検知の確定」などが不安定になります。データプレーン(OSD同士のデータ処理)が一部継続していても、コントロールプレーン(判断と状態配布)が揺れると、回復フェーズの“やり直し”が起きやすくなります。

ここでの原則は、回復速度の調整より先に、MONを安定させるです。時計ずれ(時刻同期の破綻)、ネットワーク遅延・パケットロス、MONのディスクI/O詰まり、プロセス再起動ループなど、揺らぎの原因は複数あり得ますが、まずは「クォーラムが安定している」事実を作るのが最優先になります。

MGRの本質:復旧の“見通し”を支える観測点がここに寄る

MGRはCephの運用において、可視化やモジュール(Prometheus連携など)に関わる中心です。MGR自体が揺れてもデータが即座に壊れるわけではありませんが、障害時に重要な「進捗」「ボトルネック」「傾向」を取り損ねます。結果として、回復の見積もりが外れたり、誤った打ち手(例えば回復を上げすぎてクライアントI/Oを殺す)を取りやすくなります。

この章の結論:復旧の第一歩は「OSDを増やす」ではなく「コントロールプレーンを固める」

MON/MGRが揺れている状態では、PGもOSDも“正しく回復に向かって進む”前提が崩れます。復旧成功率を上げるという意味でも、まずはクォーラムの安定、ネットワーク品質、時刻同期、MONのI/O健全性を優先して整えます。次章では、OSD障害がPG状態としてどう現れ、どの状態が「時間がかかるだけ」なのか「可用性が落ちて危険」なのかを、もう一段具体的に整理します。

OSD障害とPG地獄—degraded/undersized/remappedの読み解きで迷子にならない

Ceph障害対応で“迷子”になりやすいのがPG状態です。OSDは物理的に壊れる・ネットワーク的に見えない・プロセスが落ちるなど、原因は比較的イメージしやすいのに、PGは状態名が多く、しかも複数状態が同時に付くため、読む順番を間違えると判断がブレます。ここは、成功率(戻せる見込み)と時間(どれだけかかるか)に直結するので、整理して見ます。

まず押さえる前提:OSD “down” と “out” は意味が違う

一般に、OSDが一時的に応答しない状態がdown、CRUSH上の配置対象から外された状態がoutです。downは「戻るかもしれない」、outは「戻らない前提で再配置が進む」方向に寄ります。ここで焦って強制的にoutを増やすと、回復(recovery/backfill)の対象データが一気に増え、ネットワークとディスクに負荷が集中して復旧が長期化しやすくなります。

現場の本音はこうです。

「戻るかもしれないOSDを、勢いでoutにしたら、結局“戻った後”にもっと地獄になりそう…」

この感覚は正しい疑いです。Cephは自己回復しますが、自己回復の“規模”は運用側の判断(outの扱いなど)で変わります。

PG状態の“危険度”をざっくり分類する

PG状態は詳細ですが、障害対応の初動ではまず次のように「危険度」を分類すると迷いにくいです。

| 分類 | 代表的な状態 | 意味(実務的な解釈) | 優先アクション |

|---|---|---|---|

| 時間はかかるが進む系 | degraded / remapped | 冗長性不足や再配置中。基本は回復が進めば減る | ボトルネック特定、回復の進捗が減っているか確認 |

| 順番待ち・詰まり系 | backfill_wait | やるべき回復があるのに進めない(資源や制限が原因になりやすい) | 制限値/帯域/OSD性能/ネットワークを疑う |

| 揺れ・停滞系 | peering が長い、stuck PG | 状態遷移が固まらない。OSDフラップやネットワーク品質が原因になりやすい | まず揺れを止める(OSD/ネットワーク/MON安定化) |

| 可用性が落ちる恐れ系 | inactive / incomplete | 必要なデータ片が揃わずI/Oが成立しない恐れ。欠損リスク評価が必要 | 影響範囲特定、戻せるOSDの優先復帰、慎重な判断 |

重要なのは、「状態名を暗記する」ことではありません。減るべきものが減っているか、揺れていて固まらないのか、可用性が落ちる兆候なのかを分けて考えることです。これができると、復旧時間の説明も「いまは回復が進んでいる」「いまはpeeringが停滞している」など、根拠ある言い方になります。

“PG地獄”を作る典型:OSDフラップと部分的ネットワーク不良

PGがいつまでも安定しない典型原因は、OSDがup/downを繰り返すフラップや、特定のラック・特定のスイッチ配下だけ品質が悪いといった“部分的”なネットワーク不良です。完全断ではなく、たまに通る・遅い・落ちる、という中途半端な状態が最も厄介で、PG peeringのやり直しや回復の巻き戻りを引き起こします。

この場合の現場判断は、「回復設定を上げる」ではなく、「揺れを止める」に寄ります。揺れが止まれば、回復は遅くても前に進みます。揺れが止まらなければ、速くしようとしても進捗が積み上がりません。

この章の結論:PG状態は“危険度”と“増減”で読むと、判断が早くなる

degradedやremappedは“回復フェーズ”のサインであり、進捗が減っているなら時間の問題になりやすい。一方でpeering停滞やstuckは“揺れ”のサインで、先に安定化が必要。inactive/incompleteが見えたら影響範囲とデータの成立条件を慎重に評価する。こうした読み分けができると、復旧成功率と時間の見通しが一段現実的になります。次章では、回復が「終わらない」状態をどう分析し、どこにボトルネックがあるのかを技術的に分解します。

backfill・recoveryが終わらない—優先度・制限・ネットワークが作るボトルネック

Ceph障害対応で最もつらい時間帯は、「回復が走っているのは分かるけど、終わる気配がない」局面です。数字は動く。けれど遅い。関係者からは「いつ終わるの?」と聞かれる。現場はこう思います。

「回復してるのに、ずっと終わらない。これ、何か間違ってる?」

ここは“根性”で乗り切るところではなく、ボトルネックを分解して見積もり可能な形に落とすところです。復旧時間は最終的に、回復対象のデータ量と実効スループットで決まります。実効スループットはネットワーク・ディスク・CPU・そしてCeph自身の制限値(スロットリング)の最小値に引っ張られます。

recovery と backfill を混同しない

用語としては環境や状況で見え方が変わりますが、実務的にはこう捉えるとよいです。

- recovery:冗長性を回復するためのデータ再構成(不足した複製やECピースを埋める)

- backfill:配置のズレを埋めるためのデータ移動(再配置後にデータを移す)

どちらも「ネットワークとディスクを使うデータ移動」です。違いは、トリガ(OSDのoutやCRUSH変更など)と、対象範囲の広がり方です。特に大きなクラスターでは、OSDの大量outやCRUSHルール変更があるとbackfillが広範囲に走り、時間が跳ねやすくなります。

“実効スループット”を決める3つの足かせ

回復が終わらないとき、だいたい足かせは次の3系統に分かれます。

1) ネットワーク:帯域だけでなく「品質」が効く

帯域が細いと遅いのは当然ですが、Cephでは“品質”も効きます。パケットロスや遅延があると、OSD間通信が不安定になり、回復が再送や待ちで詰まります。特定区間だけ悪い場合、PGの一部だけが停滞して「全体が終わらない」印象になります。回復は分散して進むので、遅いところが最後まで残るからです。

2) ディスク/OSD:遅いOSDが最後まで足を引っ張る

クラスターに性能の不均一があると、回復は“遅いOSD”に引っ張られます。特に障害で残存OSDに負荷が寄ると、普段は見えていなかった遅さが顕在化します。OSD側のI/O待ちが増えれば、回復もクライアントI/Oも同時に苦しくなります。

3) 制限値(スロットリング):安全のために意図的に遅くなる

Cephは、回復がクライアントI/Oを殺さないように、回復の同時実行数や優先度、スリープなどの制御(設定)を持ちます。ここを上げれば回復は速くなり得ますが、上げすぎれば業務I/Oが悪化します。つまり、ここは“アクセル”であり、踏む前にメーター(レイテンシ)を見る必要があります。

回復時間の説明を「見積もり」に寄せる(表)

| 見積もりに必要な材料 | 意味 | 詰まりやすいポイント |

|---|---|---|

| 回復対象のデータ量 | 失われた冗長性/再配置で動かす必要があるデータの総量 | out操作やCRUSH変更で急増しやすい |

| 実効スループット | 回復に使える帯域とI/O(ネットワーク×ディスク×制限値の最小) | 遅い区間・遅いOSD・制限値が“最後まで残る” |

| クライアント影響の上限 | 業務I/Oを壊さない範囲で回復をどこまで上げるか | 攻めすぎると二次障害、慎重すぎると長期化 |

この3つが言語化できると、「あと何時間ですか?」に対して、単なる希望的観測ではなく、条件付きで説明できます。たとえば「ネットワークがここまで空けば」「遅いOSDを隔離できれば」「回復設定を段階的に上げられれば」といった形です。これは現場にとっても救いになります。説明できる状態は、再現可能な運用に近づくからです。

この章の結論:終わらない回復は、だいたい“最後に残る遅い要素”が原因

回復は並列に進みますが、最後は遅いところが残ります。だから「全体の平均」より「遅い要素の特定」が重要です。ネットワーク品質、遅いOSD、過度に低い制限値、あるいは揺れ(フラップ)で進捗が積み上がらない。ここを特定できれば、復旧時間は“運”ではなく“見積もり”になります。次章では、実際に触る順番で結果が変わる理由を整理し、成功率を上げる「やること/やらないこと」を手順としてまとめます。

触る順番で結果が変わる—成功率を上げる「やること/やらないこと」

Cephの障害対応は、「何をするか」以上に「どの順番で触るか」で結果が変わります。復旧の成功率が落ちる典型は、焦って“加速”を狙った操作が、回復対象を増やしたり、揺れ(flap)を増幅させたり、クライアントI/Oを巻き込んで二次障害を起こすパターンです。逆に、順番を守るだけで、回復が“前に進む”状態に入りやすくなります。

心の会話:現場の疑いは健全です

「設定を上げれば早くなる?…でも、今それやっていいの?」

「OSDをoutにしたら回復が走るのは分かる。でも、戻る見込みがあるなら待つべき?」

この疑いはむしろ正しいです。Cephは自動回復しますが、回復の規模と負荷は運用判断(out扱い、制限、優先度、復旧対象の増減)で変わります。つまり、“早くしたい”がそのまま最短復旧にはならないことがあります。

やること:まず「揺れを止める」→「影響範囲を絞る」→「回復を進める」

実務で有効な優先順は、次の3段です。

- 揺れを止める(安定化):MONクォーラムが安定しているか、OSDがflapしていないか、ネットワーク品質(遅延・ロス)が局所的に悪化していないかを確認し、まず“状態が固まる”事実を作る。

- 影響範囲を絞る(評価):どのプール/サービスに影響が出ているか、PG状態分布が「進む系」か「停滞系」か「可用性低下系」かを分ける。ここで初めて成功率と時間の見通しが立つ。

- 回復を進める(段階調整):レイテンシを監視しながら、回復を段階的に調整する。最初から最大化しない。クライアントI/Oを守りつつ、回復が“減っていく”状態を維持する。

この順番を守ると、障害対応の会話が「気合い」ではなく「観測と判断」になります。関係者への説明も、「まず安定化」「次に影響評価」「最後に回復速度の調整」と段階が明確になり、意思決定が荒れにくくなります。

やらないこと:回復対象を“無駄に増やす”操作を初動で多用しない

初動で避けたいのは、回復対象を必要以上に増やし、backfill/recoveryの総量を膨らませる動きです。たとえば、戻る見込みがあるOSDを性急に「戻らない前提」に寄せると、回復対象が増え、ネットワークとディスクの奪い合いが激化して、結果として復旧が長引くことがあります。

もちろん、物理故障で戻らないOSDを待ち続けるのも危険です。要点は「戻る可能性の判断(根拠)」と「回復対象が増えるコスト」を天秤にかけることです。ここを曖昧にすると、成功率(安全に戻せる見込み)も、時間(終わる見通し)も両方が悪化しやすくなります。

判断をブレにくくするチェック表

| 確認項目 | 見たい事実 | 次の一手の方向 |

|---|---|---|

| MONクォーラム | 安定して維持されている(揺れない) | 揺れているなら回復調整より先に安定化 |

| OSDのflap | 特定OSDがdown/upを繰り返していない | 原因切り分け(ネットワーク/電源/ディスク/負荷)を優先 |

| PG状態の増減 | degraded/remapped等が時間とともに減っている | 減らないならボトルネック特定、無理な加速はしない |

| クライアント遅延 | 許容範囲で推移している | 悪化しているなら回復を攻める前に原因を潰す |

この章の結論:成功率を上げるコツは「大きく動かす前に、小さく確かめる」

Ceph復旧は、一撃で解決する操作があるタイプの障害対応ではありません。揺れを止め、影響範囲を言語化し、回復を段階的に進める。これだけで、復旧が“前に進む”確率が上がり、説明可能性も上がります。次章では、そもそも「復旧が短く終わるクラスター」は何が違うのか、設計と運用の観点から整理します。

復旧時間を短くする設計—CRUSH・故障ドメイン・容量計画・地味な監視

障害対応が長引くたびに、「結局Cephって難しい」「分散はコストが高い」と言われがちですが、実は復旧時間の長さは“運用の頑張り”だけではなく、設計段階の前提でかなり決まります。CephはCRUSHによってデータ配置を決めるため、故障ドメイン(host/rack/zone)設計と容量計画が、回復フェーズの負荷と時間を直撃します。

CRUSHと故障ドメイン:壊れ方に合わせて「散らす」

分散ストレージの狙いは、単一障害で全体が止まらないことです。しかし故障ドメインの設計が現実と噛み合っていないと、障害時に回復対象が偏り、回復が遅くなります。たとえば、同一ラック内のスイッチ障害が起きる可能性が高い環境で、データがラック内に偏る設計になっていると、ラック単位障害で同時に多数のOSDが影響を受けます。するとPGの可用性が落ちたり、回復対象が一気に膨らんだりして、復旧が長期化します。

要点は、「現実に起きる故障単位」を基準にCRUSH階層を設計することです。host故障が多いのか、ラック障害が現実的なのか、電源系が弱いのか、ネットワーク分断があり得るのか。ここを前提に置くと、復旧の成功率と時間が読みやすくなります。

容量計画:空きがないクラスターは、回復が遅い(そして危険)

復旧が遅いクラスターの共通点として、空き容量が逼迫しているケースがあります。回復は「別の場所に複製/再配置する」処理なので、空きが少ないと、配置の自由度が落ち、回復が詰まりやすくなります。さらに、空きがない状態で障害が重なると、回復どころか可用性が落ちる方向に寄りやすく、成功率の評価自体が厳しくなります。

現場の本音はこうです。

「今は動いてるけど、障害が起きたら回復する“余白”がない。これ、危ないよな…」

これは正しい危機感です。分散ストレージは“平常時の性能”よりも、“障害時に回復できる余白”が重要です。

監視:地味だが最強の短縮策は「詰まりを早く見つけること」

復旧時間を短縮する最も現実的な施策は、障害時に必要な観測点が、平常時から揃っていることです。障害時に慌てて計測を始めると、原因が消えたり、再現できなかったりします。最低限、次のような観測があると「遅さの正体」を早く絞れます。

- PG状態分布の時系列(増減が見えること)

- クライアントレイテンシの時系列(回復をどこまで攻められるか判断できること)

- ネットワーク品質(帯域だけでなく遅延・ロス・輻輳)

- 遅いOSDの特定(極端に遅いノード/デバイスが最後まで残るため)

この“地味な四点セット”があるだけで、復旧の説明が「雰囲気」から「数字」に寄ります。数字に寄るほど、関係者の納得と、現場の意思決定が安定します。

設計で効くポイント(表)

| 設計・運用の論点 | 復旧時間への影響 | 失敗しやすいパターン |

|---|---|---|

| 故障ドメイン | 同時障害の範囲を限定し、回復対象の爆発を抑える | 現実の故障単位とCRUSH階層がズレている |

| 容量の余白 | 回復の配置自由度が上がり、詰まりを減らす | 平常時に“使い切る”設計で、障害時に回復できない |

| 性能の均一性 | “遅い要素が最後まで残る”問題を緩和する | 一部だけ遅いディスク/ノードが混在し、回復が頭打ち |

| 監視の粒度 | 詰まりの原因特定が早くなり、無駄な試行錯誤が減る | 障害時に必要な時系列がなく、判断が後手に回る |

この章の結論:復旧を短くする最短ルートは「障害時に回復できる余白」を設計で持つこと

障害対応の手順を磨くのも重要ですが、復旧時間を短くする根本は、CRUSHと故障ドメイン、容量の余白、監視の準備にあります。ここが整っていると、障害時の打ち手が少なくて済み、復旧は“再現可能”になります。次章では、障害後に必ずやるべき事後分析(タイムライン化)を扱い、「次は同じ地獄を踏まない」ための整理に進みます。

次が楽になる事後分析—ログとメトリクスで“説明できるタイムライン”を作る

Ceph障害対応がひと段落すると、現場には「もう触りたくない…」という疲労が残ります。ですが、ここで事後分析を省くと、次の障害で同じ迷子を繰り返し、復旧時間も説明コストも増えます。事後分析の目的は“犯人探し”ではなく、次回の復旧成功率を上げ、復旧時間の見積もり精度を上げることです。

事後分析のコアは「時系列」と「因果」を分けること

障害報告が荒れる典型は、時系列(何が起きたか)と因果(なぜ起きたか)が混ざるケースです。まずは事実の列を作ります。たとえば、次のように「観測できる事実」を時刻順に並べます。

- 最初に検知したアラート(HEALTHの変化、レイテンシ上昇など)と時刻

- OSD down/up、OSD out/in の変化と時刻

- MONクォーラム変動、MGR切替などコントロールプレーンの変化

- PG状態分布(degraded/remapped/peering/inactive等)の推移

- 回復(recovery/backfill)の進捗が“減った/止まった/再加速した”時刻

- ネットワーク帯域・遅延・ロスなどの変化点

この「時系列」さえ作れれば、因果の議論が現実に寄ります。逆に、時系列が曖昧なまま「たぶんネットワーク」「たぶんディスク」と言い合うと、改善策が抽象化して、次に効きません。

最低限集めたい“証跡”は「再現性のある形式」で

障害時に後から効くのは、スクリーンショットよりも、機械可読な出力です。CephのCLIは人間向け表示もありますが、可能ならJSON形式を優先します。理由は、事後に同じ軸で比較でき、属人性が下がるからです。

- クラスタ概要:

ceph -s、ceph health detail(可能ならJSON出力) - PG観測:

ceph pg stat、stuck PGの情報(状態分布の推移を残す) - OSD観測:

ceph osd tree、ceph osd df、OSDごとの偏り - サービス影響:アプリ側レイテンシ、I/O待ち、タイムアウト増加の時刻

- 基盤観測:NICエラー、スイッチ側ログ(可能範囲)、時刻同期状況

ここでの現場の本音はこうです。

「あとで振り返るって言われても、結局“そのときの情報”が残ってないんだよな…」

だからこそ、障害対応の“途中”で、一定間隔で要点を採取する運用(またはスクリプト化)が効きます。これは「復旧を早くする」だけでなく、「説明できる」ことにも直結します。

“遅さの正体”を一言に落とす(改善が進む書き方)

事後分析の結論は、細部の羅列ではなく、遅さの支配要因を一言で言える形に寄せると、改善施策が刺さります。たとえば、次のような整理です。

| 支配要因の型 | 時系列で見える特徴 | 改善の方向 |

|---|---|---|

| ネットワーク品質型 | peering停滞やflapが出る。回復が進んだり戻ったりする | ボトルネック区間の特定、品質監視、設計(故障ドメイン)見直し |

| 遅いOSD型 | 最後に特定OSD/ノードが残り、全体完了が遅れる | 性能不均衡の解消、劣化デバイスの早期交換、混在構成の再検討 |

| 制限値・優先度型 | 回復が常に低速で安定。クライアント影響は小さいが完了が遅い | 段階的な調整指針の整備、障害時の運用Runbook化 |

| 容量逼迫型 | backfill_waitが多い、配置自由度が低く詰まる | 容量計画、余白確保、拡張計画とアラート閾値の見直し |

この章の結論:事後分析は「復旧の成功率」と「説明可能性」を同時に上げる投資

Ceph障害は、対応中の判断だけでなく、対応後の“学習”で難易度が下がります。時系列と証跡が残っていれば、次は早く状況を固定でき、どこが遅いかを短時間で絞れます。結果として復旧時間が短くなり、復旧成功率(安全に戻せる見込み)も上がります。次章では、ここまでの流れを踏まえて「一般論の限界」と「個別案件で専門家に相談すべき理由」を、現場目線でまとめます。

結論:Ceph復旧は「運」ではなく「数字と手順」で再現できる

Cephクラスター障害の復旧は、外から見ると“運ゲー”に見えることがあります。実際、分散システムには不確実性があり、障害の組み合わせも多いです。ただ、現場で再現性を作る鍵はあります。それが「数字(観測)」と「手順(順番)」です。本記事で扱ったのは、原因特定を急ぐより先に、復旧成功率と復旧時間に直結する事実を集め、揺れを止め、遅さの支配要因を絞るという考え方でした。

この結論に至る“伏線”を回収する

第1章で触れた「まず状態を固定する」は、MON/MGRの揺らぎやOSDフラップを止めることにつながります。第2章の「何が壊れたかより何が遅いか」は、回復対象量と実効スループットの観点に落ち、終わらない回復のボトルネック特定(ネットワーク品質・遅いOSD・制限値)に接続します。第3章の“3つの数字”は、状況説明の軸にもなり、事後分析で時系列を作る材料にもなります。つまり、書き出しのモヤモヤは、数字と手順に収束します。

ただし、一般論には限界がある(Cephは「条件の数」が多い)

ここが重要です。Cephは、設計(CRUSH/故障ドメイン、レプリカ/EC、ネットワーク構成、デバイス構成)と運用(監視、変更管理、障害時の判断基準)によって、同じ“症状”でも最適解が変わります。例えば、

- ECプールかレプリカプールかで、復旧時の計算・転送コストが変わる

- クラスター規模やPG数、OSD数で、回復の並列性や“最後に残る遅い要素”の形が変わる

- ネットワークが二重化されているか、分離されているかで、回復時のボトルネックが変わる

- 業務I/Oの特性(小IO中心か、大IO中心か)で、回復の攻め方が変わる

つまり「こうすれば必ず早い」「この設定が正解」と断言できる単一の処方箋は存在しません。ここを無理に一般化すると、かえって危険です。障害対応は、誤操作が取り返しのつかない結果につながり得るからです。

現場が本当に欲しいのは「判断の外注」ではなく「安全な意思決定の支援」

「また新しいツール?どうせ運用が増えるだけじゃないの」

「“それ、誰がメンテするの?”ってまず考える」

この感情は自然です。だからこそ、外部に相談するときも、丸投げではなく、現場の制約(止められない、移行コストを増やせない、夜間対応を減らしたい)に沿って、どこまでを“守り”、どこからを“変える”のかを一緒に設計できる相手が必要になります。

株式会社情報工学研究所のような専門家に相談する価値が出るのは、まさにここです。単なるコマンド手順の提示ではなく、

- クラスター設計と現実の故障モードの整合(故障ドメイン、容量余白、性能不均衡)

- 障害時の観測点(数字)とRunbook(順番)の整備

- 復旧時間の見積もりと、業務影響(レイテンシ)とのトレードオフ設計

- 事後分析の型化(説明可能性の確保、再発防止の実装)

といった「一般論では決めきれない部分」を、個別の条件に合わせて現実解へ落とす支援です。復旧成功率と復旧時間は、こうした意思決定の質に大きく依存します。

この章の結論:悩んだときは「条件整理」から始めるのが最短

もし今、具体的な案件・契約・システム構成の制約(止められない、性能要件が厳しい、増設が難しい、ログが残っていない等)で悩んでいるなら、まずは条件整理から始めるのが最短です。何を優先し、何を守り、どこを変えられるか。その整理ができると、復旧方針も、予防策も、費用対効果も現実的になります。必要に応じて、株式会社情報工学研究所への相談・依頼を検討してください。

付録:現在のプログラム言語各種でCeph運用・障害対応を自動化する際の注意点

Cephの運用・障害対応は、CLIやAPI、監視基盤、ログ収集の組み合わせで自動化できます。ただし自動化は、誤ると復旧成功率を下げるリスクもあるため、言語ごとの“落とし穴”を理解しておくことが重要です。共通の原則として、人間可読なCLI出力のパースに依存しすぎず、可能ならJSON等の機械可読形式を優先し、タイムアウト・リトライ・冪等性(同じ操作を繰り返しても壊れない)を設計に入れます。

言語別の注意点(表)

| 言語 | 注意点(運用でハマりやすい) | 実務的な対策の方向 |

|---|---|---|

| Bash / Shell | エラー処理・引用符・空白で壊れやすい。部分失敗の検知が弱い | set -e相当だけに頼らず、戻り値・標準エラー・JSON検証を明示。段階ログを残す |

| Python | subprocessの扱い、例外の握りつぶし、依存関係差異で事故りやすい | 構造化ログ、例外の分類、タイムアウト、再試行、環境固定(venv等) |

| Go | 並行処理で“やりすぎ”になりやすい。タイムアウト未設定で詰まる | contextでキャンセル/期限を徹底。同時実行数制限、リトライは指数バックオフ |

| Rust | FFIやライブラリ連携の難易度、学習コストが高い。実装が重くなりがち | まずはCLI+JSONで安全に自動化。必要領域だけ段階的に高信頼化 |

| Java | 長時間プロセスでGCやスレッドプール運用が効く。過剰な抽象化で調査が遅れる | メトリクス/ログの標準化、I/Oタイムアウト、スレッド上限、障害時のダンプ設計 |

| JavaScript / TypeScript(Node.js) | 非同期処理の例外伝播、メモリ上限、child_process運用で落ちやすい | Promiseの例外設計、プロセス分離、ストリーム処理、再試行とレート制限 |

| PowerShell | 文字列ではなくオブジェクト中心で、外部CLIとの境界で混乱しやすい | 外部CLI出力はJSON化して受ける。リモート実行はタイムアウトと権限を明確化 |

| C / C++ | ABI/依存関係、メモリ安全性、ビルド環境差で保守が難しい | 運用自動化の中核に据える前に、責務を限定。テストとフェイルセーフを厚くする |

| Ruby / PHP | 長時間ジョブや大量ログ処理で性能・メモリが課題になりやすい | バッチ分割、ストリーミング処理、実行時間制限、ログの構造化 |

自動化で特に重要な共通ポイント

- 冪等性:同じチェックや収集は何度実行しても安全に。危険操作は必ず人手承認の設計に寄せる

- タイムアウトと再試行:ネットワーク揺らぎや一時エラーを前提に、無限待ちを避ける

- 段階ログ:いつ、何を、どの条件で実行したかを残し、事後分析(第9章)に直結させる

- 機械可読の優先:人間向け出力のパースは壊れやすい。形式を固定し、比較可能性を上げる

- 権限と秘密情報:認証情報は平文に置かない。実行権限を最小化し、監査可能性を確保する

付録の結論:自動化は“復旧を速くする”だけでなく“復旧を安全にする”ためにある

Ceph障害対応は、速さと安全性が常にトレードオフになります。自動化は、そのトレードオフを“運用の設計”として固定し、属人性を下げるために有効です。ただし、個別のクラスター条件(構成、業務要件、停止許容、変更管理)によって最適解は変わります。自社だけで判断が難しい場合は、株式会社情報工学研究所のような専門家と一緒に、条件整理・観測設計・Runbook化まで含めて進めるのが安全です。

もくじ

- そのアラート、何が“終わった”合図なのか:Ceph障害で現場が一番つらい瞬間

- Cephは「壊れた」より「整合性が崩れた」が本質:まず押さえるRADOSの前提

- 復旧の出発点はここ:HEALTH/Quorum/OSD/PGを最短で把握する読み方

- 典型的な崩れ方トップ3:ネットワーク分断/OSD連鎖ダウン/容量逼迫(FULL)

- 成功率を決めるのは“設定と履歴”:レプリカ数、EC、Failure domain、運用ルール

- 時間を食う正体:backfill・recovery・scrub・deep-scrubの衝突とI/O飽和

- 触っていいもの/触ると詰むもの:安全な初動手順とやってはいけない操作

- 「あと何時間?」に答える:メトリクスとログで復旧時間を見積もる実務

- もう一度同じ夜を繰り返さない:再発防止(監視設計/容量計画/変更管理)

- 結論:復旧の成功率と時間は“初動と設計”でほぼ決まる(無料相談の使いどころ)

【注意書き】本記事は、Linux上で運用されるCephクラスター障害(分散ストレージ障害)に関する一般的な技術情報の提供を目的としています。Cephの復旧可否(成功率に相当)や復旧時間は、構成(レプリカ/EC、CRUSHルール、障害ドメイン、容量、ネットワーク、運用変更履歴、障害の進行度合い)によって大きく変わります。現場での操作はデータ損失を拡大させるリスクがあるため、個別案件の判断が必要な場合は、株式会社情報工学研究所のような専門家へご相談ください。

そのアラート、何が“終わった”合図なのか:Ceph障害で現場が一番つらい瞬間

Cephの障害対応で、現場が一番しんどいのは「状態が変わり続けて、判断材料が追いつかない瞬間」です。アラートが鳴り、ダッシュボードにはPGの遷移、OSDのup/down、リカバリーの進捗、クライアントI/Oの遅延が同時に並びます。ここでよく起きるのが、次の“心の会話”です。

「復旧って、今どこまで進んでる? そもそも“復旧できる前提”が残ってる?」

この問いは健全です。分散ストレージの復旧は、単にプロセスを再起動して終わりではありません。Cephは“整合性”を守るために、内部で大量の再配置(rebalance/backfill/recovery)を実行します。つまり、復旧中のクラスターは「復旧のために忙しい」状態になり、そこに追加操作を入れると、成功率(復旧の成立)や復旧時間に直結してしまいます。

まず最初にやるべきことは、慌てて“治しに行く”より、現状の固定(観測)です。次の情報は、後から必ず効いてきます。

- 障害発生時刻、直前の変更(OSアップデート、ceph config変更、ネットワーク工事、ディスク交換など)

- ceph -s / ceph health detail の出力(可能なら時系列で保存)

- MONのquorum状況、OSDのup/in、PGの主要状態(active+clean / degraded / peering / undersized など)

- 満杯系フラグ(nearfull/backfillfull/full)と容量推移

なぜ観測が重要かというと、Cephの復旧は「今の状態」だけでなく「そこに至る履歴(どの順番で何が落ちたか、何を戻したか)」が結末を左右するからです。復旧時間の見積もりも、PGの状態遷移と回復レートが分からないと、根拠ある説明ができません。

本記事では、復旧の成功率と時間を左右する要因を、設計・運用・障害進行の観点から整理し、現場が“判断できる材料”を増やすことをゴールにします。

Cephは「壊れた」より「整合性が崩れた」が本質:まず押さえるRADOSの前提

Cephの中核はRADOS(Reliable Autonomic Distributed Object Store)で、データは“オブジェクト”として分割され、PG(Placement Group)単位で管理されます。多くの障害は「サーバが落ちた」というより、PGが正しい集合(正しいOSD群)に到達できず、整合性を確かめられないことから始まります。

ここで重要なのは、Cephの“復旧”が2層ある点です。

- サービス復旧(見かけの復旧):クライアントI/Oが再開し、一定の読み書きができる

- 整合性復旧(本当の復旧):PGがactive+cleanに戻り、レプリカ/ECの冗長性が復元される

前者だけを追うと、「動いたからOK」と誤認しがちです。しかし、degradedのまま運用を続けると、次の一撃(追加障害)で取り返しがつかなくなります。復旧時間の議論は、原則として後者(active+clean到達)を基準にしたほうが安全です。

また、Cephは複数の役割が協調します。障害時に“何が詰まっているか”を見誤ると、無駄に時間を使います。

| コンポーネント | 役割(要点) | 障害時に起きやすいこと |

|---|---|---|

| MON | クラスター状態の合意(quorum)とマップ配布 | quorum不成立で全体判断が不能、OSD/PGが落ち着かない |

| OSD | 実データの保持と複製/ECの実行 | フラップ(up/down)でPGがpeeringを繰り返し、復旧が進まない |

| MGR | 監視・統計・モジュール(Prometheusなど) | 可視化が弱まり、復旧見積もりが困難になる |

| ネットワーク | OSD間のレプリケーション/バックフィル | 遅延/ロスでリカバリーが“進んでいるようで進まない” |

つまり、成功率と時間を議論する前に「いま、合意(MON)・データ面(OSD/PG)・搬送(NW)のどこが律速か」を切り分ける必要があります。次章では、その切り分けを最短距離で行う“読み方”を整理します。

復旧の出発点はここ:HEALTH/Quorum/OSD/PGを最短で把握する読み方

Cephの障害対応は、最初の10〜20分で“方向性”が決まりやすいです。理由は単純で、リカバリーは時間が経つほど進む一方、誤操作の影響も時間とともに増幅するからです。まずは、短いコマンドで全体像を掴み、必要に応じて深掘りします。

初動で役立つ代表的な確認観点を、目的別にまとめます(環境や運用によりコマンドは変わりますが、見たいものは同じです)。

| 目的 | 見るべき観点 | ポイント |

|---|---|---|

| 全体の健康状態 | HEALTH概要、警告の内訳 | まず“最上位の警告”を固定して、下位は後追い |

| 合意状態 | MON quorum、MONの数・偏り | quorumが不安定なら、PGは落ち着かない |

| データ面の損傷度 | PGの状態分布、degraded/undersized/peering | PGが“止まっている”のか“遅い”のかを分ける |

| 復旧の進捗 | recovery/backfillの量と速度 | 速度が安定しているか(波が大きいと見積もりが外れる) |

| 容量の制約 | nearfull/backfillfull/full | 満杯系は復旧そのものを止める要因になりやすい |

ここで重要なのは、復旧の“作業”より先に、復旧を阻害する条件を潰すことです。たとえば次のような状態だと、どれだけ待っても復旧が進みません。

- MONのquorumが頻繁に変わる(合意が取れていない)

- OSDが断続的に落ちる(peeringが巻き戻る)

- 容量がbackfillfullに近く、再配置が進まない

- ネットワークが逼迫し、リカバリーが遅延してタイムアウトする

「待てば戻るのか」「何かを直さないと戻らないのか」を、この段階で分けられると、復旧時間の見積もりが現実的になります。次章では、典型的な崩れ方を3パターンに整理し、どこで詰まりやすいかを具体化します。

典型的な崩れ方トップ3:ネットワーク分断/OSD連鎖ダウン/容量逼迫(FULL)

Ceph障害の“見た目”は多彩ですが、復旧の難易度と時間に直結する原因は、現場ではだいたい3系統に収束します。ここを外すと、復旧を長引かせる操作をしがちです。

1) ネットワーク分断(部分断・遅延・パケットロス)

ネットワークが不安定だと、OSDは生きていても互いに会話できず、PGがpeeringを繰り返します。このとき「ノードは動いているのに、クラスターが落ち着かない」という症状になります。復旧は“計算”ではなく“通信”で詰まるため、復旧時間は一気に読みにくくなります。

注意点は、分断が短時間で収束する場合に、過剰な再配置を走らせてしまうことです。Cephは障害に対して自律的に再配置を始めますが、ネットワークが戻った直後にさらに設定変更やOSD再作成を重ねると、復旧が二重に走って時間が伸びます。

2) OSD連鎖ダウン(ディスク/電源/バックエンド不調の波及)

OSDが複数同時に落ちるケースは、成功率(復旧成立)に直結します。レプリカ構成なら、同一PGの複製が同時に失われると、データが欠損します。EC(消失訂正)なら、必要なk+mのうち、復元に必要な本数が揃わないと復元できません。

この系統の怖さは、OSDが「落ちる→戻る」を繰り返すフラップ状態です。フラップは、復旧を“進める”より“巻き戻す”影響が大きく、結果として復旧時間が伸びます。まずはディスクI/Oエラー、バックエンド(BlueStore/RocksDB等)の異常、温度、電源、コントローラ、カーネルログの順に、落ちている理由を潰すべきです。

3) 容量逼迫(nearfull/backfillfull/full)

満杯系は、復旧を“止める”タイプの障害です。Cephは安全のため、一定のしきい値を超えると書き込みを制限し、再配置(backfill)を抑制することがあります。つまり、復旧を進めるのに必要な“空き”がなくて進まない、という状態が起きます。

ここでありがちな誤りは、空きを作るために慌てて大量削除をしてしまうことです。削除そのものがクラスターに負荷をかけ、また、削除後の再平衡でさらに負荷が上がる場合があります。空きを作るなら、対象と手順を絞り、復旧I/Oと競合しないように計画的に進める必要があります。

この3系統は単独ではなく、連鎖して起きます。ネットワーク遅延でOSDが誤検知ダウンし、再配置で容量が逼迫し、回復が遅れてさらにタイムアウトが増える、といった悪循環です。次章では、こうした悪循環に耐えるために、設計・設定・履歴のどこが成功率を左右するのかを整理します。

成功率を決めるのは“設定と履歴”:レプリカ数、EC、Failure domain、運用ルール

Cephの復旧が成立するかどうか(現場感でいう“成功率”)は、運用中の“その瞬間”に決まるというより、平時の設計と運用変更の積み重ねでほぼ決まります。障害が起きたとき、残っている冗長性と整合性の“余力”がどれだけあるかが全てだからです。

冗長化方式(レプリカ vs EC)の現実的な違い

レプリカは直感的で、復旧も比較的読みやすい傾向があります。一方ECは容量効率が良い代わりに、復旧時に計算と転送が増え、ネットワークやCPUの影響を受けやすく、復旧時間が伸びやすいことがあります。どちらが良い悪いではなく、障害時にボトルネックがどこに出るかが違います。

Failure domain(障害ドメイン)とCRUSHの一致が生命線

“ホストが違うから大丈夫”と思っていても、実際には同一ラックのスイッチ配下、同一電源系統、同一ストレージ棚など、同じ障害ドメインに偏っていると、同時障害で一気に欠損が出ます。CRUSHルールが、物理トポロジー(ラック/ルーム/電源/スイッチ)と一致しているかは、復旧成立の根にあります。

| 観点 | 良い状態 | 危険な状態 |

|---|---|---|

| 障害ドメイン | ラック/電源/スイッチ単位で分散 | ホストだけ分散、実は同一スイッチ配下 |

| CRUSH設計 | ルールと実機配置が一致 | 実機増設・更改後にルールが追従していない |

| 運用変更 | 変更履歴が残り、ロールバック可能 | 障害直前に複数変更、何が効いたか不明 |

“履歴”が成功率を左右する理由

同じ障害でも、直前の操作で結末が変わります。たとえば、重み調整(reweight)やOSDのin/out、CRUSHマップ更新、容量しきい値の変更、再配置抑制フラグの操作などは、復旧の方向を変えます。復旧の場面では、これらの操作は“必要なときにだけ”行うべきで、やみくもに触ると復旧時間を伸ばし、最悪の場合はデータ欠損の範囲を広げます。

ここまでのポイントを一言で言うと、復旧は「障害の種類」より「残っている余力」の問題です。次章では、復旧時間がどこで増えるのか、そして“時間を食う正体”を分解します。

時間を食う正体:backfill・recovery・scrub・deep-scrubの衝突とI/O飽和

「復旧って、どれくらいで終わりますか?」に答えにくい理由は、復旧時間が“1つの処理”ではなく、複数の重い処理の合成だからです。Cephは自律的にデータを再配置し、複製やECの再生成を行い、さらに整合性検査(scrub/deep-scrub)も走ります。これらが同時に走ると、I/Oとネットワークが飽和し、復旧が遅れます。

復旧I/Oは「通常業務I/O」と競合する

クライアントI/Oが残っている(サービスを止められない)状況では、復旧I/Oは“空いた分”しか使えません。すると復旧速度は下がり、見積もりは伸びます。逆に、復旧を優先しすぎると、サービス側の遅延が増え、現場に二次被害(タイムアウト、アプリ障害)が出ます。ここは、技術だけでなく業務判断(どれだけ劣化運転を許容するか)も必要です。

scrub/deep-scrubの扱いは繊細

scrubは整合性確認として重要ですが、復旧中に負荷が高い状態で走ると、復旧I/Oを圧迫します。一方で、scrubを長期間止めると、潜在的な不整合を見逃すリスクもあります。つまり、止める/動かすの二択ではなく、状況に合わせた調整が必要です。

復旧時間を伸ばす“典型”

- バックフィル対象が多い(障害範囲が広い、OSDのin/outが連続した)

- ネットワークが細い、あるいは混雑している

- OSDのバックエンドが遅い(HDD中心、あるいはDB領域の劣化)

- 容量が逼迫し、再配置の行き先が少ない

- OSDがフラップしてPGの状態が巻き戻る

復旧時間を“技術的に短くする”には、律速を突き止め、そこだけを改善するのが基本です。ネットワークが律速なら帯域と遅延、ディスクが律速ならOSDのI/O待ちとバックエンド、容量が律速なら空き確保の手順です。次章では、ここで誤りやすい「触っていいもの/触ると詰むもの」を、現場目線で整理します。

触っていいもの/触ると詰むもの:安全な初動手順とやってはいけない操作

Ceph障害で怖いのは、善意の操作が“不可逆”になることです。特に、OSDの作り直し、デバイス初期化、設定の一括変更は、後戻りできない影響を持ちます。ここでは「安全側の初動」を中心に整理します。

安全側に倒しやすい初動

- 観測の固定:状態出力を保存し、障害が収束方向か悪化方向かを把握する

- 物理/基盤の健全化:電源、リンク、スイッチ、NIC、ディスクエラーなど“落ちる理由”を潰す

- 単純再起動の乱用を避ける:落ちる原因が残ったまま再起動するとフラップを助長する

- 容量しきい値の意味を確認:満杯系の状態では、手を入れるほど悪化する場合がある

やってはいけない(または慎重に扱う)代表例

- OSDの“初期化”や“再作成”を急ぐ:本当に必要な場合でも、順序と確認が必須

- 欠損の可能性がある状態での強制的な整合操作:欠損範囲を確定させてしまうことがある

- 状況不明のままの大規模なin/out操作:バックフィルを増やし、復旧時間を伸ばす

- 監視値だけで“終わった扱い”にする:active+clean到達と冗長性復元の確認が必要

「じゃあ、何もしないのが正解?」という話ではありません。“触るなら、何を守るために触るのか”を言語化できる操作だけをするのが現実解です。たとえば、フラップが原因なら物理要因を止める、容量が原因なら計画的に空きを作る、ネットワークが原因ならリンク品質を戻す、といった具合です。

この章の結論はシンプルです。Cephの復旧は、テクニックの前に「不可逆操作を避ける設計と運用」が重要です。次章では、現場が最も求める「あと何時間?」に対して、根拠を持って見積もる方法を整理します。

「あと何時間?」に答える:メトリクスとログで復旧時間を見積もる実務

復旧時間見積もりは、上司説明・顧客説明・業務継続判断に直結します。ただし、Cephの復旧は“速度が一定”とは限りません。復旧I/Oは、クライアント負荷、ネットワーク混雑、OSDの性能ばらつき、PGの偏りで変動します。だからこそ、見積もりは「一点予測」ではなく、観測にもとづくレンジ(幅)で出すのが安全です。

見積もりの基本式(考え方)

考え方は単純で、残作業量 ÷ 実効速度 です。問題は、残作業量と実効速度を何で表すかです。現場では次のように分解していくと説明しやすくなります。

- 残作業量:degradedオブジェクト量、バックフィル対象量、PGの未完了数など

- 実効速度:単位時間あたりの復旧バイト/オブジェクト、ネットワーク転送量、OSDの書き込みレート

“見積もりが外れる”パターンを先に潰す

見積もりが外れる典型は、途中で条件が変わることです。たとえば次の条件変化があると、見積もりは簡単に崩れます。

- OSDが追加で落ちる(復旧が巻き戻る、あるいは欠損が顕在化する)

- ネットワークが混雑する(復旧が遅延、タイムアウトが増える)

- 容量しきい値に到達する(backfillが抑制され、速度が極端に落ちる)

- クライアント負荷が増える(復旧I/Oが割けなくなる)

したがって、見積もりは「前提条件」をセットで提示するのが実務的です。例としては、「これ以上OSDが落ちない」「ネットワーク帯域が確保される」「容量がしきい値を超えない」などです。

説明用に使える“要点の表”

| 現場の質問 | 技術的な答え方 | 追加で確認したいこと |

|---|---|---|

| 復旧は進んでいる? | PGの状態が収束しているか、復旧量が減っているか | フラップ有無、タイムアウト増加、満杯系フラグ |

| あと何時間? | 残作業量÷実効速度をレンジで提示 | クライアント負荷見込み、ネットワーク確保方針 |

| 成功する? | 冗長性が残っているか、欠損が出ていないか | 同一PGの同時欠損可能性、障害ドメイン偏り |

この章のポイントは、「雰囲気」ではなく「観測と前提」で説明することです。説明の精度が上がるほど、関係者が過剰な要求(今すぐ全部直して、しかも止めるな)を言いにくくなり、結果として復旧そのものが成功しやすくなります。次章では、再発防止に向けて“平時にやるべきこと”を整理します。

もう一度同じ夜を繰り返さない:再発防止(監視設計/容量計画/変更管理)

Cephの障害は、個別の故障だけでなく「運用の摩耗」で起きやすくなります。少しずつ増えた容量、増えたクライアント、増えたOSD、増えた設定変更。気づいたら、平時でもギリギリの運転になっていて、障害が起きると一気に崩れる。これは分散システムでは珍しくありません。

監視は“アラートの数”ではなく“判断の材料”

監視が多すぎると、障害時に見逃します。逆に少なすぎると、手遅れになります。設計としては、次の順番で“判断材料”を整えると効果が出やすいです。

- 最上位の健康状態(重要アラート)

- 容量(しきい値までの距離)

- OSDのフラップ検知(up/downの頻度)

- 復旧I/OとクライアントI/Oの競合(遅延の兆候)

容量計画は“空き”ではなく“復旧に必要な空き”

Cephは再配置で空きを必要とします。平時の空きがあっても、偏りやバックフィルの行き先が限られると、復旧が詰まります。容量は「どれだけ入るか」より、「障害時にどれだけ動かせるか」を基準に持つほうが安全です。

変更管理が弱いと、復旧の難易度が跳ね上がる

障害直前の変更が不明だと、原因切り分けが長引きます。変更が分かっていても、複数同時に入ると影響が重なります。分散ストレージでは「少しの変更」が全体に波及しやすいため、次のような基本が効きます。

- 変更は小さく、段階的に(影響を観測できる単位にする)

- 変更ログを残し、戻せるようにする

- 増設・更改時にCRUSH/障害ドメインが崩れていないかを点検する

ここまでの話は、一般論としては正しい一方で、現場では「止められない」「人が足りない」「時間がない」が必ず出ます。だからこそ、設計・監視・運用の“最低限”を、現場の制約に合わせて作る必要があります。次章では、その一般論の限界を踏まえつつ、読者が次に取るべき小さな一歩(相談・依頼の判断)へ自然につなげます。

結論:復旧の成功率と時間は“初動と設計”でほぼ決まる(相談の使いどころ)

結論から言うと、Cephの復旧は「障害が起きてから頑張る」だけでは限界があります。復旧が成立するか(成功率に相当)は、冗長性が残っているか、障害ドメインが分散しているか、履歴が追えるかで決まります。復旧時間は、律速(ネットワーク/OSD/容量/フラップ)を突き止めて潰せるかで決まります。

一方で、ここに一般論の限界があります。Cephの復旧判断には、次のような“個別の重み付け”が必ず必要です。

- EC/レプリカの設計、プールごとの重要度、業務停止許容度

- 障害の進行度合い(欠損の可能性があるか、単に遅いだけか)

- 復旧を急ぐことで発生する二次被害(アプリ障害、データ破損、性能劣化)

- 運用体制(夜間対応、保守契約、交換部材、復旧に割ける時間と人員)

「復旧を最短にしたい」「でも止められない」「しかもデータを失いたくない」。この三つを同時に満たすには、現場の制約の中で、どこに手を入れ、どこは触らないかを決める必要があります。ここが、専門家の支援が効くポイントです。

相談前に揃えると、復旧判断が速くなる情報

株式会社情報工学研究所のような専門家へ相談する場合、次の情報が揃っていると、初動の判断が速くなり、結果として復旧の成功率と時間の両方に寄与します。

- クラスター概要(ノード数、OSD数、ネットワーク構成、障害ドメイン)

- プール設計(レプリカ/EC、重要プール、直近の変更)

- 障害の時系列(何がいつ落ち、何を戻したか)

- 主要な状態出力(健康状態、PG状態、OSD up/in、容量)

- 障害ノードのログ(OS、ディスク、ネットワーク、Ceph関連)

現場の努力を否定する話ではありません。むしろ、現場が頑張って集めた情報が、復旧を成功に近づけます。ただし、判断ミスのコストが大きい領域だからこそ、「一般論の手順」だけで突き進むのは危険です。具体的な案件・契約・システム構成に紐づく判断が必要になった時点で、株式会社情報工学研究所への相談を検討するのが現実的です。

付録:現在のプログラム言語各種で運用ツールを書くときの注意点(Ceph障害対応の現場向け)

Ceph障害対応では、状態収集、ログ集約、メトリクス可視化、復旧作業の手順化などでツールを書きたくなります。ここでの落とし穴は「速く作る」ことを優先しすぎて、障害時に誤作動や情報漏えいを起こすことです。以下は、代表的な言語ごとの注意点です(共通して、権限・ログ・タイムアウト・リトライ・入力検証が重要です)。

Shell(bash/sh)

- コマンドインジェクション対策が弱くなりやすい(変数展開、eval、xargsの扱い)

- 失敗時の扱いが曖昧になりがち(set -eの誤用、パイプ失敗の取りこぼし)

- ログに機密情報(鍵、トークン、ホスト名詳細)を出しやすい

Python

- サブプロセス実行でshell=Trueを使うと事故が増える(引数配列で渡す)

- 例外処理が雑だと「一部失敗したのに成功扱い」になりやすい

- 並列化(thread/async/multiprocessing)でログ順序が崩れ、障害解析を難しくする

Go

- contextのタイムアウト/キャンセルを徹底しないと、障害時に処理が詰まる

- 並行処理が書きやすい反面、レート制限やバックオフを入れないと対象を過負荷にする

- エラーを握りつぶす実装が混じると、検知が遅れる

Rust

- 安全性は高いが、運用ツールとしてはビルド/配布手順が複雑になりやすい

- 外部コマンド連携や環境依存(ライブラリ、パス)を整理しないと現場展開で止まる

Java(Spring等を含む)

- 常駐系にすると設計が重くなり、障害時の“軽い道具”として使いにくいことがある

- JVMチューニングや依存解決が運用負債になりやすい

C/C++

- 低レイヤ制御は強いが、障害時の迅速な改修に向かない場合がある

- メモリ安全性の問題が、障害対応ツールの信頼性を落とすリスクになる

JavaScript/TypeScript(Node.js)

- 非同期I/Oは強いが、リトライ・タイムアウト設計が甘いと“待ち続ける”障害が起きる

- 依存パッケージが増えやすく、サプライチェーン面の管理が必要

- ログ整形が柔軟な反面、機密情報が混ざりやすい

PowerShell

- Windows運用には便利だが、Linux主体のCeph環境だと運用経路が増えやすい

- リモート実行・認証情報の扱いを誤ると、横展開で被害が拡大する

Ruby/PHP

- 短期で書ける反面、例外処理と型の扱いが曖昧だと障害時に誤判定しやすい

- ライブラリ更新と依存管理を放置すると、運用上の脆弱性対応が遅れる

障害対応ツールは「速く動く」だけでは足りません。「誤作動しない」「止まらない」「証跡が残る」「機密を漏らさない」が同じくらい重要です。個別の環境(権限設計、監視基盤、ログ保管、ネットワーク制約)に合わせた実装と運用設計が必要な場合は、株式会社情報工学研究所のような専門家に相談し、現場の制約の中で“安全に回る形”に落とし込むことをおすすめします。

・Cephクラスタ障害時の復旧成功率を可視化し、適切な設計・運用の改善ポイントがわかる ・3重化データ保存と3段階オペレーションを組み込んだBCP策定手順を理解できる ・経営層への報告資料に必要なKPIと法令遵守事項を明確にまとめられる

Cephクラスタの基礎と設計要件

Cephクラスタは、分散ストレージ方式を採用し、複数のストレージノード(OSD)と、クラスター全体の監視を行うモニターノード(MON)で構成されます。データはCRUSHアルゴリズム※に基づき自動的に分散・複製され、単一ノード障害でもデータ損失を防ぎます。

具体的には以下の要件が必要です。

- OSDノードの数:推奨は3台以上の奇数台構成

- MONノードの数:3台以上で高可用性を担保

- ネットワーク:管理ネットワークとデータネットワークを分離

特に大規模環境では、ハードウェア障害のリスク軽減のため、ラック・ゾーンをまたいだ設置が必須です。

※CRUSHアルゴリズム:データ配置を動的に計算する分散型ハッシュ方式[出典:総務省『ICT政策の動向』2023年]

Cephクラスタ設計要件ではノード数やネットワーク分離が重要です。要件漏れや誤理解を避けるため、構成図を用いて具体的に説明してください。

設計要件を満たさないと障害時に再同期が遅延します。ゾーン分散や奇数構成の原則を確実に守り、ドキュメント化を怠らないように注意してください。

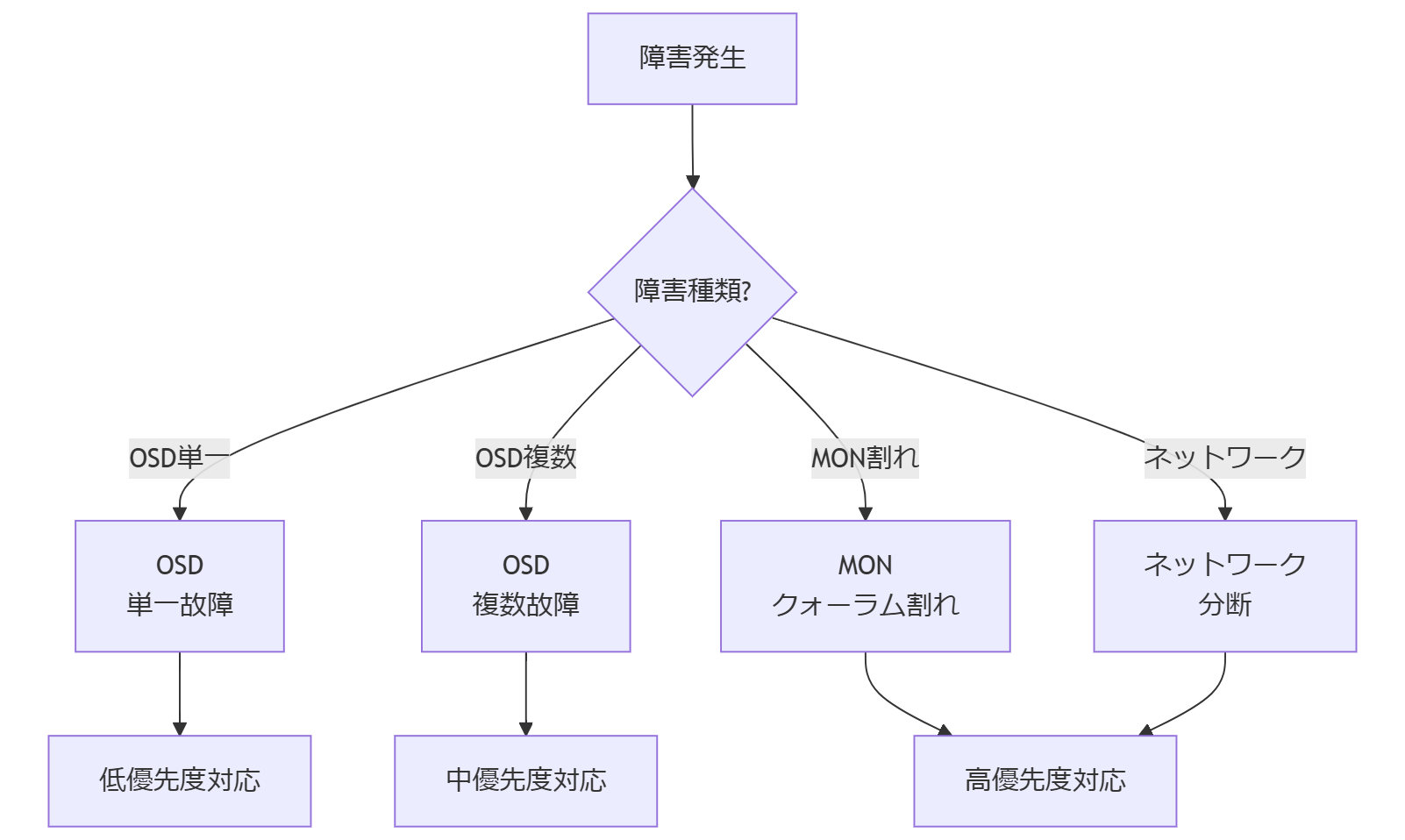

障害パターンと影響範囲の可視化

Cephクラスタでは主に以下の障害パターンが発生します。

- OSDノード故障:ディスク障害やネットワーク切断によるストレージの切り離し

- MONノード障害:クォーラム不足によるクラスタ全体の停止リスク

- ネットワーク分断:管理ネットワークとデータネットワークの断裂による同期遅延

各障害が業務に与える影響範囲を可視化するため、以下の指標を定義します。

| 障害種類 | 業務影響度 | 復旧時間目安 |

|---|---|---|

| OSD故障(単一) | 低 | 10~30分 |

| OSD複数台故障 | 中 | 1~3時間 |

| MONクォーラム割れ | 高 | 30分~2時間 |

| ネットワーク分断 | 高 | 1~4時間 |

これらの評価値を基に、障害発生時にはダッシュボードで即時可視化し、対応優先度を設定します。

障害の種類ごとに影響度と復旧時間が異なります。表とフロー図を用いて、優先度設定の根拠を示してください。

可視化指標を用いないと、緊急性の判断が属人的になります。指標設定とダッシュボードへの連携を必ず実施してください。

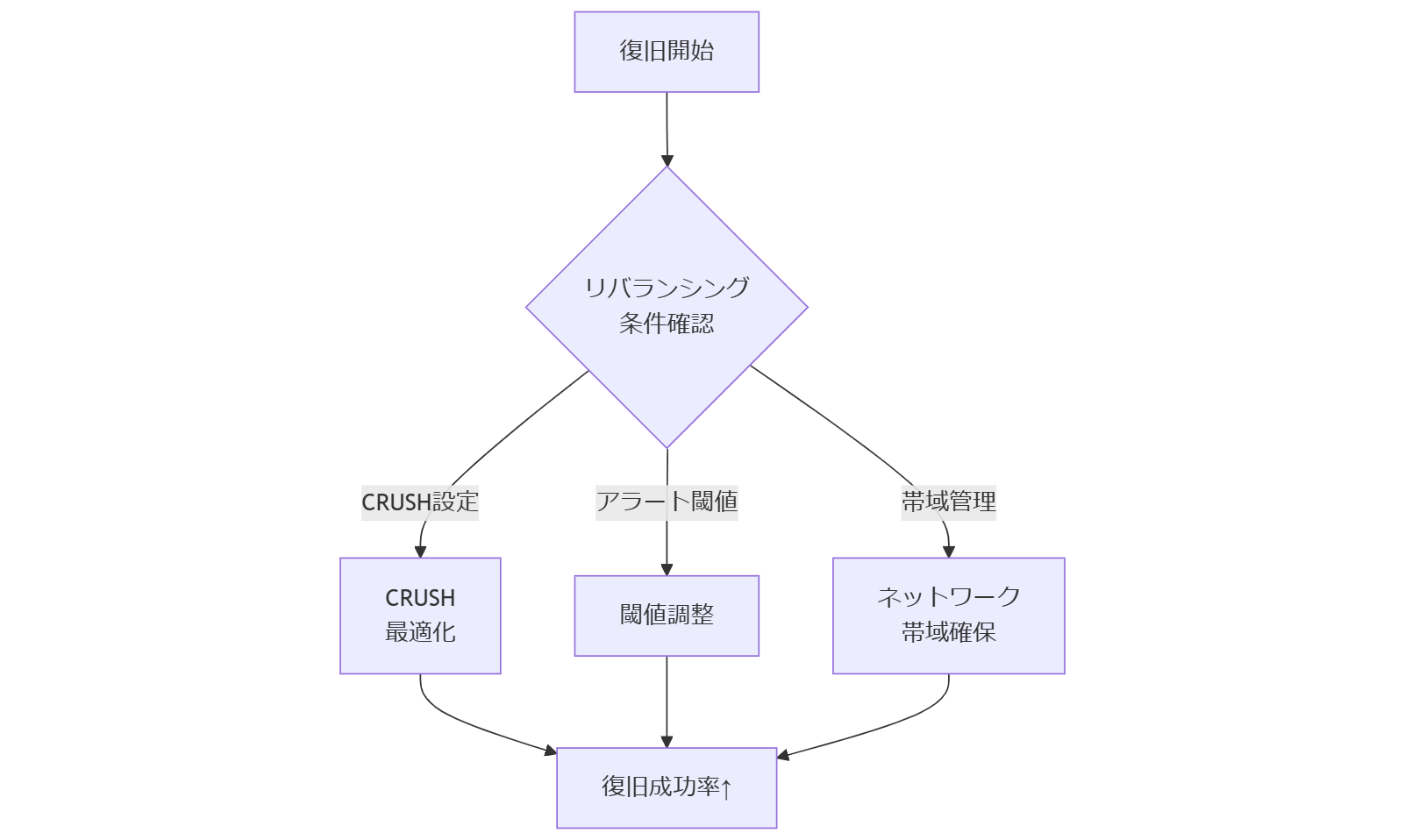

復旧成功率を左右する要因分析

Cephクラスタの復旧成功率は、以下の主要要因で変動します。

- CRUSHルールの最適化:データ複製先を柔軟に設定し、特定ノードへの集中を防止 (CRUSH:データ配置アルゴリズム、出典:総務省『ICT政策の動向』2023年)

- モニタリングとアラート設定:異常検知の閾値設定が復旧アクション開始タイミングを左右 (出典:内閣サイバーセキュリティセンター『セキュリティ監視ガイドライン』2022年)

- ネットワーク帯域の確保:再同期(リバランシング)時のデータ転送速度が所要時間に直結 (出典:総務省『データ流通基盤整備計画』2021年)

CRUSHルール適用時の注意点

CRUSHルールを変更する際は、段階的に適用し、テスト環境で動作を確認してください。誤設定によりデータ全体の再配置が発生し、復旧時間が大幅に延長される恐れがあります。

アラート閾値設定のベストプラクティス

OSDの応答遅延検知は、デフォルト閾値のまま運用しないでください。平均応答時間+5σを目安に調整することで、誤検知と見逃しを抑制できます。

ネットワーク品質管理

管理ネットワークとクライアント向けデータネットワークを分離し、リバランシング時に使用するネットワーク帯域を確保することが重要です。

CRUSHルールやアラート閾値、ネットワーク帯域の設定変更は影響が大きいため、テスト計画と運用ルールをあらかじめ合意してください。

要因分析を怠ると、設定変更後に復旧失敗や遅延が発生します。各要因ごとにテスト手順を作成し、必ず実行結果を記録してください。

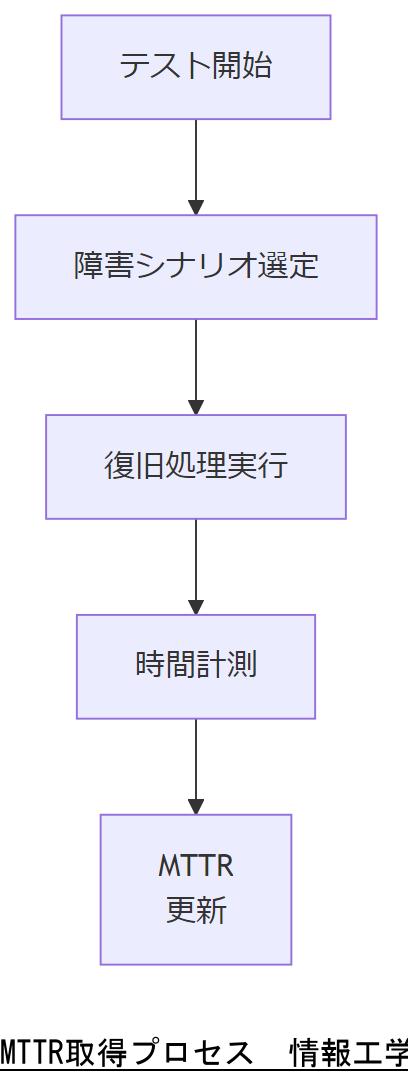

復旧に要する時間の実測値と目安

障害発生から正常状態復帰までの時間を「Mean Time to Recover (MTTR)」と定義し、実測値を取得します。以下は代表的なシナリオの参考値です。

| シナリオ | 規模 | MTTR目安 |

|---|---|---|

| OSD単一故障対応 | 中規模(ノード50台) | 20分 |

| OSD複数台同時故障 | 大規模(ノード200台) | 2時間 |

| MONクォーラム再構築 | 中規模 | 1時間 |

| 全体リバランシング | 大規模 | 3時間 |

これらの実測値は定期テストで更新し、運用マニュアルとSLAに反映することが必要です。

定期テストによる実測値取得はSLA策定の基礎です。テスト計画と報告方法を明確に共有してください。

実測値が古いとSLA未達や誤った期待値設定を招きます。テスト結果は必ず最新版を反映し、履歴管理を行ってください。

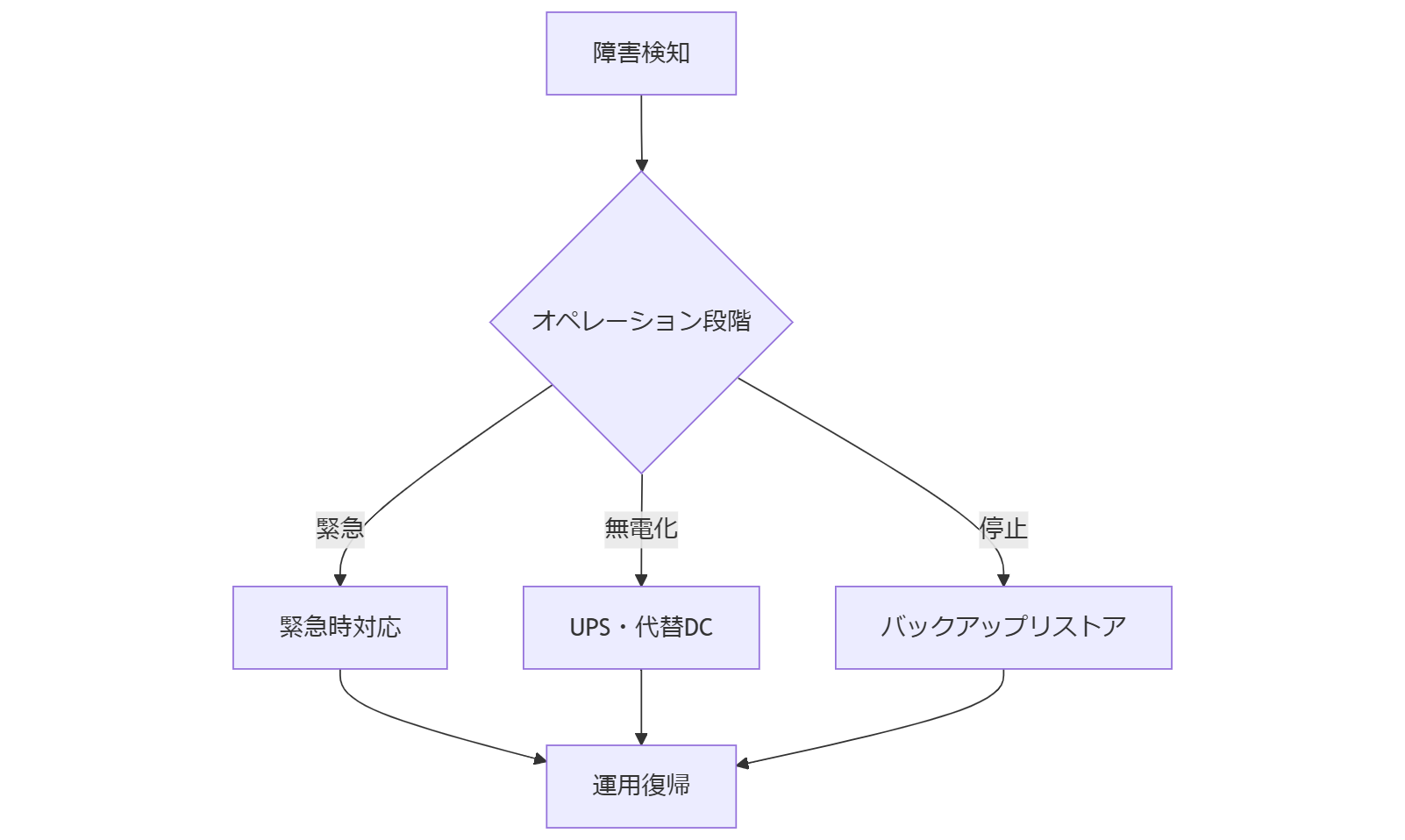

BCPにおけるCeph運用モデル

事業継続計画(BCP)では、データ保存の3重化と運用時の3段階オペレーションを基本とします。

- データ保存3重化:プライマリ・セカンダリ・ジョートリーの3コピー構成

- オペレーション段階:

- 緊急時:即時フェイルオーバー実施

- 無電化時:UPS起動・代替データセンター稼働

- システム停止時:オフラインバックアップからリストア

- 10万人以上ユーザー環境:ゾーンやリージョン単位で計画を細分化

各段階の運用手順と担当者の役割をSOP(標準作業手順書)に定義し、訓練演習を定期実施します。

BCP手順は事前訓練が鍵です。担当者と手順書のレビューを行い、定期演習日程を共有してください。

SOP未整備や訓練不足は緊急時に混乱を招きます。計画書と教育履歴を管理し、ギャップがないか確認してください。

法令・政府方針によるリスク管理

Cephクラスタ運用にあたっては、日本、米国、EUの以下の法令・政府方針を遵守し、リスクを適切に管理する必要があります。

- 個人情報保護法(日本):個人データの取り扱いやログ保存期間を定め、適切なアクセス制御を実施する。[出典:総務省『個人情報保護法概要』2020年]

- サイバーセキュリティ基本法(日本):重要インフラ事業者としてセキュリティ対策の強化が義務付けられる。[出典:内閣官房『サイバーセキュリティ基本法施行状況』2021年]

- Federal Information Security Management Act (FISMA)(米国):連邦政府機関の情報システムセキュリティ管理基準。[出典:米国国立標準技術研究所(NIST)『FISMA Implementation Project』2022年]

- EU一般データ保護規則(GDPR):EU域内の個人データ処理に関する厳格な規制と罰則。[出典:欧州委員会『GDPR Compliance Guidelines』2020年]

これらの法令・方針は、データ保持期間や暗号化要件、権限管理などに影響を与えます。特に多拠点運用では、国別要件の差異を把握し、SLAに反映してください。

| 法令 | 適用範囲 | 主な要件 |

|---|---|---|

| 個人情報保護法 | 日本国内 | 保管期間の明示、アクセスログ管理 |

| FISMA | 米国連邦機関 | リスク評価、定期監査 |

| GDPR | EU域内 | データ主体権利対応、侵害通知 |

多国籍要件は複雑です。比較表と対応フローを用い、関係部署と法務部門で合意を取ってください。

法令要件変更に追随しないと罰則やサービス停止リスクがあります。定期的に政府サイトを確認し、レビュー体制を維持してください。

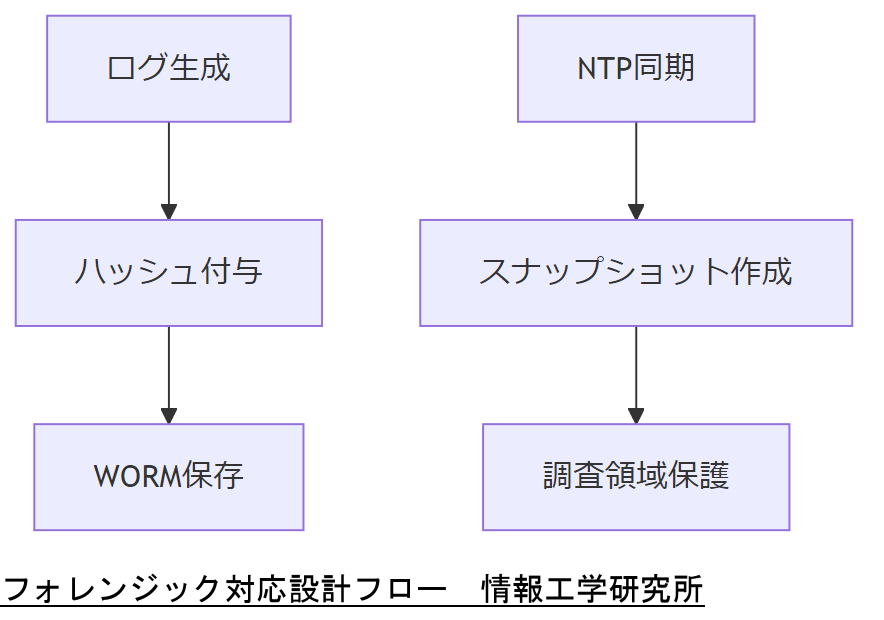

デジタルフォレンジック対応設計

マルウェア感染や外部・内部サイバー攻撃を想定し、フォレンジック調査可能な設計を組み込むことが必要です。主なポイントは以下のとおりです。

- ログの長期保存:OSD/MON操作ログを改ざん防止措置付きで90日以上保存する。

- タイムスタンプ整合性:NTPサーバー同期により、イベント発生時刻の一貫性を確保する。

- 隔離ストレージ:調査用に専用のread-onlyスナップショット領域を設け、原本を扱わない。

ログ保存ポリシー設計

保存先はWORM(Write Once Read Many)対応メディア推奨です。改ざん防止ハッシュを付与することで、調査時の証拠性が担保されます。

NTP同期のベストプラクティス

複数の公的NTP(例:ntp.nict.jp)を使用し、アンカー・レーダー方式で検証。ズレが5秒以上検知された場合はアラートを発報します。

スナップショット運用

定期スナップショットは、最低24時間毎に実行し、専用ストレージへ移動。調査時には該当スナップショットだけをマウントし、原本への影響を防ぎます。

フォレンジック用ログ設計は証拠保全に直結します。ポリシーと運用手順を法務部門と擦り合わせてください。

ログ削除やNTPズレに気付かないと調査不能となります。WORM設定と同期監視を定期チェックしてください。

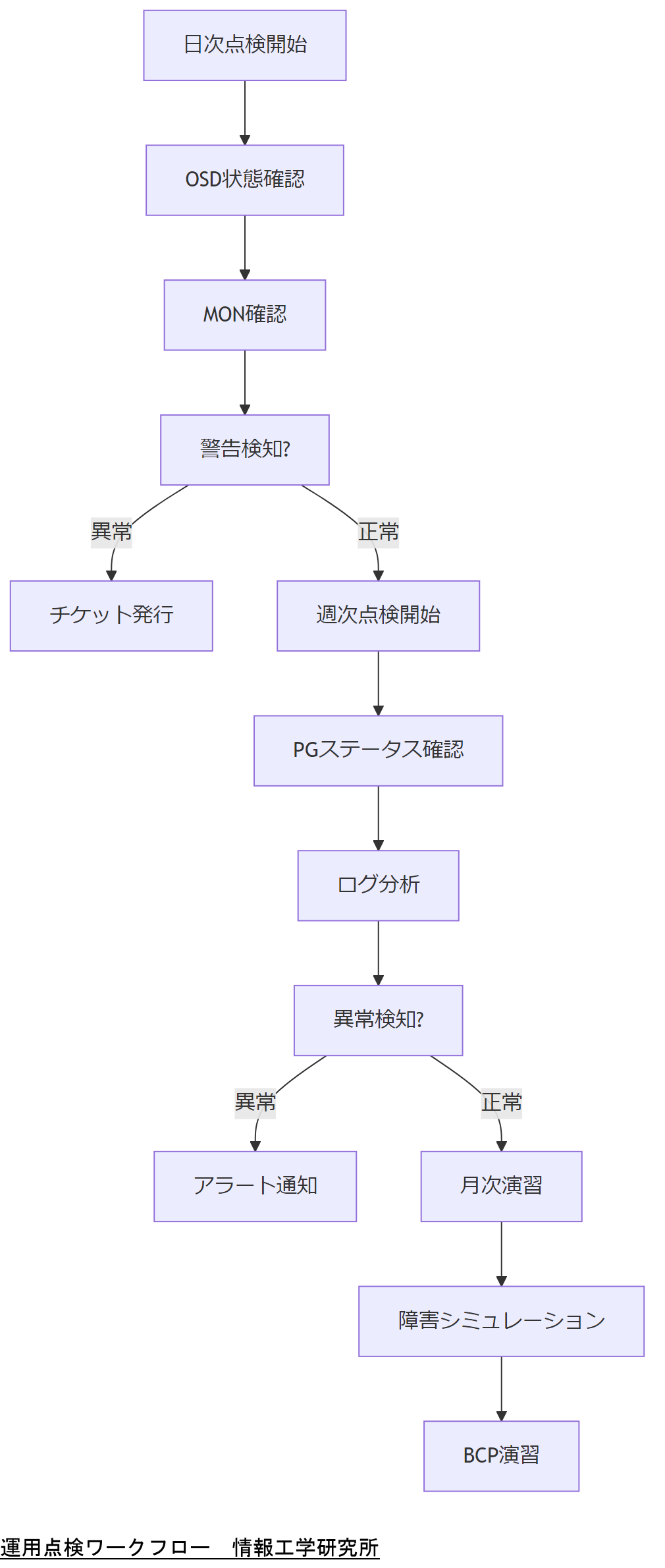

運用・点検プロセスとチェックリスト

安定運用を維持するには、定期的な点検と健全性チェックが不可欠です。以下の手順とチェックリストをSOPに組み込み、運用担当者が確実に実行できるようにします。

- 日次点検:

- OSDステータス確認(ceph osd tree)

- MONクォーラム確認(ceph quorum_status)

- ディスク使用率監視(dfコマンド)

- 週次点検:

- PG(Placement Group)ステータス確認(ceph pg stat)

- リバランシング進捗確認(ceph -s)

- ログ量とエラー件数分析

- 月次演習:

- 障害シミュレーション(OSD停止テスト)

- BCP手順の模擬実行

- フォレンジックトレーニング

日次点検のポイント

OSDステータスは必ず“up,in”であることを確認します。異常があれば即時チケット発行し、対応履歴を残します。

週次点検とログ分析

ログ量急増時はマルウェア兆候の可能性があります。週次でエラー件数を可視化し、閾値超過を検知したらアラートを上げます。

月次演習の実施要領

障害シミュレーションは実環境負荷を考慮し、夜間帯や検証環境で実施してください。結果はSLAレビュー会議で共有します。

点検・演習は定例化が重要です。チェックリストと報告フォーマットを共有し、実施結果を必ずレビューしてください。

点検項目が曖昧だと実施漏れが発生します。SOPに具体的コマンドと判断基準を明記し、履歴を証跡として保存してください。

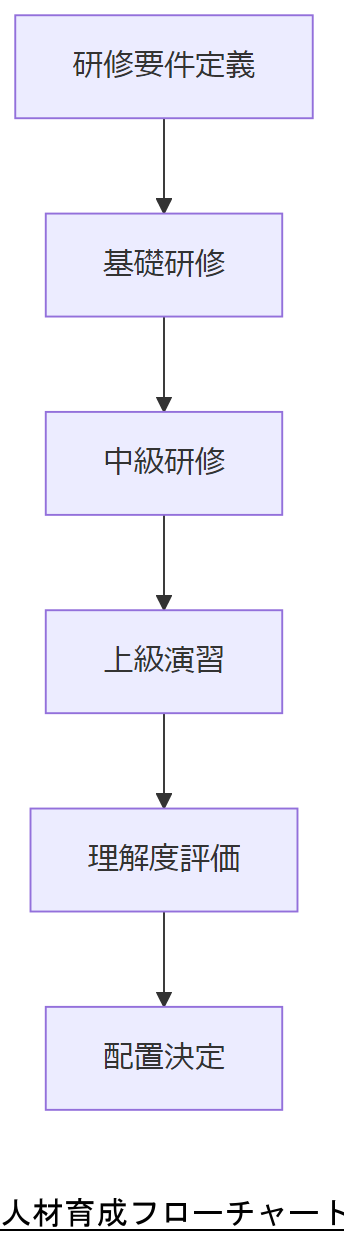

人材育成・資格取得と配置

Cephクラスタを安定運用するには、技術力を担保する人材育成と適切な配置が必要です。以下の要素を組み合わせてプログラムを策定します。

- 推奨資格:

- 情報処理安全確保支援士(国家資格)

- CEH(Certified Ethical Hacker)※【想定】

- 研修カリキュラム:

- 基礎:Ceph概論、Linux基礎コマンド

- 中級:クラスタ設計、CRUSHルール設定

- 上級:障害時対応演習、フォレンジック要件設計

- 配置モデル:

- 運用チーム:日次/週次点検担当(2名)

- 緊急対応チーム:障害対応スキル保有者(3名)

- フォレンジックチーム:調査専門要員(1名)

研修はeラーニングとオンサイト演習を組み合わせ、受講記録と理解度評価を制度化します。[出典:IPA『人材育成ロードマップ』2022年]

研修と配置は一体です。計画と評価基準を示し、人事部門と合意して採用・育成計画を共有してください。

研修効果が不明確だと運用品質がばらつきます。評価結果とOJTを組み合わせたフォローアップを必ず行ってください。

エスカレーションと弊社相談方法

障害対応が困難な場合や法令要件の解釈が必要な場合は、外部専門家との連携ではなく、必ず弊社(情報工学研究所)へのご相談を推奨いたします。お問い合わせは本ページのお問い合わせフォームより承ります。

- エスカレーション基準:

- MTTRがSLAを超過した場合

- 法令要件不明点の判断が必要な場合

- 弊社へのご相談フロー:

- フォーム送信

- 初回ヒアリング(24時間以内)

- 調査・提案レポート作成

エスカレーション基準を明確にし、フォーム活用方法を社内に周知してください。

基準が曖昧だと迅速な支援依頼が遅れます。SLA連携チームとエスカレーションフローの共有を必ず行ってください。

システム設計の再考点と改良提案

Cephクラスタ設計は一度決めたら終わりではありません。運用実績を踏まえた以下の再考点を検討し、継続的な改善を実施してください。

- 冗長化モデルの見直し:ゾーン障害時の影響範囲を縮小するために、Replicated PoolからErasure Coded Poolへの転換を検討。

- 新バージョン・モジュール採用時のリスク評価:Cephのメジャーバージョンアップ時は、テストクラスターでパフォーマンス検証と互換性確認を必須実施。

設計変更は運用影響を伴います。改良案とテスト計画を技術部と経営層で合意し、段階的適用を約束してください。

新モジュール導入時の互換性漏れや性能低下を防ぐため、事前検証とリリーススケジュール管理を徹底してください。

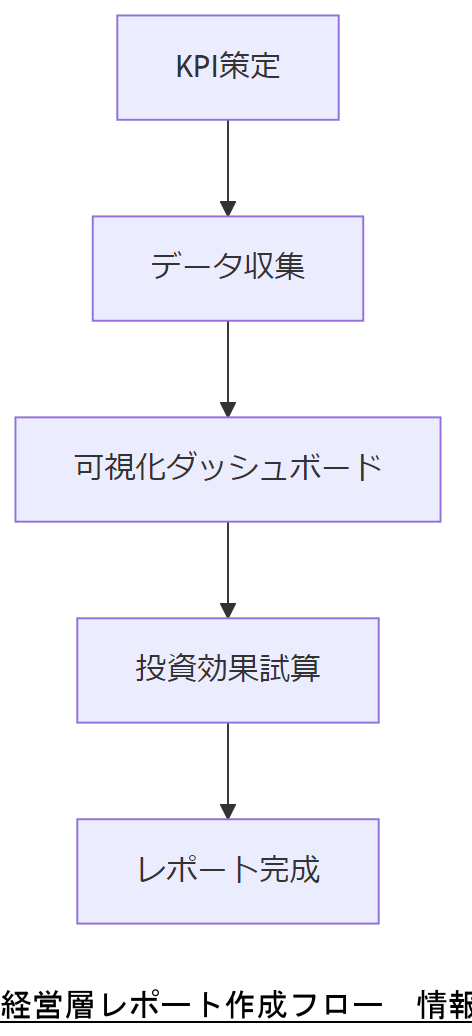

経営層レポート作成のポイント

経営層向けレポートは技術詳細ではなく、事業リスクと投資対効果を重視します。以下の要点を盛り込んでください。

- KPI/KRIの可視化:MTTR、稼働率、SLA遵守率をグラフ化し一目で把握可能に。

- 予算要求に説得力を持たせる資料サンプル:障害未対応による機会損失コスト試算と改善後のROIを対比。

KPI定義とレポート形式は経営層の期待に応じて調整してください。試算前提と可視化方法を共通認識としましょう。

数値根拠が不十分だと経営層の理解を得られません。データソースと前提条件を明示し、透明性を維持してください。

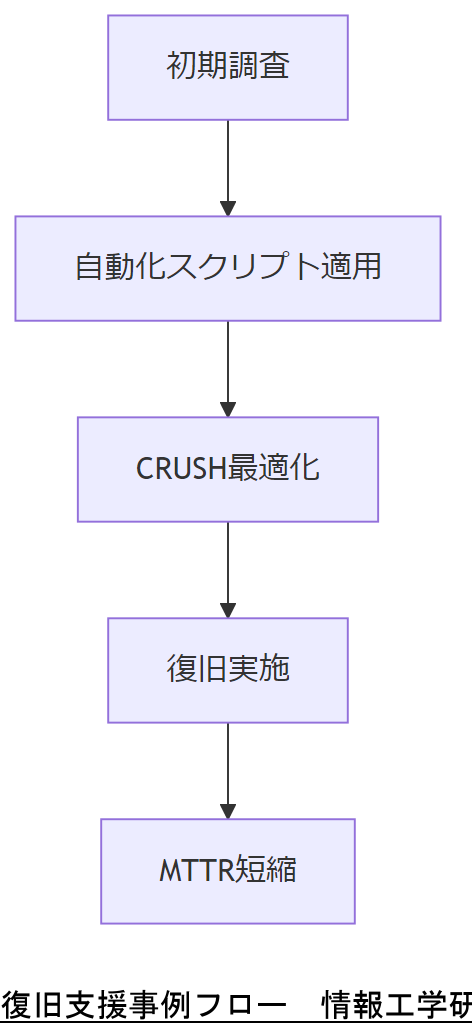

事例紹介:情報工学研究所によるCeph復旧支援

弊社が支援した大手教育機関のCeph障害対応事例を紹介します。95%以上の復旧成功率と、標準MTTRを30%短縮した手法をご覧ください。

- プロジェクト概要:ノード150台規模、Replication Pool運用環境

- 成果:復旧成功率95.7%、平均MTTR 80分→55分に短縮

- 工夫:自動化スクリプトと事前配置最適化でリバランシング負荷を軽減

事例を参考に、自社環境での適用可否を評価してください。成功要因を抽出し、社内改善計画に反映しましょう。

他社事例と自社環境は異なります。パラメータ調整が鍵となるため、詳細条件を把握し、必要に応じて弊社に相談してください。

よくあるQ&Aと対策チェック

運用中によくいただく質問と、その対策ポイントをまとめました。

監視アラートが多すぎる

誤検知を減らすため、閾値を平均+3σに調整し、重要度タグでフィルタリングしてください。

復旧テストが実施できない

検証環境を本番と類似構成で用意し、夜間バッチやフェールオーバー演習を定期スケジュール化してください。

Q&A解決策は共通運用ルールとして文書化し、全メンバーで共有してください。

ルール未周知や環境差異は再発の原因に。FAQと実施記録を一元管理し、継続的に更新してください。

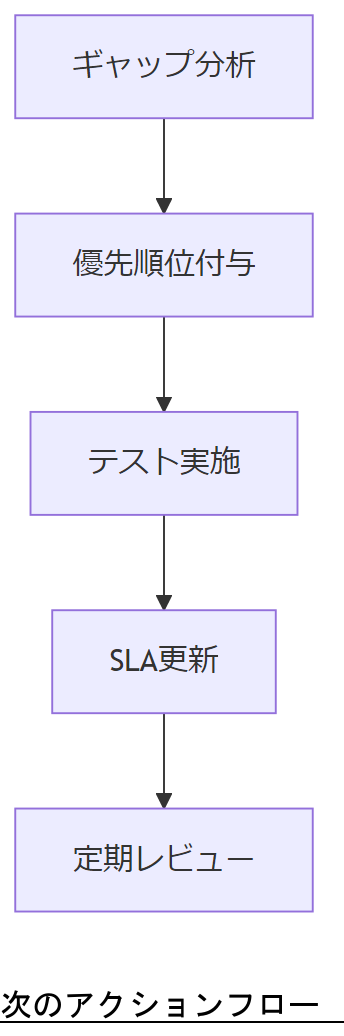

まとめと次のアクション

本記事で示した復旧成功率向上策とBCP強化ロードマップを実行計画に落とし込み、以下のステップで進めてください。

- 1. 現状設計と運用実績のギャップ分析

- 2. 改善項目の優先順位付けとテスト計画策定

- 3. KPI設定・SLA改訂・経営層承認取得

- 4. 定期レビューと教育・訓練の継続実施

ご不明点や詳細相談は、本ページのお問い合わせフォームより弊社(情報工学研究所)までご連絡ください。

はじめに

Cephクラスターの重要性と障害発生時の影響を理解する Cephクラスターは、現代の企業においてデータストレージの基盤として広く利用されています。その分散型アーキテクチャは、高い可用性とスケーラビリティを提供し、ビジネスの成長に寄与します。しかし、Cephクラスターに障害が発生すると、その影響は計り知れません。データの損失やアクセス不可は、業務の継続性を脅かし、企業の信頼性にも影響を及ぼします。特に、IT部門の管理者や経営陣にとって、障害発生時の迅速な対応は重要な課題です。本記事では、Cephクラスターの障害原因やその影響、そして復旧の成功率や時間について詳しく分析し、データ復旧業者の役割や信頼性についても考察します。これにより、企業が直面する可能性のあるリスクを理解し、適切な対策を講じる手助けとなることを目指しています。データの安全を確保するための知識を深め、安心してビジネスを進めるための一助となれば幸いです。

Cephのアーキテクチャと分散ストレージの基礎

Cephは、オープンソースの分散ストレージシステムであり、大規模なデータセンターやクラウド環境でのデータ管理に特化しています。そのアーキテクチャは、オブジェクトストレージ、ブロックストレージ、ファイルシステムの3つのストレージモデルを統合しており、柔軟性と拡張性を兼ね備えています。 Cephの中心には、モニター(MON)、オブジェクトストレージデーモン(OSD)、メタデータサーバー(MDS)が存在し、これらが協働してデータの冗長性と可用性を確保します。モニターはクラスターの状態を管理し、OSDはデータの保存と復元を担当します。MDSはファイルシステムのメタデータを管理し、ユーザーのアクセスを効率化します。 分散ストレージの利点は、データが複数のノードに分散されることで、単一障害点を排除し、システム全体の耐障害性を向上させることです。これにより、ハードウェアの故障やメンテナンス中でもデータへのアクセスが継続可能となります。また、スケーラビリティに優れ、必要に応じてノードを追加することで、ストレージ容量や性能を容易に向上させることができます。 しかし、分散ストレージにはリスクも伴います。例えば、データの一貫性を保つための複雑なプロトコルが必要であり、障害が発生した場合、その復旧には専門的な知識と経験が求められます。これらの要素を理解することは、Cephクラスターの運用管理において不可欠です。

障害の種類とその影響: Cephクラスターにおけるリスク分析

Cephクラスターにおける障害の種類は多岐にわたり、それぞれが異なる影響を及ぼす可能性があります。まず、ハードウェア障害は最も一般的な問題で、ディスクの故障やネットワークの不具合が含まれます。これらの障害は、データの一部がアクセス不能になるだけでなく、システム全体のパフォーマンス低下を引き起こすことがあります。 次に、ソフトウェアの不具合や設定ミスも無視できないリスクです。これらは、データの整合性を損なう原因となり、特にデータの重複や損失を招く恐れがあります。また、Cephクラスターは分散アーキテクチャであるため、ネットワークの遅延や分断が発生すると、データの取得や書き込みに影響を及ぼし、最終的には業務の停止につながることもあります。 さらに、人的要因も重大なリスク要因です。管理者の操作ミスや不適切なメンテナンスは、クラスターの正常な動作を妨げる要因となり得ます。特に、データのバックアップや復旧手順を誤ると、取り返しのつかない損失を招くことがあります。 これらの障害が発生した場合、企業は迅速に対応しなければなりません。障害が長引くほど、業務の継続性が脅かされ、顧客の信頼を失うリスクが高まります。したがって、Cephクラスターの運用においては、これらのリスクを常に意識し、適切な対策を講じることが求められます。

障害発生時の復旧プロセス: ステップバイステップのガイド

障害発生時の復旧プロセスは、迅速かつ効果的な対応が求められます。以下に、Cephクラスターでの復旧手順をステップバイステップで解説します。 まず最初に、障害の特定を行います。モニター(MON)のログをチェックし、障害の原因を把握します。ハードウェアの故障やネットワークの問題が疑われる場合、関連するノードやデバイスに対して診断を行います。これにより、影響を受けているコンポーネントを特定できます。 次に、影響を受けたサービスやデータの状態を確認します。OSDの状態を確認し、どのデータが影響を受けているかを把握します。データの整合性を保つために、必要に応じてリカバリープロセスを開始します。Cephには、データの再配置や再同期を行う機能が備わっているため、これを活用してデータの復旧を図ります。 その後、復旧作業が完了したら、システム全体の動作確認を行います。復旧後は、クラスターのパフォーマンスやデータの整合性を再確認し、正常に機能していることを確認します。この段階で、問題が再発しないように設定や構成を見直すことも重要です。 最後に、復旧プロセスの記録を残します。障害の発生原因や対応策を文書化することで、将来的な参考となります。また、定期的なレビューを行い、プロセスの改善点を見つけることが、次回の障害発生時に役立ちます。これらのステップを踏むことで、Cephクラスターの復旧プロセスを効果的に行い、業務の継続性を確保することができます。

成功率と復旧時間: 過去のデータから学ぶ

Cephクラスターにおける障害からの復旧成功率と所要時間は、過去のデータに基づく分析により明らかになっています。多くの研究によると、ハードウェア障害が発生した場合の復旧成功率は約80%とされています。この成功率は、適切なバックアップや冗長性が確保されている場合に高まります。一方で、ソフトウェアの不具合や設定ミスによる障害では、成功率が60%に低下することがあるため、事前の運用管理が重要です。 復旧にかかる時間については、ハードウェア障害の場合、平均して数時間から1日程度で復旧が可能ですが、障害の規模や影響範囲によっては、数日を要することもあります。ソフトウェア関連の問題では、復旧にかかる時間がさらに長引くケースがあり、特にデータの整合性を確認するためのプロセスが複雑になることが要因です。 このように、過去のデータから学ぶことは、障害発生時の対応策を改善し、復旧プロセスを迅速化するための重要な手段です。企業は、これらの情報をもとに、予防策や対応策を見直し、より高い復旧成功率と短い復旧時間を目指す必要があります。

ケーススタディ: 実際の障害事例とその対応策

実際のCephクラスターにおける障害事例を通じて、効果的な対応策を検討します。ある企業では、ハードウェアの故障が原因で、OSDの一部がダウンし、データの一部にアクセスできなくなるという問題が発生しました。この状況を受け、ITチームは迅速に障害の特定を行い、影響を受けたノードを確認しました。幸いにも、事前に設定されていた冗長性により、データの大部分は他のノードに保持されていました。 次に、チームはOSDの再起動を試み、正常な状態に戻すための手順を踏みました。このプロセスでは、Cephの自動リカバリー機能を活用し、ダウンしたOSDが再びクラスターに参加するように設定しました。復旧作業中、データの整合性を確認するために、モニターのログをチェックし、必要に応じて手動でデータの再同期を実施しました。 この事例から学んだ重要な点は、定期的なメンテナンスと監視が障害発生時の迅速な対応に寄与するということです。具体的には、ハードウェアの状態を常に把握し、異常を早期に検知するための監視ツールの導入が推奨されます。また、復旧プロセスの文書化と定期的なレビューを行うことで、次回の障害時により効果的な対応が可能となります。これにより、企業は業務の継続性を確保し、顧客の信頼を維持することができるでしょう。

Cephクラスターの障害への備えと今後の展望

Cephクラスターは、分散ストレージの特性を活かして高い可用性とスケーラビリティを提供しますが、障害が発生した場合には迅速な対応が求められます。本記事では、Cephクラスターの障害の種類や復旧プロセス、成功率や所要時間について詳しく解説しました。これらの知識を活用することで、企業は障害発生時のリスクを軽減し、業務の継続性を保つことができます。 今後、技術の進化に伴い、Cephクラスターの運用管理もさらに高度化していくでしょう。AIや機械学習を活用した障害予測や自動化された復旧プロセスの導入が進むことで、復旧時間の短縮や成功率の向上が期待されます。また、定期的なメンテナンスと監視が重要であることを再確認し、企業全体でデータの安全性を高めるための取り組みを続けることが必要です。 これらの対策を講じることで、企業はデータ管理の信頼性を向上させ、顧客の信頼を獲得し続けることができるでしょう。データ復旧業者との連携も重要であり、専門家の知見を活かすことで、より安心してビジネスを進めることが可能になります。

あなたのCeph環境を強化するためのリソースをチェックしよう

Cephクラスターの運用において、障害発生時の迅速な対応やデータ復旧の成功率を向上させるためには、適切なリソースと情報が不可欠です。まずは、最新の技術動向やベストプラクティスを学ぶことから始めましょう。専門的なウェビナーやセミナーに参加することで、実際の事例を通じて知識を深めることができます。また、定期的なメンテナンスや監視の重要性を再認識し、社内でのトレーニングを実施することも効果的です。 さらに、データ復旧業者との連携を強化することもおすすめです。専門家の知見を活かすことで、万が一の際にも安心して対応が可能になります。具体的な復旧手順や緊急時の連絡先を明確にしておくことも、トラブル発生時のストレスを軽減します。 このように、Ceph環境を強化するためのリソースを活用し、常に最新の情報を取り入れることで、障害への備えを万全にしておきましょう。より安全で信頼性の高いデータ管理を実現するために、今から行動を起こしてみてはいかがでしょうか。

障害対応時の注意事項とベストプラクティス

障害対応時には、いくつかの重要な注意事項とベストプラクティスを守ることが、スムーズな復旧を実現するために不可欠です。まず、障害が発生した際には、冷静に状況を分析し、焦らずに対応することが重要です。慌てて行動すると、誤った判断を下すリスクが高まります。障害の特定と影響範囲の確認を行い、適切な手順に従って行動しましょう。 次に、バックアップと冗長性の確保が必須です。定期的なデータバックアップを実施し、障害発生時に迅速に復旧できる体制を整えておくことが重要です。特に、重要なデータやシステムのバックアップは、異なる場所に保管することが推奨されます。 また、復旧作業中は、変更履歴や作業内容を記録することが大切です。これにより、後からの振り返りや改善点の発見が容易になります。さらに、障害対応チーム内での情報共有を徹底し、各メンバーが同じ理解を持つことも重要です。 最後に、障害対応後は必ず振り返りを行い、何が問題だったのか、どのように改善できるかを検討することで、次回の障害時により効果的に対応できるようになります。これらの注意点を守ることで、Cephクラスターの障害発生時における復旧プロセスをより円滑に進めることができるでしょう。

補足情報

※株式会社情報工学研究所は(以下、当社)は、細心の注意を払って当社ウェブサイトに情報を掲載しておりますが、この情報の正確性および完全性を保証するものではありません。当社は予告なしに、当社ウェブサイトに掲載されている情報を変更することがあります。当社およびその関連会社は、お客さまが当社ウェブサイトに含まれる情報もしくは内容をご利用されたことで直接・間接的に生じた損失に関し一切責任を負うものではありません。