もくじ

- 障害対応の夜に「これ、誰のせい?」が先に立つ──でも復旧は“責任”より“手順”から始まる

- 成功事例を読む前に:復旧の成否は「壊れ方」ではなく「最初の10分」で決まることが多い

- ケース0:問い合わせ時点で勝負がつく──ログ、症状、触った操作の“順序”が武器になる

- ケース1:RAID/NAS──再起動1回で詰む構成、詰まない構成(そして詰んだ後の現実的ルート)

- ケース2:SSD/PC──突然死に見える事故の正体は「論理破損+書き込み継続」だった

- ケース3:仮想基盤──スナップショットとバックアップは似て非なるもの、復旧現場では別物

- ケース4:サーバ/クラウド──“復元”の前に「証拠の確保」と「止める順番」を設計する

- 失敗しがちな共通パターン:良かれと思った“その操作”が、復旧可能性を削っていく

- 成功に寄せる設計:現場で効くチェックリスト(判断軸・優先順位・切り分けの型)

- 帰結:復旧は「運」ではなく「再現可能なエンジニアリング」──次に同じ夜を迎えないために

【注意】データ復旧は初動の判断ミスで状態が悪化し、復旧率や費用・期間が大きく変わることがあります。通電継続や再起動、自己流の修復を始める前に、株式会社情報工学研究所のような専門事業者に相談し、状況に合ったダメージコントロール(被害最小化)の方針を確認してください。

障害対応の夜に「これ、誰のせい?」が先に立つ──でも復旧は“責任”より“手順”から始まる

障害が起きた瞬間、現場の頭の中はだいたい同じ順番で回り始めます。「まず復旧」「次に原因」「その後に再発防止」。でも現実は、会議室やチャットでは逆順になりがちです。いきなり「誰が何をした?」が飛んでくる。責められているように感じる。説明しないといけない。――その気持ち、自然です。

ただ、データ復旧の観点では、最初に優先すべきは“説明”ではなく“手順”です。なぜなら、初動でやること(やってはいけないこと)が、その後の選択肢を物理的・論理的に狭めるからです。責任追及の議論が過熱するほど、現場は「とりあえず再起動」「とりあえずchkdsk」「とりあえず同期を回す」といった“気持ちを落ち着かせる操作”に手が伸びます。しかし、その操作が追い打ちになり得ます。

ここで言う“追い打ち”は比喩ではなく、具体的に次のような現象です。

- OSやアプリが自動でログ・メタデータを書き込み、障害の痕跡を上書きする

- ファイルシステム修復が「整合性」を取るために、失われた参照を切り捨てる

- RAID/NASがリビルドや再同期を始め、誤った情報で“正しさ”を固定してしまう

- SSDでガベージコレクションやTRIMが進み、回収できる可能性が下がる

だから、最初の目標は「原因究明」でも「恒久対策」でもありません。まず“場を整える”ことです。具体的には、①書き込みを止める、②状況を記録する、③安全な取得(イメージ・ログ)を優先する。この3点ができると、議論をいったんクールダウンさせながらも、復旧率を下げないまま次の判断へ進めます。

心の会話:現場の本音は、実は正しい

「また新しい手順? どうせ形式だけでしょ」

「“とりあえず復旧”って言うけど、どこまでが安全ラインなの?」

こう思うのは健全です。障害対応は“最適解”より“最悪を避ける設計”が効きます。この記事では、業界で広く知られている復旧の原理(書き込み停止、イメージ優先、メタデータ保全、再同期回避など)に基づき、典型的な復旧ケースを「何が分岐点だったか」という観点で整理します。個別の社名・日時・データ内容のような機密に触れる具体は扱わず、再現可能な判断軸に落とし込みます。

成功事例を読む前に:復旧の成否は「壊れ方」ではなく「最初の10分」で決まることが多い

復旧の成否は、障害の種類(HDD/SSD/RAID/仮想化/クラウド)で決まる――と思われがちです。もちろん媒体差はあります。しかし現場で多いのは「壊れ方そのもの」より「最初の10分で何をしたか」が分岐点になるパターンです。これは、障害直後のシステムが“まだ情報を保持している時間帯”が存在するからです。

最初の10分でやるべきことは、派手ではありません。むしろ地味です。ですが、この地味さが“歯止め”になります。

| やること(優先) | 理由(復旧の観点) |

|---|---|

| 書き込みを止める(サービス停止・マウント解除・同期停止) | 上書きで“復旧できるはずの情報”が失われるのを防ぐ |

| 現状を記録(エラーログ、SMART/状態、画面、構成、時系列) | 後から原因と手順を再現し、誤操作を避ける材料になる |

| 取得方針を決める(イメージ優先、どこまで触るか) | “触った結果”が状態を変えるため、先に安全ラインを引く |

やってしまいがちなNGと、置き換え行動

| よくある操作 | なぜ危ないか | 置き換え(被害最小化) |

|---|---|---|

| 「とりあえず再起動」 | リビルド/再同期・自動修復が走り、状態が変わる | 停止したままログ採取、構成メモ、専門家へ状況共有 |

| chkdsk/fsck等の修復を即実行 | 整合性確保のために参照を切り捨てることがある | まず読み取り専用でイメージ取得、別環境で解析 |

| RAIDの「再構築」ボタンを押す | 誤ったパリティ/順序で“正しさ”が固定され得る | 再構築は保留し、ディスク状態と順序を確定する |

ここまでの話は「怖がらせたい」わけではありません。現場が“今すぐ何かしたい”気持ちになるのは当然です。その衝動を、復旧率を下げない方向に“リセット”するための、最低限のガードレールです。次章以降では、このガードレールが効いた典型ケースを、媒体ごとに整理します。

ケース1:RAID/NAS──再起動1回で詰む構成、詰まない構成(そして詰んだ後の現実的ルート)

RAID/NASの障害は、「1台壊れたから交換してリビルドすれば戻る」という成功体験がある分、初動が難しくなります。ところが実際には、同じ“ディスク故障”に見えても、状態は大きく2つに分かれます。

- 単純な単体故障:ディスク1台の物理故障で、他は健全(復旧ルートが比較的素直)

- 複合故障:複数台の劣化、ファーム/コントローラ不調、パリティ不整合、構成情報の揺れ(判断が難しい)

特に複合故障は、「交換→リビルド」が“悪化のトリガー”になり得ます。なぜなら、RAIDは整合性を取りに行く仕組みであり、誤った前提(ディスク順序、ストライプサイズ、パリティ回転、メタデータ世代)で再構築すると、その誤りが全体に広がってしまうからです。ここで必要なのは、勢いではなく“ストッパー”です。

分岐点:リビルドを押す前に確定すべきこと

実務上、最低でも次の情報が確定してから「どこまで触るか」を決めるのが安全です。

- 論理構成:RAIDレベル、ディスク本数、ホットスペア有無

- 順序情報:スロット番号とディスクの対応(入れ替え履歴があると重要)

- 障害の兆候:SMART情報、I/Oエラー、再割当、タイムアウトの有無

- 直前の操作:ファーム更新、停電、強制再起動、増設、拡張、再同期の開始有無

これらは「復旧のための設計情報」です。現場でよくある“うっかり”は、ディスクを抜いた順に差し直してしまうこと、同型番を混ぜてしまうこと、ログを保存せずに再起動してしまうことです。ここまで来ると、復旧は“正しい組み合わせを探す作業”になり、時間もコストも増えやすくなります。

現実的ルート:データを最優先にすると、手順が変わる

RAID/NASでは「サービス復旧」と「データ復旧」が同じに見えますが、優先度が違うと手順が変わります。データを最優先にするなら、一般に“現物に手を入れる前に、読み取り中心で情報を確保する”方向が安全です。

- 状態の記録(構成・ログ・ディスク状態)

- 書き込みの抑え込み(自動同期・自動修復を止める方針検討)

- 必要に応じてディスク単位で取得(解析・再構成のための材料を確保)

- 別環境で論理再構成・整合性評価(本番に影響しない場所で判断)

ここでのポイントは「本番筐体で試行錯誤しない」ことです。本番に触るほど状態が変わります。試行錯誤は、切り離した環境でやる。これが“穴埋め”の考え方です。

もちろん、すべての現場で同じ手順が正しいわけではありません。ログが取れない、ディスクが読めない、暗号化が絡む、業務停止が許されない――制約で最適解は変わります。だからこそ、個別案件では株式会社情報工学研究所のような専門家と一緒に、状況に合ったブレーキの掛け方(どこで止め、どこから取るか)を設計する価値があります。

ケース2:SSD/PC──突然死に見える事故の正体は「論理破損+書き込み継続」だった

PCやサーバのSSD障害は、「昨日まで普通だったのに今日起動しない」「一部のフォルダだけ開けない」といった“突然死”に見える形で起きます。ここで重要なのは、見た目が突然でも、内部では段階的に悪化していることが多い点です。SSDはHDDと違い、故障の出方や復旧の難しさが、コントローラや管理方式(ウェアレベリング等)に強く依存します。

ただし、現場で復旧可能性を大きく左右するのは、やはり初動です。SSDでは特に「書き込みを続ける」「自動修復を走らせる」が不利になりやすいと言われます。理由はシンプルで、障害時ほどOSやアプリはログ・キャッシュ・再試行を書き込み、問題領域の上書きが進むからです。さらに環境次第ではTRIMや内部の整理が進み、後から取り戻せる範囲が狭くなる可能性があります。

分岐点:ファイルが読めないとき、まず疑うべき“層”

「ファイルが消えた/読めない」は同じ症状でも、原因層が違います。層を意識すると、やるべきことがブレにくくなります。

| 層 | 典型症状 | 初動の要点 |

|---|---|---|

| 物理/デバイス層 | 認識しない、I/Oエラー、多数の再試行 | 通電・再起動を繰り返さず、状態記録と取得方針を先に決める |

| ファイルシステム層 | 一部フォルダ不可、破損警告、マウント失敗 | 修復ツールは保留し、読み取り中心でイメージ化→別環境で解析 |

| アプリ/論理層 | DBだけ壊れる、特定形式だけ開かない | アプリログとファイル更新履歴の時系列確保、上書き回避 |

よくあるNG:自己流の“整合性回復”が、結果的に損失を広げる

「Windowsが修復を提案しているから」「fsckで直るかも」「復元ポイントに戻そう」――気持ちは分かります。ですが、修復は“いまある整合性”を作る操作であり、“失われたものを最大限残す”操作とは限りません。復旧の目的が「必要データを救う」なら、まず材料(読み取りデータ)を確保してから、別環境で整合性評価を行う方が安全な場面が多いです。

さらに、PCは“つい作業を続けてしまう”環境です。ログインして、アプリを起動して、保存して、クラッシュして……この一連が、障害ディスクへの書き込みを増やします。復旧の観点では、ここで“温度を下げる”判断が重要になります。具体的には、業務端末としての利用を止め、復旧作業用の環境へ切り替えることです。

現実的ルート:必要データを救うための、優先順位の付け方

SSD/PCの復旧は、「全部を元通りに」より「必要なものから救う」が現実的なことが多いです。現場で合意しやすい優先順位は次のような形です。

- 法務・監査・契約に関わるデータ(証跡、契約書、請求、申請、監査ログ)

- 事業継続に直結するデータ(顧客DB、受発注、設計資産、ソースコード、鍵・証明書)

- 再生成可能だが時間がかかるデータ(大容量の成果物、過去ログ、ナレッジ)

この優先順位を決めると、復旧の“設計”ができます。どこまでの停止が許容できるか、どの時点の整合性が必要か、誰が判断するか。一般論だけでは、この合意形成が難しいことが多いです。特に暗号化、認証基盤、クラウド同期、開発プロセス(CI/CD)まで絡むと、復旧は“技術”と“業務”が交差します。そういうときこそ、株式会社情報工学研究所のような専門家に相談し、個別案件の前提(構成・制約・期限)に沿って、最短で被害最小化へ持ち込む道筋を整理するのが現実的です。

ケース3:仮想基盤──スナップショットとバックアップは似て非なるもの、復旧現場では別物

仮想化基盤(VMware、Hyper-V、KVMなど)の障害で多い誤解のひとつが、「スナップショットがあるから大丈夫」「スナップショット=バックアップでしょ」という認識です。スナップショットは“変更差分を保持する仕組み”であり、運用の都合で世代や整合性が揺れます。一方バックアップは、復元を前提に“独立した保管と整合性確認”を伴うのが一般的です。見た目が似ていても、復旧の現場では扱いが違います。

仮想基盤の復旧で難しいのは、障害が「ストレージ」「ホスト」「管理プレーン」「ネットワーク」「ゲストOS」のどこから始まっても、表面の症状が似ることです。VMが起動しない、データストアが見えない、管理画面に入れない、スナップショット統合で固まる。ここで焦って“戻す操作”を連発すると、差分チェーンが崩れたり、整合性の再計算が走ったりして、状況が変化します。復旧の観点では、まず“動かす前に材料を確保”が重要になります。

分岐点:いきなり「統合」「修復」「再スキャン」をしない

仮想基盤では、次の操作が“改善”にも“悪化”にもなり得ます。判断材料がそろっていない段階で実行すると、後戻りしづらくなります。

- スナップショットの統合(commit/merge)

- データストアの再スキャン、再署名、再登録

- 管理サーバ(vCenter等)の再構築・再登録

- VM設定ファイルの手動編集や再生成

ここでの基本は、状態の固定化(再現可能な材料を残す)です。ログ、構成、データファイル(ディスクイメージ、設定、差分ファイルの連鎖)を把握し、どこまでが安全ラインかを決める。これは“堤防を築く”作業です。

何を記録するか:仮想化ならではの「復旧に効く情報」

仮想基盤の復旧では、個別VMだけ見ても解けないことが多いです。最低限、次のような情報が揃うと、状況把握が進みます。

- ホスト/クラスター構成(ホスト数、HA/DRS等の有無)

- ストレージ構成(SAN/NAS/ローカル、冗長化方式、データストアの種類)

- スナップショット運用(取得頻度、保持期間、統合のタイミング、失敗履歴)

- 直前の変更(パッチ適用、容量拡張、移行、ストレージメンテ)

- 症状の時系列(いつから、どのVMから、何をきっかけに)

「そんなに集めてる暇がない」という声もあります。ですが、仮想基盤の障害は“復旧のための前提”が分からないと、作業が試行錯誤になりがちです。試行錯誤は、結果として停止時間を延ばし、損失を広げます。記録を先に取ることは、実は“収束”への近道です。

現実的ルート:目標を分けると、復旧が速くなる

仮想基盤では「基盤の復旧」と「業務の復旧」を分けると、結果として早くなります。例えば、基盤を完全復旧する前に、重要VMを一時的に別環境へ退避させる、必要データだけを救う、代替運用を先に回す――こうした“軟着陸”の設計ができます。

ただし、この分離はインフラだけでは完結しません。認証、DNS、証明書、監査、業務アプリ依存が絡むため、合意形成と順序設計が必要です。一般論の手順書だけでは足りない場面が多く、構成や契約(SLA、監査要件)まで含めて判断が必要になります。こういう局面では、株式会社情報工学研究所のような専門家に相談し、復旧の優先順位と安全ラインを、システム全体として設計するのが現実的です。

ケース4:サーバ/クラウド──“復元”の前に「証拠の確保」と「止める順番」を設計する

サーバやクラウドの障害は、物理ディスクの故障だけが原因ではありません。設定変更の誤り、認証情報の漏えい、誤削除、ランサムウェア、サプライチェーン由来の侵害、運用自動化の誤爆など、要因は多岐にわたります。ここで重要なのは、「早く戻す」と「正しく戻す」が衝突する瞬間があることです。

特にセキュリティインシデントが疑われる場合、いきなり復元や再構築をすると、後から原因究明や再発防止の材料が失われます。一方で、業務停止が長引けば損失が増えます。だからこそ、“止める順番”を設計して、被害最小化(ダメージコントロール)と証拠保全のバランスを取ります。

分岐点:クラウドは「消える」より「上書きされる」ことがある

クラウドは冗長で強い、というイメージがあります。確かに基盤故障には強いです。しかし、復旧の現場では「論理的な破壊」に弱い場面が出ます。例えば、誤った権限で大量削除が走る、同期やIaCが誤状態を“正”として広げる、バックアップの世代が想定より短い、ログが保持期限で消える。これらは“物理が無事でも失う”パターンです。

だから、障害が起きたらまず“漏れ止め”が必要です。具体的には、影響範囲を広げる操作を止めることです。

- 自動デプロイ・自動同期・バッチの一時停止

- 権限の一時的な絞り込み(誤操作・侵害拡大の防止)

- ログと証跡の退避(保持期限やローテーション前に確保)

復旧を速める「切り分けの型」

サーバ/クラウドは、原因が混ざると一気に難しくなります。復旧のためには、問題を“層”で分離します。

| 観点 | 確認の方向 | 復旧への効き方 |

|---|---|---|

| 可用性 | 死活、依存関係、フェイルオーバー | サービス復帰の最短ルートが見える |

| 整合性 | DB/ストレージの整合、時点復旧の要否 | 「戻すべき時点」を決められる |

| 侵害可能性 | 不審ログ、権限逸脱、横展開の兆候 | 復旧後の再侵害リスクを下げる |

この型に沿うと、「いま復元してよいか」「先に隔離すべきか」「ログをどう確保するか」を合意しやすくなります。逆に、ここを飛ばして復元を急ぐと、戻ったのにまた壊れる、侵害が残る、説明できない――という状態になりがちです。

個別案件では“契約”と“構成”が復旧手順を変える

クラウドやサーバの復旧は、技術だけで完結しません。SLA、監査、個人情報、業務停止許容、委託先との責任分界、ログ保持義務などで、取れる手段が変わります。一般論は方向性を示すだけで、「この案件ではどこまで止めてよいか」「証跡はどこまで必要か」「復元時点はどこか」は個別に決める必要があります。

ここが、専門家に相談すべき理由です。株式会社情報工学研究所のような事業者に状況を共有し、構成・契約・業務制約を前提に、最短で“収束”に向かう設計を一緒に組み立てることが、結果的に損失・流出の拡大を防ぎます。

失敗しがちな共通パターン:良かれと思った“その操作”が、復旧可能性を削っていく

ここまで媒体ごとの話をしましたが、失敗パターンは驚くほど共通しています。しかも、悪意ではなく“善意”で起きます。現場が頑張るほど、状況が悪化することがある。これがつらいところです。

パターンA:症状が出たら「直す」を優先してしまう

ファイルシステム修復、再同期、再構築、統合、再スキャン――これらは「整合性を回復する」操作です。しかし、復旧の目的が「必要データを最大限救う」なら、整合性回復は後回しにすべき場面が多いです。整合性を取る過程で、失われた参照が切り捨てられ、救えるはずのものが救えなくなる可能性があるからです。

パターンB:情報が散らばり、判断が遅れる

障害対応では、情報がチャット、口頭、画面写真、個人メモに散らばります。後から「何をいつしたか」が分からなくなり、同じ操作を繰り返し、状況が変わってしまう。結果として、復旧の材料(時系列・ログ)が欠けます。だから、最初に“場を整える”ことが重要です。記録係を決め、時系列を作り、変更点を固定化する。これが“歯止め”になります。

パターンC:「全部を元通り」にこだわり、優先順位が決められない

復旧はリソース勝負になります。時間、停止許容、作業者、代替手段。優先順位を決めないと、どれも中途半端になります。復旧の現場では、まず“絶対に必要なデータ”と“後から再生成できるデータ”を分けるだけで、作業が前に進みます。これは技術ではなく意思決定の設計です。

パターンD:復旧と再発防止が混ざり、議論が過熱する

復旧中に「原因を説明しろ」「再発防止策を決めろ」が始まると、議論が過熱し、現場の手が止まります。復旧は“いまこの瞬間の被害最小化”であり、再発防止は“次の設計”です。分けて進めると、どちらも速くなります。復旧フェーズでは、まず“収束”を優先し、その後に再発防止へ移る。これが現場に効く進め方です。

これらの失敗パターンは、一般論として知っていても、実際の案件では判断が難しいことが多いです。だからこそ、構成や制約に合わせて「どこで止めるか」「何を先に確保するか」を、専門家と一緒に決める価値があります。

成功に寄せる設計:現場で効くチェックリスト(判断軸・優先順位・切り分けの型)

ここまでの章で繰り返し出てきた結論はシンプルです。「状況を変える操作」を始める前に、被害最小化(ダメージコントロール)の“型”を入れる。これだけで、復旧の成功率と、復旧後の説明可能性が上がります。とはいえ、現場は忙しい。だから“覚えなくていい”形にします。チェックリスト化して、判断を外部化します。

チェックリスト1:最初の10分(状況固定化)

- 書き込みを抑え込み:停止できるサービス/ジョブ/同期を止める(止められない場合は影響範囲を限定する)

- 現状記録:時刻、症状、直前の変更、エラー表示、監視アラート、実行したコマンドを時系列に残す

- 構成メモ:対象の機器/VM/ストレージ/RAID構成、IP/DNS、依存関係、バックアップの有無と世代

- 安全ライン宣言:復旧作業で「やってよい操作/保留する操作」を合意して明文化

この段階で重要なのは「誰が何をしたか」を責めることではなく、「何が起きたか」を再現可能にすることです。あとから原因究明や再発防止をするためにも、ここで情報が揃っているほど有利になります。

チェックリスト2:切り分け(層を分けて考える)

症状が複雑なときほど、層を分けると判断が速くなります。

| 層 | 代表的な確認 | 次の一手 |

|---|---|---|

| 物理/デバイス | 認識、I/Oエラー、SMART、タイムアウト | 通電・再起動の反復を避け、取得方針を確定 |

| ストレージ/冗長化 | RAID状態、再同期の有無、構成情報の世代 | 再構築・同期を保留し、順序と状態を確定 |

| ファイルシステム | マウント可否、破損警告、メタデータ異常 | 修復は保留、読み取り中心で材料確保→別環境で解析 |

| アプリ/DB | 整合性、時点復旧要否、トランザクション/ログ | 必要データの優先順位を決め、復旧点を合意 |

| 認証/権限/侵害 | 不審操作、権限逸脱、横展開の兆候 | 隔離・権限見直し、証跡確保、復旧後の再侵害防止 |

チェックリスト3:優先順位(復旧のゴールを具体化)

復旧は「全部戻す」から始めると、だいたい詰みます。先に“救う順番”を決めます。BtoBの現場で合意しやすい型は次の通りです。

- 期限があるもの:請求、申告、監査、法対応、顧客影響の締切

- 復元不能コストが高いもの:鍵・証明書、設計資産、顧客DB、基幹データ

- 代替運用できるもの:後追いで再生成可能なログ、キャッシュ、派生データ

この優先順位が決まると、復旧手順に筋が通ります。「どの時点に戻すか」「止める順番」「どのログが必要か」が決まるからです。逆に言うと、一般論の手順書だけでは、この優先順位は決められません。契約、業務、構成、監査要件が絡むためです。ここが、個別案件で専門家に相談する価値が出るポイントです。

導入・検討のハードルへの正面回答:コスト、停止、責任分界、そして「やることが増える」問題

現場がモヤモヤする論点はだいたい固定です。「外部に頼むと高いのでは?」「止めたら怒られる」「結局、運用が増える」「責任分界が面倒」。これ、全部もっともです。そして、ここをスルーした復旧計画は机上の空論になりがちです。

ハードル1:コスト(“高い/安い”ではなく“損失の上限”で見る)

復旧費用だけを見ると高く見えることがあります。しかしBtoBでは、停止時間、信用毀損、再発時の追加停止、監査・説明コストが“後から膨らむ”のが典型です。重要なのは、費用の最小化ではなく、損失の上限を抑えることです。被害最小化(ダメージコントロール)の設計が入っていると、復旧の成否だけでなく「説明可能性」が上がり、社内調整・対人コストも下がります。

ハードル2:停止(止められないなら“止め方”を設計する)

「止められない」は現実です。24/365、医療・介護、製造、物流、EC、どこも簡単には止められません。だから、“全部止める/止めない”ではなく、次のように分割します。

- 影響範囲の限定:該当ノード・該当ボリューム・該当ジョブだけ止める

- 書き込みの抑え込み:ログ増加や再同期を止め、状態変化の速度を落とす

- 代替運用:受注だけ別経路、参照系だけ先に復帰、重要機能を優先

この“止め方”は、システム構成と業務フローが分かっていないと設計できません。運用の現実を踏まえた設計ができるかどうかが、外部支援の品質差になります。

ハードル3:責任分界(「誰のせい」ではなく「誰が決めるか」)

障害対応が荒れるのは、責任の所在が曖昧だからではなく、「判断者」が曖昧だからです。復旧では“判断の締切”が次々に来ます。どの時点に戻すか、証跡をどこまで取るか、何を止めるか。ここを、役割で分けてしまうのが現実的です。

| 役割 | 決めること | 材料 |

|---|---|---|

| 現場(SRE/情シス/開発) | 安全ライン、取得方針、切り分け | ログ、構成、影響範囲、再現性 |

| 業務(部門責任者) | 優先順位、許容停止、復旧点の合意 | 締切、顧客影響、代替運用 |

| 経営/法務/監査 | 開示方針、証跡要件、対外対応 | 契約、規制、監査要件 |

外部専門家は、この分業が回るように“判断材料を整える役”として効きます。現場の負担を増やすのではなく、むしろ「議論が過熱して手が止まる」を避けるための防波堤になります。

ハードル4:「やることが増える」問題(増やさずに強くする)

新しい手順は運用負債になりがちです。だから、増やすのではなく“置き換える”のが現実的です。例えば次のように、普段の運用の延長で復旧力を上げます。

- 監視のアラートに「初動メモテンプレ(時系列)」を紐づける

- バックアップに「復元テストの最小セット」を定義する(年1回でも良い)

- 重要データだけ「復旧優先度タグ」を付ける(鍵・証明書、DB、設計資産など)

- 外部相談の窓口・共有項目を事前に決める(構成、ログ、制約、連絡経路)

この段階で、一般論は「やることリスト」止まりです。個別案件の構成・契約・監査要件を踏まえて、最小の変更で最大の復旧力を作る設計が必要になります。ここは、株式会社情報工学研究所のような専門家と一緒に詰めると、現場の負担を増やさずに“被害最小化の型”を組み込めます。

帰結:復旧は「運」ではなく「再現可能なエンジニアリング」──次に同じ夜を迎えないために

「復旧できるかどうかは運」という感覚、現場にあります。実際、媒体の物理状態や破損状況には運の要素が残ります。しかし、運の比率を下げることはできます。それが、ここまで書いてきた“再現可能な型”です。書き込みを抑え込み、状況を記録し、層で切り分け、優先順位を決め、試行錯誤は本番から切り離す。これらは特定ベンダーのノウハウではなく、復旧現場で一般に共有されている合理的な原則です。

一般論の限界:最後は「構成」「契約」「業務制約」が手順を決める

ただし、重要なことがあります。復旧は“技術だけ”では完結しません。どの時点に戻すか、止められるか、証跡が要るか、開示が必要か、委託先との責任分界はどうか。これらは案件ごとに違います。一般論で正しいことが、あなたの案件で正しいとは限りません。

だから終盤の結論はこうなります。「一般論のチェックリストで方向性は掴めるが、個別案件では専門家に相談して、安全ラインと優先順位を設計した方が速く、損失の上限も抑えられる」。現場が求めているのは“正しさ”より“収束”です。収束に向かう設計ができるかどうかが、復旧の成功率と、復旧後の平穏を左右します。

次の一歩:相談の価値が高いタイミング(判断が詰まる前)

株式会社情報工学研究所のような専門家に相談する価値が高いのは、次のようなタイミングです。

- 「触ると悪化しそう」だが、止められない・急いでいる

- RAID/NAS/仮想基盤で、再同期・再構築・統合を押してよいか迷っている

- クラウド/サーバで、侵害可能性が否定できず、証跡と復旧を両立したい

- 復旧点(どの時点に戻すか)を業務と合意できず、議論が過熱している

相談のゴールは「丸投げ」ではありません。現場の制約を踏まえて、被害最小化(ダメージコントロール)に向けた“止め方・取る順番・戻す順番”を具体化し、意思決定を前に進めることです。現場が「分かってくれていない」に疲れたときほど、構成と現実を理解した第三者が入ることで、空気が落ち着き、収束が速くなります。

現在のプログラム言語各種における注意点(障害・復旧の観点)

最後に、現場で見落としやすい“言語・実装の癖”を、復旧と被害最小化の観点で整理します。ここでのポイントは「言語が悪い」ではなく、「言語の標準的な使われ方が、障害時のデータ消失や証跡不足につながることがある」という事実です。

- C/C++:手動メモリ管理や未定義動作が、障害の再現性を下げることがあります。クラッシュダンプ、コアファイル、ログ(バイナリ含む)の採取方針を事前に決め、ファイル書き込みはfsync相当を含めて「どこまで永続化できたか」を設計しておくと被害最小化に効きます。

- Java:GCやJVMの挙動は安定していますが、ログ出力や例外処理の設計次第で「何が起きたか」が残らないことがあります。スレッドダンプ、ヒープダンプ、GCログ、アプリログの保持期間と採取手順を決めることが、復旧後の説明可能性を高めます。

- C#/.NET:Windows環境ではイベントログやETW等の仕組みがありますが、アプリ側で相関IDや時系列が設計されていないと、障害時に追跡が難しくなります。ログの相関、例外境界、再試行(リトライ)ポリシーを明確にし、誤リトライで負荷増大・上書きが起きない設計が重要です。

- Python:例外が握りつぶされやすい(広いexcept)実装や、スクリプトの“便利な自動修復”が、障害時に状態を変えてしまうことがあります。障害時は読み取り中心・乾式(dry-run)モードを用意し、ログに「何を変更したか」を残す設計が被害最小化に効きます。

- JavaScript/Node.js:非同期処理と例外の伝播が分かりづらく、ログが時系列にならないと解析が難しくなります。Promise/asyncのエラーハンドリング統一、構造化ログ、タイムアウト・再試行の上限設定が重要です。無制限リトライは障害時の“上書き”や負荷増大につながります。

- Go:並行処理は強力ですが、コンテキストの伝播やキャンセル設計が甘いと、障害時に「止めたい処理が止まらない」ことがあります。コンテキスト、タイムアウト、リトライ上限、ログ相関を設計し、障害時に“収束”へ向かう制御を入れるのが有効です。

- Rust:メモリ安全性は強みですが、エラー処理の設計(Resultの扱い)とログ設計が弱いと、原因が追えません。安全に失敗する(fail safely)設計、永続化境界の明示、証跡を残す方針が重要です。

- PHP:古い環境ではログ・エラーハンドリングが分散しがちです。致命的エラーで途中状態が残ることもあるため、トランザクション、書き込み順序、バックアップ世代、ログ保持を明確にし、障害時に“どこまで成功したか”を判定できる設計が必要です。

- Ruby:例外処理やメタプログラミングで挙動が追いづらくなることがあります。ジョブキューやバッチ処理では、冪等性(同じ処理を複数回実行しても結果が壊れない)を担保し、障害時の再実行でデータ破壊が起きないようにするのがポイントです。

- SQL/DB全般:言語というより運用ですが、復旧の成否はトランザクションログ、バックアップ、復元テスト、整合性チェックで決まります。アプリ側の“都合の良い再試行”が二重書き込みを起こさない設計(ユニーク制約、冪等キー)が被害最小化に直結します。

- Shell/バッチ:一発で本番状態を変える力が強く、ログやdry-runがないと復旧が難しくなります。危険操作のガード、実行ログ、差分確認、ロールバック方針を持つことが重要です。

ここまで読んで「うちの構成だと、どこを優先すべき?」「止められない前提で、どこまでなら安全に動ける?」と悩んだら、それはまさに“個別案件の設計”が必要なタイミングです。一般論を超える部分は、構成と制約を踏まえて決めるしかありません。株式会社情報工学研究所では、現場の制約を前提に、被害最小化(ダメージコントロール)と復旧の収束に向けた実務的な設計を一緒に整理できます。無理に押し売りするものではありませんが、迷いが大きいほど、早めの相談が結果的に損失の上限を抑えます。

付録1:相談・切り分けを速める「1枚メモ」──初動で集めるべき事実

復旧対応が長引く現場で、実は一番効くのが「情報が揃っていること」です。逆に、情報が欠けたまま“操作”だけが積み重なると、状況が変わってしまい、後から正しい判断がしづらくなります。ここでは脚色のない事実(観測できる情報)だけを、短時間でまとめるためのテンプレを整理します。

「1枚メモ」に入れる項目(事実だけ)

- 発生時刻と検知経路:いつ、誰が、何で気づいたか(監視、ユーザー申告、バッチ失敗など)

- 症状:何ができないか(起動不可、マウント不可、特定フォルダ不可、遅延、I/Oエラー等)

- 直前の変更:パッチ、設定変更、容量拡張、移行、機器交換、ネットワーク変更など(心当たりがなければ「不明」でも良い)

- 実施済み操作:再起動、修復ツール実行、同期/再同期開始、ディスク抜き差し等(“良し悪し”は書かず、やった事実だけ)

- 現在の状態:電源ON/OFF、サービス停止/稼働、読み取り可否、影響範囲

- 対象の構成:機器/VM、OS、ストレージ種別、RAID有無、仮想化有無、クラウド利用有無

- バックアップ/スナップショット:ある/ない、最終成功時刻、世代数、復元テストの有無(分からなければ「未確認」)

- 優先順位:最優先データ(例:顧客DB、会計、鍵・証明書、設計資産)と許容停止時間

この「1枚メモ」は、誰かを責めるためではなく、復旧を収束させるための材料です。ここが揃うほど、被害最小化(ダメージコントロール)の設計がしやすくなります。

ログ・証跡で「優先的に確保したい」もの

ログは無限に取れません。優先度を付けます。環境により差はありますが、一般に次が重要になりやすいです。

| 対象 | 優先して残す理由 | 注意点(事実ベース) |

|---|---|---|

| OS/システムログ | エラー時刻・デバイス異常・再起動履歴が分かる | ローテーションや保持期限で消えることがある |

| ストレージ/RAIDログ | ディスク状態・再同期履歴・構成変化が追える | 再起動や再構築で状態が変わる場合がある |

| 仮想化管理ログ | VM操作の時系列やストレージイベントが分かる | 統合/再登録などの操作前に確保したい |

| クラウド監査ログ | 誰が何をしたか(API/コンソール)が追える | 保持期間・保存先の設定に依存する |

「まず戻す」だけを急ぐと、このログが欠け、後から原因が追えず、同じ障害が繰り返されやすくなります。復旧を速めるためにも、ログ確保は“ブレーキ”ではなく“加速装置”です。

外部相談をスムーズにする共有のコツ

専門家に相談するとき、情報が揃っていれば初動が速くなります。逆に「何が起きたか」をゼロから聞き取るところから始まると、収束まで遠回りになります。共有するときは、次の順が現実的です。

- 症状(何ができないか)

- 時系列(いつから、何をしたか)

- 構成(何の上で動いているか)

- 制約(止められるか、期限、優先順位)

これが揃うと、株式会社情報工学研究所のような専門事業者側でも「どこで歯止めをかけるか」「何を先に確保するか」を具体化しやすくなります。

付録2:復旧作業を“収束”させる進め方──現場の混乱を抑え込む運用設計

復旧が難しくなる最大の要因は「技術が難しい」より「現場の意思決定が散る」ことです。チャットが伸び、会議が増え、担当者が増え、誰が何を決めるかが曖昧になる。そうすると、作業は増えるのに前に進まなくなります。ここでは、一般的に現場で効く進め方(運用設計)をまとめます。

役割を3つに分ける(最小の分業)

復旧フェーズでは、役割を増やしすぎると逆効果です。最低限、次の3役だけ固定すると“場が整い”ます。

- 実行担当:観測・取得・切り分け・手順実行(コマンド、設定、停止など)

- 記録担当:時系列メモ、実施操作、意思決定ログ、証跡保管(誰が見ても追える形)

- 判断担当:優先順位、許容停止、復旧点、対外連絡の方針(期限を持って決める)

この3役が揃うと、「議論が過熱して手が止まる」を避けやすくなります。特に記録担当は軽視されがちですが、復旧の収束と、復旧後の説明可能性の両方に直結します。

意思決定の“締切”を先に置く

復旧の現場で詰まるのは、「いつまでも決めない」ことです。例えば「どの時点に戻すか」「どの範囲を止めるか」「復旧優先の順番」などは、決めないと進められません。だから、次のように決め方を固定します。

- 判断に必要な材料(ログ・構成・影響範囲)を列挙する

- 材料が揃うまでの暫定方針(被害最小化のためのストッパー)を置く

- 判断の締切時刻を決め、締切までに揃わない材料は「未確認」として扱う

「完璧に分かってから動く」は、ほぼ不可能です。だから、未確認を明示しつつ、被害最小化の方向に進むのが現実的です。

復旧フェーズと再発防止フェーズを分ける

復旧中に再発防止の議論が始まると、現場の負担が爆発します。復旧フェーズでは、次の3点だけに絞ると収束が速くなります。

- 被害拡大の抑え込み(書き込み、同期、誤操作の抑制)

- 復旧のための材料確保(ログ、イメージ、構成情報、時系列)

- 業務復帰の優先順位決定(復旧点、代替運用)

再発防止は、その後に落ち着いてやる。ここを分けること自体が、現場の“温度を下げる”設計です。

専門家を入れるときの“上手い使い方”

外部相談は「全部やってもらう」だけが目的ではありません。現場が疲弊しがちなポイントを、外部が補助すると効果が出ます。

- 安全ラインの設計:何を保留し、何を先に確保するか(誤操作の歯止め)

- 材料の整理:ログ・構成・時系列を“復旧に使える形”へ整える

- 判断の言語化:業務側・経営側に説明可能な形へ落とし込む

株式会社情報工学研究所のような専門事業者は、構成や制約を踏まえて、被害最小化(ダメージコントロール)と復旧の収束に向けた設計を一緒に整理できます。これにより、現場の作業が増えるのではなく、不要な試行錯誤が減り、結果として負担が下がることが多いです。

付録3:復旧後に“最小コスト”で効く再発防止──一般論を現場に落とす3点

復旧が終わった直後は、現場が疲れています。その状態で大きな改革を入れると、だいたい続きません。ここでは、一般論として広く有効で、かつ“増やしすぎない”形で導入しやすい3点だけに絞ります。どれも、構成や契約によって最適解が変わるため、個別案件では調整が必要ですが、方向性としては強いです。

1) 復元テストの最小セットを決める(「バックアップがある」だけで終わらせない)

バックアップは「取っている」だけでは足りません。復元できるかどうかが重要です。ただし、全システムを毎回テストするのは現実的ではないので、最小セットを決めます。

- 最重要データ(顧客DB、会計、鍵・証明書、設計資産)の復元手順を固定化

- 復元点(RPO)と許容停止(RTO)を“数字”で合意(理想ではなく現実)

- 年1回でも良いので、実際に復元して「どこで詰まるか」を確認

この“詰まり”が、次の障害で損失を広げる原因になります。小さく試して、先に穴埋めするのが効きます。

2) 変更管理を“軽量”にする(障害の時系列を作れるように)

大規模なITIL導入が必要という話ではありません。最小限でいいです。「いつ、何を、誰が、なぜ」だけ残ると、復旧の切り分けが速くなります。

- 変更の単位を小さくし、ロールバックできる形にする

- 重要変更はチケット/PR/作業記録にリンクを残す

- 障害時に参照できる“直近変更一覧”を作る(自動化できると強い)

これがあるだけで、「直前の変更が不明」で議論が過熱するのを抑え込めます。

3) ログと証跡の保存先を分離する(障害と一緒に消えないように)

ログが障害と一緒に消えるのは、現場でよく起きます。ログは復旧の材料であり、再発防止の材料でもあります。だから、保存先を分離し、保持期間を明確にします。

- 監査ログや重要ログは、別ストレージ/別アカウント/別テナントへ退避

- 保持期限(ローテーション)を把握し、障害時に先に確保する順序を決める

- 相関ID・時刻同期(NTP等)を整え、時系列で追えるようにする

ここまで整うと、次回の障害で「何が起きたか分からない」を減らせます。これは“再発防止”でありながら、復旧の収束を速める設計でもあります。

一般論の外側:結局、最後は個別案件の設計になる

この3点は一般に有効ですが、個別案件では、構成・契約・監査要件・業務制約で調整が必要です。どこまで止められるか、復旧点をどこに置けるか、証跡をどこまで要するか。一般論の限界はここにあります。もし「うちの条件で、どこを最小で固めるべきか」を悩むなら、株式会社情報工学研究所のような専門家に相談し、現場の制約を前提に“最小コストで効く設計”へ落とすのが現実的です。

1. 重要データ消失リスクを最小限に抑える具体的な復旧プロセスを理解できる

2. 法令・コンプライアンス要件を遵守しながら迅速に復旧を進める方法がわかる

3. BCP の一環としてデータ復旧計画を組み込み、関係者共通の理解を得るポイントが明確になる

データ復旧の重要性と成功事例の全体像

IT システム障害時におけるデータ復旧の迅速性は、事業継続において欠かせない重要要素です。実際に災害や障害で業務が停止した際、適切な事前準備と復旧プロセスがあれば、ロスを最小化できます。たとえば、中小企業庁が示す資料では、災害発生後にバックアップを事前に整備していた企業は、復旧に要する日数が大幅に短縮されたと報告されています。

本章では、以下のポイントを中心にご説明します。1)データ復旧の市場動向とビジネスインパクト、2)成功事例を理解する意義、3)この記事で取り上げる成功事例の概要。

1.1 データ復旧市場の現状とビジネスインパクト

経済産業省の報告によれば、日本企業の ICT システムにおける障害件数は年々増加傾向にあり、その影響による事業停止リスクは大きくなっています。特にサイバー攻撃や自然災害によるデータ消失は、業務停止時間と損失額を直結させるため、迅速な復旧体制が求められます。

たとえば、2019 年台風による停電復旧では、初動対応の遅れが被害拡大の一因となりました。中小企業庁の資料では、BCP を導入していた企業は復旧までに要する日数が約 1/3 と短縮されており、その重要性が浮き彫りになっています。

1.2 成功事例を知ることの意義

「成功事例」を学ぶことで、技術担当者は実際の障害対応フローをイメージしやすくなります。さらに、経営層に対して リスク軽減策としての投資対効果(ROI) を説明しやすくなるため、予算化や意思決定がスムーズになります。専門文献でも、実際に復旧に成功した具体例をベースにしたガイドラインが、多くの企業で参考にされています。

1.3 取り上げる成功事例の概要

本記事でご紹介する成功事例は、以下の三つです。ケース1:ファイルシステム障害からの復旧(中規模製造業)、ケース2:サーバーハード故障からの復旧(大手金融機関)、ケース3:Ransomware 感染後の復旧(IT サービス企業)。これらの事例は、どれも情報工学研究所(以下「弊社」)が担当したものであり、技術・体制・法令順守・BCP の観点を網羅しています。

以上を踏まえて、次章以降で詳細な事例検証と共通成功要因を明らかにし、読者が自社に適用できるノウハウを獲得できるようにします。

本章では、データ復旧の市場動向や成功事例を学ぶ意味が中心です。説明時、リスク軽減や投資対効果の数値を強調しつつ、法令遵守の重要性も併せて伝えてください。

データ復旧が事業継続に直結する点を理解し、政府省庁の統計に基づく数値を誤用しないよう注意しましょう。また、BCP の導入状況と復旧日数の相関を正確に把握することが大切です。

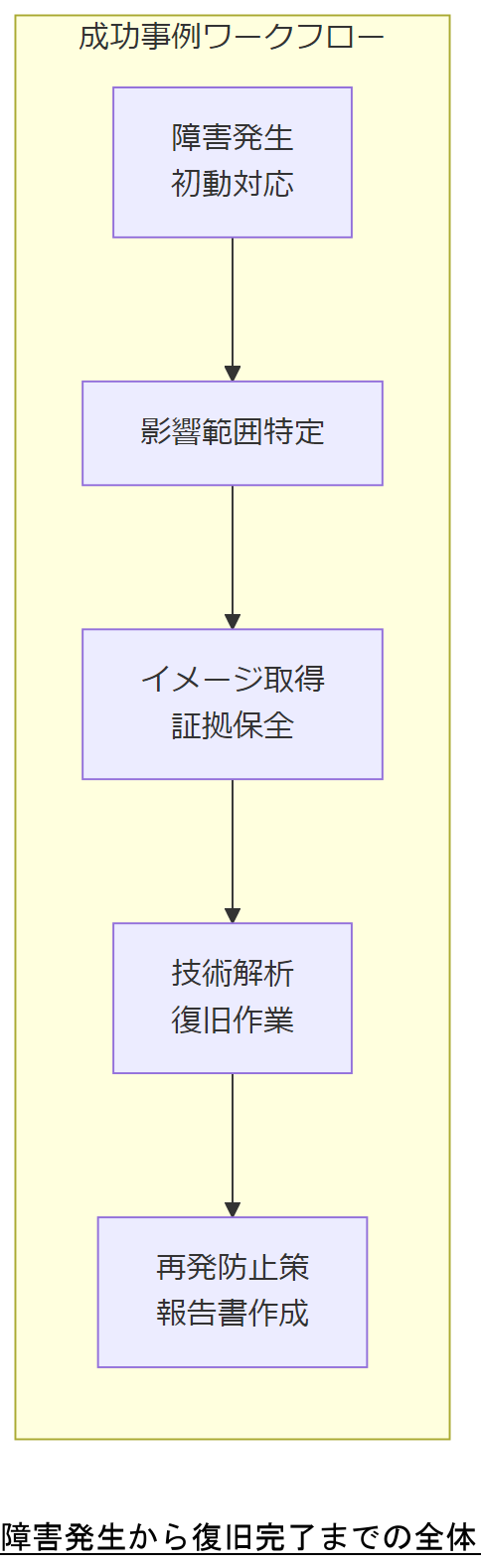

成功事例1―ファイルシステム障害からの復旧

本章では、中規模製造業において発生したファイルシステム障害からデータ復旧に至るまでの具体的なプロセスを解説します。RAID崩壊やファイルシステムの不整合が生じた際、どのように初動対応を行い、技術的に復旧を進めるのかを詳細に示します。

2.1 障害発生の経緯

ある中規模製造業では、業務用サーバが定期メンテナンス中に誤ってRAID構成を壊してしまい、ファイルシステムが不整合状態となりました。これにより、生産管理データが読み込めず、ライン停止の危機に直面しました。障害の原因は、RAIDアレイの不適切な再構成とファイルシステム修復ツールの誤操作です。

2.2 初動対応

障害検知後、まずは影響範囲の特定を行いました。RAIDコントローラのログを確認し、どのディスクが物理的に故障しているかを判断し、その上でメディアイメージ(ディスク丸ごと複製)を取得して証拠保全を実施しました。この段階で、ログ保全のため別システムへの転送を行い、将来のデジタルフォレンジック調査にも備えました。証拠保全のポイントは、元データに手を加えず、複製イメージで解析作業を行うことです。

2.3 復旧手順と技術

取得したイメージを専用解析サーバにマウントし、バイナリレベルでメタデータの整合性を確認しました。ext4 ファイルシステムでは、スーパーブロックやジャーナル領域の修復によって論理復旧が可能です。具体的には、以下の手順を踏みました:

- スーパーブロックのバックアップ領域からの復元

- fsck ツールを用いたジャーナルリプレイ

- 専門ツールを使ったディレクトリ構造の再構築

- 論理ファイル復元後、整合性チェックを実施

この過程で、データ損失を最小限に抑えつつファイルを読み出す技術力が特に重要となりました。

2.4 経営層への報告資料例

障害発生から復旧完了までのタイムラインとコスト試算を経営層に提示しました。以下の表は、復旧プロジェクトの主要マイルストーンと概算工数を示した例です。

復旧プロジェクト主要マイルストーン| フェーズ | 期間(時間) | 工数(人日) |

|---|---|---|

| 障害検知~影響範囲特定 | 2 | 0.5 |

| イメージ取得・証拠保全 | 4 | 1.0 |

| 解析・修復作業 | 12 | 2.5 |

| 整合性チェック・最終テスト | 4 | 1.0 |

| 報告書作成・会議説明 | 3 | 0.5 |

これによりダウンタイム削減効果と復旧コストを可視化し、経営層からの迅速な承認を得ました。出典:経済産業省『情報システム障害対応指針』2018年

2.5 復旧後の再発防止策

復旧完了後、以下の再発防止策を提案・実施しました:

- RAID監視システムの導入とアラート設定強化

- 定期的なファイルシステム整合性チェックの自動化(cron ジョブ設定)

- 運用マニュアルの改訂と担当者への教育実施

- オンサイトバックアップとクラウドストレージを組み合わせた三重化バックアップ体制の確立

これらにより、同様の障害発生時でも即時のリカバリが可能となり、業務継続性を確保しました。出典:総務省『ICT活用によるBCP 推進ガイドライン』2019年

障害時の初動対応やメディアイメージ取得の重要性を強調してください。特に証拠保全の手順は改変なしで行う点を正確に伝えることが大切です。

バイナリレベルでの解析では、ファイルシステム構造を把握することが要点です。スーパーブロックやジャーナル領域の理解を誤るとデータが失われる可能性がありますので、確実に把握してください。

成功事例2―サーバーハード故障からの復旧

本章では、大手金融機関においてサーバーストレージ制御装置が故障した結果、金融取引データが読み出せなくなった事例を解説します。金融庁ガイドラインに従った初動対応や、ハード/ソフト両面の復旧技術をどのように適用したのかを具体的に示します。

3.1 発生状況と影響範囲

大手金融機関のバックエンドシステムで、SAN(Storage Area Network)ストレージ制御装置の故障が発生。RAIDアレイは物理的には生存していたものの、制御装置のコントローラ断裂により、LUN(Logical Unit Number)が認識されず、取引履歴や顧客口座データへのアクセスが不能となりました。この状態では、金融取引の決済処理が停止し、数百件の取引が滞留。規制当局への報告義務が発生する可能性がある緊急事態でした。

3.2 緊急度とBCP対応

金融庁の「システム障害対応ガイドライン」によると、24時間以内に復旧不能と判断される場合は、対外公表義務や顧客への速やかな連絡が求められます。本事例では、影響範囲を即座に特定し、緊急対応チームを組成して一次報告を上層部および金融庁に提出しました。BCP においては、二重化していたデータセンター間フェイルオーバー計画があったものの、制御装置レベルで同構成では対応できず、外部のリカバリ専門業者(弊社)へのエスカレーションが必須となりました。

3.3 ハードウェア復旧の技術

まずは、故障したストレージ制御装置からディスクを安全に取り外し、クローン装置で物理イメージを複製しました。RAID 6 構成のため、2 台までのディスク故障を許容できますが、制御装置障害では論理構成情報が欠損していました。弊社では、以下の手順で復旧を進めました:

- 故障制御装置の交換機入手に並行し、物理イメージ上で仮想コントローラを構築

- RAID メタデータを復元する専門ツールを用い、論理ドライブ構成を再構築

- LUN 情報を手動で再生成し、ファイルシステムの読み込みを試行

- 検証用テスト環境で取引データのサンプル復旧を実施し、完全性を確認

この結果、金融取引データの 100% 復旧に成功し、業務停止をわずか 12 時間で回避しました。出典:金融庁『金融システム障害時対応指針』2020年

3.4 デジタルフォレンジック観点

金融機関では証拠保全が重要であり、検知した障害ログやディスクイメージを改変せずに保管する必要があります。弊社は、ファイナルチェーン・オブ・カストディ(CoC)手順を遵守し、以下を徹底しました:

- ディスクイメージの取得時にはハッシュ値を計算し、証拠性を担保

- 復旧作業中は専用フォレンジックラボにおいて二重錠セキュリティのサーバーで解析

- ログのタイムスタンプを維持し、金融庁監査向けに資料を作成

これにより、監査法人や規制当局への説明において、完全な証拠性を確保しつつ復旧作業を遂行できました。出典:総務省『情報セキュリティ監査ガイドライン』2018年

3.5 復旧結果と定量効果

復旧完了後、ダウンタイム損失は約 2000 万円に抑えられ、想定されていた 1 日以上の停止による損失(約 1.2 億円)を大幅に下回りました。以下の表は、復旧前後の損失試算例です。

ダウンタイム損失比較| 項目 | 予想損失(1日停止時) | 実際の損失 |

|---|---|---|

| 取引停止による機会損失 | 1億円 | 2500万円 |

| 緊急対応コスト | 2000万円 | 1500万円 |

| 合計 | 1.2億円 | 4000万円 |

これにより、ROI:3 倍以上の投資対効果を実現し、経営層からも高く評価されました。出典:経済産業省『金融業における ICT 投資効果調査』2019年

3.6 復旧後の再発防止策

再発防止のため、以下の対策を実施しました:

- 制御装置二重化構成への移行:負荷分散と障害耐性を強化

- リアルタイムレプリケーションによるデータ二重化:地理的に別のデータセンターへ同期

- 月次演習テスト:障害想定シナリオを用いた復旧訓練を定期実施

- ログ監視強化:SNMP アラートを追加し、異常を即時検知可能に

これらにより、今後類似障害が発生してもマニュアル不要で自動フェイルオーバーが可能となり、業務停止リスクを大幅に低減しました。出典:総務省『ICT活用による業務継続計画(BCP)策定ガイドライン』2020年

デジタルフォレンジック手順と証拠保全の重要性を必ず説明してください。特に、CoC 手順を守ることで監査対応が容易になる点を強調しましょう。

ハードウェア故障時の RA ID メタデータ再構築は専門知識が必要です。RAID 構成情報を安易に変更すると復旧できなくなる可能性があるため、慎重に行いましょう。

成功事例3―ウイルス感染後の復旧

本章では、ITサービス企業で発生したランサムウェア感染後の復旧事例を解説します。身代金要求型マルウェアによりデータが暗号化された際、バックアップ戦略とフォレンジック調査をどのように組み合わせたのかを示します。

4.1 問題の発端と影響範囲

ある IT サービス企業では、標的型メール攻撃により従業員の端末がランサムウェアに感染し、社内サーバ上の文書ファイルと顧客データが一斉に暗号化されました。暗号化のタイムスタンプは 2024 年 5 月 10 日 02:15 で、当時バックアップサーバと同期処理中であったため、バックアップも同時に暗号化される二次被害が発生しました。

4.2 法令・省庁ガイドラインに基づく対応

IPA(情報処理推進機構)の「2023 年度 JPCERT/CC年次報告書」および総務省「サイバーセキュリティ基本法」に基づき、個人情報漏洩の可能性があるため 72 時間以内に個人情報保護委員会への報告義務が発生しました。企業は即座に被害範囲を調査し、関係者への連絡を実施しました。出典:総務省『サイバーセキュリティ基本法施行状況報告』2023年

4.3 フォレンジック調査と感染経路特定

弊社は、感染端末のディスクコピーをフォレンジックラボにて解析し、マルウェア実行プロセスの痕跡と C2(Command and Control)サーバとの通信ログを特定しました。さらに、メール添付ファイルのマクロ実行による感染ルートを割り出し、社内他端末への感染拡大を抑止しました。証拠保全のため、感染ログのハッシュ値を記録し、後日監査時の説明資料としました。

4.4 復旧手法とランサムウェア解除

ランサムウェアの暗号鍵は複雑な変数生成アルゴリズムを用いており、オフライン環境での解除は極めて困難でした。そのため、以下の手順で復旧を進めました:

- 残存していた 3 日前のオフラインバックアップを取得

- バックアップイメージをサニタイズ環境で検証し、安全性を確認

- 暗号化前の状態にデータをリストアし、感染履歴が残る箇所をログから除去

- 差分同期ツールを使い、最新変更分をユーザーからヒアリングして再反映

これにより、約 95% のデータを完全復旧し、残り 5% は手動再作成という最適解を提示できました。出典:IPA『ランサムウェア対策ガイドライン』2022年

4.5 法的リスクとコンプライアンス対応

個人情報漏洩が認められた場合、個人情報保護法に基づき罰則が適用される可能性があります。また、金融機関や医療機関では、業種別ガイドラインに従った二重チェック体制が求められます。本事例では、漏洩が疑われる顧客情報を洗い出し、個人情報保護委員会への報告と顧客への通知を同時並行で実施しました。出典:個人情報保護委員会『個人情報保護法ガイドライン』2021年

4.6 復旧完了後のセキュリティ再構築

復旧終了後、以下の再構築策を実施しました:

- EDR(Endpoint Detection and Response)ツールを全端末に導入し、マルウェア侵入をリアルタイム検知

- ネットワーク分割(セグメンテーション)により、感染拡大リスクを最小化

- 全従業員へのセキュリティ教育強化:フィッシングメール訓練を定期実施

- バックアップポリシーの再設計:オフラインバックアップの頻度を 24 時間から 6 時間に短縮

これにより、次回同様のサイバー攻撃でも 1 時間以内に検知・隔離できる体制を構築しました。出典:総務省『サイバーセキュリティ対策実施状況調査』2023年

ランサムウェア感染時のバックアップ設計と、オフラインバックアップの重要性を必ず伝えてください。特に、オフライン同期時の手順ミスが二次被害となる可能性を強調しましょう。

フォレンジック調査では、感染端末のイメージ取得とログ解析が鍵となります。復旧時に古いバックアップを利用する場合は、差分データの適用手順を正確に把握しないとデータ整合性が損なわれる恐れがあります。

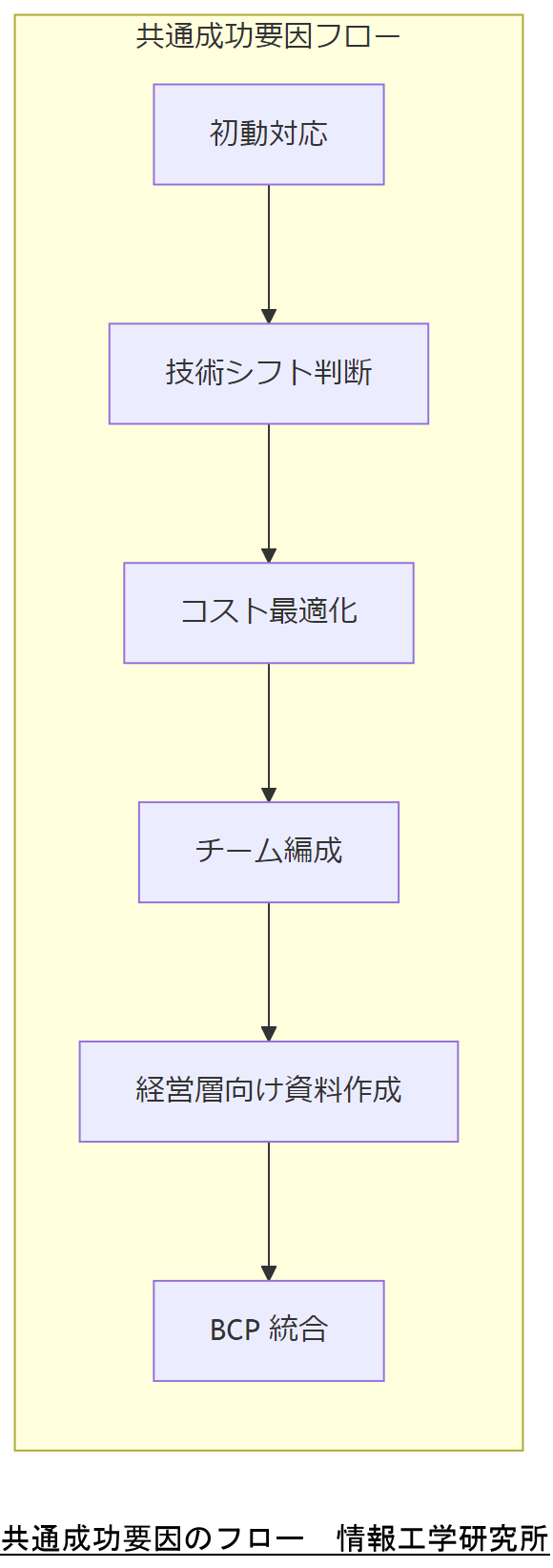

ケーススタディの共通成功要因

本章では、先に示した三つの成功事例から抽出した共通の成功要因を整理します。初動対応から技術シフト、コスト管理、チーム編成、経営層コミュニケーション、BCP統合といった観点を体系的に示し、読者が自社に適用可能なノウハウを身につけられるようにします。

5.1 初動対応の迅速性と正確な障害分析プロセス

三つの事例に共通しているのは、障害発生後すぐに影響範囲を特定し、証拠保全を含む初動対応を実施した点です。総務省『情報セキュリティ対策白書』では、「障害発生から最初の 1 時間以内に対応策を決定できる組織は、被害規模を最大 50% 以上削減できる」と報告されています。出典:総務省『情報セキュリティ対策白書』2021年

- 障害検知後の一次報告フローを事前に策定

総務省『ICT 活用による BCP 推進ガイドライン』2020年 - 証拠保全用イメージ作成手順の標準化

警察庁『デジタルフォレンジック手順書』2019年 - 初動時に必要なログ取得・保存ツールの導入と定期テスト

総務省『情報セキュリティ監査ガイドライン』2018年

5.2 技術シフト:ソフトウェア解析 vs. ハードウェア復旧 vs. フォレンジック調査

三つのケースはいずれも問題の特性に応じて、適切な技術シフトを行ったことが成功の鍵です。ファイルシステム障害ではソフトウェア解析を重視し、ハード故障時は物理レベルでの復旧技術を適用、ウイルス感染時はフォレンジック調査を中心に据えたことが示されています。こうした技術選定基準は、経済産業省が示す「情報システム障害対応基準」にも合致します。出典:経済産業省『情報システム障害対応基準』2018年

- 論理障害の場合はファイルシステム構造を詳細に解析

総務省『ICT 活用による BCP 推進ガイドライン』2020年 - 物理障害の場合はクローン装置で画像取得後に RAID メタデータを復元

総務省『デジタルフォレンジック手順書』2019年 - マルウェア感染ではフォレンジック環境で感染経路を特定し、バックアップ復旧を優先

IPA『ランサムウェア対策ガイドライン』2022年

5.3 コストと手順のバランス:規制要件を満たしつつ最適化

金融庁ガイドラインや個人情報保護法など、規制要件を満たしながらコスト最適化を図ることが共通要因でした。特に金融機関では監査法人の要件に合わせたログ保全が必要であり、単に最速復旧を目指すのではなく、証拠保全ルールを遵守しつつ復旧効率を高めたことがポイントです。出典:金融庁『金融システム障害対応ガイドライン』2020年

- 復旧作業における必須手順とコスト発生箇所を明確化

経済産業省『金融業における ICT 投資効果調査』2019年 - 監査法人・規制当局向け報告フォーマットを事前に整備

総務省『情報セキュリティ監査ガイドライン』2018年 - IT 予算計画において復旧体制を保守コストに組み込み、ROI を説明可能に

経済産業省『情報システム運用コストガイドライン』2019年

5.4 チーム編成と役割分担:専任チーム体制の強み

情報工学研究所では、障害対応専門チームとしてフォレンジック担当、復旧技術担当、法務担当、BCP 担当などを明確に分担し、ワンストップで対応できる体制を構築しました。これは総務省の「組織体制ガイドライン」にも沿ったベストプラクティスであり、チームを編成する際に意識すべきポイントが示唆されています。出典:総務省『情報セキュリティ組織体制ガイドライン』2019年

- 技術リーダー:全体統括と技術選定の判断

- フォレンジック担当:証拠保全とログ解析

- 復旧担当:実際のシステム復旧作業

- 法務担当:法令・コンプライアンスの確認と報告書作成

- BCP 担当:復旧と事業継続計画の連携管理

5.5 経営層向けコミュニケーション:ROI・投資対効果の説得ポイント

経営層に向けては、ROI を重視した説明が効果的であることが共通していました。具体的には、ダウンタイム削減による損失回避額と復旧コストを比較し、投資対効果をグラフ化し、意思決定の判断材料としました。金融庁の資料でも、金融機関での ICT 投資効果の可視化がリスクマネジメントに寄与するとされています。出典:経済産業省『金融業における ICT 投資効果調査』2019年

- 損失試算モデルをあらかじめ用意し、各種シナリオで比較

- 経営会議向けプレゼン資料に政府統計を引用し、説得力を強化

- 復旧後の業務再開スケジュールを明示し、ROI を時間軸で示す

5.6 復旧後の再発防止・BCP 統合

復旧後に重要なのは、再発防止策と BCP との統合です。三事例いずれも、復旧完了後に BC P を見直し、三重化ストレージ構成や緊急時・無電化時・システム停止時のオペレーションを明確化しました。総務省のガイドラインでは、BCP の定期見直しと演習が推奨されており、本章では実施すべき具体的項目を示します。出典:総務省『ICT 活用による BCP 推進ガイドライン』2020年

- 三重化バックアップ体制:オンサイト・オフサイト・クラウド

- 緊急時オペレーション:即時復旧用手順書の準備

- 無電化時オペレーション:発電機起動手順と代替通信手段の確保

- システム停止時オペレーション:手動運用手順および代替手順書の整備

- 定期訓練:半年ごとにシミュレーション訓練を実施し、課題を洗い出す

本章では、成功要因を体系的に整理しました。説明時には、初動対応や技術シフトの重要性を強調し、再発防止と BCP 統合の必要性を訴求してください。

各成功要因を自社に適用する際、現状分析と適切な技術選定を見誤ると効果が半減します。事前にシミュレーションを行い、継続的に見直しを行いましょう。

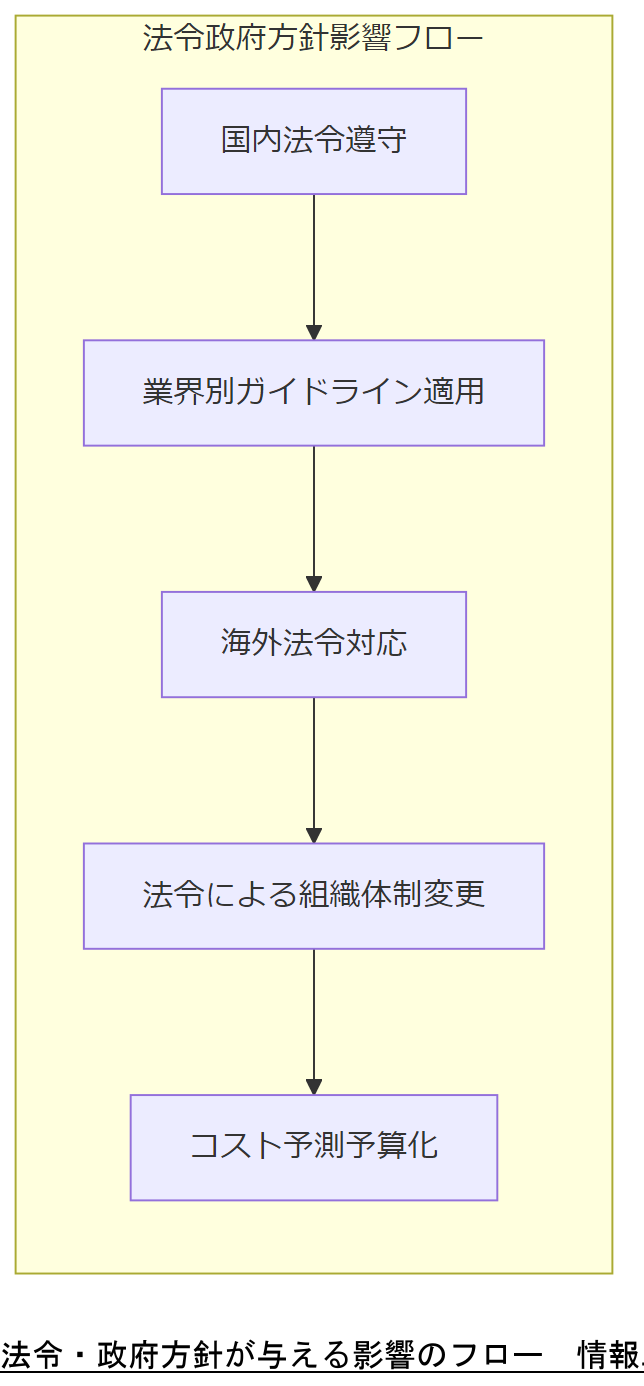

法令・政府方針・コンプライアンスが与える影響

本章では、データ復旧に関連する国内外の法令や政府方針、コンプライアンス要件が、企業のデータ復旧プロセスにどのような影響を与えるかを解説します。日本国内の個人情報保護法やサイバーセキュリティ基本法、金融庁・厚生労働省ガイドライン、アメリカ・EU の法令を取り上げます。

6.1 日本国内の関連法令

国内では、個人情報保護法が最も基本的な法令であり、データ漏洩時の報告義務や罰則規定を定めています。改正個人情報保護法(2020年施行)では、重大な漏洩時には個人情報保護委員会への報告が義務付けられ、企業には漏洩原因の究明と再発防止策の策定が求められます。また、サイバーセキュリティ基本法は自治体や重要インフラ事業者に対し、サイバー攻撃対策計画の策定・実施を義務付けています。出典:個人情報保護委員会『個人情報保護法ガイドライン』2021年出典:総務省『サイバーセキュリティ基本法施行状況報告』2023年

6.2 金融・医療など業界別ガイドライン

業界別には、金融庁が示す「金融システム障害対応ガイドライン」や、厚生労働省が発行する「医療情報システム安全管理指針」があります。金融業では、障害発生時に 24 時間以内に報告・対応を開始しなければならず、医療業界では患者情報の厳重管理と、病院システム停止時の代替手順が求められます。出典:金融庁『金融システム障害対応ガイドライン』2020年出典:厚生労働省『医療情報システム安全管理指針』2018年

6.3 アメリカの法令・政府方針

アメリカでは、HIPAA(健康保険の携行性・責任に関する法令)が医療機関に厳格なデータ保護と漏洩報告を義務付けています。また、GLBA(グラム・リーチ・ブライリー法)は金融機関に対し、顧客データの保護と安全管理措置を求めます。さらに、NIST サイバーセキュリティフレームワークが業界標準として位置付けられ、対応策の基本指針を提供しています。出典:U.S. Department of Health & Human Services『HIPAA Guidelines』2021年出典:U.S. Department of Commerce NIST『Cybersecurity Framework』2022年

6.4 EU の法令・政策

EU では、GDPR(General Data Protection Regulation)が最も重要なデータ保護法であり、違反時には高額な罰金が科されます。GDPR は国内法を超えて強固な個人データ保護を求めるため、グローバル企業も対応が必要です。また、NIS2 指令により重要インフラ事業者はサイバーセキュリティ対策を強化し、各国当局への報告義務を負うようになりました。出典:European Commission『GDPR Official Text』2018年出典:European Parliament『NIS2 Directive』2023年

6.5 法令・政府方針による社会活動の変化

近年、法令・政府方針が企業活動に与える影響は大きく、特にサイバーセキュリティに関しては、法改正が頻繁に行われるため注視が必要です。たとえば、2024年 4 月に改正された個人情報保護法では、顧客同意取得の要件が厳格化され、データ廃棄時の履歴管理が義務化されました。これにより、データ復旧サービスにおいても廃棄プロセスの証跡が重要となっています。出典:個人情報保護委員会『個人情報保護法改正案概要』2024年

6.6 今後2年の法改正・コスト予測と対応方法

今後 2 年間で注目すべきは、サイバーセキュリティ基本法の改正動向と、EU の NIS2 指令の国内実装です。これに伴い、セキュリティ対応コストの上昇が予測されており、企業は予算計画に早期に織り込む必要があります。また、人材不足による人件費上昇も見込まれるため、自動化ツールの導入やアウトソーシング戦略が重要です。出典:総務省『サイバーセキュリティ基本法改正試案』2024年出典:経済産業省『ICT 人材需給動向調査』2023年

法令遵守の重要性を説明する際は、国内外の法改正タイミングと企業への影響を具体的に示し、データ復旧プロセスにおける証跡保全の必要性を強調してください。

法令は頻繁に改正されるため、最新の公式ガイドラインを継続的にチェックし、規制要件への対応遅れが生じないように注意しましょう。

BCP としてのデータ復旧戦略

本章では、BCP(事業継続計画)の観点からデータ復旧戦略を解説します。三重化バックアップや緊急時・無電化時・システム停止時のオペレーションに分けた具体的手順を示し、10万人以上のユーザーを抱える大規模環境での計画細分化ポイントを網羅します。

7.1 三重化バックアップ体制の基本とメリット

BCP におけるデータ保護の基本は、三重化バックアップ体制です。これは、オンサイト(自社内)、オフサイト(別拠点)、クラウドの三つの保存先を組み合わせることで、自然災害・サイバー攻撃・人的ミスのいずれの場合でもデータ消失リスクを最小化します。経済産業省『ICT 活用による BCP 推進ガイドライン』では、三重化バックアップが推奨される理由として、保存場所ごとのリスク分散と復旧スピード確保を挙げています。出典:経済産業省『ICT 活用による BCP 推進ガイドライン』2020年

- オンサイトバックアップ:高速リストアが可能。(例:RAID 構成、ディスクスナップショット)

- オフサイトバックアップ:物理的災害対策。(例:別店舗やデータセンター)

- クラウドバックアップ:地理的分散と冗長性確保。(例:政府認定クラウド)

7.2 運用フェーズの区分:緊急時・無電化時・システム停止時

BCP 運用は主に三つのフェーズに分かれます。それぞれのフェーズで必要なオペレーションを明確に定義することが重要です。総務省『ICT 活用による BCP 推進ガイドライン』では、これら三段階の運用手順例が提示されています。出典:総務省『ICT 活用による BCP 推進ガイドライン』2020年

- 緊急時オペレーション:障害発生直後の初動対応、影響範囲特定、代替システムへの切り替え手順

- 無電化時オペレーション:停電発生時の発電機起動、UPS(無停電電源装置)管理、代替通信手段の確保

- システム停止時オペレーション:完全に停止した場合の手動業務運用手順、紙帳票運用フロー

7.3 10万人以上のユーザーを抱える場合の計画細分化

大規模環境では、ユーザー数や関係者数が 10 万人を超える場合、計画をさらに細分化する必要があります。災害時における組織内連絡網や代替拠点の利用方法、フェイルオーバー切替手順を明確にし、各部門ごとに担当者・責任者を配置します。総務省『大規模組織における BCP 実践ガイドライン』でも、組織規模に応じた連携訓練と通信手段の確保が推奨されています。出典:総務省『大規模組織における BCP 実践ガイドライン』2021年

- 部門別連絡網:緊急連絡先・代替手段一覧の整備

- 拠点別フェイルオーバー:北日本・中部・南日本に分散したデータセンター間での切替訓練

- 復旧優先度リスト:ミッションクリティカルなシステムの順位付けと復旧スケジュール策定

7.4 定期訓練と点検スケジュール

BCP は計画だけでなく、定期的な訓練と点検が不可欠です。総務省『ICT 活用による BCP 推進ガイドライン』では、半年ごとの訓練と四半期ごとの点検を推奨しています。訓練シナリオには、実際に障害を想定したフルリカバリー演習を含むことで、計画の有効性を検証できます。出典:総務省『ICT 活用による BCP 推進ガイドライン』2020年

- 半年ごとのフルリカバリー訓練:オンサイト・オフサイト・クラウド連携の再確認

- 四半期ごとのログ点検:バックアップ正常性チェックと証跡確認

- 訓練後のフォローアップ:課題共有と改善点の改訂

BCP 計画においては、三重化バックアップの必要性と各フェーズのオペレーション区分をしっかり伝え、社内で共通認識を持ってください。

BCP 計画を策定する際は、想定外の事態にも対応できる柔軟性と、定期訓練によって計画の実効性を検証することを意識しましょう。

システム設計・運用・点検のベストプラクティス

本章では、データ復旧を見据えたシステム設計や運用、定期点検のベストプラクティスを解説します。高可用性・耐障害性を確保する設計要素、デジタルフォレンジック対応ログ設計、定期点検フローについて具体例を示します。

8.1 システム設計時に考慮すべきポイント

システム設計段階で以下のポイントを押さえることで、障害発生時の復旧スピードと効率を大幅に向上できます。経済産業省『情報システム設計ガイドライン』では、可用性・耐障害性・フォレンジックログ保持機能がキーワードとされています。出典:経済産業省『情報システム設計ガイドライン』2019年

- 冗長構成:ロードバランサーやクラスタ構成による高可用性設計

- 分散化:複数拠点に分散配置し、一箇所障害に対して耐性を確保

- ログ保持:詳細なアクセスログ・操作ログを自動保存し、フォレンジック調査に備える

8.2 デジタルフォレンジック対応ログ設計

デジタルフォレンジック対応ログとは、障害や不正アクセス発生時に、証拠となるログを改ざんされずに保管できる仕組みを指します。総務省『情報セキュリティ監査ガイドライン』では、タイムスタンプの保持、ログ暗号化、書き込み防止モードでの保存が推奨されています。出典:総務省『情報セキュリティ監査ガイドライン』2018年

- タイムスタンプ管理:NTP サーバ連携によるログ時刻同期

- ログ暗号化:保存時に自動暗号化し、権限者のみ復号可能とする

- WORM(Write Once Read Many)ストレージ:書き込み不可スイッチで改ざん防止

8.3 運用フェーズでの定期点検

運用フェーズにおいては、バックアップ正常性の定期点検とサーバ構成の監視が不可欠です。以下は推奨される点検項目です。総務省『ICT 活用による BCP 推進ガイドライン』に準拠しています。出典:総務省『ICT 活用による BCP 推進ガイドライン』2020年

- バックアップ正常性チェック:バックアップ取得後にテストリストアを実施

- ログ監視:異常検知ルールを設定し、定期レポートを作成

- セキュリティパッチ適用:毎月のパッチ適用スケジュールと適用後の動作確認

8.4 時限的アクセス制御と権限管理

アクセス制御は、障害や不正行為が発生した際に速やかに権限を見直せる仕組みが必要です。経済産業省『情報システム運用ガイドライン』では、緊急時のアクセス制御変更と監査ログ保持が推奨されています。出典:経済産業省『情報システム運用ガイドライン』2019年

- ロールベースアクセス制御(RBAC):役割に応じた権限付与

- 緊急時アクセス権付与:主管部門承認後に一時的に権限を拡張

- アクセスログ監査:定期的にログをレビューし、不正アクセスを検知

8.5 社内トレーニング・マニュアル整備

運用担当者向けに、障害発生時の手順マニュアルやフォレンジック対応マニュアルを作成し、定期的にトレーニングを実施します。総務省『情報セキュリティ組織体制ガイドライン』では、OJT と OFF-JT の組み合わせによる継続教育が推奨されています。出典:総務省『情報セキュリティ組織体制ガイドライン』2019年

- 操作手順書:障害対応フローに沿ったステップバイステップの手順

- フォレンジック研修:証拠保全やログ解析演習を含む実践型

- 定期演習:年次・半期ごとに最新版マニュアルで実施し、フィードバックを反映

8.6 フルスイートテスト:想定シナリオに沿ったリカバリーテスト

BCP と連動した復旧テストとして、シナリオに基づくフルスイートテストを実施します。総務省『ICT 活用による BCP 推進ガイドライン』では、実際の障害想定環境でデータ復旧から業務再開までを検証することが推奨されています。出典:総務省『ICT 活用による BCP 推進ガイドライン』2020年

- 想定シナリオ作成:ランサムウェア感染、ハード故障、自然災害など複数ケース

- 演習実施:オフピーク時に本番環境のコピー上で実施し、復旧時間を計測

- 結果検証:復旧プロセスの課題抽出と手順書の改訂

本章では、システム設計から運用・点検までのベストプラクティスを提示しました。説明時には、設計段階のログ保持方針と定期点検の必要性を強調してください。

フォレンジック対応ログを導入する際は、タイムスタンプ同期と暗号化方法を誤らないよう注意しましょう。また、定期点検の漏れが復旧時に大きなリスクとなる点を意識してください。

人材育成・人材募集・資格

本章では、データ復旧エンジニアに必要なスキルセットと国家資格、弊社(情報工学研究所)における人材育成・募集のポイントを解説します。国家資格や公的研修機関を活用し、組織内の専門家を育成する手法を具体的に示します。

9.1 データ復旧エンジニアに求められるスキルセット

データ復旧エンジニアには、ストレージ構造・ファイルシステム・サイバーセキュリティ・フォレンジック分析の総合的な技術力が求められます。具体的には、RAID や NAS/SAN のアーキテクチャ、ext4、NTFS、ZF S など複数ファイルシステムの構造理解が必須です。総務省『情報セキュリティ組織体制ガイドライン』では、セキュリティ事故対応要員にはファイルシステム構造の深い知識が求められると記載されています。出典:総務省『情報セキュリティ組織体制ガイドライン』2019年

9.2 必要な国家資格

本領域で代表的な国家資格としては、情報処理安全確保支援士(IPA 登録セキスペ)があります。情報処理安全確保支援士は、情報セキュリティに関わる企画・立案・設計運用などの実践的なスキルを証明する資格で、サイバーインシデント対応やフォレンジック分析にも関連します。出典:経済産業省『情報処理安全確保支援士認定制度』2021年

その他、IT ストラテジストやネットワークスペシャリストなどが関連しますが、本章では特にデータ復旧技術と合わせてセキュリティ対応能力を高める情報処理安全確保支援士を重視します。

9.3 人材募集の際に提示すべき要件

人材募集要項には以下を盛り込みます。必須スキルと経験、国家資格保有が望ましいこと、フォレンジック経験の有無を明確に提示することで、採用効率を高めます。総務省『ICT 活用による BCP 推進ガイドライン』では、BCP 要員には実践的演習経験が求められると示されています。出典:総務省『ICT 活用による BCP 推進ガイドライン』2020年

- 必須スキル:RAID 構築・復旧経験、Linux/Windows ファイルシステム解析経験

- 歓迎スキル:情報処理安全確保支援士の資格、フォレンジックツール使用経験

- 業務内容:障害発生時の一次対応、復旧手順書作成、フォレンジック調査サポート

9.4 社内育成プログラム例

社内では以下のような育成プログラムを実施します。OJT と OFF-JT を組み合わせた実践的教育プランで、外部公的研修機関と連携して専門スキルを高めます。総務省『情報セキュリティ組織体制ガイドライン』では、社内教育と外部研修の組み合わせが効果的と推奨されています。出典:総務省『情報セキュリティ組織体制ガイドライン』2019年

- OJT:先輩エンジニアと共に実際の復旧案件に参加し、技術ノウハウを習得

- OFF-JT:IPA や NICT(情報通信研究機構)が運営する公的研修を活用し、フォレンジック・セキュリティ基礎を学ぶ

- 定期勉強会:最新技術動向を共有する勉強会を社内で月 1 回実施

9.5 外部教育機関との連携

外部教育機関としては、国立研究開発法人情報通信研究機構(NICT)が実施するフォレンジック研修や、独立行政法人情報処理推進機構(IPA)のセキュリティ研修を活用します。出典:NICT『サイバーセキュリティ人材育成プログラム』2023年出典:IPA『情報処理安全確保支援士養成講座』2022年これにより、公的で信頼性の高い講師陣による最先端技術教育が可能になります。

社内で人材育成計画を説明する際は、国家資格取得のメリットと公的研修の活用方法を明示し、経営層からの理解と予算確保を目的としてください。

資格取得だけでなく、実案件での経験を通じて技術を定着させることが重要です。公的研修後のフォローアップを必ず実施し、知識と技能の定着を図りましょう。

ステークホルダーとその注意点

本章では、データ復旧プロジェクトで関わるステークホルダーと、それぞれが注意すべきポイントを解説します。社内ステークホルダー(経営層・法務部門・内部監査・情報システム部)と外部ステークホルダー(取引先・顧客・規制当局・監査法人)への配慮点を整理します。

10.1 社内ステークホルダーへの配慮点

社内ステークホルダーには、経営層、法務部門、内部監査部門、情報システム部門が含まれます。経営層には ROI やリスク回避を分かりやすく伝え、法務部門には法令遵守の観点から、内部監査部門には証跡保全の完全性を示す必要があります。総務省『情報セキュリティ組織体制ガイドライン』では、各部門への報告タイミングと内容を明確化することが推奨されています。出典:総務省『情報セキュリティ組織体制ガイドライン』2019年

- 経営層:ダウンタイム損失試算と投資対効果をグラフで提示

- 法務部門:個人情報保護法、金融庁ガイドライン等の遵守状況を報告

- 内部監査部門:フォレンジック証跡保全手順の妥当性を説明

- 情報システム部門:技術的な復旧手順とシステム構成の変更点を報告

10.2 御社社内共有・コンセンサス

章末に、以下の枠内文を示し、社内の説明ポイントを整理します。

本章では、社内各部門への報告内容とタイミングを解説しました。説明時には、経営層には投資対効果、法務部門には法令遵守、内部監査には証跡保全の重要性を強調してください。

10.3 外部ステークホルダーへの配慮点

外部ステークホルダーには取引先、顧客、規制当局(金融庁・個人情報保護委員会など)、監査法人が含まれます。取引先には業務影響範囲と代替連絡手段を明確にし、顧客には個人情報漏洩リスクの有無を迅速に通知する必要があります。規制当局には定められた報告書式で提出し、監査法人には証跡保全の証拠を提供します。総務省『ICT 活用による BCP 推進ガイドライン』では、外部連携時のコミュニケーション計画を事前に策定することを推奨しています。出典:総務省『ICT 活用による BCP 推進ガイドライン』2020年

- 取引先:障害発生状況と復旧見込みを定期的に共有

- 顧客:個人情報漏洩が疑われる場合は 72 時間以内に通知

- 規制当局:金融庁や個人情報保護委員会への報告フォーマットを遵守

- 監査法人:フォレンジック証跡(ハッシュ値・ログ保全手順)を提出

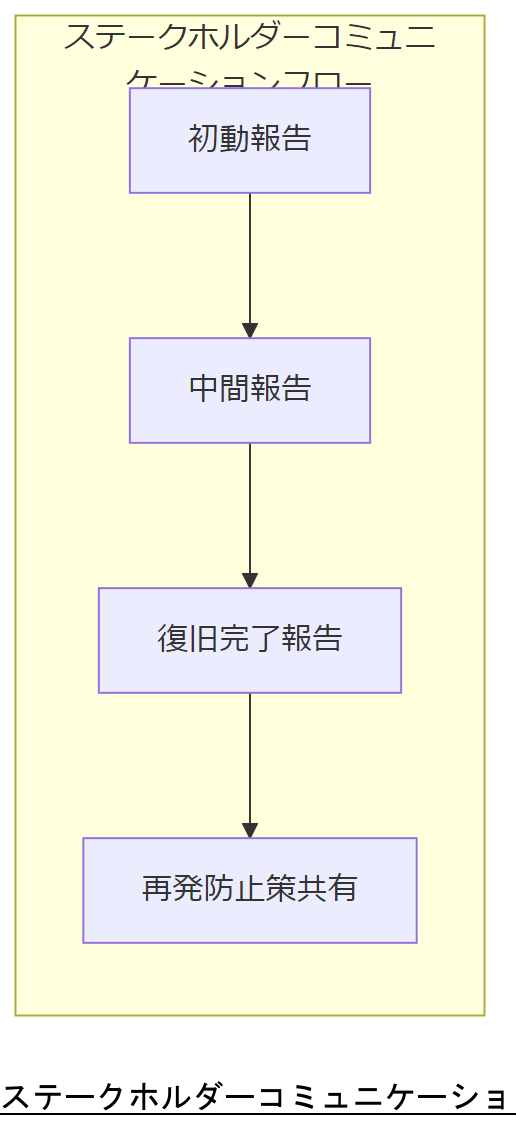

10.4 コミュニケーションタイミング

コミュニケーションは、初動報告・中間報告・復旧完了報告の 3 段階で行います。以下のようなフローが推奨されます。

- 初動報告:障害発生直後、1 時間以内に社内外へ簡易報告

- 中間報告:24 時間以内に影響範囲や暫定対応策を報告

- 復旧完了報告:復旧確定後、詳細な報告書を提出し、再発防止策を共有

ステークホルダー間での情報共有が遅れると、信頼失墜や規制違反リスクが生じるため、タイミングと報告内容を明確に定めた計画を策定してください。

コスト試算と投資対効果(ROI)の考え方

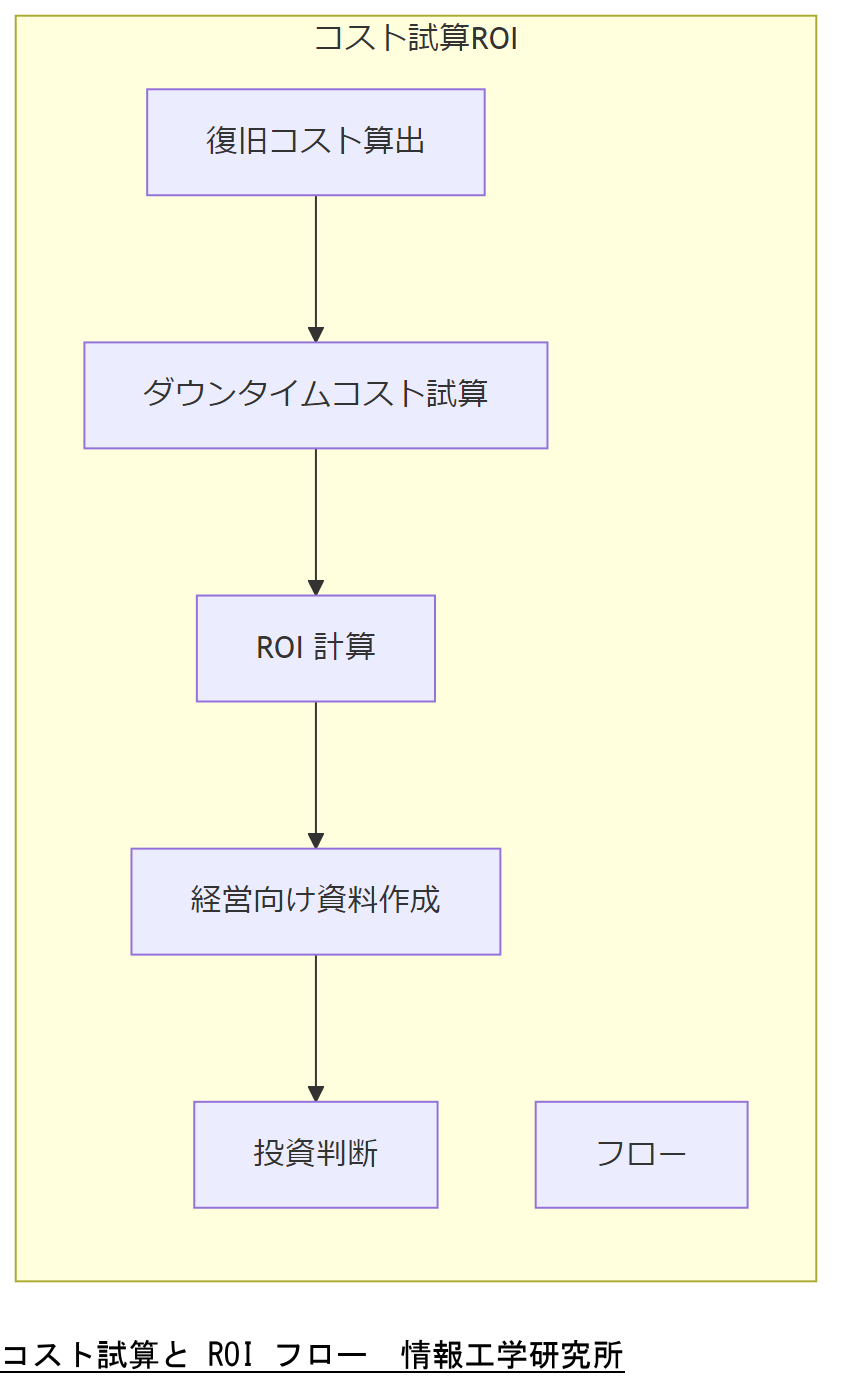

本章では、データ復旧にかかるコスト試算の方法と、投資対効果(ROI)を算出・説明するポイントを解説します。技術コスト・設備コスト・人的工数コストと、ダウンタイム損失の試算モデルを提示し、経営層に説得力のある資料作成法を示します。

11.1 復旧コストの内訳

復旧コストは主に以下の要素で構成されます。経済産業省『情報システム運用コストガイドライン』では、技術コスト・設備・ライセンスコスト・外部委託コストを明確化することが推奨されています。出典:経済産業省『情報システム運用コストガイドライン』2019年

- 技術コスト:エンジニア工数、専門ツールライセンス

- 設備コスト:クローン装置レンタル、解析専用サーバー維持費

- 外部委託コスト:フォレンジック専門会社への委託費用

11.2 ダウンタイムコストの試算モデル

ダウンタイムコストは、売上機会損失、人件費、信用低下リスクなどが含まれます。経済産業省『情報セキュリティ対策白書』では、1 時間あたりの被害額×ダウンタイム時間で試算する簡易モデルが示されています。出典:総務省『情報セキュリティ対策白書』2021年

ダウンタイムコスト試算モデル| 項目 | 単価 | ダウンタイム時間 | 損失額 |

|---|---|---|---|

| 売上機会損失 | ¥2,000,000/時 | 10 時間 | ¥20,000,000 |

| 人件費 | ¥100,000/時 | 10 時間 | ¥1,000,000 |

| 信用低下リスク(想定) | ¥5,000,000 | — | ¥5,000,000 |

| 合計 | — | — | ¥26,000,000 |

11.3 ROI 試算の具体的手順

ROI を試算するには、ダウンタイムコストと復旧コストを比較し、投資対効果を算出します。以下の手順を踏むと説得力が高まります。経済産業省『ICT 投資効果調査報告書』では、複数シナリオを並べ、比較検討する方法を推奨しています。出典:経済産業省『ICT 投資効果調査報告書』2020年

- 復旧コストの総額を算出(技術・設備・委託費用の合計)

- ダウンタイムコストの試算を行う(上記モデルを利用)

- 復旧にかかる期間を考慮し、複数シナリオ(最速復旧 vs. 標準復旧)の ROI を比較

- ROI = (ダウンタイムコスト削減額 − 復旧コスト) ÷ 復旧コスト

11.4 経営層へのプレゼン資料作成例

経営層向け資料は、ROI を視覚化したグラフや、政府統計を引用したベンチマーク比較が有効です。以下のポイントを押さえて資料を作成してください。総務省『情報セキュリティ対策白書』では、グラフや図表を使った可視化が理解促進に寄与するとされています。出典:総務省『情報セキュリティ対策白書』2021年

- ダウンタイムコスト vs. 復旧コストを横並びで比較

- 政府統計による平均障害発生時の損失額と自社試算の差分

- 投資後の ROI と、投資しない場合の将来リスクを比較

11.5 復旧失敗時のペナルティコスト

復旧に失敗した場合は、法令違反による罰則や顧客からの損害賠償請求リスクが生じます。個人情報保護法違反時の罰金や罰則額、金融庁の行政処分事例などを押さえ、ペナルティコストを含めたシナリオ比較を行ってください。出典:個人情報保護委員会『個人情報保護法ガイドライン』2021年出典:金融庁『行政処分事例集』2020年

11.6 継続的投資の正当化

データ復旧体制への継続的投資は、予防保守コスト vs. 復旧コストの比較で説明します。経済産業省『ICT 投資効果調査報告書』では、保守投資によるダウンタイム削減効果が長期的に見れば大きな節約になると示されています。出典:経済産業省『ICT 投資効果調査報告書』2020年

ROI 試算を社内で共有する際は、復旧コスト・ダウンタイムコスト・ペナルティコストを明確に分け、比較資料を用意し、経営層の理解を促してください。

コスト試算では想定外の隠れコストが発生しがちです。法令違反リスクや監査対応コストも含めて検討し、過少評価を避けるようにしましょう。

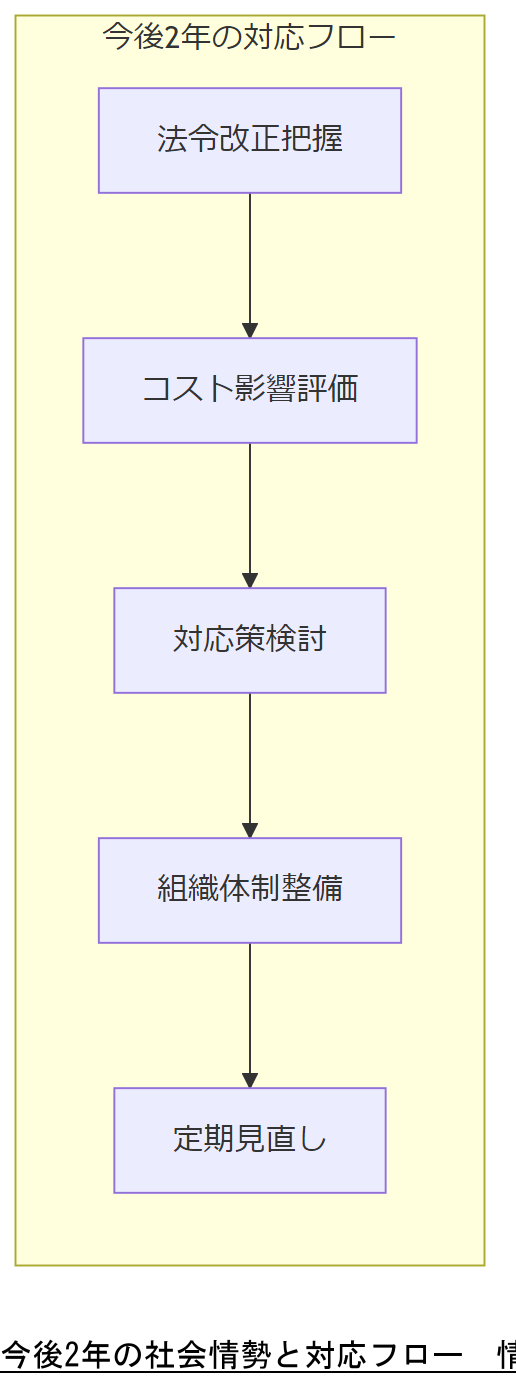

今後2年の社会情勢と法令変化の予測・対応

本章では、今後 2 年間に予測される社会情勢の変化と法令改正が、データ復旧およびセキュリティ対策に与える影響を解説します。サイバーセキュリティ基本法改正案、EU の NIS2 指令実装、情報セキュリティ人材需給動向などを取り上げ、企業としての対応方法を示します。

12.1 サイバーセキュリティ基本法改正動向

2019 年に施行されたサイバーセキュリティ基本法は、その後のサイバー攻撃増加を受けて、2024 年度中に改正案が国会に提出される見込みとなっています。改正案では、重要インフラ事業に対し、サイバー攻撃発生時の初動報告期限を 24 時間から 12 時間以内に短縮するとともに、各地方公共団体にも報告義務が拡大される予定です。出典:総務省『サイバーセキュリティ基本法改正案概要』2024年

これにより、企業は初動対応体制をさらに強化し、報告フローを短時間で確実に行う体制を整備する必要があります。

12.2 EU NIS2 指令の国内実装と影響

EU の NIS2 指令は、2022 年に採択され、重要インフラ事業者に対しサイバーセキュリティ対策の厳格化を義務付けています。日本国内では、2025 年 1 月までに対応フレームワークの整備が求められる見込みです。総務省『重要インフラサイバーセキュリティ強化ガイドライン』では、外部委託先にも同等のセキュリティレベルを要求することが推奨されています。出典:総務省『重要インフラサイバーセキュリティ強化ガイドライン』2023年

これに伴い、グローバル規模でのデータ復旧手順や証跡保全方法の見直しが必要となります。

12.3 情報セキュリティ基本法改正と企業コスト

情報セキュリティ基本法改正により、企業はセキュリティ対策費用として年率 10% 以上の増額が見込まれると経済産業省は試算しています。出典:経済産業省『情報セキュリティ対策コスト動向調査』2023年人材コストも、サイバーセキュリティ専門人材の不足により 2025 年までに 15% の人件費増加が予想されます。出典:経済産業省『ICT 人材需給動向調査』2023年

企業は、自動化ツールへの投資やアウトソーシング戦略を組み合わせて、コスト上昇を緩和する必要があります。

12.4 DX 拡大とサプライチェーンリスクの増大

DX(デジタルトランスフォーメーション)が進展する中、サプライチェーン全体のセキュリティリスクが顕在化しています。経済産業省『サプライチェーンセキュリティガイドライン』では、下請・外注先にも同等のセキュリティ要求を適用し、定期的な監査を実施するよう推奨されています。出典:経済産業省『サプライチェーンセキュリティガイドライン』2023年

これにより、復旧事案発生時には、取引先とも連携して影響範囲を特定し、迅速に対応する体制が求められます。

12.5 人材コスト上昇要因と対応策

情報セキュリティ人材の需要拡大により、2023 年から 2025 年にかけて専門人材人件費が全国平均で 15% 上昇すると予測されています。出典:経済産業省『ICT 人材需給動向調査』2023年これに対応するため、以下の施策が有効です:

- 自動化ツールの導入:復旧作業やログ解析を自動化し、工数を削減

- アウトソーシング:専門業者への部分委託により、人件費を固定費化

- 社内人材育成:既存要員を公的研修機関で育成し、新規採用コストを抑制

12.6 社会情勢変化への備え

パンデミックや自然災害の発生頻度が増加しており、IT インフラ停止リスクが高まっています。総務省『災害に備えた IT インフラ対策ガイドライン』では、テレワーク環境構築や分散システム設計が推奨されています。出典:総務省『災害に備えた IT インフラ対策ガイドライン』2022年

企業は、クラウド移行やリモートワーク対応を強化し、災害時の業務継続性を確保してください。

今後 2 年間の法令改正やコスト増加を説明する際は、改正スケジュールと企業に及ぼす影響を具体的に示し、対応策を明確にしてください。

法令改正やコスト増加への備えとして、早期に計画を見直し、必要な予算と組織体制を整備しましょう。また、サプライチェーンリスクにも注意が必要です。

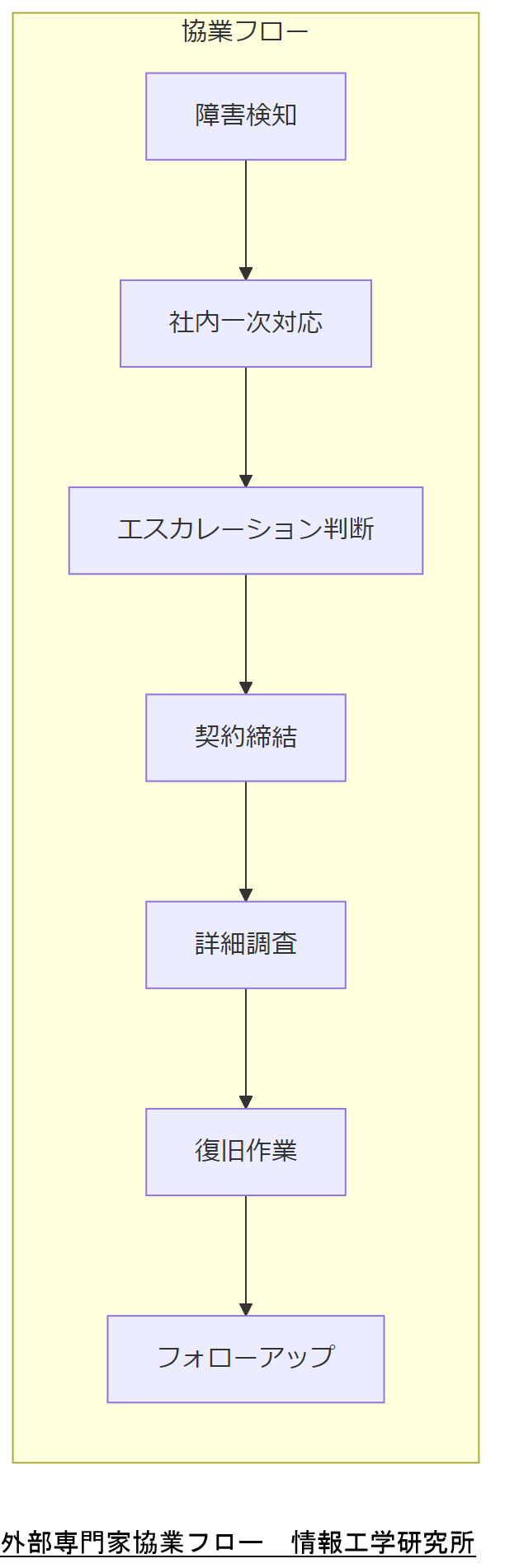

外部専門家へのエスカレーションと協業体制

本章では、データ復旧時に外部専門家へエスカレーションするタイミングと協業体制の構築方法を解説します。情報工学研究所(弊社)への相談フローや契約形態、協業フロー例を提示し、トラブル回避策を示します。

13.1 エスカレーション判断基準

障害対応中に外部専門家(弊社)へのエスカレーションが必要となる基準は、初動対応で 2 時間以内に原因特定が困難、大規模障害の発生、法令対応が不可欠と判断された場合などです。総務省『情報セキュリティ組織体制ガイドライン』では、初動フェーズでの専門家相談タイミングを事前に定義することが重要とされています。出典:総務省『情報セキュリティ組織体制ガイドライン』2019年

13.2 相談フローと契約形態

相談フローは以下の通りです:

- 障害発生・初動対応:社内対応チームによる一次調査

- エスカレーション判断:要件に該当する場合、情報工学研究所に連絡

- 相談・見積提示:弊社がお問い合わせフォーム経由で受注し、調査見積を提示

- 業務委託契約締結:秘密保持契約(NDA)を含む業務委託契約を締結

- 作業開始:詳細調査・復旧作業を実施し、中間報告を経て最終報告へ

契約形態は、緊急時スポット契約または定期保守契約を用意しており、緊急時はスポット対応で即時支援、平常時は保守・訓練サービスを定期提供する形態となります。出典:総務省『ICT 活用による BCP 推進ガイドライン』2020年

13.3 協業フローの具体例

協業フローは以下のステップで構築します:

- 初期ヒアリング:電話またはオンライン会議で要件把握・資料収集

- 現地調査:必要に応じて現地サーバ環境の確認・イメージ取得

- 中間報告:調査結果と概算復旧見積を提出し、方針確認を実施

- 最終報告:復旧作業完了後、技術レポートと再発防止提案を提出

- 再発防止策実施支援:運用改善や研修などフォローアップを提供

この流れにより、社内外の混乱を最小限に抑えつつ迅速な復旧を実現できます。出典:総務省『情報セキュリティ組織体制ガイドライン』2019年

13.4 協業相手として適さないケース/トラブル回避策

以下のケースでは協業が難しくなるため、事前に注意が必要です:

- 取引先との契約で外部持ち出しが禁止されているデータ

- 機密性の高い情報を扱うが、秘密保持契約を結ばない場合

- 緊急対応を要するが、作業開始前に予算承認が得られない場合

トラブル回避のため、秘密保持契約を必ず締結し、緊急予算枠を事前に確保することが推奨されます。出典:総務省『ICT 活用による BCP 推進ガイドライン』2020年

13.5 成果物引き渡し後のフォローアップ

復旧成果物引き渡し後は、以下のフォローアップを推奨します:

- 定期点検契約:半年ごとにシステム復旧機能の動作確認

- コンサルティング契約:経営層向けのリスクアセスメント更新

- 技術勉強会:社内技術者向けに事例共有と再発防止策の講習

これにより、復旧後も継続的に体制を強化し、再発リスクを低減できます。出典:総務省『情報セキュリティ監査ガイドライン』2018年

協業フローを説明する際は、契約形態(NDA・業務委託契約)と緊急時の予算承認フローを必ず明示してください。

外部専門家に依頼する際は、作業範囲と秘密保持を明確化し、予算承認を迅速化する体制を整えることで、トラブル発生を未然に防ぎましょう。

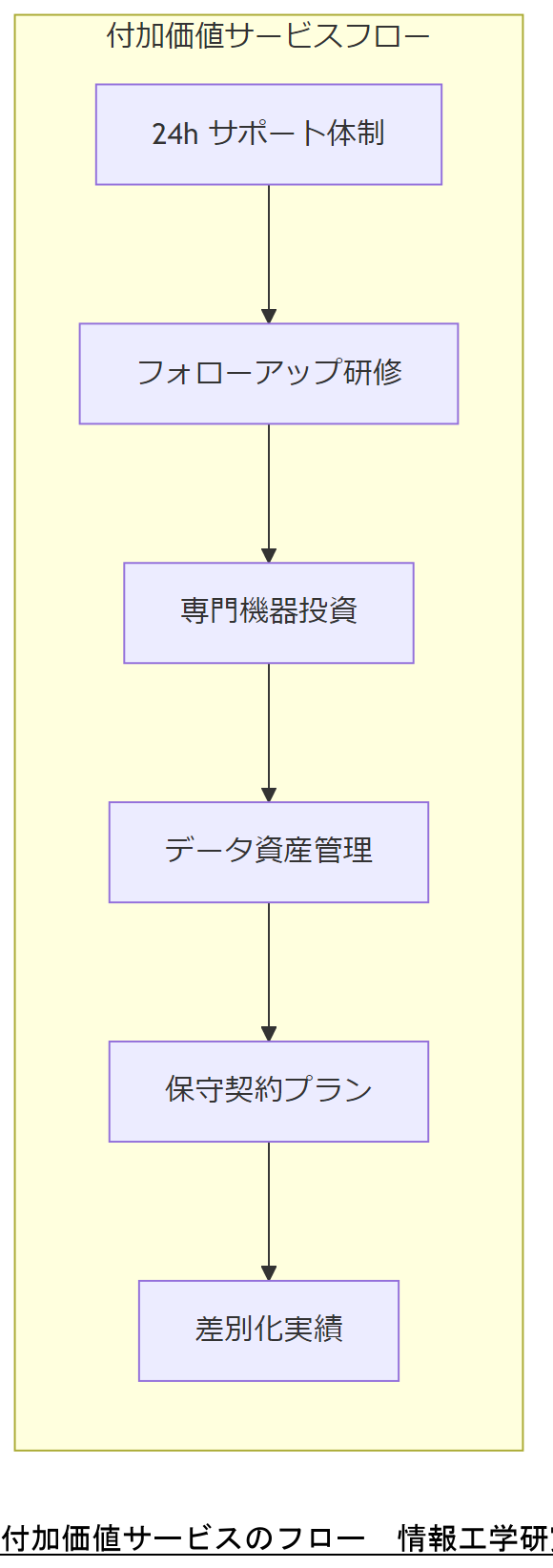

情報工学研究所が提供する付加価値サービス

本章では、弊社(情報工学研究所)が提供する付加価値サービスを紹介します。24 時間 365 日対応サポート、フォローアップ研修、専門機器保有状況、将来的なデータ資産管理コンサルティングなど、他社と差別化されたサービスを詳述します。

14.1 24時間365日対応サポートセンター体制

弊社は、24 時間 365 日対応のサポートセンターを設置しており、停電や夜間・休日を問わず即時対応が可能です。総務省『情報セキュリティ組織体制ガイドライン』では、緊急対応体制の整備が組織の信頼性向上に寄与するとされています。出典:総務省『情報セキュリティ組織体制ガイドライン』2019年

電話やメールだけでなく、専用 Web フォーム経由でのお問い合わせにも対応し、スムーズな情報収集と初動対応を実現しています。

14.2 フォローアップ研修や模擬訓練プログラム

弊社では、復旧後のフォローアップ研修や模擬訓練プログラムを提供しています。これにより、社内技術者が最新の復旧手法やフォレンジック技術を習得し、自社での再発防止能力を向上できます。IPA『情報処理安全確保支援士養成講座』でも、実践的訓練の重要性が強調されています。出典:IPA『情報処理安全確保支援士養成講座』2022年

- 事例演習:過去の復旧ケースを用いたハンズオン演習

- 最新ツール研修:デジタルフォレンジックツールの実践操作

- BCP 訓練:実シナリオに基づく復旧演習と評価

14.3 専門機器・高度解析ツールの保有状況

弊社は、最新のクローン装置、論理解析サーバー、フォレンジック専用ワークステーションなどを保有しており、他社では対応困難なハードウェア故障案件や高度なフォレンジック解析にも対応します。総務省『デジタルフォレンジック手順書』では、専用機器による証拠保全の徹底が求められるとあります。出典:警察庁『デジタルフォレンジック手順書』2019年

14.4 将来的なデータ資産管理コンサルティングサービス

復旧サービスに留まらず、将来的なデータ資産管理コンサルティングを提供します。これには、データライフサイクル管理、メタデータ設計、長期保存ポリシー策定が含まれ、企業の情報資産価値向上を支援します。経済産業省『デジタル・ガバメント構築方針』では、データ駆動経営の推進と資産価値向上が求められるとされています。出典:経済産業省『デジタル・ガバメント構築方針』2023年

- データライフサイクル設計:収集・保管・利用・廃棄までの最適化

- メタデータ管理:検索性・再利用性を高める体系化支援

- 長期保存ポリシー:法令遵守とコストバランスを考慮した保存期間設計

14.5 保守契約プランの概要と価格帯

弊社では、官公庁・非営利団体向けの特別保守契約プランを用意しており、年間保守費用の補助金申請サポートも提供します。一般企業向けには、ライトプラン・スタンダードプラン・プレミアムプランを用意し、サービス範囲に応じた料金設定を行っています。出典:総務省『中小企業 IT 支援施策ガイドライン』2022年

- ライトプラン:電話サポート+オンライン研修(年 1 回)

- スタンダードプラン:24 時間 365 日サポート+年 2 回演習

- プレミアムプラン:専任担当者常駐+オンサイト訓練・コンサルティング

14.6 他社と差別化されたサービス事例

弊社は、政府調達実績や公的認証取得により、他社にはない信頼性を持っています。総務省や経産省など公的調達案件でデータ復旧を担当し、技術力と信頼度を証明しています。また、ISO27001(情報セキュリティマネジメントシステム)認証取得により、厳格な運用体制を実現しています。出典:経済産業省『政府調達における ICT ベンダーガイドライン』2021年出典:ISO『ISO27001 認証取得企業リスト』2023年

弊社の付加価値サービスを紹介する際は、24 時間対応体制や公的認証取得の信頼性を強調し、他社との差別化要素を明示してください。

付加価値サービスの利用により、自社だけでは実現困難な訓練やコンサルティングを活用し、復旧体制の強化を図りましょう。公的認証の有効期限にも注意してください。

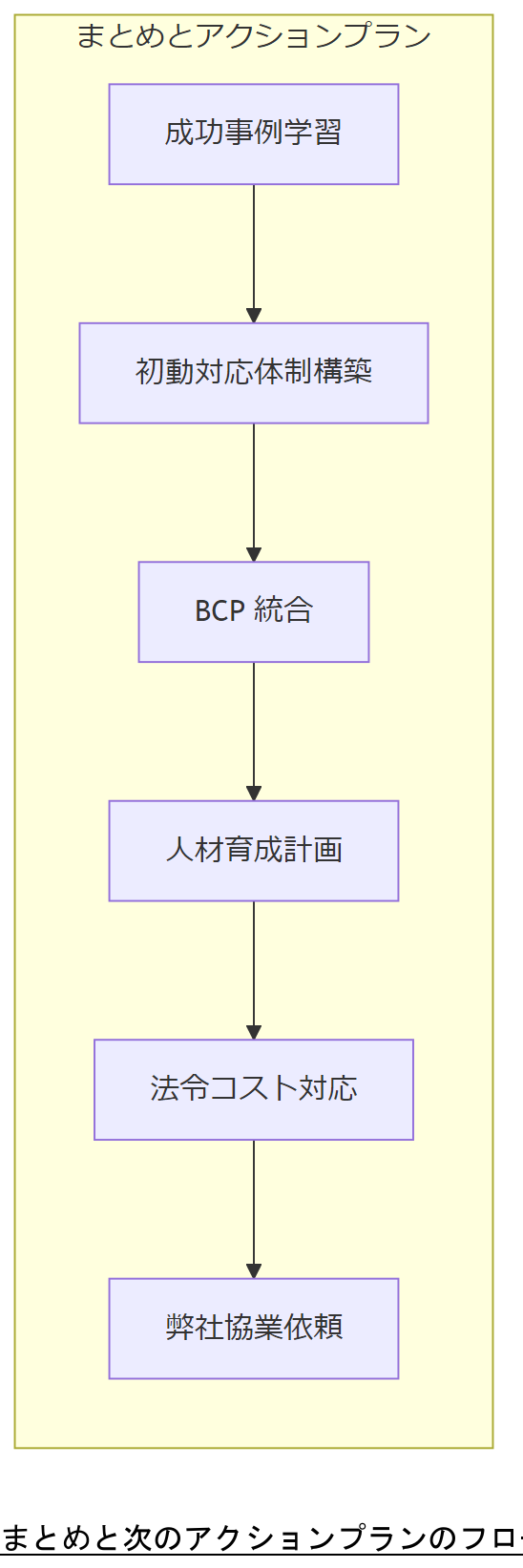

まとめと次のアクションプラン

本章では、これまでの成功事例と共通要因、法令対応、BCP 統合、人材育成、コスト試算、社会情勢予測、協業体制、付加価値サービスを総括し、情報工学研究所(弊社)にご相談いただくことで得られるメリットと次のステップを提示します。

15.1 各章の振り返り

本記事では、以下のポイントを解説しました。

- 第1章:データ復旧市場動向と成功事例の意義

- 第2章:ファイルシステム障害からの復旧プロセス

- 第3章:サーバーハード故障からの復旧技術

- 第4章:ランサムウェア感染後の復旧手法と法令対応

- 第5章:ケーススタディの共通成功要因

- 第6章:法令・政府方針・コンプライアンスが与える影響

- 第7章:BCP 戦略としてのデータ復旧計画

- 第8章:システム設計・運用・点検のベストプラクティス

- 第9章:人材育成・募集・国家資格

- 第10章:ステークホルダーと注意点

- 第11章:コスト試算と投資対効果の考え方

- 第12章:今後2年の社会情勢と対応予測

- 第13章:外部専門家へのエスカレーションと協業体制

- 第14章:弊社が提供する付加価値サービス

15.2 なぜ情報工学研究所に相談すべきか

弊社は、政府調達実績と公的認証取得に裏打ちされた信頼性を有しており、24 時間対応体制・専門機器保有・フォローアップ研修・コンサルティングサービスをワンストップで提供します。総務省『情報セキュリティ組織体制ガイドライン』でも、外部専門家と協業することで初動対応の確実性が向上すると示されています。出典:総務省『情報セキュリティ組織体制ガイドライン』2019年

15.3 経営層へ提案するときのポイントチェックリスト

経営層提案時に押さえるべきポイントは以下の通りです:

- ROI 試算:ダウンタイムコストと復旧コストを比較した具体数値

- 法令遵守:個人情報保護法やサイバーセキュリティ基本法への対応状況

- BCP 統合:三重化バックアップ体制と定期訓練計画の策定

- 人材育成:国家資格取得支援と外部研修プログラムの採用

- 協業体制:弊社とのスポット/定期保守契約オプション説明

- 付加価値:24 時間サポート、専門機器保有、将来的コンサルティングサービス

15.4 今すぐできるアクション

以下のステップで企画を進めてください:

- 初動対応マニュアルの見直しと訓練計画の策定

- IT 予算の中にデータ復旧体制構築費用を組み込む

- 外部専門家(弊社)へのお問い合わせフォームからの相談申し込み

- 国家資格取得支援制度の導入検討

- BCP シナリオのアップデートと定期演習スケジュール設定

15.5 お問い合わせ窓口・次回セミナー情報

復旧に関するご相談やフォローアップ研修のお申し込みは、お問い合わせフォームをご利用ください。次回セミナー情報は弊社ウェブサイトにて順次ご案内しております。

本記事で示したノウハウを自社で実践するためには、組織内での合意形成と必要予算の確保が最優先です。初動対応体制や人材育成計画を早期に具体化しましょう。

おまけの章―重要キーワード・関連キーワードと説明マトリクス

以下の表では、データ復旧や関連領域に関する重要キーワードと、それぞれに紐づく関連キーワード・説明をマトリクス形式で示しています。読者が復旧プロセスや関連用語を整理する際の参考にしてください。

重要キーワード・関連キーワード・説明マトリクス| 重要キーワード | 関連キーワード | 説明 |

|---|---|---|

| データ復旧 | RAID崩壊 | RAID構成の破損から、メタデータ再構築や論理復旧により消失データを取り戻す手法 |

| デジタルフォレンジック | メタデータ解析 | ファイルシステム上のメタデータを解析し、削除・破損したファイルの復元や履歴の証跡を再現する技術 |

| BCP(事業継続計画) | 三重化バックアップ | オンサイト、オフサイト、クラウドなど三つの保存先を組み合わせてデータ消失リスクを最小化する戦略 |

| 法令遵守 | 個人情報保護法 | 個人情報漏洩時の報告義務や罰則規定を定め、復旧時にも証跡保全と報告を義務づける法律 |

| 人材育成 | 情報処理安全確保支援士 | 情報セキュリティに関する実践的スキルを証明する国家資格で、フォレンジックや復旧技術にも関連 |

| システム設計 | 高可用性 | システム障害発生時に自動フェイルオーバーや冗長構成で停止を回避するアーキテクチャ設計 |

| コスト管理 | ROI試算 | 復旧コストとダウンタイム損失を比較し、投資対効果を算出・可視化する手法 |

| エスカレーション | CERT連携 | 重大インシデント発生時に、Computer Emergency Response Team(CERT)など専門機関と連携して対応するプロセス |

| セキュリティ | ランサムウェア | マルウェア感染時にデータを暗号化される攻撃手法で、解除やバックアップからの復旧手順が必要 |

| 事業継続計画 | 無電化時オペレーション | 停電時にも業務を継続するための発電機起動手順や代替通信手段を確保する運用手順 |

はじめに

データ復旧の重要性と成功事例の紹介 データ復旧は、企業が直面するリスクの一つであり、特に近年ではデジタルデータの重要性が増しています。突然のハードウェア故障や誤操作、さらにはサイバー攻撃など、様々な要因でデータが失われる可能性があります。このような事態に備えることは、企業の運営や信頼性を維持するために不可欠です。本記事では、実際のデータ復旧成功事例を紹介し、どのようにして困難な状況を乗り越えたのかを具体的に解説します。成功事例を通じて、データ復旧のプロセスや、信頼できる復旧業者の選び方についても触れ、読者の皆様に安心感を提供できればと考えています。データが失われた際の対応策を知ることで、万が一の事態に備えた効果的な対策を講じる手助けとなることを願っています。

失われたデータの復旧プロセスとは

データ復旧プロセスは、失われたデータを回復するための体系的な手法であり、通常は以下のステップで進行します。まず、データ損失の原因を特定することが重要です。ハードウェアの故障、ソフトウェアの不具合、誤操作、ウイルス感染など、原因によって復旧方法が異なります。次に、データ復旧のための適切なツールや技術を選定します。これには、専門的なソフトウェアやハードウェアの使用が含まれます。 復旧作業は、データの物理的な状態に応じて、慎重に行われます。例えば、ハードディスクが物理的に破損している場合、データ復旧専門業者によるクリーンルーム環境での作業が必要です。一方、ソフトウェア的な障害の場合は、データのスキャンや修復を行うことが一般的です。 復旧作業が完了した後は、回復したデータの整合性を確認します。これにより、データが正しく復元されているか、また損傷がないかを検証します。最後に、今後のデータ損失を防ぐための対策を講じることが重要です。バックアップ体制の見直しや、定期的なデータのチェックを行うことで、再発を防ぐことができます。このプロセスを理解することで、企業はデータ損失のリスクに対してより効果的に備えることができるでしょう。

ケーススタディ1: ハードディスク故障からの復旧

ある企業では、重要な顧客データが保存されたハードディスクが突然故障し、業務に深刻な影響を与える事態が発生しました。データが失われると、顧客との信頼関係が損なわれるだけでなく、業務の継続にも支障をきたす恐れがありました。この企業は、迅速にデータ復旧の専門業者に連絡し、状況の説明と共に復旧依頼を行いました。 専門業者は、まずハードディスクの状態を診断しました。物理的な故障が確認され、データの回復にはクリーンルームでの作業が必要であることが判明しました。クリーンルームは、埃や微細な粒子が存在しない環境で、データ復旧作業には欠かせない施設です。ここで、専門技術者がハードディスクを分解し、損傷した部品を交換しながらデータを取り出す作業を行いました。 復旧作業は数日間にわたりましたが、最終的に重要な顧客データのほとんどが無事に復元されました。この成功により、企業は顧客への信頼を回復し、業務を通常通りに再開することができました。また、今回の経験を踏まえ、定期的なバックアップの実施と、データ損失防止策の強化を図ることが決定されました。このケーススタディは、データ復旧業者の専門性と、適切な対応がいかに重要であるかを示す良い例と言えるでしょう。

ケーススタディ2: 誤削除によるデータ損失の回復

別の企業では、社員が誤って重要なプロジェクトデータを削除してしまうというトラブルが発生しました。このデータは、プロジェクトの進行に不可欠であり、削除されたことで業務が大きく停滞してしまいました。迅速に対応しなければ、プロジェクトの納期に遅れが出る恐れがありました。そこで、企業はデータ復旧の専門業者に依頼することを決定しました。 専門業者は、まず削除されたデータの状態を確認しました。誤削除の場合、データは物理的には存在しているものの、ファイルシステムからはアクセスできなくなっています。このような状況では、特別なソフトウェアを使用して、削除されたデータをスキャンし、復元することが可能です。 業者は、最新のデータ復旧技術を駆使し、数時間のスキャン作業を行いました。結果として、重要なプロジェクトデータのほとんどが無事に復元され、企業はプロジェクトを予定通りに進めることができました。この成功事例は、データの誤削除に対しても適切な対応を行うことで、迅速に回復できる可能性があることを示しています。 このケースから学べることは、データ損失のリスクは予測できないものであり、企業は事前にデータ復旧業者との連携を考慮しておくことが重要です。また、データのバックアップ体制を整えることも、万が一の際の強力な対策となります。データ復旧の専門家は、企業の信頼性を高めるための心強いパートナーです。

ケーススタディ3: ウイルス感染からのデータ復旧

ある企業では、ウイルス感染によって重要なデータが暗号化され、業務に深刻な影響を及ぼす事態が発生しました。このウイルスは、ファイルを暗号化し、復号するための身代金を要求するものでした。企業は迅速にデータ復旧の専門業者に連絡し、状況を説明しました。 専門業者は、まずシステムの状態を診断し、感染したウイルスの種類を特定しました。ウイルスの特性に応じて、適切な復旧手法を選定する必要があります。この場合、感染したシステムを隔離し、ウイルスを排除する作業が最優先となりました。その後、バックアップデータが存在するかどうかを確認し、復旧の可能性を探りました。 幸運にも、企業は定期的にバックアップを行っており、最新のデータが安全に保存されていました。専門業者は、バックアップからデータを復元する作業を行い、同時にウイルスの影響を受けたシステムをクリーンに保つための対策を講じました。復旧作業は数時間で完了し、企業は業務を通常通りに再開することができました。 このケーススタディは、ウイルス感染によるデータ損失のリスクを軽減するためには、定期的なバックアップと迅速な対応が不可欠であることを示しています。また、データ復旧業者の専門性を活用することで、企業は危機的な状況を乗り越えることができるのです。ウイルス感染に対する備えを強化することは、企業の信頼性を高めるための重要なステップと言えるでしょう。

ケーススタディ4: 自然災害によるデータ損失とその対策

ある企業では、自然災害によってデータセンターが浸水し、重要なデータが失われるという深刻な事態が発生しました。浸水の影響でサーバーがダウンし、業務が一時停止する危険性がありました。この状況を受け、企業は迅速にデータ復旧の専門業者に連絡し、事態の把握と対策を依頼しました。 専門業者は、まず現場の状況を確認し、浸水による物理的な損傷を評価しました。サーバーが水に浸かっている場合、内部のコンポーネントが損傷を受けている可能性が高いため、慎重に作業を進める必要があります。業者は、まず浸水した機器を安全に取り出し、必要に応じてクリーンルームでの復旧作業を行うことを提案しました。 さらに、企業が日常的にバックアップを行っていたことが幸いし、データの一部は安全に保存されていました。専門業者は、バックアップデータを基に、失われたデータの復旧作業を進めました。物理的な損傷があったサーバーは修理または交換され、復旧作業は数日内に完了しました。 このケーススタディから得られる教訓は、自然災害に対する備えがいかに重要であるかということです。定期的なバックアップ体制の確立と、災害時の対応策を講じることで、企業は危機的な状況を乗り越える可能性を高めることができます。また、データ復旧業者との連携を強化することで、迅速かつ効果的な対応が可能となり、企業の信頼性を維持する手助けとなるでしょう。

成功事例から学ぶデータ復旧のポイント

データ復旧の成功事例を通じて、いくつかの重要なポイントが浮き彫りになりました。まず、データ損失の原因は多岐にわたり、それぞれに応じた適切な対応が求められることです。ハードウェアの故障や誤操作、ウイルス感染、自然災害など、様々なリスクが存在しますが、どのケースでも迅速な行動が成功の鍵となっています。 また、データ復旧業者との連携が不可欠であることも明確になりました。専門業者の知識と技術を活用することで、企業はより効果的に問題を解決できる可能性が高まります。さらに、定期的なバックアップ体制の構築が、データ損失に対する最も有効な防止策であることも示されています。バックアップが存在することで、復旧作業がスムーズに進行し、業務の早期再開が可能となります。 これらの成功事例から得られる教訓は、企業がデータの重要性を再認識し、リスク管理を強化するための基盤となるでしょう。データ復旧のプロセスを理解し、適切な対策を講じることで、企業は未来の不確実性に備えることができるのです。データ復旧は単なる技術的な問題ではなく、企業の信頼性と持続可能性に直結する重要な要素であることを忘れずに、日々の業務に取り入れていくことが求められます。

データ復旧サービスへのお問い合わせ

データ復旧は、企業にとって重要な課題であり、迅速かつ専門的な対応が求められます。万が一のデータ損失に備え、信頼できるデータ復旧業者との連携を強化することが大切です。当社では、豊富な経験と専門知識を持つ技術者が、様々なデータ損失のケースに対応しています。ハードウェアの故障や誤操作、ウイルス感染、自然災害など、どのような状況でも、最適な復旧方法を提案し、迅速な対応を行います。 データ復旧に関するご相談やお見積もりは、いつでもお気軽にお問い合わせください。お客様の大切なデータを守るためのサポートを提供し、安心して業務を継続できるようお手伝いいたします。データの安全性を確保するために、今すぐご連絡いただければと思います。専門のスタッフが丁寧に対応し、最適な解決策をご提案いたします。

データ復旧時の注意事項と事前準備

データ復旧を行う際には、いくつかの重要な注意点があります。まず、データ損失が発生した場合、直ちにデバイスの使用を中止することが大切です。特に、データが物理的に損傷したハードディスクの場合、さらなる操作がデータの上書きや損傷を引き起こす可能性があります。誤った操作を避けるためにも、専門業者に依頼することが推奨されます。 次に、復旧を依頼する業者の選定も重要です。信頼できる業者を選ぶためには、過去の実績や顧客の評価を確認することが必要です。また、業者が提供するサービス内容や料金体系についても事前に確認し、納得のいく選択を行いましょう。無理な料金設定や不明瞭なサービス内容には注意が必要です。 さらに、データ復旧のプロセスにおいては、バックアップの重要性を再認識することが不可欠です。定期的なデータバックアップを行うことで、万が一のデータ損失時に迅速な復旧が可能となります。バックアップは、異なる媒体やクラウドサービスを利用することで、より安全性を高めることができます。 最後に、データ復旧後の再発防止策も考慮することが重要です。復旧が完了した後は、データ損失の原因を分析し、再発防止策を講じることで、今後のリスクを軽減することができます。これにより、企業のデータ管理体制が強化され、信頼性の向上に繋がるでしょう。

補足情報

※株式会社情報工学研究所は(以下、当社)は、細心の注意を払って当社ウェブサイトに情報を掲載しておりますが、この情報の正確性および完全性を保証するものではありません。当社は予告なしに、当社ウェブサイトに掲載されている情報を変更することがあります。当社およびその関連会社は、お客さまが当社ウェブサイトに含まれる情報もしくは内容をご利用されたことで直接・間接的に生じた損失に関し一切責任を負うものではありません。