もくじ

- 昨夜の「誰かが触った」を追う――設定が消える瞬間はUIではなくAPIに残る

- Redfishは“画面操作”の裏側を言語化する:/Systems と /Managers の見取り図

- まずは証拠保全:BMCイベントログ/監査ログ/SELを壊さず吸い上げる

- EventServiceとLogServices:どこに「削除・変更」が記録されるのか

- 犯人捜しではなく因果の特定:ユーザー/セッション/IP/時刻の突合

- 「DELETEされた設定」を復元する準備:前状態の推定とゴールデン設定

- Redfish PATCHで安全に戻す:冪等・差分適用・再起動条件の扱い

- 自動化で“抑え込み”:定期スナップショットと設定ドリフト検知

- 監査対応まで見据える:変更申請・証跡・権限分離をAPI運用に組み込む

- 帰結:Redfishログ分析は「復旧」ではなく「運用を壊さない設計」への近道

【注意】本記事は、Redfish API(サーバ管理の標準インターフェース)を手がかりに「設定が消えた/変わった」事象を分析し、一般的に取り得る“被害最小化(ダメージコントロール)”と復旧アプローチを整理した情報提供です。実際の最適解は、機器ベンダー実装(iLO/iDRAC/XClarity 等)、ログ保持期間、権限設計、監査要件、復旧期限、既存運用(変更管理・IaC・バックアップ)で変わります。重要な本番環境では判断を誤ると影響が拡大しやすいため、個別案件として株式会社情報工学研究所のような専門事業者に相談してください。

昨夜の「誰かが触った」を追う――設定が消える瞬間はUIではなくAPIに残る

「朝イチでアラートが鳴って、見たら設定が消えてる。いや、こっちは夜勤じゃないんだが…」——SRE/情シスの現場だと、こういう“胃が重くなる朝”は珍しくありません。

しかも困るのが、管理画面(Web UI)で見える範囲だけでは、「何が、いつ、どの経路で変更されたか」が追い切れないことです。ベンダーの管理UIは便利ですが、裏ではAPI呼び出しが走っていて、変更の実体は「API操作」として記録されることが多い。つまり、画面を眺めても分からないときほど、Redfishを含む管理インターフェースのログが主戦場になります。

最初にやるべきは“沈静化”:原因究明より先に、状況を悪化させない

ここでやりがちなのが、焦って設定を戻し始めることです。気持ちは分かります。でも、分析前に手を入れると、変更痕跡が上書きされたり、ログが流れたりして、あとから「結局何が起きたのか」が分からなくなります。

まずは“沈静化”のために、次の順でブレーキを踏みます。

- アクセス経路の抑え込み:BMC管理ネットワークへの到達経路(VPN/踏み台/ACL)を一時的に絞る

- 権限の暫定見直し:共有アカウントがあるなら停止、APIトークン/パスワードのローテーション

- 時刻の固定:NTPずれがあると突合が崩れるので、BMCとOS/監視基盤の時刻差をメモする

- ログ保全の優先:SEL/BMCログ/監査ログが短期でローテーションされる前に吸い上げる

この段階のゴールは「犯人当て」ではありません。“これ以上壊さない”状態に落とすことです。復旧が急務でも、まずは被害最小化のための手順を固定してから動いた方が、結果的に早いケースが多いです。

なぜRedfishが効くのか:変更の“共通語”としての標準API

Redfishは、サーバのBMCが提供する管理機能(状態参照・ログ・設定変更など)を、HTTP/JSONの形式で扱えるようにした標準インターフェースです。重要なのは、ベンダー固有の管理UIが違っても、「同じ概念を同じ構造で追える」可能性があること。

「UIのどこをクリックしたか」ではなく、「どのリソースに対して、どんな操作(GET/PATCH/POST/DELETE)が走ったか」を追うと、原因と復旧が“技術の言葉”で整理できます。現場としては、ここが一番腹落ちするポイントです。

このあと第2章以降で、Redfishの基本構造、ログの取り方、変更の突合、そして安全な戻し方(差分適用・冪等)へ進みます。

Redfishは“画面操作”の裏側を言語化する:/Systems と /Managers の見取り図

「Redfishって聞いたことはあるけど、結局どこを見ればいいの?」という声、よく分かります。結論から言うと、ログ分析や設定復旧で最初に押さえるのは、Service Root(入口)→ Systems(本体)→ Managers(BMC)→ LogServices(ログ)という流れです。

最小の地図:Service Rootから辿る

Redfishは、だいたい次のような“入口”から始まります(パスは機器により異なりますが概念は同じです)。

- Service Root:Redfishの入口。ここから Systems / Managers / Chassis などへリンクされる

- Systems:OSが動く「サーバ本体」側の情報(CPU/メモリ/ストレージ、ブート、状態など)

- Managers:BMC(iLO/iDRAC等)そのものの情報(管理NIC、ユーザー、ログ、時刻など)

- Chassis:筐体・電源・ファン・センサー等(ハード寄りの状態)

設定が消えた/変わったのが「ブート順」「BIOS/UEFI」「RAID設定」「BMCユーザー」「管理ネットワーク」など、どの層の話かで、見るべき場所が変わります。とはいえ、“変更の証跡”は Managers 側(BMC側)に寄ることが多いので、まずは Managers を主軸に置くと迷子になりにくいです。

ログとイベントの位置づけ:EventService と LogServices

Redfishには、イベント通知の仕組み(EventService)と、ログの仕組み(LogService/Entries)が用意されています。ここで大事なのは、現場で起きがちな誤解を避けることです。

| 観点 | EventService(通知) | LogServices(記録) |

|---|---|---|

| 目的 | 起きたことを外へ届ける(サブスク/Webhook的) | 起きたことを機器内に残す(Entriesとして参照) |

| 強み | リアルタイム性、監視基盤と相性が良い | 過去ログの調査、時系列突合に強い |

| 落とし穴 | 購読設定が無いと“届かない” | 保持件数が小さいと“流れる” |

削除された設定を追う場合、まずはLogServicesのEntriesを確実に吸い上げる。その上で、EventServiceの購読が既にあるなら、監視基盤側のイベント履歴も突合する、という順が安全です。

伏線:標準の“外側”にある、ベンダー固有ログ

重要なのは、Redfishが標準だからといって、監査ログや操作履歴がすべて標準で揃うとは限らないことです。実際には、

- Redfishの標準ログとして見える範囲

- ベンダー独自の監査ログ(UI操作、ユーザー操作履歴)

- ハードウェアのイベントログ(SEL等)

が併存します。ここを混同すると、「ログが無い=何も起きていない」と誤判定しがちです。第3章では、ログ保全を“壊さずに”やる具体手順(どこから、どの順で、何を保存するか)を整理します。

まずは証拠保全:BMCイベントログ/監査ログ/SELを壊さず吸い上げる

「ログを取るだけでしょ?」と思われがちですが、障害対応の現場では“取る順番”がすべてです。特にBMC周りのログは保持が短いことがあり、操作を増やすほど上書きが進みます。ここはノイズカットの発想で、必要最小限の操作で最大の証拠を確保します。

最優先は時系列を崩さないこと:時刻差メモと取得順

まず、BMC(Managers)・ホストOS・監視基盤の時刻差をメモします。NTPが正しくても、障害時にズレていることがあります。時系列突合では、1〜2分の差でも判断を誤ります。

次に、取得の順番は原則こうです。

- 機器内ログ(消えやすいもの):SEL、BMCログ、LogServices/Entries

- 外部ログ(消えにくいもの):SIEM、踏み台、VPN、FW、ID基盤、監視イベント

- 状態情報:現在の設定・現状の構成スナップショット(ただし変更操作は最小)

“まず外部から”にしたくなるのは自然ですが、機器内ログがローテーションしやすいなら、先にそこを確保するのが堅いです。

Redfishで「読むだけ」を徹底する:GET中心、変更系は後回し

証拠保全フェーズでは、基本はGETで取得し、可能なら生JSON(レスポンス)をそのまま保存します。ここでのコツは、「人間が見やすい整形」より「原本性」です。整形は後から何度でもできますが、原本は一度失うと戻りません。

また、ログの“種類”は1つではありません。たとえば次のように層で持ちます。

| ログの層 | 例 | 狙い |

|---|---|---|

| ハードウェアイベント | SEL、温度、電源、メモリエラー等 | 物理起因(再起動/不安定化)の切り分け |

| BMC操作・管理ログ | LogServices/Entries、監査ログ | いつ・誰が・何を操作したかの追跡 |

| 外部アクセスログ | 踏み台/VPN/FW/ID基盤 | 操作主体の同定(端末/IP/認証イベント) |

“削除”が疑われるときの注意:ログそのものが消される前提で動く

設定が削除されたということは、ログが削除される可能性もゼロではありません(権限が強いアカウントが使われた場合、なおさらです)。なので、保全では次を意識します。

- 権限の再配布は最後:アカウント整理は必要だが、先にログ確保

- 取得経路を固定:どの端末・どのユーザーで取得したかを記録

- 再現しない:“試しにもう一回”はログ汚染になり得る

ここまでできると、次は「どのログに削除・変更が出るのか」という核心に入れます。第4章では、EventService/LogServicesの具体的な当たり方と、ベンダー差が出るポイントを、現場目線で整理します。

EventServiceとLogServices:どこに「削除・変更」が記録されるのか

「ログは取った。で、どこを見れば“削除”が分かるの?」——ここが一番、現場の時間を溶かすポイントです。Redfishは“標準”ですが、すべての操作履歴が同じ粒度で残るわけではありません。なので、闇雲に眺めるのではなく、当たりを付けて“ノイズカット”しながら掘るのがコツです。

まずは整理:Redfishで扱う「ログ」「イベント」「監査」は別物になりやすい

Redfishの世界では、ざっくり次の3つが混同されがちです。

| 区分 | 代表的な置き場(概念) | 何が分かるか |

|---|---|---|

| イベント通知 | EventService | “起きた”ことを外部に通知(購読していれば) |

| ログ記録 | LogServices / Entries | 機器内に残る時系列ログ(種類は複数) |

| 監査・操作履歴 | (ベンダー依存が強い)監査ログ/セキュリティログ | 誰が何を操作したか(ユーザー/IP/セッション等) |

“設定が削除された”という事象は、厳密には操作(監査)の話であり、同時に状態変化(ログ)の話でもあります。つまり、LogServicesだけで完結することもあるが、監査ログが無いと「誰が」が分からない、という形になりがちです。

LogServicesは「種類ごと」に当たりがある:まず“どのログ種か”を特定する

RedfishのLogServicesは、複数のログを持てます。典型的には、ハードウェアイベント、システムイベント、管理イベントなどが分かれます。ここでの最短手順は、

- LogServices を列挙して「何種類のログがあるか」を把握する

- それぞれの Entries を見て、削除・変更に近い語彙が出るログ種を当たり付けする

です。現場感としては、電源/温度/メモリのようなハードイベントだけのログをいくら見ても「設定削除」は出ません。一方、管理系ログ(管理操作や構成変更が出るログ)に当たると、変更が見える可能性が上がります。

「DELETEがログに出ない」ことは普通にある:証跡は“間接”で追う

ここが厄介ですが、実装によっては、RedfishのHTTPメソッド(DELETE/PATCH/POST)がそのままログに残らないことがあります。つまり「DELETEした」ではなく、

- 設定値が“変わった”という記録

- 再起動やApply、ジョブ投入が走った記録

- ユーザー操作(ログイン/セッション開始/権限変更)の記録

のように、間接的な痕跡を時系列で繋いで結論に近づきます。これは脚色ではなく、ログ調査の現実です。ログが「因果」を自動で語ってくれないので、こちらが因果を組み立てる必要があります。

EventServiceは「事後調査」より「再発防止」に効く

EventServiceは購読していれば強力ですが、購読していなければ過去に遡って“通知”は取れません。したがって、削除設定復旧の局面では、EventServiceは主役というより、

- 今後の構成変更に対する“早期検知”

- 監視基盤/SIEMへ構成変更イベントを流す

といった抑え込み(再発防止)の武器になりやすいです。第8章で、定期スナップショットと合わせて、ドリフト検知の設計として扱います。

ベンダー差が出るポイント:監査ログがRedfishで取れない場合の逃げ道

現場で多いのは、「RedfishのEntriesに変更は出るが、誰が操作したかが薄い」パターンです。この場合は、次のように外部ログと突合して“穴埋め”します。

- 踏み台/SSH/リモート管理端末のログ:誰がいつ踏み台に入ったか

- VPN/ゼロトラスト/ID基盤:ログイン成功、MFA、端末情報

- FW/ルータ:BMC管理ネットワークへの通信の発生有無

この“穴埋め”が、次章の「ユーザー/セッション/IP/時刻の突合」の伏線です。削除・変更は、単独のログでは証明しきれないことがある。だからこそ、突合できるように設計しておくのが、長期的には一番の被害最小化になります。

次の第5章では、実際に「誰が」を断定しようとして事故る典型(犯人捜しで空気が荒れる)を避けつつ、技術者としての結論を出すための突合手順に進みます。

犯人捜しではなく因果の特定:ユーザー/セッション/IP/時刻の突合

現場の本音を言うと、「誰がやったのか」は早く知りたい。でも同時に、「それを言い出すと荒れる」のも分かってる。ここで大事なのは、議論が過熱しないように“場を整える”ことです。目的は責任追及ではなく、復旧と再発防止だと最初に明言した方が、調査が速くなります。

突合の前提:時刻のズレを吸収して“同じタイムライン”を作る

第3章でメモした時刻差がここで効きます。BMCログ、踏み台、VPN、SIEMはそれぞれ時刻源が違うことがあります。突合ではまず、

- 各ログのタイムゾーン(UTC/JST)

- 時刻差(±何分)

- ログの粒度(秒まであるか、分単位か)

を揃えて、1つのタイムラインに落とします。ここをサボると、「同時刻に別の人が操作した」ように見える誤差が出ます。

“誰が”の同定は段階的に:確度を上げるための4点セット

同定を一発で決めに行くと、外します。そこで、確度を段階的に上げるために、次の4点セットで積み上げます。

| 要素 | どこにあるか | 確度の上げ方 |

|---|---|---|

| ユーザー | BMC監査ログ/ID基盤 | 共有アカウントなら特に外部ログで補強 |

| セッション | 監査ログ/管理UIログ | ログイン→操作→ログアウトの連なりを確認 |

| IP/端末 | FW/VPN/踏み台 | 管理ネットワーク到達経路を一本化すると強い |

| 時刻 | 全ログ共通 | ズレ補正と前後イベント(再起動/ジョブ投入)で補強 |

この4点が揃うと、「操作があった」→「その操作はこの経路」→「経路の先にいる主体」という形で、推測ではなく因果に近づけます。

よくある落とし穴:共有アカウントと自動化(ジョブ)が混ざる

Redfishや管理UI周りは、共有アカウント運用になっている現場が少なくありません。また、構成管理ツールやスクリプトが定期的にアクセスしていることもあります。ここが混ざると、

- “誰かが触った”と思ったら、実は定期ジョブだった

- 逆に、ジョブを装った手動操作が紛れた

というケースが起き得ます。だから、突合では「ユーザー名」だけで結論を出さず、アクセス元IP、User-Agent相当、操作パターン(一定間隔か、突発か)などの特徴量も見ます。

伏線:結論は「復元」では終わらない—“戻し方”が次の事故を決める

突合が進むと、「じゃあ戻そう」となります。でも、ここで雑に戻すと、別の依存関係(ブート順、仮想メディア、RAID、セキュアブート、鍵管理)が崩れて、二次障害が起きます。

次の第6章では、削除された設定を復元する前に必要な“前状態の推定”と、ゴールデン設定の作り方を整理します。ここを押さえると、復旧作業が“炎上/クレーム対応”になりにくくなります。

「DELETEされた設定」を復元する準備:前状態の推定とゴールデン設定

設定が消えたとき、現場はつい「とにかく元に戻す」に寄ります。でも、Redfish絡みの復旧で一番危ないのは、“元”が曖昧なまま戻すことです。手元の記憶、古い手順書、別環境の設定——それらを混ぜると、復旧は一瞬できても、後で不整合が噴き出して“温度を下げる”どころか上がります。

前状態を推定する材料:ログ・スナップショット・構成管理の三点セット

削除された設定の復元準備は、次の三点セットで確度を上げます。

- ログ:「いつ変わったか」「変更前後のイベント」「再起動やジョブ投入の有無」

- スナップショット:変更前の設定出力(取れていれば最強)

- 構成管理:IaC(Ansible等)や運用台帳、チケットの変更履歴

このうち、ログは第4〜5章で固めました。次はスナップショットと構成管理ですが、現実には「スナップショットが無い」ことも多い。その場合は、“前状態の推定”を段階的に行います。

スナップショットが無いときの推定手順:安全側に倒す

推定は、次の順番が現実的です。

- 同型機/同ロールの健全個体があれば、設定差分を比較する(同じクラスタ、同じ世代のサーバ)

- 運用要件(ブート方式、仮想化、RAID、セキュアブート、管理ネットワーク方針)から“許容される範囲”を特定

- 現状の状態(今の設定)を取得し、「どこが空/デフォルトに戻ったか」を洗い出す

ここで大事なのは、“完全一致を目指さない”ことです。復旧の第一目標は、業務影響を抑え込んでサービスを安定させること。最終的な整合(監査・標準化・再発防止)は、落ち着いてから詰めた方が成功率が上がります。

ゴールデン設定を作る:復元の「正解」を文章化する

復元の場面で「どれが正しい設定?」がブレると、チーム内の議論が過熱します。だから、復旧作業に入る前に、最低限のゴールデン設定(目標状態)を作ります。

ゴールデン設定は、機器や環境により違いますが、最低限ここは定義します。

- 管理面:BMCのユーザー/権限、パスワードポリシー、監査ログ設定、管理NICのIP/DNS/NTP

- 起動面:UEFI/BIOS、BootOrder、Secure Bootの扱い、仮想メディアの許可/禁止

- ストレージ面:RAID構成(論理/物理)、HBA/パス、キャッシュ設定(有効/無効)

- 運用面:変更はチケット経由、緊急時の例外手順、復旧後の監査提出物

この「ゴールデン」を作る工程は、復旧のためだけでなく、次章以降の差分適用(PATCH)を安全にする伏線になります。

注意:復元の前に“依存関係”を表にしておく

Redfishの設定は単独で存在しないことがあります。たとえば、ブート順を戻すと、セキュアブートや仮想メディアの設定と噛み合わない。RAID設定をいじると、OS起動に影響する。だから、戻す前に簡単な依存関係表を作ると、二次障害の防波堤になります。

| 戻したい設定 | 依存しやすい要素 | 確認ポイント |

|---|---|---|

| BootOrder | UEFI/BIOS、Secure Boot、仮想メディア | 次回再起動で意図したデバイスから起動するか |

| BMCユーザー/権限 | 監査ログ、運用手順、APIトークン | 自動化が止まらないか、共有アカウントを残さないか |

| RAID/Storage設定 | OS/ドライバ、冗長性、性能要件 | 復旧後にI/Oが不安定にならないか |

準備ができたら、いよいよ「安全に戻す」工程です。第7章では、Redfishでの変更適用を、事故りにくい形(冪等・差分・ロールバック前提)で扱います。

Redfish PATCHで安全に戻す:冪等・差分適用・再起動条件の扱い

復旧で一番まずいのは、「戻したつもりが別の設定まで巻き込んだ」事故です。RedfishはJSONで状態を扱うため、操作の仕方によっては意図しないフィールドが変わります。ここでの基本戦略は、“全面上書き”ではなく、差分を小さく、再実行可能(冪等)にです。

冪等にするとは:同じ操作を何度やっても同じ結果になる

障害対応では、途中で通信が切れたり、確認のために再実行したりします。そのたびに状態が揺れると、収束しません。だから、復旧操作は次を満たすように設計します。

- 変更前に必ず現状をGETして、期待状態との差分だけを作る

- 差分適用後に再度GETして、結果を検証する

- 再実行しても同じ差分(または差分ゼロ)になる形にする

これはツールや言語の話ではなく、復旧手順の品質の話です。

差分適用の実務:戻すフィールドを“最小集合”に絞る

Redfishのリソースは多くのプロパティを持ちます。復旧で重要なのは、戻す対象を限定することです。たとえば「BootOrderを戻したい」なら、Boot周り以外を触らない。

このとき、手順としては次の形が事故りにくいです。

- 現状取得:対象リソースをGETし、現状値を保存(原本)

- 目標決定:ゴールデン設定または推定前状態から、戻したい値を定義

- 差分生成:変更が必要なキーだけを抽出してPATCHペイロードを作る

- 適用:PATCH実行(失敗時はログ採取→再実行は“同じ差分”で)

- 検証:再度GETして値を確認(必要なら関連ログも確認)

「全部のJSONを丸ごとPUTで戻す」ようなやり方は、環境により許されないことも多い上、巻き込みが増えやすいので避けた方が無難です。

再起動条件の扱い:ApplyTime/ジョブ/リセットが絡むと“温度が上がる”

設定によっては、反映に再起動が必要です。ここでトラブルになるのが、

- いつ再起動されるのか(即時か、次回か)

- 再起動が業務影響に直結する(止められない)

- ジョブキューに溜まって意図せず順番が変わる

といった運用面です。ここは技術だけで解けないので、復旧手順に「再起動の意思決定」を明示します。具体的には、

- 即時反映が必要な設定か(ログイン権限、ネットワーク等)

- 次回メンテまで待てる設定か(一部のブート関連等)

- 再起動前に確認すべき依存関係(第6章の表)

をチェックリスト化して、現場の判断をブレさせないのがコツです。

安全装置:復旧前の“戻し戻し”を準備する

復旧で想定外が起きたとき、手戻りできないと炎上します。だから、最低限、

- 変更前のGET結果(原本)を保存

- 適用した差分ペイロードを保存

- 適用後のGET結果(証跡)を保存

をセットで持ちます。これがあると、「何をしたか」が説明でき、監査や社内調整もやりやすくなります。

次の第8章では、今回の件を“抑え込み”として再発防止に繋げます。ポイントは、スナップショットとドリフト検知で「設定が消えた」を早期に検知し、同じ対応を繰り返さないことです。

自動化で“抑え込み”:定期スナップショットと設定ドリフト検知

「また消えたらどうするの?」に、現場が一番現実的に答えられるのがここです。原因究明も大事ですが、運用としては“次に起きた瞬間に分かる”状態にしておくことが、結果的にダメージコントロールになります。

スナップショットの基本:Redfishは“取得しやすい”が“保管しにくい”

RedfishはHTTP/JSONなので、設定や状態を定期的に取得すること自体は難しくありません。一方で、取得したJSONは量が多くなりがちで、機密性も含みます(ユーザー構成やネットワーク情報が混じる場合がある)。そこで、スナップショット設計では次を分けます。

- 保存してよい情報:ブート順、BIOS/UEFI関連(公開できる範囲)、ログ設定の有無、ファームウェアバージョンなど

- 秘匿すべき情報:ユーザー名一覧、IP設計、証明書、トークン、秘密鍵に類するもの

「全部取って全部残す」は簡単ですが、監査・セキュリティ上の負債になります。ここは“ノイズカット”で、比較に必要な最小セットを定義するのが堅いです。

ドリフト検知の実務:差分の取り方で運用コストが決まる

ドリフト検知(設定が勝手に変わった検知)で重要なのは、アラートの精度です。誤検知が多いと“アラート疲れ”が起き、肝心なときに見逃します。運用を成立させるために、差分の取り方を段階化します。

| 段階 | 差分の粒度 | 向いている場面 |

|---|---|---|

| レベル1 | “重要キーだけ”の比較(BootOrder等) | まず事故を減らしたい、誤検知を抑えたい |

| レベル2 | サブツリー単位(Managers配下の一部) | 構成が固まっていて、監査要件が強い |

| レベル3 | 広範囲(Systems/Managers/Chassisの複数) | 専任運用がいて、アラートの解釈が回る |

最初はレベル1から始め、運用が回り始めたら段階的に広げるのが、現場負担が増えにくい進め方です。

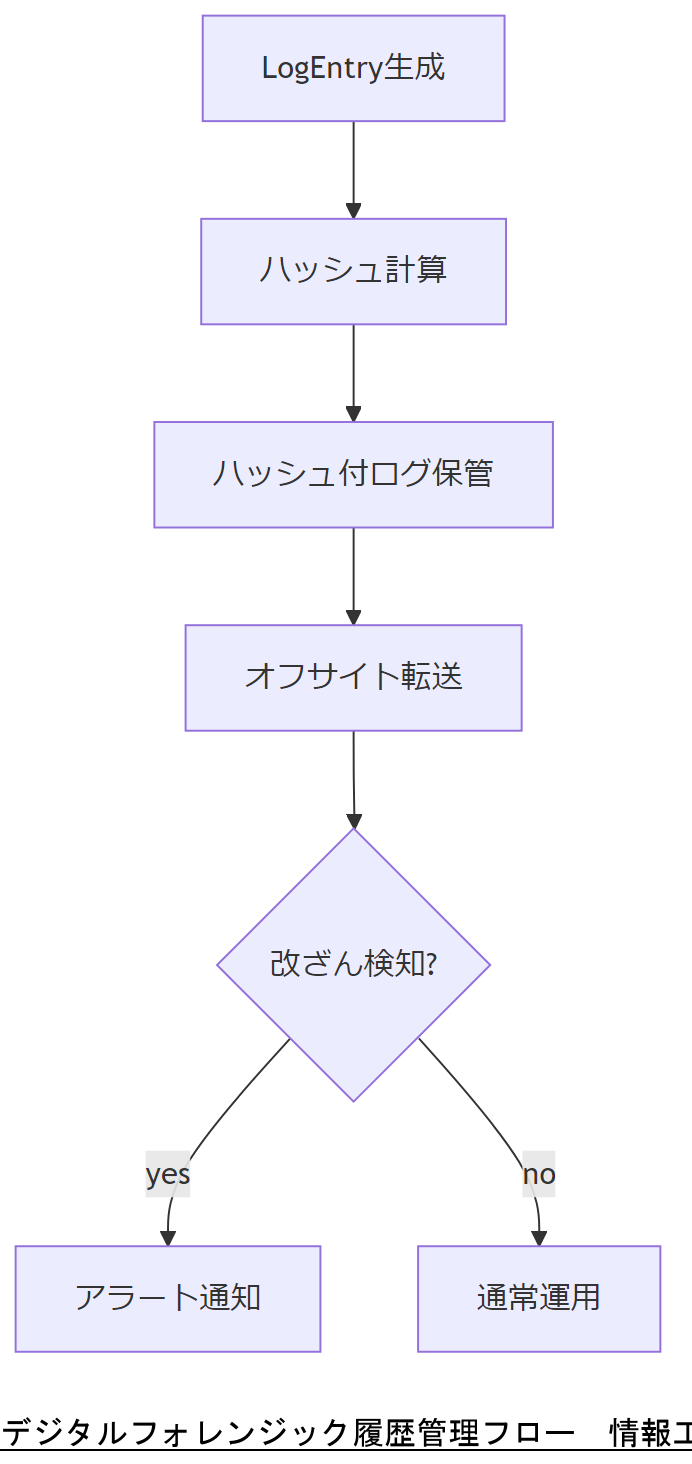

スナップショットの“証跡性”:改ざん検知と保管期限

「設定が消えた」を説明する場面では、スナップショットが“証跡”として使えることが重要です。最低限、次は押さえます。

- 取得日時・取得元・取得者(実行主体)をメタ情報として残す

- 改ざん検知(ハッシュ付与や署名、変更履歴の追跡が可能な保管)

- 保持期間(ログ保持と同じく、短すぎると意味が薄い)

特に、BMC側のログ保持が短い場合は、外部に“残る証拠”を作るのが被害最小化になります。

アラート設計:通知先は「担当者」ではなく「仕組み」に寄せる

運用でよくある失敗は、通知が個人に閉じることです。夜間や休暇で途切れると、収束が遅れます。おすすめは、

- チケット発行(ITSM等)と連動して「記録が残る」

- オンコールルールで「引き継がれる」

- 重大度で通知先を分ける(軽微なドリフトはまとめて通知)

という、仕組み寄りの設計です。ここまで作ると、第9章の「監査対応・権限分離」に自然に繋がります。

監査対応まで見据える:変更申請・証跡・権限分離をAPI運用に組み込む

Redfishで設定を戻せるようになると、次に問われるのは「じゃあ、誰でも戻せるの?」です。ここで雑に権限を広げると、次の事故の火種になります。運用としては、権限を絞りつつ、必要なときに確実に動かせる形にするのが“ブレーキ”になります。

変更管理の最小要件:チケットがない変更は“後から地獄”

APIでの変更は速い反面、「いつ誰が何を変えたか」が曖昧になりやすいです。だから、最低限ここは運用ルール化します。

- 変更はチケットに紐付ける(緊急でも“事後に必ず”記録)

- 実行ログ(差分ペイロード)を添付(第7章の保存3点セット)

- 承認者と実行者を分ける(小規模でも役割を明確化)

これがあるだけで、社内調整や監査対応の“空気を落ち着かせる”効果が大きいです。

権限分離:最小権限と“壊せる権限”の隔離

BMC操作は強力です。操作できる範囲が広いほど、便利さと引き換えに事故リスクが上がります。そこで、アカウント/権限設計では次を基本にします。

| 役割 | できること | 注意点 |

|---|---|---|

| 閲覧(Read) | 状態参照、ログ参照、スナップショット取得 | まずはこの権限を標準にする |

| 運用変更(Change) | 限定した設定の変更(例:ログ設定、通知設定) | 対象を絞り、差分適用に限定 |

| 緊急復旧(Break-glass) | ブート/ユーザー/ストレージ等の強力操作 | 普段は封印、利用時は監査を厚くする |

“Break-glass”は、事故時に必要になりますが、常用するとリスクが跳ね上がります。普段は封印し、利用時は記録と承認を厚くするのが基本です。

到達経路の固定:踏み台・MFA・ネットワーク分離で“歯止め”を作る

ログ突合(第5章)を強くするためにも、BMCへの到達経路を整理します。

- 管理ネットワークは分離(業務ネットワークから直通しない)

- 踏み台を経由(アクセスログが必ず残る)

- MFA/端末制御(ID基盤側で統制)

これにより、「BMC側ログが薄い」場合でも、外部ログで穴埋めできる確率が上がります。

一般論の限界が出る部分:監査要件と規模で最適解が変わる

ここまでの話は“筋の良い一般解”ですが、実際には、業界の監査要件やシステム規模、保守契約、24/365の稼働要件で最適解は変わります。たとえば、

- 変更承認フローをどこまで形式化するか

- スナップショットの保持期間と保管場所をどうするか

- ベンダー固有機能(監査ログ等)をどう組み込むか

は、個別案件の設計課題です。次の最終章では、Redfishログ分析が最終的に何をもたらすか、そして「専門家に相談すべき境界線」を整理します。

帰結:Redfishログ分析は「復旧」ではなく「運用を壊さない設計」への近道

ここまでの流れを一言でまとめると、Redfishログ分析の価値は「設定を戻す魔法」ではなく、運用を壊さずに収束へ持っていくための共通言語を手に入れることです。

復旧の“成功”を定義し直す:戻っただけでは終わらない

設定が元に見えても、次のどれかが欠けると、また同じ事故が起きます。

- 証跡:何が起きたかを説明できる(ログ・差分・時系列)

- 再現性:同じ手順で同じ結果を得られる(冪等・差分適用)

- 抑え込み:次に起きたらすぐ分かる(ドリフト検知・通知)

- 統制:勝手に変えられない(権限分離・到達経路固定)

この4つが揃って初めて、現場の温度が下がります。

“一般論”の限界ライン:ここを越えたら専門家の出番

一方で、Redfishは標準でも、現場の条件はバラバラです。次の条件が絡むと、一般論だけで安全に進めるのが難しくなります。

- 本番停止が許されない(再起動を伴う変更が絡む)

- ストレージ構成が複雑(RAID/HBA/多経路、仮想化基盤)

- 監査要件が強い(証跡の真正性、職務分掌、ログ保全)

- ベンダー固有実装が深い(標準ログでは足りず、追加解析が必要)

この領域は、判断を誤ると復旧難易度が上がり、影響範囲が広がりやすいです。だからこそ、個別案件として株式会社情報工学研究所のような専門家に相談し、環境条件に合わせた手順・権限・保全設計を組み立てる価値があります。

現場が取りやすい“小さな一歩”:今日からできるチェックリスト

最後に、いきなり大改修ではなく、今日からできる“被害最小化”の一歩を置きます。

- BMCログの保持条件(保持件数/期間)を把握する

- 重要設定だけでも週次でスナップショットを取る

- BMC到達経路を棚卸しし、踏み台/ログを整える

- 共有アカウントがあるなら、段階的に廃止計画を作る

これだけでも、「また起きたときに詰む」確率は下がります。もし、現状の構成や監査要件、ベンダー実装の差で迷う場合は、一般論で無理に押し切らず、株式会社情報工学研究所への相談を検討してください。状況整理と設計から入るだけでも、収束までの時間は短くできます。

付録:現在よく使われるプログラム言語別の注意点(Redfish/API運用)

RedfishはHTTP/JSONなので、どの言語でも扱えます。ただし、実務で事故りやすいポイントは言語や実装スタイルで差が出ます。ここでは「Redfishログ取得・差分比較・PATCH適用」を想定して、注意点を整理します。

共通の注意(言語に依らず必須)

- TLS証明書検証を無効化しない:検証OFFは一時しのぎにはなりますが、運用に残すとリスクが跳ね上がります(どうしても必要なら、正規の証明書配布や信頼ストア整備へ寄せる)

- タイムアウトとリトライ設計:BMCは高負荷や再起動直後に応答が遅くなることがあります。無限待ちは避け、指数バックオフ等で“抑え込み”を作る

- ログの原本性:取得したJSON/レスポンスを加工前に保存し、後から整形する

- 秘密情報の扱い:トークン/パスワードはコードやログに残さない(マスク、外部秘匿管理、権限分離)

- 冪等・差分:全面上書きより、差分適用と検証(GET→PATCH→GET)を基本にする

Python

- requests系の運用:証明書検証OFF(verify=False)を常用しない。例外的に使うなら“なぜ必要か”を手順書化し、恒久対応を別途計画する

- 例外処理:タイムアウト、接続エラー、JSONパース失敗を分けて扱わないと、原因調査が難しくなる

- ログ出力:デバッグログにAuthorizationヘッダ等が混ざりやすいので、必ずマスクする

Go

- HTTPクライアントの再利用:都度生成すると接続管理が荒れて失敗率が上がることがある(Transport設定、タイムアウト、再試行方針を固める)

- 並列化のやりすぎ:ログ取得を並列にし過ぎるとBMCが詰まり、結果的に取りこぼしが出る。速度より確実性を優先する

Java

- TLS/信頼ストア:自己署名証明書環境で“とりあえず無効化”に流れやすい。運用するなら信頼ストア整備が王道

- HTTPクライアントの選定:接続プール、タイムアウト、リトライの挙動を理解した上で統一する(チーム内で実装が割れると保守が難しい)

JavaScript / Node.js

- 非同期の取り回し:並列に投げやすいが、BMCに負荷をかけ過ぎると失敗が増える。キューイング/並列数制限を入れる

- 例外の握りつぶし:Promiseのエラー処理が曖昧だと、取りこぼしに気づきにくい。必ず失敗件数を集計して通知する

PowerShell

- 証明書の扱い:環境によっては証明書検証まわりの回避コードが出回っているが、運用に残すと監査上の説明が難しくなる

- 文字コード/ログ:ログ保存時のエンコーディングや改行で差分比較が壊れることがある。機械比較用は生JSON、閲覧用は別ファイルに分ける

Bash / curl

- 再現性:ワンライナーは便利だが、復旧手順としてはミスが混ざりやすい。最低限、入力値を変数化し、実行ログを残す

- エラー判定:HTTPステータス、レスポンスボディ、再試行の条件を明確にしないと、成功/失敗が曖昧になる

C# / .NET

- HttpClientの扱い:生成/破棄の設計を誤ると接続が不安定になることがある。タイムアウトと再試行方針を含めて標準化する

- 証明書例外:例外設定を乱用すると、後から統制が効かなくなる。恒久対応(証明書整備)に寄せる

Rust

- 堅牢だが実装が重くなりやすい:小規模運用では、まずは取得・保全・差分の最低限を素早く作る方が被害最小化に直結する

- エラーハンドリング:細かく作り込める分、方針が無いとチームで一貫性が崩れる。失敗分類(ネットワーク/認証/JSON/整合)を決めておく

言語選定そのものより、タイムアウト・証跡・差分・権限・秘密情報の設計が結果を分けます。もし、現場要件(止められない・監査が強い・構成が複雑)に合わせて最短で収束させたい場合は、一般論で無理に押し切らず、株式会社情報工学研究所のような専門事業者に相談して、環境に最適化した手順と実装方針を固めることをおすすめします。

自動化で“抑え込み”:定期スナップショットと設定ドリフト検知

「また消えたらどうするの?」に、現場が一番現実的に答えられるのがここです。原因究明も大事ですが、運用としては“次に起きた瞬間に分かる”状態にしておくことが、結果的にダメージコントロールになります。

スナップショットの基本:Redfishは“取得しやすい”が“保管しにくい”

RedfishはHTTP/JSONなので、設定や状態を定期的に取得すること自体は難しくありません。一方で、取得したJSONは量が多くなりがちで、機密性も含みます(ユーザー構成やネットワーク情報が混じる場合がある)。そこで、スナップショット設計では次を分けます。

- 保存してよい情報:ブート順、BIOS/UEFI関連(公開できる範囲)、ログ設定の有無、ファームウェアバージョンなど

- 秘匿すべき情報:ユーザー名一覧、IP設計、証明書、トークン、秘密鍵に類するもの

「全部取って全部残す」は簡単ですが、監査・セキュリティ上の負債になります。ここは“ノイズカット”で、比較に必要な最小セットを定義するのが堅いです。

ドリフト検知の実務:差分の取り方で運用コストが決まる

ドリフト検知(設定が勝手に変わった検知)で重要なのは、アラートの精度です。誤検知が多いと“アラート疲れ”が起き、肝心なときに見逃します。運用を成立させるために、差分の取り方を段階化します。

| 段階 | 差分の粒度 | 向いている場面 |

|---|---|---|

| レベル1 | “重要キーだけ”の比較(BootOrder等) | まず事故を減らしたい、誤検知を抑えたい |

| レベル2 | サブツリー単位(Managers配下の一部) | 構成が固まっていて、監査要件が強い |

| レベル3 | 広範囲(Systems/Managers/Chassisの複数) | 専任運用がいて、アラートの解釈が回る |

最初はレベル1から始め、運用が回り始めたら段階的に広げるのが、現場負担が増えにくい進め方です。

スナップショットの“証跡性”:改ざん検知と保管期限

「設定が消えた」を説明する場面では、スナップショットが“証跡”として使えることが重要です。最低限、次は押さえます。

- 取得日時・取得元・取得者(実行主体)をメタ情報として残す

- 改ざん検知(ハッシュ付与や署名、変更履歴の追跡が可能な保管)

- 保持期間(ログ保持と同じく、短すぎると意味が薄い)

特に、BMC側のログ保持が短い場合は、外部に“残る証拠”を作るのが被害最小化になります。

アラート設計:通知先は「担当者」ではなく「仕組み」に寄せる

運用でよくある失敗は、通知が個人に閉じることです。夜間や休暇で途切れると、収束が遅れます。おすすめは、

- チケット発行(ITSM等)と連動して「記録が残る」

- オンコールルールで「引き継がれる」

- 重大度で通知先を分ける(軽微なドリフトはまとめて通知)

という、仕組み寄りの設計です。ここまで作ると、第9章の「監査対応・権限分離」に自然に繋がります。

監査対応まで見据える:変更申請・証跡・権限分離をAPI運用に組み込む

Redfishで設定を戻せるようになると、次に問われるのは「じゃあ、誰でも戻せるの?」です。ここで雑に権限を広げると、次の事故の火種になります。運用としては、権限を絞りつつ、必要なときに確実に動かせる形にするのが“ブレーキ”になります。

変更管理の最小要件:チケットがない変更は“後から地獄”

APIでの変更は速い反面、「いつ誰が何を変えたか」が曖昧になりやすいです。だから、最低限ここは運用ルール化します。

- 変更はチケットに紐付ける(緊急でも“事後に必ず”記録)

- 実行ログ(差分ペイロード)を添付(第7章の保存3点セット)

- 承認者と実行者を分ける(小規模でも役割を明確化)

これがあるだけで、社内調整や監査対応の“空気を落ち着かせる”効果が大きいです。

権限分離:最小権限と“壊せる権限”の隔離

BMC操作は強力です。操作できる範囲が広いほど、便利さと引き換えに事故リスクが上がります。そこで、アカウント/権限設計では次を基本にします。

| 役割 | できること | 注意点 |

|---|---|---|

| 閲覧(Read) | 状態参照、ログ参照、スナップショット取得 | まずはこの権限を標準にする |

| 運用変更(Change) | 限定した設定の変更(例:ログ設定、通知設定) | 対象を絞り、差分適用に限定 |

| 緊急復旧(Break-glass) | ブート/ユーザー/ストレージ等の強力操作 | 普段は封印、利用時は監査を厚くする |

“Break-glass”は、事故時に必要になりますが、常用するとリスクが跳ね上がります。普段は封印し、利用時は記録と承認を厚くするのが基本です。

到達経路の固定:踏み台・MFA・ネットワーク分離で“歯止め”を作る

ログ突合(第5章)を強くするためにも、BMCへの到達経路を整理します。

- 管理ネットワークは分離(業務ネットワークから直通しない)

- 踏み台を経由(アクセスログが必ず残る)

- MFA/端末制御(ID基盤側で統制)

これにより、「BMC側ログが薄い」場合でも、外部ログで穴埋めできる確率が上がります。

一般論の限界が出る部分:監査要件と規模で最適解が変わる

ここまでの話は“筋の良い一般解”ですが、実際には、業界の監査要件やシステム規模、保守契約、24/365の稼働要件で最適解は変わります。たとえば、

- 変更承認フローをどこまで形式化するか

- スナップショットの保持期間と保管場所をどうするか

- ベンダー固有機能(監査ログ等)をどう組み込むか

は、個別案件の設計課題です。次の最終章では、Redfishログ分析が最終的に何をもたらすか、そして「専門家に相談すべき境界線」を整理します。

帰結:Redfishログ分析は「復旧」ではなく「運用を壊さない設計」への近道

ここまでの流れを一言でまとめると、Redfishログ分析の価値は「設定を戻す魔法」ではなく、運用を壊さずに収束へ持っていくための共通言語を手に入れることです。

復旧の“成功”を定義し直す:戻っただけでは終わらない

設定が元に見えても、次のどれかが欠けると、また同じ事故が起きます。

- 証跡:何が起きたかを説明できる(ログ・差分・時系列)

- 再現性:同じ手順で同じ結果を得られる(冪等・差分適用)

- 抑え込み:次に起きたらすぐ分かる(ドリフト検知・通知)

- 統制:勝手に変えられない(権限分離・到達経路固定)

この4つが揃って初めて、現場の温度が下がります。

“一般論”の限界ライン:ここを越えたら専門家の出番

一方で、Redfishは標準でも、現場の条件はバラバラです。次の条件が絡むと、一般論だけで安全に進めるのが難しくなります。

- 本番停止が許されない(再起動を伴う変更が絡む)

- ストレージ構成が複雑(RAID/HBA/多経路、仮想化基盤)

- 監査要件が強い(証跡の真正性、職務分掌、ログ保全)

- ベンダー固有実装が深い(標準ログでは足りず、追加解析が必要)

この領域は、判断を誤ると復旧難易度が上がり、影響範囲が広がりやすいです。だからこそ、個別案件として株式会社情報工学研究所のような専門家に相談し、環境条件に合わせた手順・権限・保全設計を組み立てる価値があります。

現場が取りやすい“小さな一歩”:今日からできるチェックリスト

最後に、いきなり大改修ではなく、今日からできる“被害最小化”の一歩を置きます。

- BMCログの保持条件(保持件数/期間)を把握する

- 重要設定だけでも週次でスナップショットを取る

- BMC到達経路を棚卸しし、踏み台/ログを整える

- 共有アカウントがあるなら、段階的に廃止計画を作る

これだけでも、「また起きたときに詰む」確率は下がります。もし、現状の構成や監査要件、ベンダー実装の差で迷う場合は、一般論で無理に押し切らず、株式会社情報工学研究所への相談を検討してください。状況整理と設計から入るだけでも、収束までの時間は短くできます。

付録:現在よく使われるプログラム言語別の注意点(Redfish/API運用)

RedfishはHTTP/JSONなので、どの言語でも扱えます。ただし、実務で事故りやすいポイントは言語や実装スタイルで差が出ます。ここでは「Redfishログ取得・差分比較・PATCH適用」を想定して、注意点を整理します。

共通の注意(言語に依らず必須)

- TLS証明書検証を無効化しない:検証OFFは一時しのぎにはなりますが、運用に残すとリスクが跳ね上がります(どうしても必要なら、正規の証明書配布や信頼ストア整備へ寄せる)

- タイムアウトとリトライ設計:BMCは高負荷や再起動直後に応答が遅くなることがあります。無限待ちは避け、指数バックオフ等で“抑え込み”を作る

- ログの原本性:取得したJSON/レスポンスを加工前に保存し、後から整形する

- 秘密情報の扱い:トークン/パスワードはコードやログに残さない(マスク、外部秘匿管理、権限分離)

- 冪等・差分:全面上書きより、差分適用と検証(GET→PATCH→GET)を基本にする

Python

- requests系の運用:証明書検証OFF(verify=False)を常用しない。例外的に使うなら“なぜ必要か”を手順書化し、恒久対応を別途計画する

- 例外処理:タイムアウト、接続エラー、JSONパース失敗を分けて扱わないと、原因調査が難しくなる

- ログ出力:デバッグログにAuthorizationヘッダ等が混ざりやすいので、必ずマスクする

Go

- HTTPクライアントの再利用:都度生成すると接続管理が荒れて失敗率が上がることがある(Transport設定、タイムアウト、再試行方針を固める)

- 並列化のやりすぎ:ログ取得を並列にし過ぎるとBMCが詰まり、結果的に取りこぼしが出る。速度より確実性を優先する

Java

- TLS/信頼ストア:自己署名証明書環境で“とりあえず無効化”に流れやすい。運用するなら信頼ストア整備が王道

- HTTPクライアントの選定:接続プール、タイムアウト、リトライの挙動を理解した上で統一する(チーム内で実装が割れると保守が難しい)

JavaScript / Node.js

- 非同期の取り回し:並列に投げやすいが、BMCに負荷をかけ過ぎると失敗が増える。キューイング/並列数制限を入れる

- 例外の握りつぶし:Promiseのエラー処理が曖昧だと、取りこぼしに気づきにくい。必ず失敗件数を集計して通知する

PowerShell

- 証明書の扱い:環境によっては証明書検証まわりの回避コードが出回っているが、運用に残すと監査上の説明が難しくなる

- 文字コード/ログ:ログ保存時のエンコーディングや改行で差分比較が壊れることがある。機械比較用は生JSON、閲覧用は別ファイルに分ける

Bash / curl

- 再現性:ワンライナーは便利だが、復旧手順としてはミスが混ざりやすい。最低限、入力値を変数化し、実行ログを残す

- エラー判定:HTTPステータス、レスポンスボディ、再試行の条件を明確にしないと、成功/失敗が曖昧になる

C# / .NET

- HttpClientの扱い:生成/破棄の設計を誤ると接続が不安定になることがある。タイムアウトと再試行方針を含めて標準化する

- 証明書例外:例外設定を乱用すると、後から統制が効かなくなる。恒久対応(証明書整備)に寄せる

Rust

- 堅牢だが実装が重くなりやすい:小規模運用では、まずは取得・保全・差分の最低限を素早く作る方が被害最小化に直結する

- エラーハンドリング:細かく作り込める分、方針が無いとチームで一貫性が崩れる。失敗分類(ネットワーク/認証/JSON/整合)を決めておく

言語選定そのものより、タイムアウト・証跡・差分・権限・秘密情報の設計が結果を分けます。もし、現場要件(止められない・監査が強い・構成が複雑)に合わせて最短で収束させたい場合は、一般論で無理に押し切らず、株式会社情報工学研究所のような専門事業者に相談して、環境に最適化した手順と実装方針を固めることをおすすめします。

Redfish APIのログサービスを活用し、ResourceRemovedイベントの検出から設定削除の原因分析、PATCHによる迅速な復旧まで実践的に解説します。

事業継続計画(BCP)の基本3重化構成と緊急時・無電化時・システム停止時の運用フェーズを連携し、事業継続性を確保する設計手法を紹介します。

個人情報保護法やBCPガイドラインの最新動向をフォローし、経営層向けにわかりやすく説明する資料作成のポイントを提示します。

- 出典:個人情報保護委員会『個人情報の保護に関する法律』2017年

- 出典:内閣府『事業継続計画策定支援ハンドブック』2018年

Redfish APIの基本とログサービス概要

Redfish APIは、サーバのハードウェア管理を標準化するRESTfulインターフェース仕様です。DMTF(Distributed Management Task Force)により策定され、BMC(Baseboard Management Controller)経由で電源制御やファームウェア更新、ログ取得などを統一的に操作できます。本章では、Redfish APIの構造と、その中でログを管理するLogServiceリソースの概要を解説します。

API仕様の背景

サーバ管理には従来 IPMI等ベンダー依存の仕様が用いられていましたが、複数ベンダー環境では運用が複雑化します。RedfishはJSON/HTTPSを用いるREST APIとして設計され、標準化されたURI空間とスキーマにより異機種混在環境での運用負荷を軽減します。

LogServiceリソースとは

RedfishのLogServiceは、BMCが保持する各種ログ(イベントログ、システムログ、安全性ログなど)を表すリソースです。LogServiceコレクションは`/redfish/v1/Managers/{managerId}/LogServices`以下にあり、各エントリは`/Entries`サブコレクションで個別に参照できます。

主なLogService種別

- SEL(System Event Log)…ハードウェアイベント記録

- IML(Integrated Management Log)…Redfish管理イベント

- Lclog…ベンダー独自のログサービス

技術担当者は上司に対し、Redfish APIがRESTfulな標準インターフェースであること、各LogServiceがサーバの稼働履歴を取得する役割を担う点を強調し、運用影響を共有してください。

技術担当者はRedfish APIのリソース階層とLogServiceコレクションの位置関係を正確に理解し、どのURIでログ操作を行うかを意識しましょう。

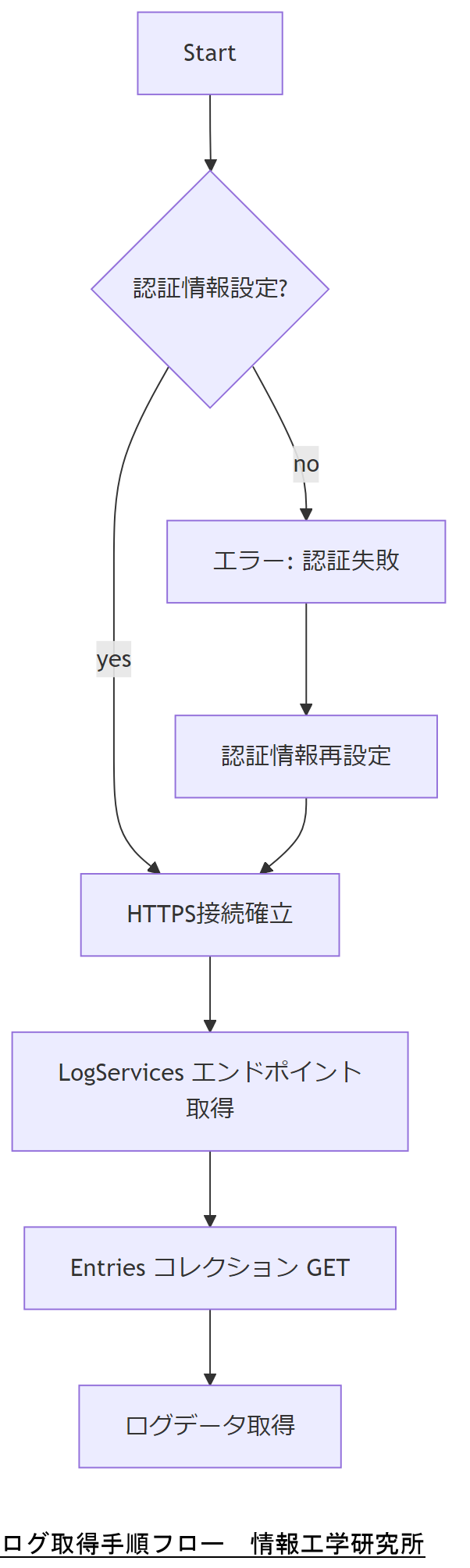

ログ取得手順と環境設定

Redfish APIでログを取得するためには、BMC(Baseboard Management Controller)へのHTTPS接続と適切な認証情報が必要です。まずは管理者アカウントを用意し、HTTPS通信を許可したクライアント環境を整えます。

認証方式の設定

一般的にRedfishではベーシック認証が用いられ、ユーザー名とパスワードをBase64エンコードしてHTTPヘッダーに含めます。また、より安全なトークン認証に対応するBMCも増えています。

HTTPS証明書の信頼設定

BMCが自己署名証明書を使用している場合、クライアント側で証明書を信頼リストに追加するか、curl等で証明書検証を無効化(-kオプション)します。ただし運用環境では証明書を発行機関から取得することが推奨されます。

ログ取得コマンド例

以下はSELログを取得するcurlコマンドの例です。

curl -k -u admin:password \

https://bmc.example.com/redfish/v1/Managers/1/LogServices/Sel/Entries

技術担当者は上司に、HTTPSと認証設定が正確でないとログ取得が失敗する点を共有し、証明書運用ポリシーの遵守を確認してください。

クライアント環境の証明書管理と認証方式を理解し、真偽性の担保とログ取得の安定性を両立させることを意識しましょう。

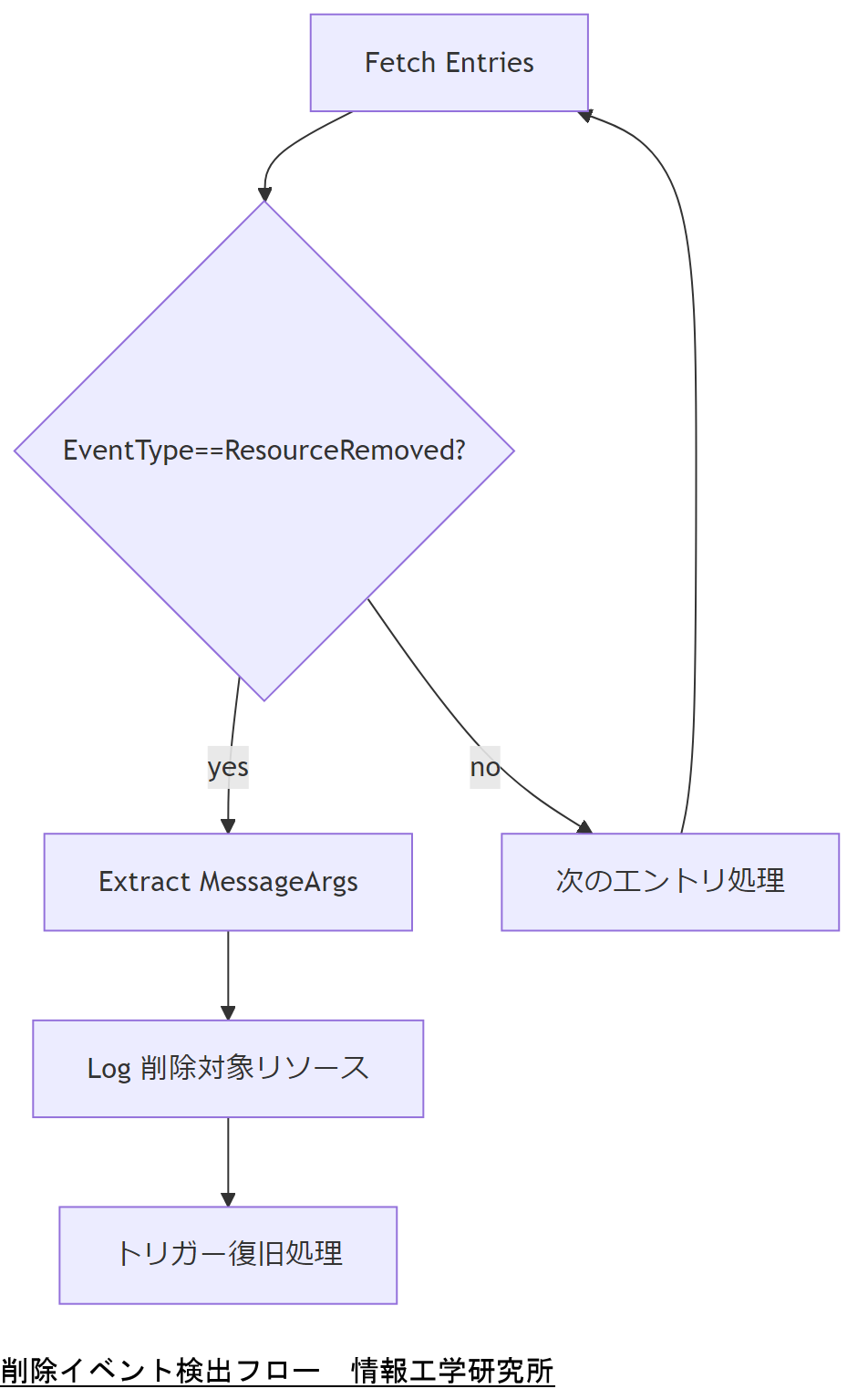

削除操作イベントの検出ロジック

LogEntryには

EventTypeによるフィルタリング

各エントリの

MessageIdとMessageArgsの活用

MessageIdでより詳細に操作種別を判定し、MessageArgs配列から削除された具体的リソース名(例:NetworkProtocol)を取得します。削除前後の状態比較を自動化するためにも必要な情報です。

検出スクリプト概要

Python等で以下のような処理を行います。

1. EntriesコレクションをGET

2. 各LogEntryをパースしてEventTypeをチェック

3. ResourceRemovedの場合はMessageArgsをリスト化

4. 対象リソース名をログ出力・アラート通知

技術担当者は上司に、EventTypeとMessageArgsの組み合わせで確実に削除操作を特定できる点を説明し、誤検出防止策を共有してください。

削除イベントの検出条件を明確にし、フィルタリング漏れや誤検出を防ぐためのテストケースを設計しましょう。

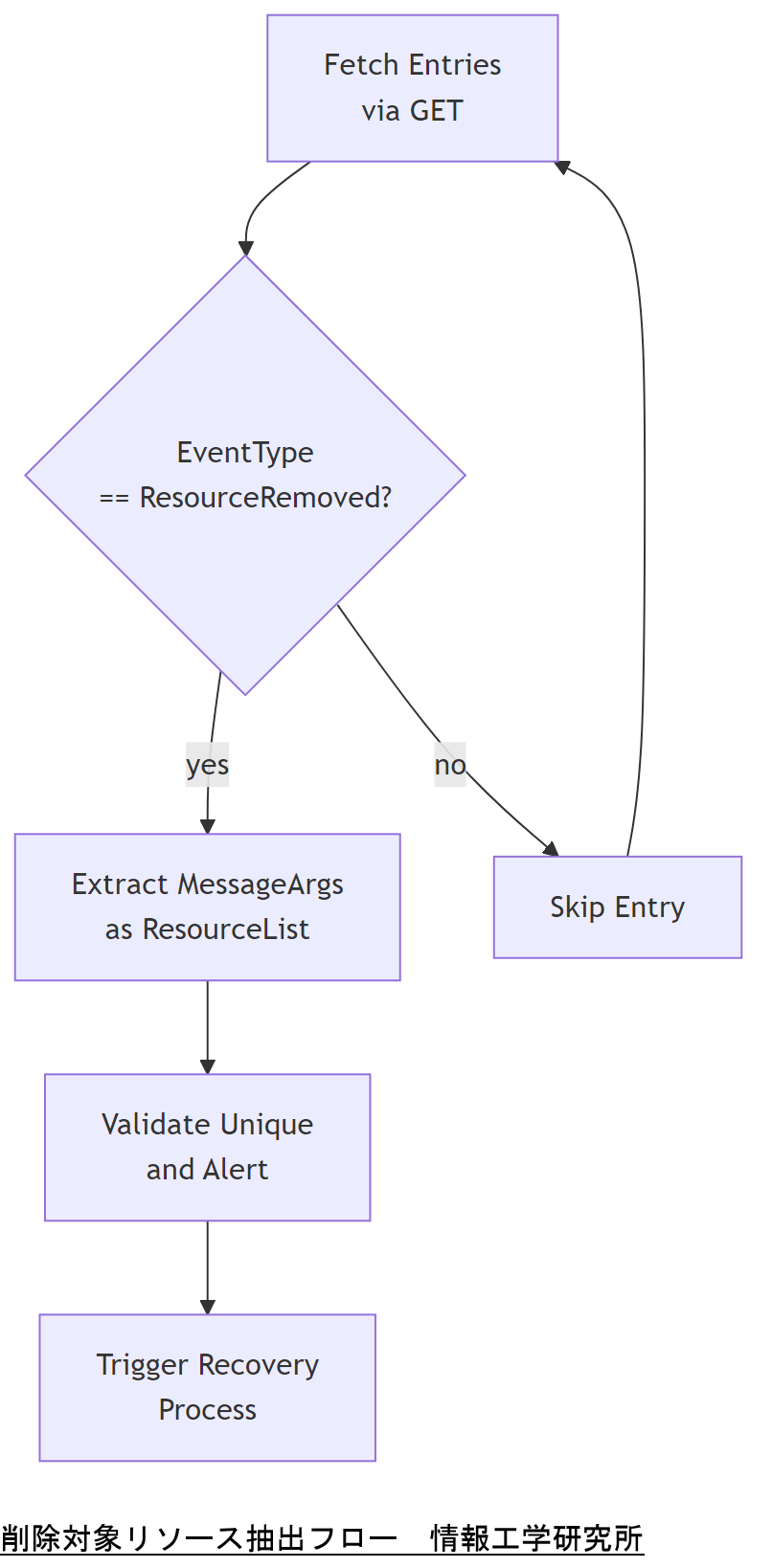

削除対象リソースの特定方法

LogEntryのMessageArgs配列には、削除対象リソース名が格納されます。

MessageArgsは、JSONペイロード内のフィールドで、複数の要素を含む場合があります。

たとえばNetworkProtocolの削除では、["NetworkProtocol"]がMessageArgsに含まれます。

MessageIdはResourceRemoved以外の操作種別判定にも利用されます。

MessageIdはDMTF標準仕様に基づき一意の識別子を持ちます。

削除対象リソースの特定は自動化スクリプトの重要箇所です。

Pythonでの抽出例として、jsonモジュールを用いたパースが一般的です。

抽出後は一覧化し、重複や誤検出を排除するバリデーション処理を推奨します。

実運用ではWebhook通知やログ監視システムへの連携も検討します。

これにより、削除操作の影響範囲を即座に把握できます。

Pythonスクリプト例

以下はMessageArgsからリソース名を抽出する簡易スクリプト例です。

- EntriesコレクションをGETし、JSONレスポンスを取得

- 各LogEntryの"EventType"=="ResourceRemoved"をフィルタ

- "MessageArgs"フィールドを抽出し、対象リソース名をリスト化

技術担当者は上司に、MessageArgsで正確に削除対象を特定し、誤検出を防ぐためのバリデーション手順を共有してください。

技術担当者は、抽出ロジックのテストケースを設計し、異なるLogService種別でも一貫して動作することを確認しましょう。

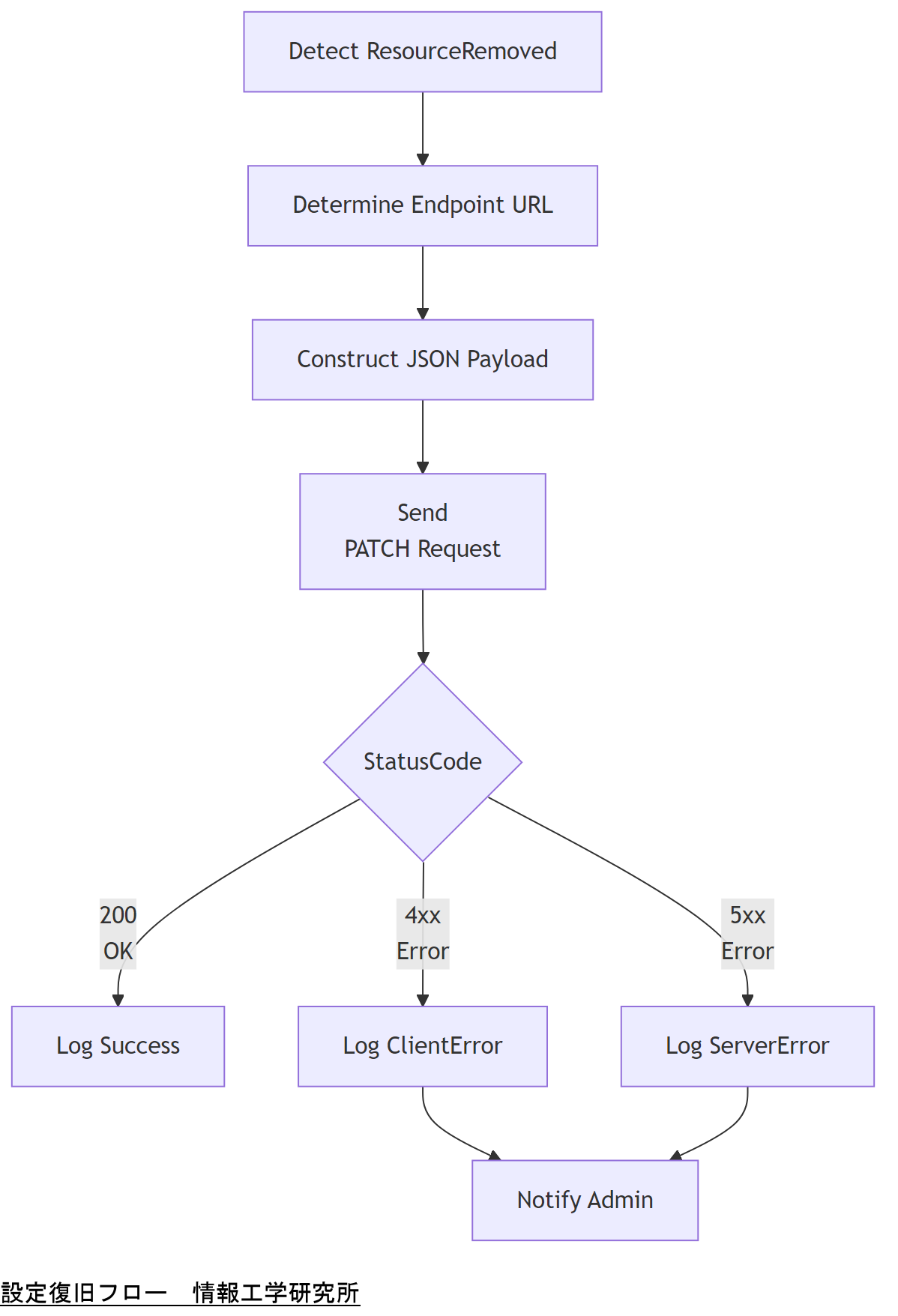

設定復旧フローの設計と実装例

削除されたリソースを復旧するには、Redfish APIのPATCHメソッドを用いて対象エンドポイントに再度適切なプロパティを送信します。たとえばNetworkProtocolリソースのHTTP/HTTPS/SSH設定を再有効化できます。PATCHは部分的更新を行うHTTPメソッドです。

NetworkProtocolの再設定例:

curl -k -u admin:password -X PATCH https://bmc.example.com/redfish/v1/Managers/1/NetworkProtocol- ヘッダー:

Content-Type: application/json - ボディ:

{"HTTP": true, "HTTPS": true, "SSH": true}

このリクエストに成功すると、BMCは指定プロトコルを有効化し、200 OKが返されます。

エラーハンドリングとしては、HTTPステータスコードを確認し、4xx系はリクエスト不備、5xx系はBMC側の問題と判断します。再試行やログ出力、運用通知を組み込むことで運用品質を向上できます。

技術担当者は上司に、PATCHによる設定復旧が部分更新である点と、成功・エラーコードの意味を共有し、運用手順書の更新を依頼してください。

実装時には、対象エンドポイントと更新プロパティが正しいかを仕様書と突合し、誤った更新を防止するテストケースを整備することが重要です。

自動化スクリプトと運用ツール提案

Redfish APIを活用したログ分析と復旧処理は、人手による運用では対応が遅れるため、スクリプトやツールで自動化することが重要です。OpenUSMはRedfish APIベースでサーバ管理とログ分析を行うオープンソースツールとして知られています。

OpenUSMはDockerコンテナ化されており、ELKスタックと組み合わせてログの可視化・アラート通知を実装できます。

Pythonスクリプト例として、OpenBMC Test Automationリポジトリのeventlogテスト自動化では、ResourceRemovedイベントの生成から検証までを実現しています。

DellのiDRAC用Pythonスクリプトでは、ライフサイクルコントローラのログを取得し、特定のMessageIdでフィルタリングするサンプルが公開されています。

HPE iLO用APIドキュメントには、NetworkProtocolリソースのPATCH例が掲載されており、自動処理のコード化に役立ちます。

Collabnixのブログでは、Windows環境向けにRedfishでログを取得し、Logstash→Elasticsearch→Kibanaに流すワークフローを紹介しています。

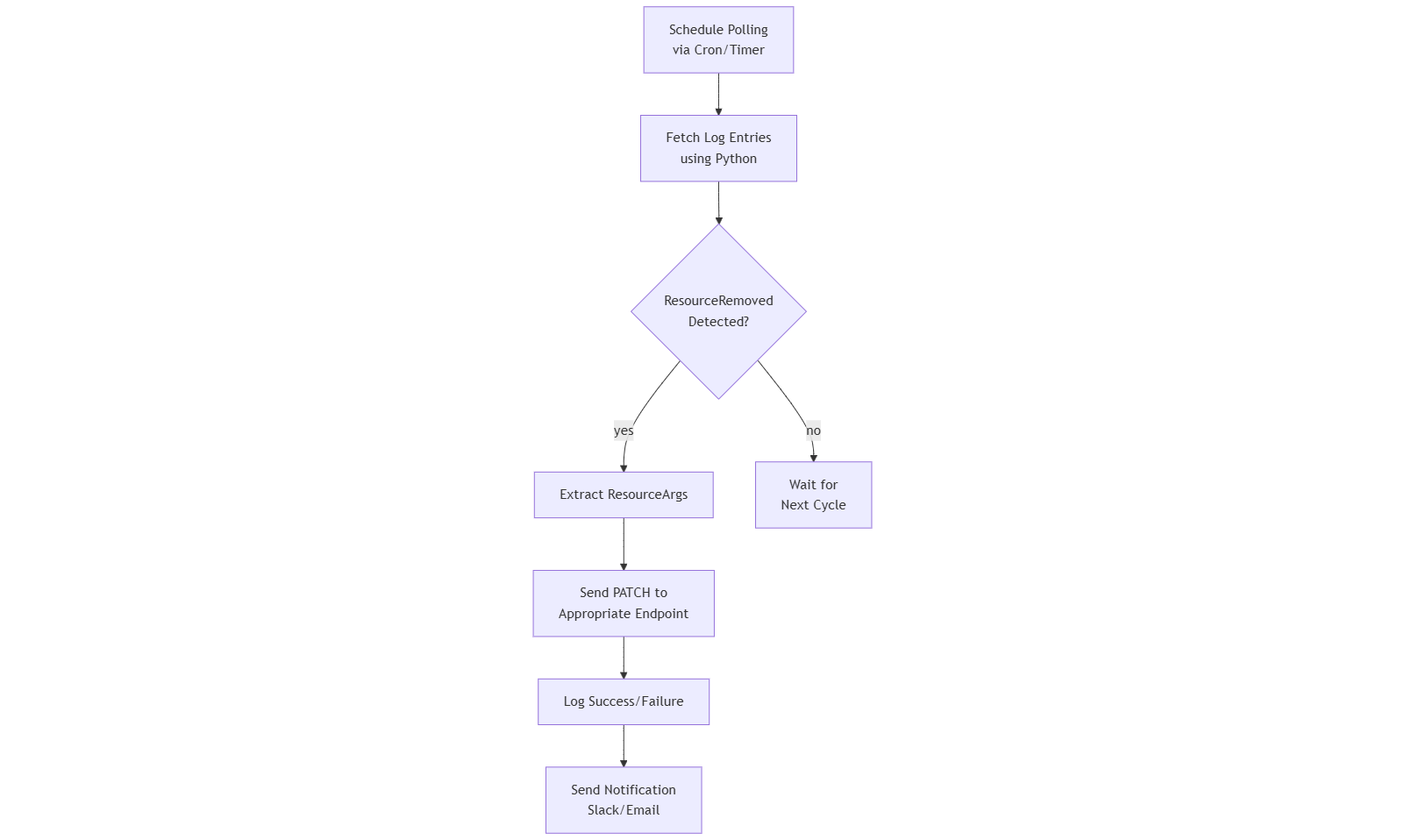

運用ツールとしては、定期的にEntriesをポーリングし、ResourceRemovedを検出したら自動でPATCHを実行するフローを組み込むことが推奨されます。

システム運用ではCronやSystemdタイマーでスクリプトをスケジューリングし、障害発生時にはSlackやメール通知を連携することで迅速な対応が可能になります。

ワークフロー例:

技術担当者は運用ツールの導入により人的ミスを削減し、定期実行とアラート連携で対応速度を向上できる点を上司に報告してください。

スクリプトの自動化により監視・復旧が高速化されますが、テスト環境で十分に動作検証し、誤動作時のフェイルセーフを必ず設計することを心がけましょう。

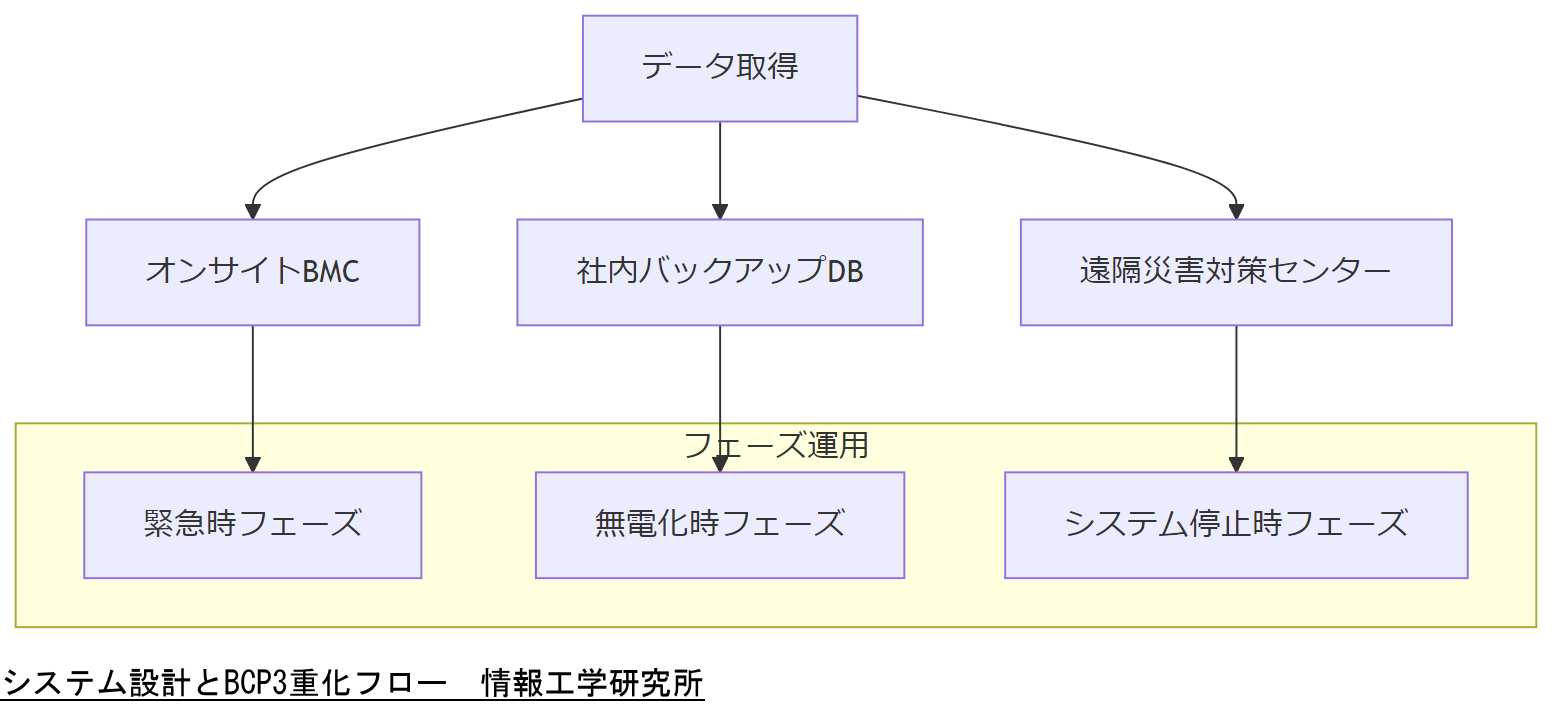

システム設計とBCP連携

サーバ管理基盤においては、ログ分析による復旧機能だけでなく、事業継続計画(BCP)と連携した冗長化設計が不可欠です。BCPでは、データ保存を3重化し、緊急時・無電化時・システム停止時の3段階フェーズ運用を想定します[出典:内閣府防災情報『事業継続ガイドライン』令和5年]。

まず、データ保存はオフサイト含む3重バックアップが基本です。オンサイトのBMCログ、社内バックアップサーバ、遠隔災害対策センターの3拠点に分散配置し、単一障害点を排除します[出典:内閣府防災情報『BCP文書構成モデル例』平成18年]。

次に、運用フェーズは以下の3段階で設計します[出典:厚生労働省『BCP策定の手引き』令和3年]:

- 緊急時フェーズ:災害発生直後の初動対応。ログ収集・解析チームと運用チームを即時稼働させ、ResourceRemovedイベント検出・復旧を行います。

- 無電化時フェーズ:電力供給が途絶した場合、UPSや非常用発電機の起動を前提に、オフサイトシステムからのログアクセスと復旧コマンド発行を継続します。

- システム停止時フェーズ:主要システムが停止した場合は、遠隔SOC(Security Operations Center)からの遠隔制御でログ分析・復旧スクリプトをトリガーします。

ユーザー数10万人以上など大規模環境では、さらに細分化したフェーズ設計や拠点間連携が求められます[出典:中小企業庁『中小企業BCPガイド』平成20年]。

BCP連携設計では、3拠点のデータ保存や3段階フェーズ運用が事業継続の要であることを共有し、運用規程への反映を依頼してください。

技術担当者は、各フェーズにおけるログアクセス経路と復旧スクリプトの起動条件を明確化し、リハーサル演習で実効性を検証しましょう。

デジタルフォレンジック視点の履歴管理

サイバー攻撃や内部不正の発生時には、ログの改ざんや消失を防ぐ信頼性の高いログ保全が必須です。Redfish APIのLogServiceはイベントログをJSON形式で厳格に記録し、タイムスタンプやイベントIDによって改ざん検知にも活用できます。

ログの完全性確保

ログファイル格納前にハッシュを生成し、オフサイトの監査用ストレージへ転送します。これにより、後からログの改ざんを検出できます。

マルウェア検出連携

LogEntryのMessageミッセージに異常な振る舞い(例:UnexpectedReset)が記録された場合、自動でセキュリティインシデント対応チームへ通知します。

内部不正対応履歴

管理者操作の履歴を専用DBに二重記録し、ログ保全と追跡可能性を確保します。管理者ログイン/設定変更/削除操作のすべてが対象です。

技術担当者は上司に、ログ保全プロセスでハッシュ付与とオフサイト保管を行い、改ざん検知体制を構築する必要性を共有してください。

技術担当者は、ハッシュ生成と検証のタイミング設計を行い、インシデント発生時に即座に改ざんの有無を判断できる体制を検討しましょう。

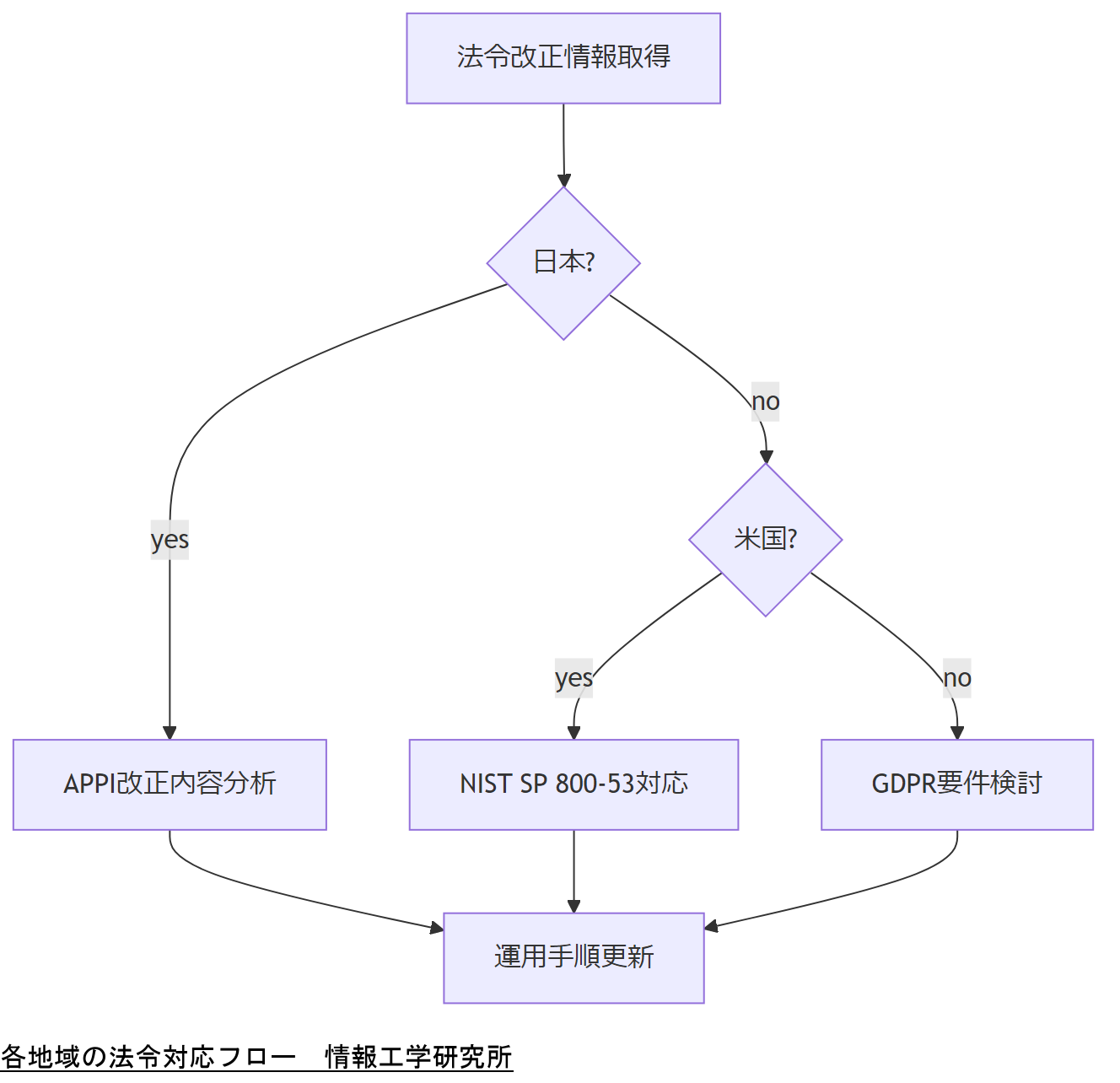

法令・政府方針の最新動向

個人情報保護や運用ガイドラインは頻繁に改定されるため、Redfish API活用時にも法令遵守が求められます。本章では、日本、米国、EUそれぞれの最新法令・政府方針を概観し、サーバ管理運用への影響と対応策を解説します。

日本:個人情報保護法(APPI)

改正個人情報保護法は2022年4月1日に施行され、保護措置の強化や匿名加工情報の利用拡大を規定しています。サーバ管理者はログに含まれる個人識別符号が適切に扱われているか確認が必要です。

米国:FISMA/NIST SP 800-53

米連邦情報セキュリティ管理法(FISMA)は政府機関向けセキュリティ基準を定め、NIST SP 800-53ではアクセス制御や監査ログの保存要件を詳細に規定します。商用サーバでも同等レベルの運用がベストプラクティスとされています。

EU:GDPR(一般データ保護規則)

EU一般データ保護規則(Regulation 2016/679)は、EU域内の個人データ処理に厳格な条件を求めます。ログ監査ではデータ主体の権利(アクセス権・削除権)対応を含めた運用ルール策定が必要です。

技術担当者は、各地域の最新法令要件がサーバ運用に及ぼす影響を整理し、運用ポリシーへの反映を上司に依頼してください。

技術担当者は法令ごとのログ保存期間やアクセス権管理など要件を詳細に確認し、監査対応可能な運用フローを設計しましょう。

- 出典:個人情報保護委員会『個人情報の保護に関する法律概要』2022年

- 出典:米国国立標準技術研究所『Security and Privacy Controls for Federal Information Systems and Organizations SP 800-53 Revision 5』2020年

- 出典:欧州連合『Regulation (EU) 2016/679 (General Data Protection Regulation)』2016年

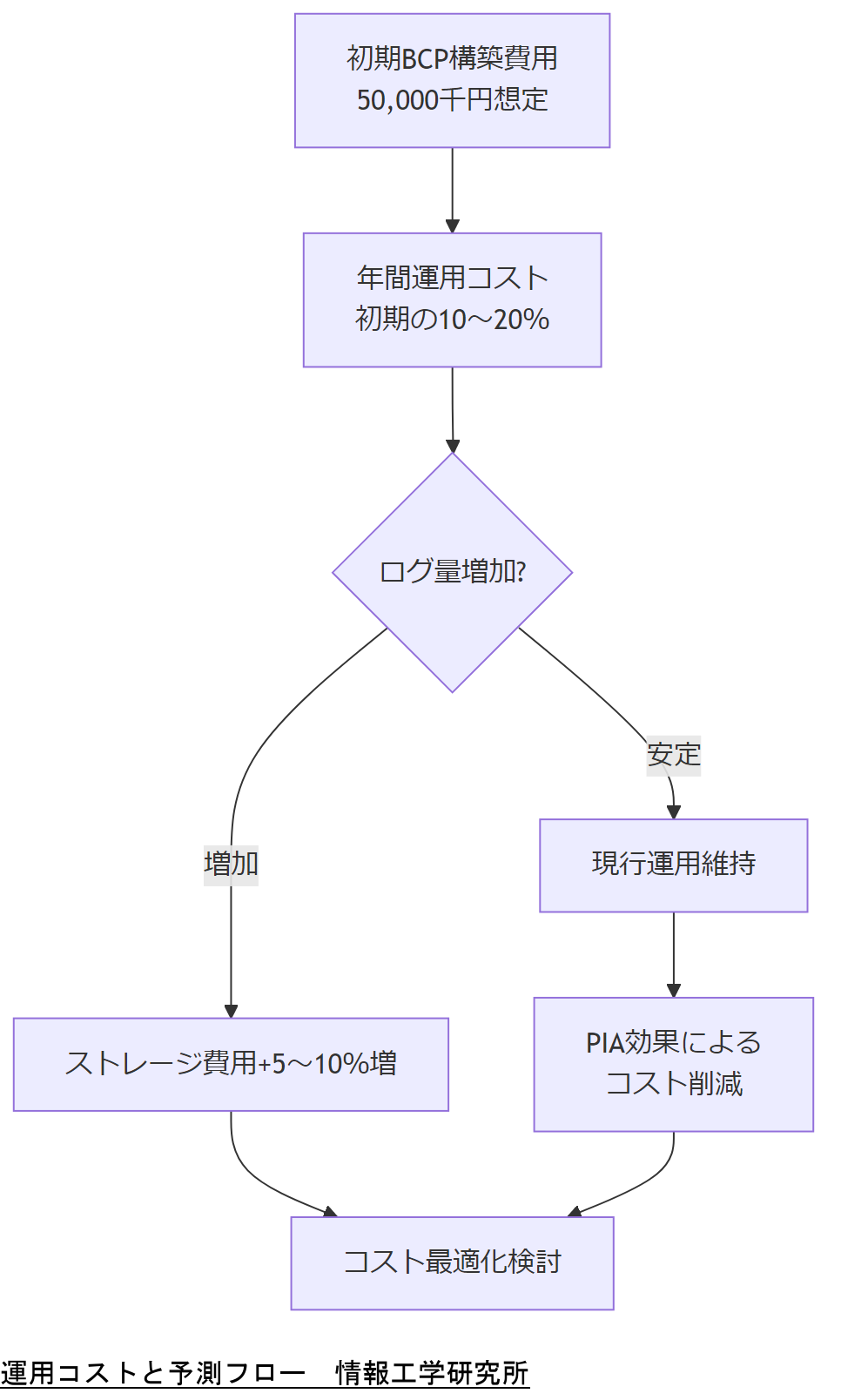

運用コストと今後2年の予測

サーバ管理とBCP運用に伴うコストは、初期構築費用だけでなく定期的な訓練・見直し・システムメンテナンスに要する費用が含まれます。

現在の運用コスト構成

中小企業BCP策定運用指針によると、事前対策として設備復旧費用用の資金調達例は約50,000千円(5,000万円)を想定しています【出典:中小企業庁『事業継続力強化計画 策定の手引き』令和5年】。

同ガイドラインでは、人材トレーニング・訓練費用、外部監査実施費用も別途計上することが推奨されており、年間で導入費用の10~20%相当が運用コストに充てられるケースが多いとされています【出典:中小企業庁『中小企業BCP策定運用指針 第2版』平成18年】。

個人情報保護法(APPI)対応では、プライバシー影響評価(PIA)の実施による初期導入コストが発生する一方で、長期的には事故対策・罰則回避によるコスト削減効果が報告されています【出典:個人情報保護委員会『PIAの取組の促進について―PIAの意義と実施順に沿った留意点』平成31年】。

今後2年のコスト予測

■■推測■■ 2025年から2026年にかけては、ログ保持要件の強化とクラウド連携によるデータ量増加が見込まれ、ストレージ運用コストが年間5~10%程度上昇する可能性があります。

GDPRでは通知義務の削減がコスト低減に寄与していますが、データ主体からのアクセス・削除要求対応など運用負荷は依然として高水準です【出典:EUR-Lex『Regulation (EU) 2016/679 Impact Assessment』2016年】。

米国FISMA準拠では、定期的な監査と評価報告の作成が必要であり、NIST SP 800-53準拠の運用コストは年間数万ドル規模となるケースがあります【出典:CISA『FY 2024 IG FISMA Metrics Evaluation Guide』2024年】。

国内DX調査によると、事業継続計画(BCP)を策定・訓練実施している企業は70%超えとなり、BCP運用への投資意欲の高まりがうかがえます【出典:経済産業省『デジタルトランスフォーメーション調査2025の分析』令和7年】。

技術担当者は、BCP運用コストの内訳(初期構築 vs 年間運用)や、今後のストレージ費用上昇リスクを上司に説明し、予算計画の見直しを依頼してください。

技術担当者は、年間予算案に必要コストを反映し、ログ保持要件やクラウド利用料増加への対応策を事前に準備しましょう。

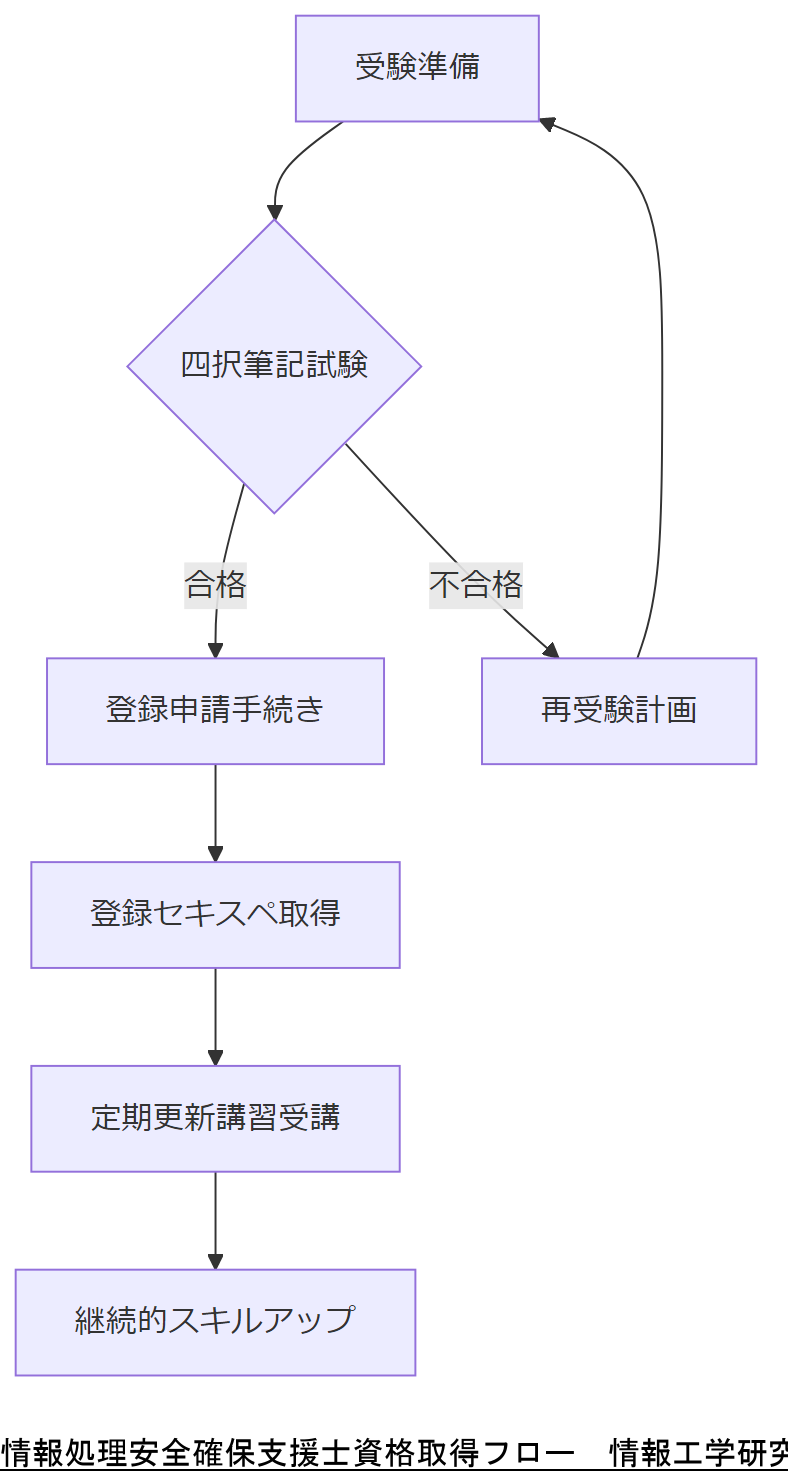

該当資格と人材育成・募集計画

Redfish APIログ分析・復旧運用を担う技術者には、国家資格「情報処理安全確保支援士」が最適です。登録後は、組織内外でセキュリティコンサルタントや運用担当者として活躍できる能力証明となります。

情報処理安全確保支援士(RISS)試験概要

本試験は春期(4月)・秋期(10月)年2回、筆記試験で実施されます。合格後、経済産業大臣から合格証書が交付され、所定の登録手続きを経て国家資格「情報処理安全確保支援士(登録セキスペ)」となります。

登録手続きと講習

合格後はIPAが主催する登録申請手続きと、定期的な更新・講習受講が義務付けられています。講習では最新の脅威動向やフォレンジック技術を学び、実践力を維持します。

人材育成プラン例

- 研修導入:基礎講座(IT基盤/ネットワーク/セキュリティ原則)

- 実践演習:Redfish APIを用いたログ取得・解析ハンズオン

- 資格取得支援:試験問題集配付、模擬試験実施

- フォローアップ:半年ごとのナレッジ共有/脆弱性分析演習

募集計画のポイント

- 募集要件:情報処理安全確保支援士合格者優遇

- 役割定義:ログ分析・復旧スクリプト開発・BCP設計支援

- 配属初期:OJTによるRedfish環境構築から運用開始

- 中長期:定期講習・資格更新への支援体制整備

技術担当者は、RISS資格取得から登録セキスペ取得、定期講習によるスキル維持の流れを上司に説明し、受験支援制度の整備を依頼してください。

技術担当者は、自社の人材育成ロードマップにRISS試験・講習スケジュールを組み込み、OJTと資格取得を連動させて計画的にスキルを強化しましょう。

- 出典:IPA『情報処理安全確保支援士試験』2023年6月30日

- 出典:IPA『情報処理安全確保支援士(登録セキスペ)の受講する講習について』2024年

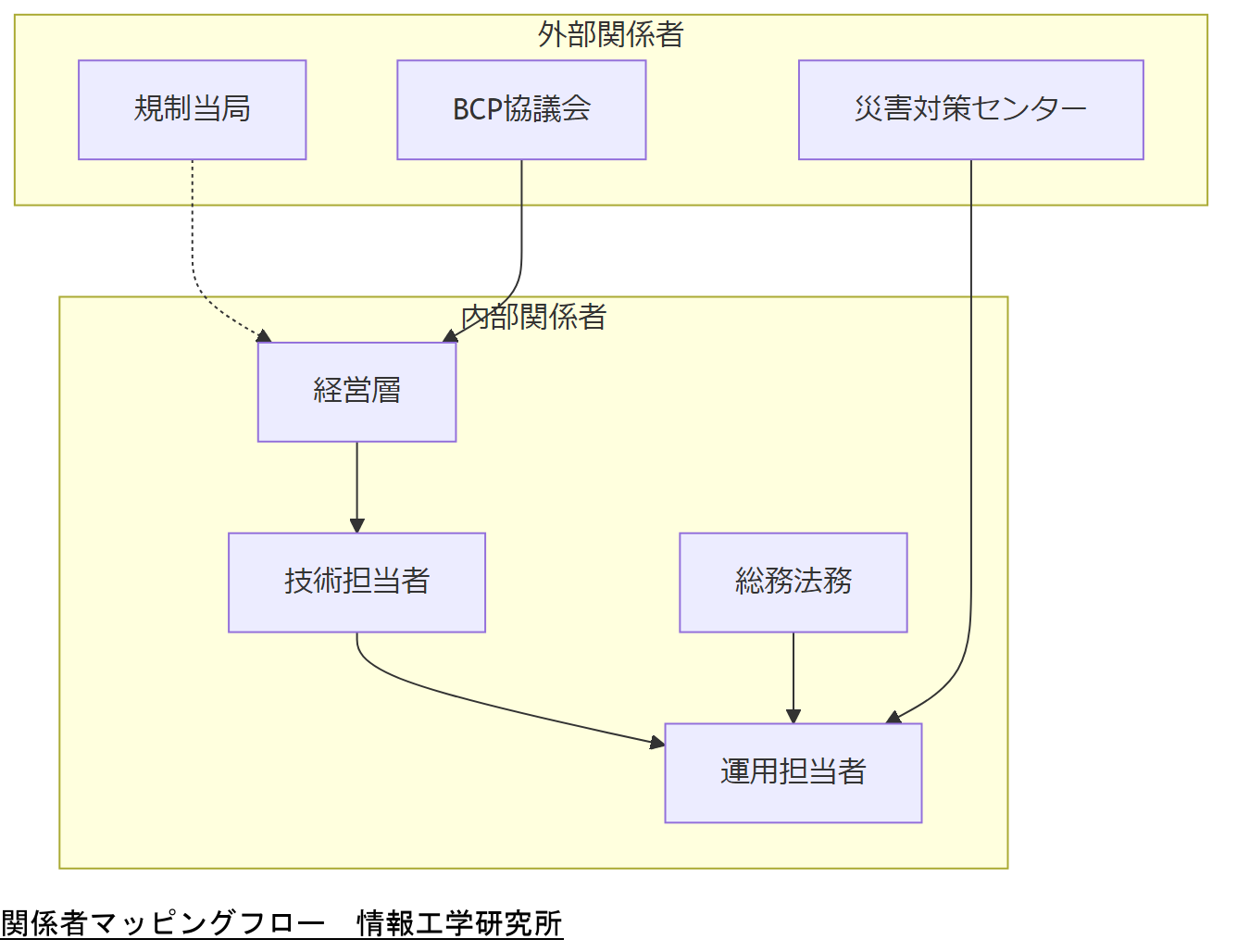

関係者マッピングと注意点

サーバ管理ログ分析および復旧運用においては、企業内外の多様な関係者が関与します。適切なマッピングと注意点の整理により、スムーズな連携と意思決定を実現します。

内部関係者の役割

- 経営層:事業継続の最終判断と予算確保を担当します。[出典:内閣府防災情報『事業継続ガイドライン』令和5年]

- 技術担当者:Redfish API設定・スクリプト実装、ログ分析を担います。

- 運用担当者:日常監視とアラート対応、復旧手順実行を担当します。

- 総務/法務:コンプライアンス確認、ログ保全ポリシーの整備を行います。

外部関係者の役割

- 規制当局:法令遵守状況を監督し、監査を実施します。

- 災害対策センター:オフサイトでのログ保全・バックアップを提供します。

- BCP協議会:関係者合意の下、連携体制を維持します。[出典:国土交通省『港湾の事業継続計画策定ガイドライン』平成31年]

注意点

- 関係者間の責任範囲を明確化し、二重・未実施を防止する。

- 権限不足による操作遅延を避けるため、権限委譲ルールを整備。

- 定期的な連絡体制と連携訓練を実施し、緊急時の混乱を軽減。

技術担当者は、社内外の関係者とその役割を整理し、二重対応や責任不明確を防ぐためのマッピング結果を上司に共有してください。

技術担当者は、関係者ごとの権限と責任を明文化し、緊急連絡網とエスカレーション手順を定期的に検証・更新しましょう。

外部専門家へのエスカレーション

自社だけで対応が困難な障害やログ解析においては、外部専門家への早期エスカレーションが重要です。本章では、エスカレーション判断基準と手順を示します。

エスカレーション判断基準

- 復旧スクリプトのエラーが連続して発生し、ログ復元不能と判断した場合【想定】

- BMCファームウェアの根本的問題によるログ取得失敗が解消しない場合【想定】

- 影響範囲が経営判断を要する重大インシデントに発展しそうな場合【想定】

エスカレーション手順

- 技術担当者がエラー内容と影響範囲を整理

- 上司へエスカレーション提案書をメールまたは口頭で提出

- 情報工学研究所へお問い合わせフォーム経由で相談・支援を依頼【想定】

- 専門家による初期調査結果を受領後、追加作業スケジュールを共有

技術担当者は、エスカレーション基準に該当した際に速やかに情報工学研究所へ相談し、現状と依頼内容を端的に共有する必要性を伝えてください。

技術担当者は、自社対応フェイズの限界を判断するためのチェックリストを用意し、判断ミスを防ぐためのレビュー体制を整備しましょう。

おまけの章:重要キーワード・関連キーワードマトリクス

本記事で扱った主要概念と関連キーワードをマトリクス形式でまとめました。用語の理解にご活用ください。

キーワードマトリクス| キーワード | 説明 |

|---|---|

| Redfish API | サーバ管理用RESTful標準インターフェース |

| LogService | イベントログ取得リソース |

| ResourceRemoved | リソース削除イベントタイプ |

| PATCH | 部分更新用HTTPメソッド |

| BCP | 事業継続計画 |

| 情報処理安全確保支援士 | 国家資格によるセキュリティ専門家 |

| デジタルフォレンジック | 証拠保全・解析技術 |

| コンセンサス形成 | 社内承認プロセス |

まとめと次のステップ

本記事では、Redfish APIによるログ分析から設定削除の検出、復旧フローの実装、BCP連携、法令対応、人材育成まで幅広く解説しました。これらを総合的に導入することで、万が一の設定削除や障害発生時にも迅速な復旧と事業継続が可能になります。

記事全体のポイント整理

- Redfish APIのLogServiceを使った確実な削除イベント検出

- PATCHによる部分更新を活用した復旧自動化

- BCPの3重化設計と緊急/無電化/停止時フェーズ運用

- 個人情報保護法・GDPR・FISMAなど各地の法令対応

- 情報処理安全確保支援士資格による体制強化

次のステップ

- 本番環境でのスクリプト動作検証と運用品質テスト

- BCP演習の定期実施とリハーサル結果のフィードバック

- 定期的な法令改定チェックと運用ルールの更新

- 人材育成ロードマップへの資格取得計画組み込み

- 情報工学研究所へのご相談:より高度な復旧・運用支援

技術担当者は、本記事の全ポイントを踏まえた上で、運用改善とBCP強化のための予算・スケジュール計画を経営層へ提案してください。

技術担当者は、この記事を基礎に定期的なレビュー・演習を繰り返し、運用チームと連携しながら実効性を高めていきましょう。

はじめに

Redfish APIの重要性とログ分析の必要性 近年、ITインフラの管理がますます複雑化する中、Redfish APIはサーバ管理の標準インターフェースとして注目を集めています。このAPIは、ハードウェアの管理を効率化し、運用の自動化を促進するための重要なツールです。しかし、Redfish APIを使用する際には、生成されるログの分析が不可欠です。ログ分析は、システムの健全性を把握し、潜在的な問題を早期に発見するための手段です。特に、削除設定が誤って行われた場合、迅速な復旧が求められます。 ログ分析を通じて、サーバの動作状況やエラーメッセージを把握することで、問題の根本原因を特定し、適切な対策を講じることが可能です。これにより、業務の継続性を確保し、データ損失のリスクを低減することができます。Redfish APIのログは、システムの状態をリアルタイムで反映しているため、適切な分析を行うことで、より効果的なサーバ管理が実現します。次の章では、Redfish APIのログの具体的な内容と、その分析方法について詳しく探っていきましょう。

Redfish APIとは?サーバ管理の新しい標準

Redfish APIは、サーバ管理を効率化するための新しい標準インターフェースとして、特にデータセンターやクラウド環境での利用が進んでいます。このAPIは、RESTfulアーキテクチャに基づいており、HTTPプロトコルを利用してリソースにアクセスするため、直感的で使いやすいのが特徴です。Redfishは、従来の管理プロトコルと比較して、より柔軟で拡張性の高い設計がされています。 Redfish APIは、サーバのハードウェア情報、状態、設定を取得するための統一された方法を提供します。これにより、異なるベンダーのハードウェアを一元管理することが可能になり、運用の効率化が図れます。また、JSON形式でデータをやり取りするため、人間にも理解しやすい構造になっています。 さらに、Redfishは、セキュリティ機能も強化されています。APIの認証には、OAuthやBasic Authenticationが使用され、データの保護が図られています。これにより、システム管理者は安心して操作を行うことができ、重要なデータの保護が強化されます。 このように、Redfish APIは、サーバ管理における新しいスタンダードとして、効率性とセキュリティを両立させる重要な役割を果たしています。次の章では、Redfish APIのログ分析がどのように行われるのか、その具体的な手法について詳しく見ていきます。

ログ分析の基本:データ収集と解析手法

ログ分析は、Redfish APIを用いたサーバ管理において重要なプロセスです。このプロセスは、データ収集と解析手法の2つの主要なステップから成り立っています。まず、データ収集では、Redfish APIが生成するログ情報を適切に取得することが求められます。これには、APIエンドポイントからの情報の引き出しや、必要なデータをフィルタリングする作業が含まれます。具体的には、サーバの状態や動作に関する情報、エラーメッセージ、設定変更の履歴などが収集されます。 次に、収集したデータを解析する段階に移ります。ここでは、ログのパターンや傾向を把握し、異常やエラーの兆候を特定します。解析手法には、統計的手法や機械学習アルゴリズムを活用することが一般的です。これにより、過去のデータと比較して現在の状態を評価し、問題が発生する前に予防措置を講じることが可能になります。さらに、解析結果を可視化することで、管理者が迅速に状況を把握できるようにすることも重要です。 このように、Redfish APIのログ分析は、サーバの運用を最適化し、トラブルを未然に防ぐための効果的な手段です。次の章では、具体的な事例を通じて、ログ分析の実践的なアプローチについてさらに詳しく探ります。

削除設定復旧のプロセスとその意義

削除設定復旧のプロセスは、Redfish APIを活用する上で重要なステップです。誤って設定を削除した場合、迅速に復旧するための手順を理解しておくことが求められます。まず、復旧の第一歩は、ログ分析を通じて削除された設定の特定です。Redfish APIのログには、設定変更の履歴が記録されているため、どの設定がいつ、どのように

実践的なログ分析のステップとツール

実践的なログ分析を行うためには、いくつかのステップと適切なツールを活用することが重要です。まず最初に、Redfish APIから取得したログデータを整理することが求められます。これには、ログファイルを適切な形式(例:CSVやJSON)に変換し、必要な情報を抽出する作業が含まれます。データの整理が完了したら、次に重要なのは、分析ツールを使用してデータを可視化することです。 一般的に使用される分析ツールには、PythonのPandasライブラリや、データ可視化ツールであるTableauなどがあります。これらのツールを利用することで、複雑なデータをグラフやチャートに変換し、視覚的に理解しやすくすることが可能です。特に、異常検知のためのアルゴリズムを組み込むことで、過去のデータと照らし合わせて異常を早期に発見することができます。 また、ログ分析の際には、特定の指標(KPI)を設定することも効果的です。これにより、サーバのパフォーマンスやエラー発生率などを定量的に評価し、改善点を見つけ出すことができます。さらに、ログの分析結果を定期的にレビューし、必要に応じて運用方針や設定を見直すことで、より効果的なサーバ管理を実現することができます。 このように、実践的なログ分析は、Redfish APIを活用したサーバ管理の効率化に寄与します。次の章では、削除設定復旧の具体的な手法について詳しく考察していきます。

ケーススタディ:成功事例から学ぶ教訓

ケーススタディを通じて、Redfish APIのログ分析と削除設定復旧の成功事例を見ていきましょう。ある企業では、サーバの設定が誤って削除されるというトラブルが発生しました。この企業は、Redfish APIを用いてログを詳細に分析することで、削除された設定の特定に成功しました。具体的には、APIのログに記録されている変更履歴を確認し、どのユーザーがいつ設定を変更したのかを明らかにしました。 次に、企業はログ分析の結果を基に、迅速に復旧手続きを行いました。具体的には、削除された設定を再適用するためのスクリプトを作成し、手動での復旧作業を最小限に抑えました。このプロセスにより、ダウンタイムを大幅に削減することができました。また、復旧後には、再発防止策として、設定変更の履歴を定期的に監視する体制を整えました。 この事例から学べる教訓は、ログ分析が迅速な問題解決に寄与すること、そして事前の準備が重要であるという点です。適切なログ管理と分析手法を導入することで、企業はトラブルを未然に防ぎ、安定した運用を実現できることを示しています。次の章では、これらの実践を踏まえた効果的な解決方法について考察していきます。

Redfish APIログ分析の価値と今後の展望

Redfish APIのログ分析は、サーバ管理における重要な要素であり、運用の効率化と問題解決の迅速化に寄与します。ログを適切に分析することで、システムの状態をリアルタイムで把握し、潜在的な問題を早期に発見することが可能となります。特に、削除設定の復旧においては、ログに記録された変更履歴を利用することで、迅速な対応が実現できます。 今後、Redfish APIの普及が進む中で、ログ分析技術もさらに進化していくことでしょう。機械学習やAIを活用した高度な分析手法が導入されることで、より精度の高い異常検知や予測が可能になると期待されます。また、セキュリティの強化やデータ保護の観点からも、ログ分析の重要性は増す一方です。 このように、Redfish APIのログ分析は、単なるデータの収集にとどまらず、企業のITインフラ全体の健全性を保つための基盤となります。今後も、適切な分析手法を取り入れ、運用の最適化を図ることが求められるでしょう。

今すぐRedfish APIを活用したログ分析を始めよう

Redfish APIを活用したログ分析は、サーバ管理の効率化と問題解決の迅速化に不可欠な要素です。今こそ、Redfish APIを導入し、ログ分析のプロセスを取り入れることで、システムの健全性を保ちながら、業務の継続性を確保する時です。正確なログ分析により、潜在的な問題を早期に発見し、迅速に対応することが可能になります。また、設定変更の履歴を把握することで、誤操作によるトラブルを未然に防ぐこともできます。 これからのITインフラ管理において、Redfish APIの活用はますます重要になるでしょう。ぜひ、専門的な知識を持つデータ復旧業者と連携し、効果的なログ分析を実施してください。あなたの組織が持続可能な運用を実現するための第一歩を踏み出しましょう。

ログ分析における注意事項とベストプラクティス

ログ分析を行う際には、いくつかの注意点を押さえておくことが重要です。まず、ログデータの収集と保存には十分なセキュリティ対策を施す必要があります。ログには機密情報が含まれる可能性があるため、アクセス制限や暗号化を行い、不正アクセスを防ぐことが求められます。 次に、収集したログデータの整理と管理が欠かせません。大量のログデータを効果的に分析するためには、適切なフォーマットで保存し、必要な情報を迅速に抽出できる体制を整えておくことが大切です。これにより、分析作業がスムーズに進み、迅速な問題解決が可能となります。 さらに、ログ分析を定期的に実施することも重要です。システムの状態を常に把握し、異常を早期に発見するためには、定期的なレビューと分析が不可欠です。これにより、潜在的な問題を未然に防ぎ、安定した運用を維持することができます。 最後に、ログ分析の結果を適切に活用することが求められます。得られた情報を基に、運用方針や設定を見直し、必要な改善策を講じることで、より効果的なサーバ管理が実現します。これらの注意点を意識しながら、ログ分析を行うことで、システムの健全性を保つことができるでしょう。

補足情報

※株式会社情報工学研究所は(以下、当社)は、細心の注意を払って当社ウェブサイトに情報を掲載しておりますが、この情報の正確性および完全性を保証するものではありません。当社は予告なしに、当社ウェブサイトに掲載されている情報を変更することがあります。当社およびその関連会社は、お客さまが当社ウェブサイトに含まれる情報もしくは内容をご利用されたことで直接・間接的に生じた損失に関し一切責任を負うものではありません。