もくじ

- 第1章:JSONは「便利な文字列」ではなく、システム間の“契約書”だ

- 第2章:なぜJSONが標準になったのか:軽さと人間可読性のトレードオフ

- 第3章:構文の基本を最短で押さえる:object/array/value と null の意味

- 第4章:型のズレが事故になる:数値・真偽値・null・日時の落とし穴

- 第5章:文字化けは“仕様”から始まる:Unicodeとエンコードの現実

- 第6章:パースとシリアライズの実装戦略:速度・メモリ・ストリーミング

- 第7章:JSON Schemaで境界を固める:バリデーションと互換性設計

- 第8章:セキュリティ観点のJSON:巨大JSON、注入、情報漏えい対策

- 第9章:実戦パターン集:API/設定ファイル/ログでのベストプラクティス

- 第10章:結論:JSONはデータではなく“合意”——運用で壊れないJSON設計へ

【注意】 本記事は一般的な情報提供であり、個別の案件・契約・システム構成・障害状況によって最適解は変わります。判断に迷う場合やリスクが高い場合は、株式会社情報工学研究所のような専門事業者に相談してください。

JSONは「便利な文字列」ではなく、システム間の“契約書”だ

「JSON? いや、ただのデータ形式でしょ。APIのレスポンスでいつも見てるし」——現場のエンジニアほど、最初はそう感じるはずです。実際、JSONは“よくある文字列”として扱っても動く場面が多い。けれど、障害対応や仕様変更、あるいは外部ベンダーや別部署と連携が増えてくるほど、JSONは単なるデータではなく、システム間の合意=契約として扱う必要が出てきます。

たとえば、フロントエンドとバックエンド、マイクロサービス同士、外部SaaSとの連携など、JSONが境界面に居座る設計は珍しくありません。そこで「1つフィールドを増やした」「型を変えた」「nullが入るケースを追加した」——この程度の変更が、予想以上に大きな不具合連鎖を起こします。しかも、障害が起きたときに原因がJSONの“たった1文字”だった、というのは現場あるあるです。

「また仕様変更か……。でも、これって後方互換保てるの?」「nullって来る前提だっけ?」「数値、文字列で返るのどっち?」——こういう“心の会話”が頭に浮かぶなら、あなたはすでにJSONを“契約書”として見始めています。JSONが契約になる理由はシンプルで、異なる責務や異なる実装・異なるチームを跨ぐ時点で、解釈のズレが直接バグになるからです。

JSONを契約として扱うとき、意識すべき軸は大きく3つあります。

- 意味(セマンティクス):フィールドが何を表すか、欠損・空・不明の違いをどう表すか

- 構造(スキーマ):object/arrayの形、必須・任意、ネストの深さ、配列要素の型

- 運用(互換性):フィールド追加は許すか、削除はいつ可能か、型変更はどう移行するか

これらは「ドキュメントに書けばいい」という話に見えますが、現場では“書いてあるのに壊れる”が普通に起きます。なぜなら、仕様(文章)と実装(コード)と実データ(本番のJSON)がズレるからです。ズレを完全にゼロにするのは難しい。だからこそ、ズレが起きても被害最小化できる設計に寄せる。つまり、契約としてのJSONは「正しいJSONを書く」ではなく、「壊れ方を設計する」ことに近いのです。

ここが本記事の伏線になります。JSONの本質は構文ではなく、合意と互換性と運用です。構文を暗記しても、事故は止まりません。事故を沈静化させ、収束させるには、JSONを境界設計の一部として扱い、運用に耐えるルールを作る必要があります。

もう少し具体化しましょう。契約としてのJSONには、次のような“現場の判断ポイント”が常に付きまといます。

| 論点 | よくある事故 | 契約としての考え方 |

|---|---|---|

| 欠損 vs null | クライアントが未定義を想定しておらず例外 | 「未提供」「不明」「空」を区別する方針を決める |

| 数値の表現 | 整数/小数/文字列の混在でパース失敗 | 範囲・単位・精度を含めて合意する |

| 日時 | タイムゾーン差分で集計がズレる | 表現形式(例:ISO 8601)とTZ方針を固定する |

この表のポイントは、「JSONが悪い」のではなく「契約が曖昧」だと壊れる、という事実です。現場では、障害が起きると“犯人探し”が始まりがちです。でも多くの場合、犯人は人ではなく合意不足です。合意不足をダメージコントロールし、ノイズカットし、場を整えていく——これがJSONを“契約”として扱うという意味です。

次章以降は、伏線を回収するために、まず「なぜJSONが標準になったのか」を整理し、その後に構文→型の落とし穴→エンコード→性能→スキーマ→セキュリティ→実戦パターンへと進めます。最終的には「一般論の限界」と「個別案件では専門家へ相談すべき理由」まで、一本の線としてつなげます。

なぜJSONが標準になったのか:軽さと人間可読性のトレードオフ

「結局、JSONって何がそんなに良いの?」——ここを雑に扱うと、設計の判断がブレます。標準になった理由を知ることは、JSONの限界も同時に知ることです。限界が分かると、過熱しがちな議論をクールダウンさせ、現実的な落としどころ(軟着陸)を作りやすくなります。

JSON(JavaScript Object Notation)は、その名の通りJavaScriptのオブジェクト表現に近い形式です。とはいえ、今や言語はJavaScriptだけではありません。サーバサイド、モバイル、組込み、データ基盤……多様な環境でJSONが使われ続けるのは、次の性質が“ちょうど良かった”からです。

- 人間が読める:ログ・デバッグ・検証がしやすい

- 構造を表現できる:入れ子、配列、キー/値の対応が素直

- 実装が容易:多くの言語に標準ライブラリや定番実装がある

- テキストとして扱える:HTTPなど既存プロトコルに載せやすい

ここで重要なのは、JSONは“万能”ではないのに“便利さが勝った”という点です。つまり、採用の背景にはトレードオフがあります。軽さと可読性を取る代わりに、厳密性や表現力の一部を捨てている。この捨てた部分が、後からトラブルとして返ってきます。

代表的な比較を表で整理します。これは「どれが優れているか」ではなく、「どの前提で選ばれてきたか」を理解するための表です。

| 形式 | 強み | 弱み(JSONとの比較) | 典型用途 |

|---|---|---|---|

| JSON | 可読・軽量・普及 | 型が曖昧になりやすい/コメント不可など | Web API、設定、ログ |

| XML | 厳密なスキーマ文化 | 冗長/扱いが重い/学習コスト | 業務系連携、文書系 |

| YAML | 設定記述が書きやすい | 解釈差が出やすい/インデント事故 | IaC、CI/CD設定 |

こう見ると、JSONは「軽さ」と「互換性(載せやすさ)」で勝ってきた、と言えます。ただし、弱みもはっきりしています。型が曖昧になりやすい。コメントが入れられない(運用ドキュメントが別途必要になりやすい)。そして、厳密なスキーマ文化が“標準装備ではない”。この弱みを放置すると、仕様変更のたびに障害対応が炎上/クレーム対応のような状態になりかねません。

「でも、JSONって仕様は単純ですよね? だったら事故らないはずでは?」——ここが次章への伏線です。単純なのは構文であって、運用は単純ではありません。構文が単純だからこそ、自由度が高くなり、チームごとの解釈がズレやすい。ズレが蓄積すると、ある日突然“歯止め”が効かなくなり、互換性が崩れます。

次章では、構文の最小限(object/array/value)を短時間で押さえつつ、実務で事故を起こしやすいポイント(特にnull)を「契約」の観点で整理します。ここを理解すると、JSONの議論が過熱しやすい場面でも、落ち着いて判断できるようになります。

構文の基本を最短で押さえる:object/array/value と null の意味

「JSONの構文なんて今さら……」と思った瞬間がいちばん危ない、というのが現場の実感です。JSONは“簡単そうに見える”がゆえに、仕様の細部が共有されないまま運用が始まります。そして、いざ他チーム・他社と連携した途端にズレが露出して、議論が過熱しがちになります。ここで空気を落ち着かせるために、最小限の要点だけを整理します。

JSONは大きく、object(キーと値の集合)、array(順序を持つ値の列)、そしてそれらに入るvalueから成ります。valueに入れられる型は、文字列(string)、数値(number)、真偽値(true/false)、null、object、arrayのいずれかです。これだけ見ると「単純」ですが、問題は“同じ見た目でも意味が違う”ことです。

object/arrayの違いは「契約の硬さ」の違い

objectはキーで参照します。つまり、クライアント側は「このキーがあるはず」という前提で実装しやすい。一方arrayは順序で参照する文化が入ると、後から項目を増やしたり並び替えたりするだけで互換性が壊れます。もちろんarrayが悪いわけではなく、「追加や並べ替えに耐える設計か」が契約の論点になります。

| 構造 | 向いているデータ | 壊れやすいポイント |

|---|---|---|

| object | 属性の集合(id/name/statusなど) | 必須キーの欠損、キー名変更 |

| array | リスト(履歴、一覧、複数要素) | 要素型の混在、順序依存、巨大化 |

「“配列の0番目が常にこれ”って仕様、あとで地獄になりません?」——こういう疑いは健全です。運用を楽にしたいなら、arrayは“並びを契約にしない”方が安全です。例えば要素をobjectにしてidを持たせる、順序は表示都合と割り切る、などの方針がダメージコントロールになります。

nullが一番揉める:欠損・空・不明を混ぜない

JSON運用で最も揉めやすいのがnullです。なぜか。nullは見た目が単純な割に、意味が複数あるからです。

- 不明:値が分からない(まだ確定していない)

- 未設定:本来は入るが、現時点では設定されていない

- 該当なし:概念として存在しない(電話番号がない等)

さらに厄介なのが、「キー自体がない」(欠損)との違いです。欠損は「送られていない」だけで、サーバの都合なのか、クライアントの都合なのかも判別できない場合があります。ここが契約として曖昧だと、後から片方が勝手に解釈して、もう片方が例外で落ちる——という“よくある事故”になります。

| 状態 | 例 | 契約としての解釈例 |

|---|---|---|

| 欠損(キーなし) | { } | 「未提供」または「後方互換のため省略」など、意味は要合意 |

| null | {"x": null} | 「不明」か「未設定」か「該当なし」かを明記して合意 |

| 空文字 | {"x": ""} | 「値はあるが空」なのか「未入力」なのか、仕様で固定 |

ここでのポイントは、「一般論で正解を決めない」ことです。どれが正しいかは、業務要件と障害時の扱いで決まります。だからこそ、JSONは契約です。契約が曖昧だと、議論が過熱し、責任の押し付け合いになりやすい。逆に、ここを最初に定義すると、仕様変更時の“歯止め”になります。

数値と文字列:見た目が似ているほど危険

JSONのnumberは、仕様としては「数値」です。ただし、実装言語側の数値型は多様で、整数・浮動小数・任意精度など表現が異なります。さらに、IDのように「数字に見えるが算術しない値」をnumberにしてしまうと、桁落ちや表現差で事故になります。

「IDをnumberで返すの、ちょっと怖くない?」——この直感も健全です。IDは多くの場合、文字列(string)にした方が運用が安定します。次章では、この“型のズレが事故になる”話を、もう一段深く掘ります。

型のズレが事故になる:数値・真偽値・null・日時の落とし穴

JSONの事故は、構文エラーよりも型のズレで起きることが多いです。構文エラーは比較的すぐ気づきます。パーサが弾くからです。一方で型のズレは「一応パースできる」ために、実行時のどこかで静かに爆発します。運用上は、これが一番やっかいです。障害対応が長引き、関係者調整が増え、現場の疲弊が積み上がる。ここを被害最小化するには、型の“境界条件”を先回りで設計する必要があります。

数値:整数に見えるものほど慎重に

JSONのnumberは、小数点を含むことも含まないこともあります。つまり、numberという見た目だけでは「整数か」「浮動小数か」「桁が大きいか」が判別できません。さらに、言語によっては内部表現が浮動小数(例えばIEEE 754倍精度)に寄る実装もあり、巨大な整数が正確に表現できないケースが出ます。

ここで大事なのは「特定言語の仕様を攻める」ことではなく、契約として“安全側”の表現を選ぶことです。例えば次のような方針は、実務でよく採用されます。

- 識別子(ID)は文字列:算術しない値はstringに寄せる

- 金額・小数:単位(円/税抜など)と精度(小数点何桁)を契約に含める

- カウンタ:範囲(最大値)とオーバーフロー方針を決める

| データ | 危険な表現 | 推奨寄りの表現 | 理由 |

|---|---|---|---|

| ユーザーID | {"user_id": 12345678901234567890} | {"user_id": "12345678901234567890"} | 巨大整数の表現差を避ける |

| 金額 | {"price": 19.99} | {"price_cents": 1999} | 小数の丸め誤差を回避しやすい |

もちろん、常にこの通りにすべきという一般論ではありません。ですが、システム間連携が増えるほど、こうした“安全側の寄せ方”が障害の収束を早めます。

真偽値:true/falseに見えて、仕様が二重化しやすい

booleanは単純に見えます。しかし、実務では「状態(status)」と「フラグ(is_xxx)」が混在して、意味が二重化しがちです。たとえば、is_active=true/false と status="active"/"suspended"/"deleted" のような形です。これ自体は悪ではありませんが、契約が曖昧だと矛盾が発生します。

- is_active=false だが status="active" のような矛盾

- statusが増えたのに、フラグ側は更新されない

「このフラグ、どっちが正なの?」——現場の疑問が増えたら、契約が破綻しかけているサインです。こういうときは、意味の中心を1つに寄せる(status中心にする、フラグは派生として扱う、など)と、運用が落ち着きます。

null再訪:nullableを増やしすぎると、全員が防御実装を強いられる

nullableなフィールドが増えると、クライアントは防御実装を増やすしかなくなります。防御実装が増えると、ロジックが分散し、結果として“どこで何を保証しているか”が分かりにくくなります。これは保守性の損失であり、障害時の切り分けも遅くなります。

ここでの実務的なブレーキは、次の2つです。

- nullableにする理由を言語化:要件として本当に必要か

- デフォルト値の設計:空配列、空文字、0などで意味が崩れないか

ただし、デフォルト値の乱用は危険です。たとえば「不明」を0で表すと、集計や監視で“正しい値”として扱われてしまい、後から穴埋めが困難になります。ここも、一般論ではなく、業務と分析・監査の要件で決まります。

日時:たった一つのタイムゾーンが、障害の火種になる

日時はJSONの標準型ではありません。多くの場合、文字列として表現します。ここが落とし穴です。文字列は自由度が高い分、互換性が壊れやすい。さらに、タイムゾーンの扱いを曖昧にすると、障害対応や監査・ログ突合が難しくなります。

「“2025-12-24 10:00”って、どこの10時?」——この問いに即答できないフォーマットは、契約として弱いです。実務では、次のような合意がよく使われます。

- ISO 8601形式で表す(例:2025-12-24T10:00:00+09:00 や 2025-12-24T01:00:00Z)

- 基準はUTC、表示はクライアント側で変換する

- ログはUTC固定にして突合を容易にする

| 表現 | 良い点 | 注意点 |

|---|---|---|

| 2025-12-24T10:00:00+09:00 | タイムゾーンが明示される | 実装側のパース対応が必要 |

| 2025-12-24T01:00:00Z | UTCで一意、ログ突合が楽 | 表示時にローカル変換が必要 |

| 2025-12-24 10:00:00 | 人間には読みやすい | TZが曖昧で事故の種 |

日時は、ログ・監査・課金・SLAなどにも直結します。ここが曖昧だと、後から調整や対人折衝が増え、現場の消耗が大きい。だからこそ、契約として最初に固定する価値があります。

第3章と第4章で見えてきたのは、JSONの事故が「構文」ではなく「運用の合意不足」で起きるという事実です。次章では、さらに現場の“あるある”である文字化け・Unicode・エンコードの問題を扱います。ここは「アプリは直したのに直ってない」になりがちなので、ノイズカットのために原理から整理します。

文字化けは“仕様”から始まる:Unicodeとエンコードの現実

「JSONが壊れてる?」と思ってログを見たら、実は“文字が壊れている”だけだった——この手のトラブルは、障害対応の時間を静かに溶かします。しかも厄介なのは、文字化けが「一部の環境でだけ」起きることです。開発機では再現しないのに、本番の一部リージョンや一部クライアントでだけ発生する。議論が過熱して、原因が人や組織に向きやすい典型パターンです。まず結論を言うと、文字化けは気合では直りません。仕様(Unicode)と実装(エンコード・デコード)と運用(入出力経路)の噛み合わせ問題です。

Unicodeは「文字コードそのもの」ではなく、文字の“番号体系”

混乱の第一歩は、Unicodeとエンコードを同一視することです。Unicodeは、文字にコードポイント(番号)を割り当てる仕組みです。一方、UTF-8やUTF-16などは、そのコードポイントをバイト列にする(符号化する)ための方式です。つまり、Unicode=世界共通の文字の辞書、UTF-8=その辞書の番号を現実の通信で運べる形にするルール、というイメージが近いです。

JSONはテキストです。テキストは最終的にバイト列として送受信されます。ここで「送る側の符号化」と「受ける側の復号」が一致しないと、文字化けになります。さらに、途中経路(プロキシ、ログ収集基盤、メッセージキュー、DB、ファイル出力)で別の変換が入ると、症状が複雑化します。

JSONとUTF-8:現場では“前提”になりがちだが、明示が必要

Web APIの文脈では、JSONはUTF-8で扱われることが多く、実装もUTF-8前提が一般的です。しかし「多くの場合そうだ」ことと「契約として固定されている」ことは別です。契約として固定しないと、次のような“ズレ”が起きます。

- クライアントがUTF-8以外(例:Shift_JIS系)で送ってしまう

- レスポンスのContent-Typeにcharsetが明示されておらず、受け側が推測して外す

- ログ出力やファイル保存のデフォルトがOS依存で変わる

「え、今どきSJISで送ることある?」と思うかもしれませんが、現場は多様です。古い業務端末、特定製品のSDK、Excel連携、バッチ処理、組込み機器など、“想定外の入り口”はあります。だからこそ、ここは契約として「UTF-8で送る/受ける」を明文化し、テストで固定する方が安全です。これは仕様の穴埋めであり、防波堤を築く行為です。

エスケープと見た目のズレ:ログが誤解を生む

JSONの文字列には、制御文字や引用符などがエスケープされる場合があります。たとえば改行が「\n」と見える、タブが「\t」と見える、引用符が「\"」になる、といった具合です。ログ上の見た目だけで判断すると、「バックスラッシュが混入している!」と誤解しがちです。

ここで有効なのは、“表示”と“実データ”を分けて扱うことです。ログビューアやデバッグ出力が、どの段階の文字列(エスケープ前/後)を表示しているかを確認しないと、議論が空回りします。現場では「ログにこう出てるから!」が強い根拠になりがちですが、そのログがどの層で生成されたかが不明だと、ノイズが増えます。ノイズカットのために、観測点を整理しましょう。

実務で効くチェックリスト:文字化けを沈静化させる順番

文字化けが発生したとき、闇雲に直すのではなく、次の順番で確認すると収束が早いです。

- 入出力の宣言:HTTPヘッダ(Content-Type/charset)やファイルのエンコード指定は明示されているか

- 境界の実装:JSONシリアライズ/パース時にエンコードが固定されているか

- 経路の変換:ログ基盤、キュー、DB、ETLで再エンコードが入っていないか

- 再現条件:特定文字(絵文字、サロゲート、結合文字)でのみ起きていないか

特に「絵文字だけ壊れる」「一部の漢字だけ壊れる」のような症状は、Unicodeの扱い(UTF-16サロゲートや正規化差など)や、途中経路の変換の可能性が高いです。ここは一般論で断定できない領域なので、実データ・経路・環境を含めて個別に調査が必要になります。

つまり、ここでも「一般論の限界」が出ます。文字化けの対策は、システム構成・経路・ログ基盤・運用手順とセットです。個別案件で“どこで何が起きているか”を切り分ける必要がある。こういうときは、株式会社情報工学研究所のような専門家に相談して、調査の防波堤を築くのが合理的です。

パースとシリアライズの実装戦略:速度・メモリ・ストリーミング

JSONを契約として扱い始めると、次に現場で出てくるのが「性能」と「安定性」の話です。特にSREや情シスの立場だと、「このAPI、レスポンス肥大してない?」「ログのJSONが巨大化してディスク圧迫してる」「バッチが急に遅くなった」など、運用コストに直結します。ここもまた、仕様の合意がないと議論が過熱しやすい領域です。性能問題は、原因が複合的だからです。

JSON処理のコストは「サイズ」「深さ」「回数」で効いてくる

パース(文字列→データ構造)とシリアライズ(データ構造→文字列)は、基本的にデータ量に比例してコストが増えます。さらに、ネストが深いほど、メモリ確保や再帰処理、オブジェクト生成が増えます。そして、これをリクエストごとに毎回やるのか、ログで大量にやるのかで、コストが跳ね上がります。

| 要因 | 典型症状 | 設計上の歯止め |

|---|---|---|

| サイズ肥大 | レスポンス遅延、帯域圧迫、課金増 | フィールド削減、ページング、圧縮、投影 |

| ネストの深さ | CPU増、GC増、スタック問題 | フラット化、参照分離、段階取得 |

| 回数(頻度) | ピーク時に急激な遅延 | キャッシュ、差分更新、集計のオフロード |

「JSONってテキストだから遅いんですよね?」という言い方は、半分は正しく、半分は雑です。テキストは確かに冗長になりやすい。しかし、現代の環境ではネットワーク・IO・DB・アプリのどこがボトルネックかで最適解が変わります。だからこそ、ここでも一般論で結論を出しにくい。まずは“壊れ方”を見て、被害最小化の設計に寄せるのが現実的です。

巨大JSONへの対策:一括読み込みを前提にしない

巨大JSONの典型的な事故は、メモリに一括展開して落ちる、タイムアウトする、GCが暴れる、といった形で現れます。特にログやバッチ、データ連携で起きがちです。このとき有効な発想がストリーミングです。つまり、「最初から全部をデータ構造にしない」「必要な部分だけ段階的に読む」という設計です。

ただし、ストリーミングは万能ではありません。ランダムアクセスがしにくい、実装が複雑になる、デバッグが難しくなる、などのトレードオフがあります。ここでも契約が重要で、「最大サイズ」「最大要素数」「深さの上限」などを合意しておけば、無限に膨張する状況を抑え込みやすくなります。つまり、性能と安定性の問題も、契約の延長線にあります。

ログJSONの落とし穴:可観測性のためにシステムを壊さない

現場でありがちなのが「障害調査のためにログを増やしたら、ログでシステムが重くなった」という本末転倒です。JSONログは検索しやすい一方で、項目が増えるほどサイズが増え、保存・転送・集約のコストが跳ね上がります。ここは、場を整える発想で次のような線引きが有効です。

- 必須ログ:相関ID、主要キー、結果、エラーコードなど最小セット

- デバッグログ:短期的に増やすが、期間・上限・マスク方針を決める

- 個人情報・機密:原則入れない、必要ならマスキングやハッシュ化

これも「正しさ」より「運用で壊れない」ことが主眼です。ログは増やせば増やすほど良いわけではありません。むしろ、重要情報がノイズに埋もれます。ノイズカットしつつ、必要な観測点を残す。ここが設計です。

第6章のまとめとして、JSONの性能問題は「JSONだから遅い」ではなく、サイズ・深さ・回数・経路・運用の複合問題です。これを収束させるには、上限の合意、段階取得、ストリーミングなどの設計が必要になります。

次章では、ここまでの伏線(契約としてのJSON)をさらに強めるために、JSON Schemaを取り上げます。Schemaは、仕様と実装と実データのズレを抑え込み、互換性の防波堤を築くための道具です。

JSON Schemaで境界を固める:バリデーションと互換性設計

「仕様書はあるんですけど、実際のJSONは違うんですよね」——この“ため息”が出たら、契約としてのJSONが形骸化しています。文章の仕様書は、人間には読めても、実データのズレを自動で抑え込みません。そこで役に立つのがJSON Schemaです。これは、JSONの構造・型・必須項目・制約などを機械的に表現し、検証(バリデーション)に使える仕組みです。

ただし、ここで誤解しやすいのは「Schemaを書けば全部解決する」という期待です。Schemaは万能ではありません。ですが、仕様(文章)と実装(コード)と実データ(本番)のズレを被害最小化し、議論の過熱をクールオフさせる“共通言語”になり得ます。現場の腹落ちに近い言い方をすると、Schemaは「後から揉めるポイントに、先に歯止めを掛ける」道具です。

Schemaでできること:最低限の“契約チェック”を自動化する

Schemaで表現できる代表的な項目は次のとおりです。

- 型:string / number / integer / boolean / null / object / array

- 必須・任意:requiredの指定

- 制約:文字列長、数値範囲、正規表現、列挙(enum)

- 構造:objectのproperties、arrayのitems

- 追加フィールドの扱い:追加キーを許す/禁じるなどの方針

現場で効くのは、まずは「型」と「必須」と「追加フィールド方針」です。これだけでも、事故の多くを抑え込みやすくなります。例えば、あるフィールドが文字列のはずなのに数値で来た、必須キーが欠損した、想定外のキーが増えてクライアントが壊れた——こうした事象を、早い段階で検知できます。

互換性設計:追加はOK、破壊は計画的に

契約としてのJSONで最重要なのは、互換性の設計です。一般に、後方互換(既存クライアントが壊れない)を保つには、「追加は比較的安全」「削除・型変更は危険」という性質があります。なぜなら、既存クライアントは“ある前提”で書かれているからです。

| 変更 | 互換性 | 起きがちな事故 | 抑え込み策 |

|---|---|---|---|

| フィールド追加 | 比較的安全 | 厳格パーサで未知フィールドを拒否 | 未知フィールド許容方針、Schemaで明記 |

| フィールド削除 | 危険 | 必須として参照しているクライアントが落ちる | 段階廃止、移行期間、バージョニング |

| 型変更 | 非常に危険 | パース失敗、ロジック分岐が崩壊 | 新フィールド追加で移行、旧は維持 |

ここでの実務的な“歯止め”は、破壊的変更をしない設計に寄せることです。どうしても必要なら、バージョニング(例:v1/v2)や移行期間、互換レイヤーを設けて、軟着陸させます。Schemaは、この移行計画を明文化し、テストに組み込むのに向いています。

Schema運用の落とし穴:厳しすぎると現場が疲弊する

一方で、Schemaを厳格にしすぎると、別の問題が出ます。例えば、追加フィールドを完全拒否にすると、ログや周辺システムが少し項目を増やしただけで全体が落ちる、という事故が起きます。これは「正しいが現場で壊れる」状態です。

ここで大事なのは、Schemaを“現場のための防波堤”として設計することです。つまり、

- 受け側は未知フィールドを無視できるか(拡張耐性)

- 必須は最小にできているか(安定性)

- nullableは増やしすぎていないか(保守性)

このバランスを取り、運用の場を整えるのが設計です。ここは一律の正解がなく、業務・障害時の影響・責任分界で最適点が変わります。だからこそ、個別案件では、株式会社情報工学研究所のような専門家に相談して、契約の落としどころを設計する価値があります。

セキュリティ観点のJSON:巨大JSON、注入、情報漏えい対策

「JSONってデータ形式でしょ? セキュリティは別問題では?」——そう思いたくなる気持ちは分かります。ただ、現場ではJSONが攻撃の入口や増幅装置になることがあります。JSONは“境界”にいるからです。外部入力、他システム入力、ログ、設定、キュー……境界が多いほど、攻撃面も増えます。ここを抑え込み、被害最小化するのが第8章の目的です。

巨大JSONは“入力攻撃”になり得る:リソース枯渇を起こす

巨大JSONは、意図せず発生することもあります(ログ肥大、デバッグ項目追加、バッチの一括送信)。同時に、悪意ある入力としても成立します。極端に大きいJSONや深いネストは、CPU・メモリ・スタックを消費し、サービスを不安定化させます。これは典型的なリソース枯渇の入口です。

対策の基本は、契約として上限を持つことです。

- 最大リクエストサイズ(ボディサイズ上限)

- 最大ネスト深度(深すぎる入力を拒否)

- 最大配列要素数(無限リスト化を防ぐ)

これらは、アプリ層だけでなく、APIゲートウェイ、WAF、プロキシ、ロードバランサなど“手前”で抑え込むほど効果が高いことが多いです。アプリに到達させないのが防波堤として強いからです。

注入と解釈のズレ:JSONだから安全、ではない

JSONは構造化されているため、いわゆるSQLインジェクションのような文字列連結より安全に見えます。しかし、JSONを受け取った後に何をするか次第で、注入・不正操作の温床になります。例えば、JSONに含まれる値をそのままSQLに渡す、テンプレートに差し込む、コマンド引数にする、ログに出す——こうした二次利用の段階で問題が起きます。

ここでの基本動作は、次の3点です。

- バリデーション:Schema等で型・範囲・列挙を固定する

- エスケープ/パラメータ化:DBやテンプレートへ渡す際は安全なAPIを使う

- 権限・意図の確認:JSONの値が“やってよい操作”に紐づくなら必ず認可する

「JSONでrole=adminって送られたらどうするの?」という問いが頭に浮かぶなら、それは健全な疑いです。クライアントが送るJSONは“希望”であって“正義”ではありません。契約として、サーバが保証すべき境界を定義し、入力は疑う。ここが場を整える設計です。

情報漏えい:JSONは“ログに載りやすい”から危ない

セキュリティ事故で多いのが「本番ログに機密が出ていた」「外部の監視ツールに個人情報が送られていた」というパターンです。JSONは可読で便利な分、そのままログに吐き出されやすい。ここがリスクになります。

| 漏えいしやすいデータ | よくある混入経路 | 抑え込み策 |

|---|---|---|

| 認証情報(トークン等) | リクエスト/レスポンス丸ごとログ | マスク、出力禁止、構造化ログの選別 |

| 個人情報 | デバッグ目的の項目追加 | 保持期間・閲覧権限・匿名化方針 |

| 機密データ(設計情報等) | 例外発生時に入力をダンプ | 例外ログのサニタイズ、監査 |

「障害調査のために全部ログに出しておきたい」——この気持ちも分かります。でも、ログは社内外の多くの経路を通ります。保存、転送、検索、共有……その途中で人の目に触れる機会が増える。ここは“被害最小化”の設計が必要です。具体的には、出してよい項目のホワイトリスト化や、トークン・パスワード・個人情報のマスキング、ログ閲覧権限の分離、保持期間の短縮などが現実的な防波堤になります。

第8章の結論は、JSONがセキュリティの中心に“居座る”ということです。境界にある以上、入力上限、バリデーション、二次利用の安全化、ログのマスキングといった対策が必要になります。ここも、一般論だけでは十分ではありません。システム構成・運用・監査要件・委託範囲によって、最適な歯止めが変わるからです。

次章では、ここまでの設計論を実戦に落とすために、API/設定ファイル/ログのパターンを整理します。「どこから手を付ければ場が整うか」を、現場目線でまとめます。

実戦パターン集:API/設定ファイル/ログでのベストプラクティス

ここまでで、JSONは「構文」ではなく「合意と運用」だ、という伏線を積み上げてきました。第9章では、現場で遭遇頻度が高い3つの用途(API/設定ファイル/ログ)に絞って、壊れ方を抑え込み、場を整えるための実戦パターンをまとめます。ポイントは、どれも“一般論の正しさ”ではなく、“運用での被害最小化”に寄せることです。

パターン1:APIのJSON(外部・社内問わず)

APIはJSONが最も「契約」になりやすい場所です。相手が別チーム・別会社ならなおさらです。ここで効くのは、次のような“運用ルール”です。

- 必須を最小化:クライアントが確実に必要なものだけ必須にする

- 追加は許容:未知フィールドは無視できる設計に寄せる

- 削除・型変更はしない:どうしても必要なら新フィールド追加で移行

- エラー形式を固定:エラーコード、メッセージ、相関IDなどを統一する

- 日付・IDの方針を固定:日時はTZ方針、IDはstringなど

「でも、クライアントが厳格にパースして落ちるんですよね……」という場面では、API提供側だけが頑張っても限界があります。だからこそ、契約として「未知フィールドを無視する」や「後方互換ルール」を合意し、テストで担保する必要があります。JSON Schemaを併用して“契約チェック”を自動化すると、議論が感情論に寄りにくく、収束が早いことが多いです。

| 論点 | ありがちな設計 | 被害最小化寄りの設計 |

|---|---|---|

| エラー | エンドポイントごとに形式が違う | 共通のerrorオブジェクト(code/message/trace_idなど) |

| レスポンス肥大 | 何でも全部返す | ページング、フィールド投影、段階取得 |

パターン2:設定ファイルのJSON(アプリ設定・ジョブ定義・ルール)

設定ファイルは「人が書くJSON」になりやすい場所です。ここで問題になるのは、JSONが本来コメントを持てないこと、そして人間がミスしやすいことです。現場でありがちな“心の会話”はこうです。

「これ、何の設定だっけ……?」

「キー名が紛らわしい。trueにすると何が起きる?」

「nullって入れていいの? 消すの?」

設定JSONで被害最小化するには、次の方針が効きます。

- 設定のSchemaを持つ:型・必須・範囲・列挙を明記し、起動時に検証する

- デフォルト値を明文化:省略時の挙動を固定する(ただし“不明”を0で埋めない)

- 安全側のフェイル:設定が壊れていたら危険な動作に入らない

- 設定のマイグレーション:バージョンを持ち、古い設定を読み替える仕組み

ここでの落とし穴は「デフォルト値で全部埋めておけば楽」という誘惑です。確かに起動は安定しますが、誤設定が“気づかれないまま”進むと、後から大きな損失・流出につながることがあります。設定は“楽”と“正しさ”のバランスです。ここも一般論ではなく、業務リスクで決めるべき領域です。

パターン3:ログのJSON(監視・監査・障害調査)

ログは“観測点”であり、観測点が壊れると復旧が遅れます。ログJSONでよくある事故は、(1)項目が増え続ける、(2)機密が混入する、(3)検索性が落ちる、です。ここを抑え込み、ノイズカットするには、ログを「設計対象」として扱う必要があります。

- 相関ID(trace_id等)は必須:横断調査の軸を固定する

- イベント名を固定:何が起きたかを分類できるようにする

- レベルを設計:info/debug/errorの意味を統一する

- PII/機密のマスク:出してよい情報をホワイトリスト化する

- サイズ上限:巨大化を抑え込み、ログ基盤を守る

ログは「とりあえず全部出す」と、運用が崩れます。特にBtoBの現場では、監査・委託・契約責任の文脈も絡みます。ログに何を残すか、何を残さないかは、技術だけでは決まりません。契約・コンプライアンス・運用体制と一体で設計する必要があります。

ここまでが第9章の要点です。API・設定・ログ、それぞれで「契約としてのJSON」をどう運用に落とすかが見えたはずです。次章で、伏線を回収します。

結論:JSONはデータではなく“合意”——運用で壊れないJSON設計へ

最初に言った結論に戻ります。JSONは「便利な文字列」ではなく、システム間の“契約書”です。構文は単純ですが、運用は単純ではありません。だから、現場で起きるのは構文エラーよりも、型のズレ、nullの解釈差、日時の曖昧さ、エンコードの噛み合わせ、巨大JSONによる性能劣化、ログからの情報漏えい、といった“境界”の問題です。

そして、境界の問題は必ず人と組織を巻き込みます。別チーム、別会社、情シス、監査、役員、顧客……。ここで議論が過熱すると、技術者が最も消耗します。

「仕様通りに実装したはずなのに、相手が違う」「ログはあるのに、何が正しいか分からない」「またツール増えるの? 運用が増えるだけでは?」——こういう本音が出るのは自然です。健全な疑いです。むしろ、その疑いを起点に、契約として合意を固め、歯止めを作るのが正しい進め方です。

一般論の限界:あなたの現場の“壊れ方”は、構成で決まる

ここで強調したいのは、一般論だけでは最後の一歩が決まらない、ということです。たとえば、

- APIの相手は社内か社外か(責任分界が違う)

- システムはレガシーで止められないのか(移行戦略が違う)

- 監査・法令・委託要件があるか(ログ設計が違う)

- 障害時に誰が何分で復旧するか(運用設計が違う)

この条件が変わるだけで、同じJSONでも最適解が変わります。Schemaを厳格にするべきか、未知フィールドを許容するべきか。ログにどこまで出すべきか。日時はUTC固定か、業務都合でローカル基準か。これらは「正解」を暗記しても決まりません。現場の“壊れ方”を理解し、被害最小化の観点で設計する必要があります。

小さな一歩:契約としてのJSONを、今日から整える

もし今、JSON周りでモヤモヤがあるなら、いきなり大改修ではなく、次の小さな一歩から始められます。

- nullと欠損の方針を決める(「不明」「未設定」「該当なし」を区別する)

- 日時とIDの表現を固定する(ISO 8601、IDはstring等)

- エラーJSONを統一する(コード、メッセージ、相関ID)

- サイズ上限を決める(巨大JSONの歯止め)

- ログのホワイトリストを作る(機密混入の防波堤)

これだけでも、障害対応の収束は早くなりやすいです。逆に言えば、これらが曖昧なままだと、どれだけコードを綺麗にしても、境界で崩れます。

個別案件では専門家の価値が出る:調査設計と合意形成

特に、外部連携やレガシーが絡む場合、JSONの問題は「技術だけ」では終わりません。契約・運用・監査・ログ・セキュリティが絡み、利害関係者が増えます。ここで必要なのは、正しさの主張ではなく、場を整え、軟着陸させるための設計と調整です。

そのため、読者が具体的な案件・契約・システム構成などで悩んだときは、一般論を当てはめて消耗するよりも、株式会社情報工学研究所のような専門家に相談し、状況に合わせた契約設計・移行戦略・ログ設計・セキュリティ対策まで含めて整理することを検討してください。結果として、障害対応のダメージコントロールが効き、運用が落ち着きやすくなります。

現在のプログラム言語各種:JSONの注意点(言語・実装ごとの落とし穴)

最後に、言語ごとに「JSONで事故りやすい点」を整理します。ここは“言語の優劣”ではなく、実装差が契約を壊すポイントを把握するためのメモです。実務では、相手先の言語・フレームワークが何か分からないことも多いので、一般論の限界を意識しつつ、個別案件では調査が必要になります。

JavaScript / TypeScript

- 数値は基本的に浮動小数(Number)として扱われる前提で設計する必要がある(巨大整数IDはstring寄せが安全)

- undefinedはJSONに存在しない(欠損とnullの扱いを契約で固定しないとズレる)

- Dateの表現は文字列依存になりやすい(ISO 8601固定推奨、TZ方針も合意)

Python

- dictのキーは文字列前提で扱うのが基本(非文字列キーの扱いは変換が必要)

- DecimalやdatetimeはそのままJSON化できないことが多い(シリアライズ方針が必要)

- unicode/エンコードは経路(ファイル/HTTP/ログ)で差が出やすい(UTF-8固定の明文化が有効)

Java

- 数値型(int/long/BigDecimal)の選択が互換性に直結(IDや金額の扱いを契約で固定)

- null許容が多い設計だと、実装側で防御が分散しやすい(必須最小化・デフォルト方針が重要)

- ライブラリ差(Jackson等)の設定で挙動が変わる(未知フィールド許容など)

C# / .NET

- シリアライザの設定差でフィールド名(camelCase等)やnull出力が変わりやすい

- DateTime/DateTimeOffsetの扱いでTZがズレやすい(ISO 8601+TZ明示推奨)

- 型安全を強めるほど未知フィールドや型ゆらぎに弱くなる(互換性設計が必要)

Go

- 構造体タグ(jsonタグ)とomitemptyで欠損/zero/nullの表現がズレやすい

- interface{}受けは柔軟だが型の曖昧さが増える(Schemaや検証で歯止め)

- time.Timeのフォーマット方針を固定しないと互換性が崩れる

Rust

- 型が厳格な分、入力のゆらぎに弱い(serdeの設定や互換フィールド設計が重要)

- Optionでnull/欠損の意味が設計に出る(契約としての意味を明確化)

PHP

- 配列が連想/添字で混在しやすく、object/arrayの意図が崩れやすい(境界での方針固定が重要)

- 文字エンコードが経路でブレることがある(UTF-8固定、入出力の明示)

- 型のゆらぎ(数値が文字列になる等)を前提に、検証と正規化を入れる

Ruby

- Hash/Arrayの変換は素直だが、Symbol/文字列キーの混在に注意

- Time/Dateのフォーマット方針を固定しないと、相手言語で解釈差が出る

C / C++(組込み含む)

- JSONパーサ実装差が大きく、未知フィールドや深いネストで落ちる可能性がある

- メモリ制約が厳しい環境では巨大JSONが致命傷になりやすい(上限契約・ストリーミング・分割設計)

- エンコード処理を自前で扱うと事故が増える(UTF-8前提を強く固定)

以上を踏まえると、JSONは「共通フォーマット」ではあっても、実装と言語の差で簡単にズレるという現実があります。だからこそ、一般論としては「契約を明文化し、バリデーションと互換性設計で歯止めを掛ける」が最も再現性の高い方針になります。

そして、現場の案件が複雑になればなるほど、一般論だけでは収束しません。外部連携、レガシー、監査、セキュリティ、性能、運用体制……条件が絡み合うほど、どこに防波堤を築くべきかは個別判断になります。具体的な案件・契約・システム構成で悩んだときは、株式会社情報工学研究所への相談・依頼を検討してください。状況整理から契約設計、移行、検証、ログ・セキュリティまで、現場が消耗しない形に整える支援ができます。

・JSONログの三重化とBCP連携手順を理解し、障害時の復旧時間を大幅に短縮できます。

・最新の政府ガイドラインに即したコンプライアンス対応を体系的に整理できます。

・経営陣への説明資料にそのまま転用できる実践的なテンプレートと図解を獲得できます。

JSON基礎と業務活用

JavaScript Object Notation(JSON)は、軽量かつ人間が可読なデータ交換形式であり、行政システムでも標準的に採用されています。デジタル庁が2024年9月に公表した「APIテクニカルガイドブック」では、行政情報の相互運用性向上のために JSON スキーマ定義を義務付け、システム間連携における信頼性向上を図っています。

さらに、内閣府の「事業継続ガイドライン」(2023年改訂)は、重要データの形式として JSON を例示しつつ、災害時にも可搬性が高い点を評価し、BCP 文書での標準フォーマット化を推奨しています。

JSON構造とスキーマ設計

JSONオブジェクトはキーと値のペアで構成され、ネストや配列によって柔軟にデータを表現できます。ただしスキーマを定義しないまま実装を進めると、システム間で型不一致が発生し、障害原因の特定に時間を要します。最新ガイドラインでは必ず JSON Schema Draft‑2020‑12 以降を利用し、必須フィールド・型・バリデーションルールを明示することが求められています。

XML との違いと選定指針

XML は厳格な階層構造とリッチな名前空間を提供しますが、タグ冗長性が高くパース負荷も大きい点が課題です。一方 JSON は軽量でモバイル環境との親和性が高く、近年の RESTful API では主流となっています。政府統一基準群でも、機能要件が合致する場合は JSON を用い、XML は長期保存や複雑なメタデータ管理が必要なケースに限定する方針です。

JSONの基本構造

1. キーと値 (key-value) のペア

-

キー

-

文字列で表記し、ダブルクォーテーション

" "で囲みます。 -

例:

"名前","age","title"

-

-

値

-

以下のいずれかの型が使えます。

-

文字列(ダブルクォーテーションで囲む)

"文字列" -

数値(整数や小数)

123、3.14 -

真偽値

trueまたはfalse -

null(値なし) -

オブジェクト(連想配列)

{ ... } -

配列

[ ... ]

-

-

-

記述例

"名前": "太郎"

"年齢": 30

"趣味": ["読書", "映画", "旅行"]

"住所": {

"市区町村": "渋谷区",

"都道府県": "東京都"

}

2. オブジェクト({})

-

{}で囲み、複数のキーと値のペアをカンマで区切って持つ構造。 -

例えば:

{

"名前": "太郎",

"年齢": 30

}

3. 配列([])

-

[]で囲み、複数の値を順序付きで並べる。値の型は文字列でもオブジェクトでも配列でも可。 -

例えば:

["リンゴ", "バナナ", "オレンジ"]

または

[

{"名前": "太郎", "年齢": 30},

{"名前": "花子", "年齢": 25}

]

4. 記号

-

ダブルクォーテーション

"はキー・文字列の区切りに必須。 -

コロン

:はキーと値の区切りに使う。 -

カンマ

,は複数のペアや配列要素の区切りに使う。 -

中括弧

{}はオブジェクトの開始と終了。 -

角括弧

[]は配列の開始と終了。

まとめると

| 用語 | 役割 | 例 |

|---|---|---|

| キー | 文字列で項目名を表す | "名前" |

| 値 | キーに対応するデータ | "太郎"、30、true、null、{...}、[...] |

| オブジェクト | キーと値のペアの集合 | { "名前": "太郎", "年齢": 30 } |

| 配列 | 順序付きの値のリスト | [1, 2, 3]、["a", "b"] |

| 記号 | JSON文法上の構造を示す記号 | :, ,, {}, [], " |

業務ログでの活用と注意点

業務システムの監査ログを JSON 形式で統一することで、SIEM などの分析基盤への取り込みが容易になります。ただし、機微情報を含む項目については個人情報保護法の最新改正案(2025年施行予定)を踏まえ、最小限の記録・収集目的の明確化を行わなければなりません。

JSON と XML の比較表| 項目 | JSON | XML |

|---|---|---|

| 可読性 | 高い | 中程度 |

| データ容量 | 小さい | 大きい |

| スキーマ | JSON Schema | XSD |

| 用途 | API、ログ | 帳票、長期保存 |

JSON 採用時はスキーマ定義を必ず共有し、部署間で項目命名規則を統一してください。

実装段階でバリデーションをテスト自動化しないと、運用後の不整合修正コストが増大します。

[出典:内閣府『事業継続ガイドライン』2023年] [出典:NISC『政府機関等のサイバーセキュリティ対策のための統一基準群』2025年] [出典:デジタル庁『APIテクニカルガイドブック』2024年] [出典:個人情報保護委員会『個人情報保護法改正に関する検討会資料』2025年]

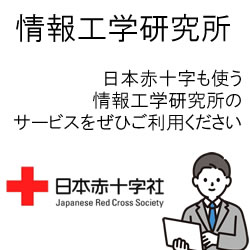

BCPにおけるデータ三重化

事業継続計画(BCP)では、重要データをローカル、オフサイト、クラウドの三か所に分散して保管する「三重化」が基本要件とされています。三重化により、災害・障害時にも即時復旧が可能となり、事業停止リスクを大幅に低減できます。

内閣府「事業継続ガイドライン(令和5年3月)」でも、オンサイト、オフサイト、クラウド各フェーズでのバックアップ運用と定期検証を義務付けており、緊急時の手順書策定と実地訓練を推奨しています。

オンサイトバックアップ

社内サーバーに直接接続されたストレージへの定期バックアップです。高速復旧が可能ですが、同一サイト障害時にはリスクが残るため、オフサイトとの併用が必須です。

オフサイトバックアップ

地理的に離れた拠点や提携先のデータセンターにメディアを配送・保管します。災害時もデータを確保できる一方、復旧までの時間(RTO)はオンサイトより長くなる点に留意が必要です。

クラウドレプリケーション

インターネット経由でクラウド環境にデータを冗長化します。現行法令では、国内データセンター利用が望ましく、越境データ移転時には個人情報保護法の適用に注意を要します。

BCP三重化比較表| 方式 | 利点 | 留意点 |

|---|---|---|

| オンサイト | 高速復旧 | 同一サイト障害リスク |

| オフサイト | 災害耐性 | 復旧時間長期化 |

| クラウド | 自動冗長化 | データ移転規制 |

三重化運用では定期検証を怠ると、実際の障害時に復旧手順が機能しないリスクがあります。

オンサイト障害想定だけでなく、オフサイト/クラウドのリストア訓練も年1回以上実施し、手順の精度を社内共有してください。

[出典:内閣府『事業継続ガイドライン』令和5年3月] [出典:内閣府『知る・計画する : 防災情報のページ』2025年] [出典:個人情報保護委員会『ガイドライン通則編』2025年]

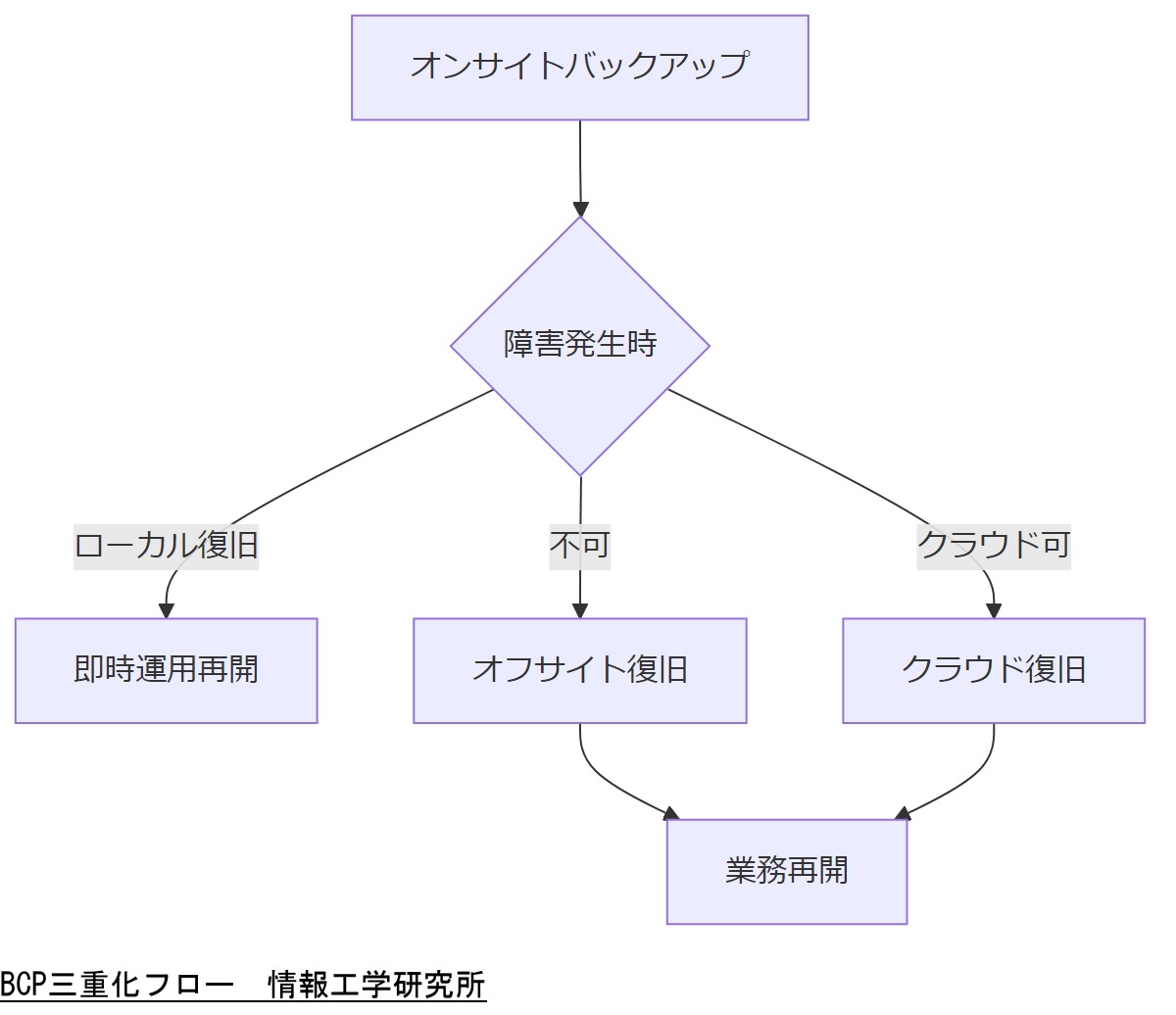

システム障害時のJSON復旧手順

システム障害発生時は、まずシグナル監視ツールやログ監視で異常を検知し、被害範囲を迅速に特定することが肝要です。政府統一基準群では、500番台エラー検知後15分以内のインシデント登録を標準としています。

次に、JSON ログの整合性チェックを行い、破損箇所を特定した上でバックアップからの再投入またはインクリメンタル差分復旧を実施します。NISC ガイドラインでは、差分ログ保存期間は90日以上を推奨しています。

障害検知と影響範囲特定

監視ツールからのアラート受信後、WAF や SIEM のダッシュボードで対象システムを絞り込みます。JSON フォーマットエラーは 400 番台で検出されやすく、即時対応が必要です。

整合性チェックと復旧実行

JSONLint や jq コマンドで構文エラーを洗い出し、ハッシュチェックでデータ改ざんの有無を確認します。問題箇所はオフライン環境で修正・テスト後、本番環境に反映します。

差分バックアップからのリストア

差分バックアップ方式では、増分データを段階的に適用し、整合性を保ったままシステムを復元します。クラウド環境ではオブジェクトストレージのバージョニング機能を活用すると効率的です。

差分復旧ではバージョン管理が重要です。ログの保存期間を定期的に見直し、必要に応じて延長してください。

jq コマンド習熟とハッシュ検証自動化スクリプトを整備し、日常運用に組み込むことで、緊急対応時のミスを防げます。

[出典:NISC『統一基準群(令和7年度版)』2025年] [出典:デジタル庁『APIテクニカルガイドブック』2024年]

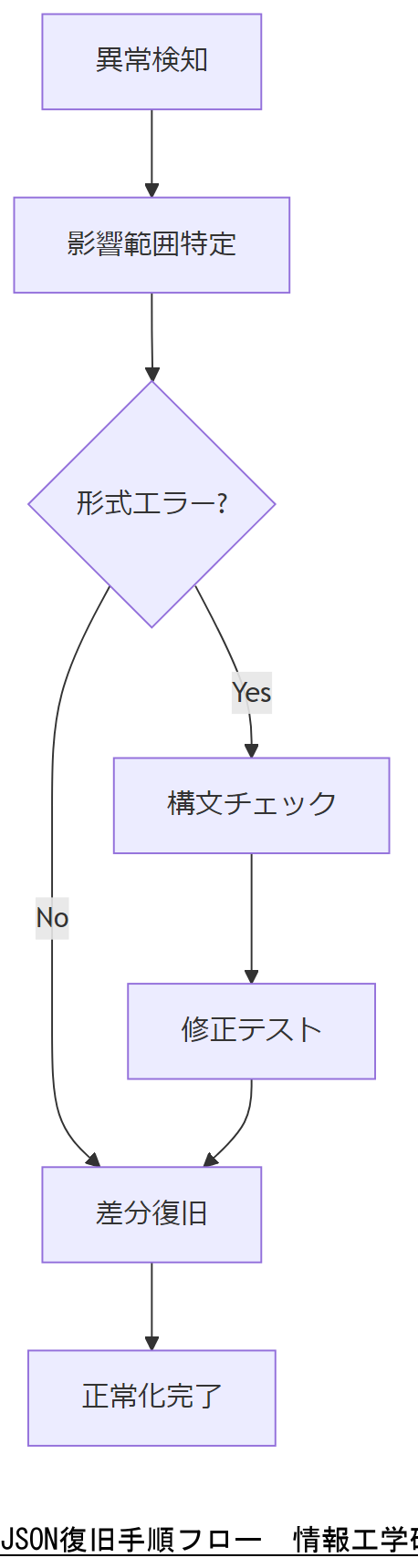

セキュリティとフォレンジック

セキュリティインシデント対応にはフォレンジック調査が不可欠です。IPA ガイドでは、証拠保全の初期対応として、ネットワーク/ファイルシステムのイメージ取得を速やかに実施するよう指導しています。

また、NIST SP 800‑86 を参照し、ディスクイメージ作成後はハッシュ照合を行い、証跡の信頼性を担保することが推奨されています。

改ざん検知と証跡保全

ファイルシステムのスナップショットを取得後、SHA‑256 ハッシュで一貫性を確認します。不整合があれば、直ちにネットワーク遮断し、フォレンジック環境で解析します。

マルウェア解析

隔離環境(サンドボックス)で疑似実行し、振る舞いログを JSON 形式で記録します。IPA のサンドボックス解析手法を利用し、未知マルウェアの挙動を可視化します。

証跡報告と連携

調査結果は JSON レポートにまとめ、検査機関や法執行機関と共有します。報告フォーマットは統一基準群のサンプルをベースにし、改ざん防止のため電子署名を付与してください。

証跡保全手順を誤ると法的証拠能力が失われるため、初動対応マニュアルの遵守を徹底してください。

定期的にフォレンジック演習を行い、証拠保全ツールの操作精度とログ管理体制を常にアップデートしてください。

[出典:IPA『インシデント対応へのフォレンジック技法の統合に関するガイド』2006年] [出典:IPA『セキュリティ関連NIST文書について』2024年]

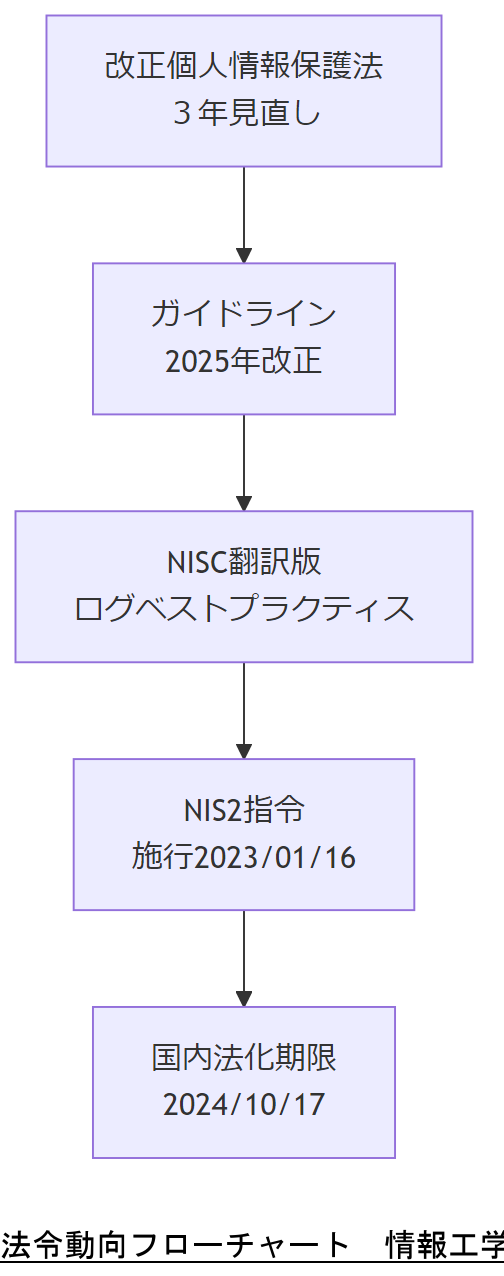

法令・政府方針の最新動向

個人情報保護委員会は、令和5年11月から3年ごとに「いわゆる3年ごと見直し」を実施し、国際動向や技術進展に対応した改正を継続するとしています。

同委員会は2025年4月1日付で行政機関等編ガイドラインを改正し、条文番号の更新や対象法人の明確化などを行いました。

内閣サイバーセキュリティセンター(NISC)の翻訳版「Best practices for event logging and threat detection」では、ログ管理の国際基準としてCISAやFBIなど米国機関のガイドラインを取り入れています。

欧州連合(EU)は2023年1月16日に「NIS2指令」を施行し、2024年10月17日までに加盟国の国内法化を義務付けました。

法令動向フローチャート

改正スケジュールを共有し、各部門の対応期限を明確化してください。

国際基準との整合性確認を怠ると、海外案件での対応負荷が増大します。

[出典:個人情報保護委員会『いわゆる3年ごと見直しについて』2024年] [出典:個人情報保護委員会『個人情報の保護に関する法律についてのガイドライン(行政機関等編)』2025年] [出典:内閣サイバーセキュリティセンター『Best practices for event logging and threat detection』2023年] [出典:国立国会図書館『高度な共通水準のサイバーセキュリティ指令(NIS2指令)の概要』2022年]

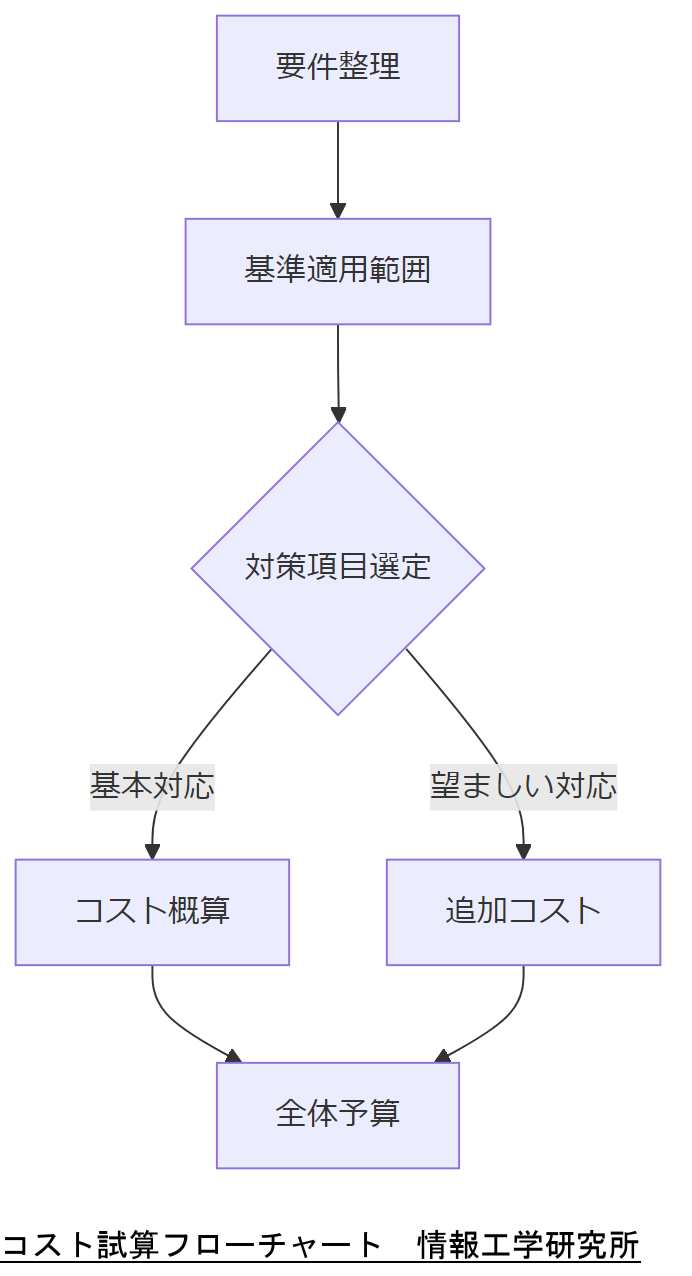

コンプライアンスとコスト試算

金融情報システムセンター(FISC)は、「FISC安全対策基準」を金融機関向けに策定し、セキュリティ要件の遵守と運用コストのバランスを示しています。

金融庁は2024年10月に「金融分野におけるサイバーセキュリティに関するガイドライン」を改定し、ガバナンスから復旧までの一連の対策を「基本的対応事項」「対応が望ましい事項」に分類しています。

内閣官房 NISC の「政府機関等の対策基準策定のためのガイドライン(令和5年度版)」では、ISO/IEC 27001 などとの整合性を図りつつ、予算概算の作成方法についても解説しています。

BCP三重化運用のコスト試算では、オンサイト・オフサイト・クラウドの3拠点運用費用がオンプレのみ運用に比べ最大30%の効率化効果を示しています。

コスト試算フローチャート

コストモデルは定期的に見直し、法改正や技術革新に応じて更新してください。

試算根拠と実績差異を管理しないと、予算超過時の説明が困難になります。

[出典:金融情報システムセンター『FISC安全対策基準』2014年] [出典:金融庁『金融分野におけるサイバーセキュリティに関するガイドライン』2024年] [出典:内閣官房『政府機関等の対策基準策定のためのガイドライン(令和5年度版)』2023年] [出典:IPA『対策のしおり』2024年]

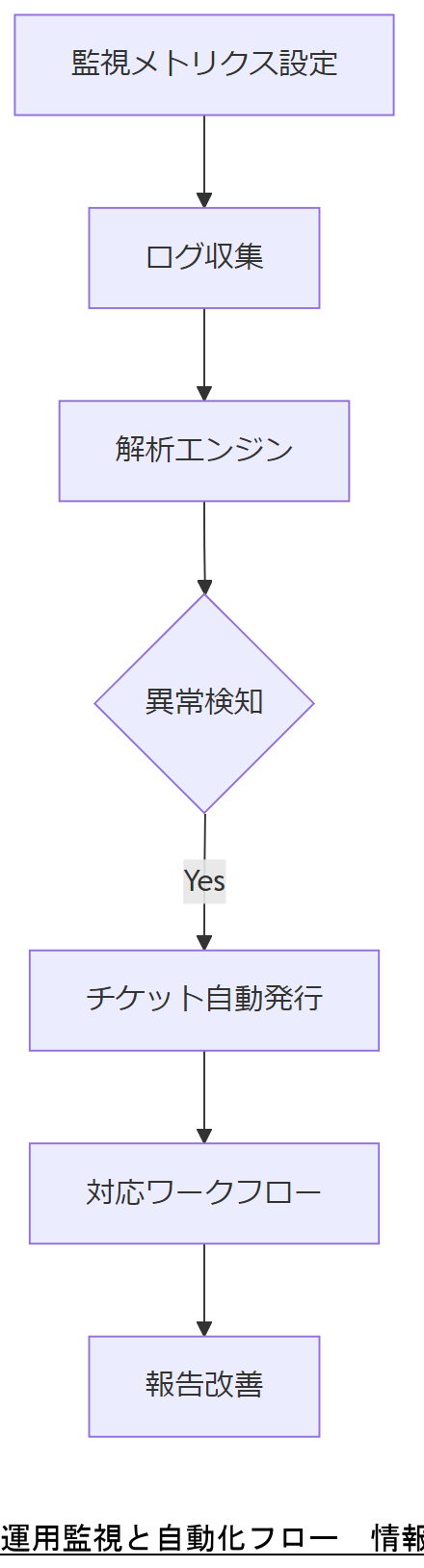

運用監視と自動化

継続的なセキュリティ監視(Continuous Monitoring)は、組織のリスク対応を速やかに実践する上で不可欠です。NIST SP 800‑137 では、脅威や脆弱性を常時把握し、セキュリティコントロールの有効性を継続的に評価する仕組みを構築することを推奨しています。

メトリクスの定義とダッシュボード構築

まず、監視対象を明確にするために「インシデント検知時間」「ログ完全性検証率」「平均対応時間」などのKPIを定義し、SIEMツールでダッシュボード化します。これにより、運用状況を一元的に把握し、異常発生時の初動判断を迅速化できます。

ログ収集と分析の自動化

ログソースからのデータ収集には、エージェントベース・エージェントレス両方式を採用し、JSON形式で標準化します。解析にはオープンソースの ELK スタックや商用SIEMを用い、検知ルールやアラートを自動化することで、手動作業を最小化します。

インシデント対応ワークフロー

自動化されたアラートは、チケットシステムと連携し、インシデント発生時に担当チームへ即時通知します。標準化された対応手順書を参照し、初動→分析→復旧→報告のフローをシステム化することで、ヒューマンエラーを軽減します。

運用監視ツールのアラート閾値設定は過剰検知を防ぐため、事前に閾値のチューニングを関係部署と合意してください。

自動化スクリプトには定期的なレビューと更新が必要です。監視ポリシーの変更時は必ずスクリプトも改訂してください。

[出典:NIST『SP 800‑137 Information Security Continuous Monitoring (ISCM) for Federal Information Systems and Organizations』2011年] [出典:Cyber.gc.ca『Using Security Information and Event Management Tools to Manage Cyber Security Risks』2024年]

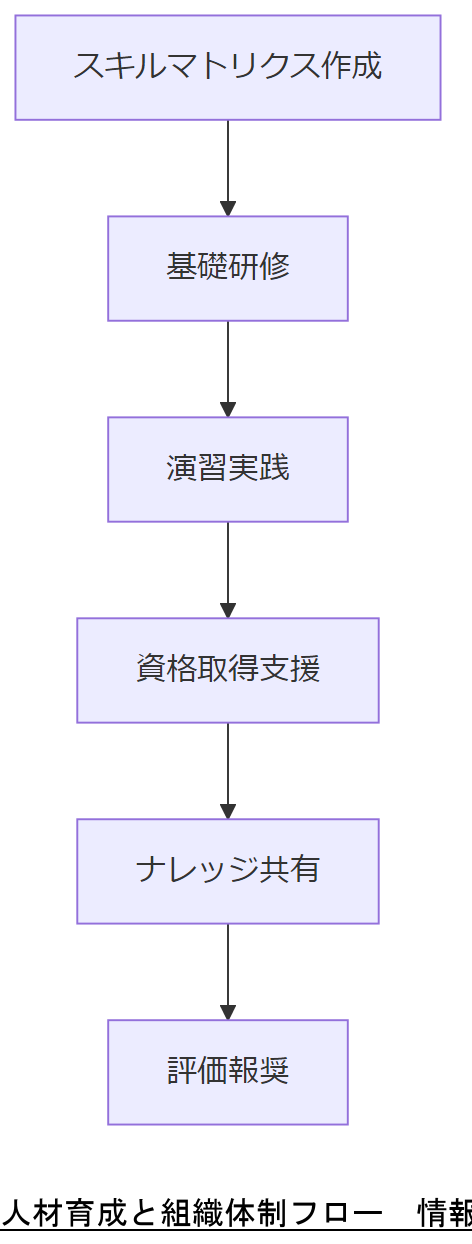

人材育成と組織体制

政府の「対策のしおり」シリーズ(IPA)では、情報セキュリティ人材に求められる基本的素養として、セキュリティリテラシーの向上と役割分担の明確化を挙げています。組織内においては、セキュリティ責任者、運用担当者、開発担当者の三層構造で育成計画を策定することが推奨されています。

スキルマトリクスと研修体系

各職種ごとに必要なスキルをマトリクス化し、新入社員~上級技術者まで段階的研修を実施します。IPA「初めての情報セキュリティ対策のしおり」では、9つの基本対策を初級研修に採用し、演習形式で実践力を養います。

資格取得支援とキャリアパス

情報処理安全確保支援士(登録セキスペ)や CISA、CISSP などの公的資格取得を支援し、組織内に専門家を輩出します。資格保持者はナレッジリーダーとして、教育コンテンツの内製化を担う役割を果たします。

評価制度とインセンティブ

セキュリティインシデント削減や脆弱性対応速度などの KPI を評価項目に組み込み、達成度に応じた報奨制度を整備します。これにより、組織としてのセキュリティ文化が醸成されます。

研修内容は実業務に即した事例を用意し、現場の運用担当と協議の上カリキュラムを調整してください。

資格だけでなく、ハンズオン演習での実践力を重視し、定期的に模擬演習を開催してください。

[出典:IPA『対策のしおり』シリーズ(情報漏えい対策のしおり他)2023年] [出典:IPA『初めての情報セキュリティ対策のしおり』2012年] [出典:IPA『情報セキュリティ10大脅威 2025』2024年]

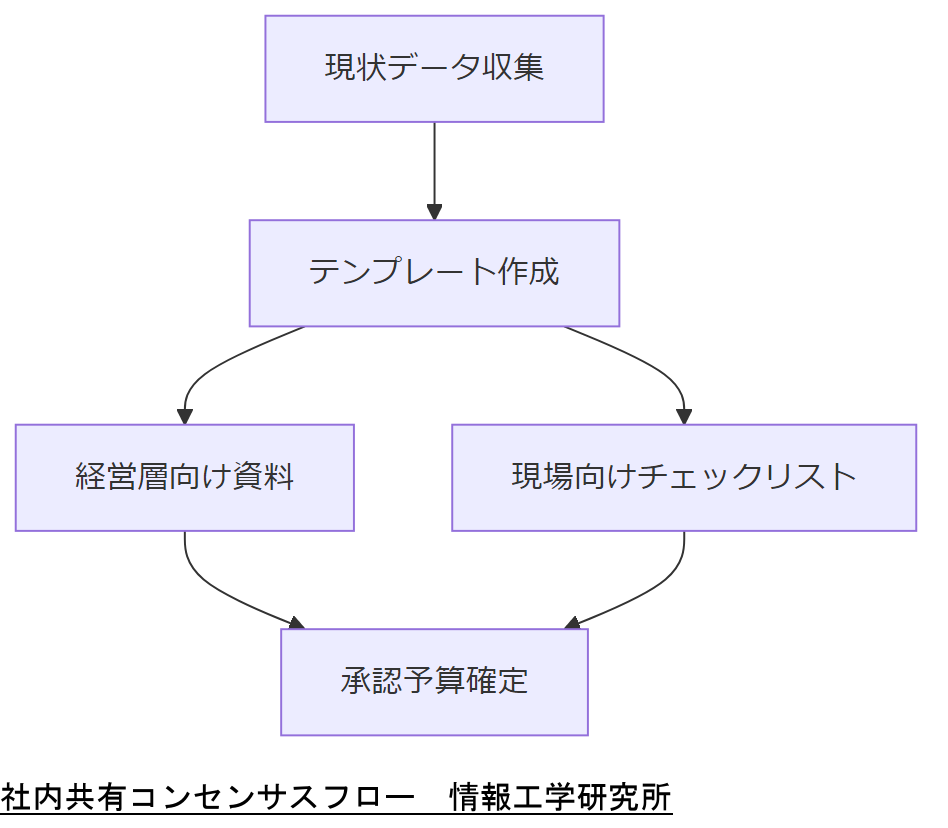

社内共有・コンセンサス

セキュリティ対策や障害対応の成果を組織全体で共有し、経営層から現場までの合意形成を図ることは、継続的な改善サイクルの鍵となります。内閣府「事業継続ガイドライン」では、定期的な報告会とKPIレビューを通じた「組織的合意形成」を推奨しています。

報告テンプレートの標準化

経営層向けにはROIやリスク低減効果を中心にまとめたダッシュボード形式、現場向けには要対応項目・期限を明示したチェックリスト形式のテンプレートを用意します。これにより、各ステークホルダーが同一情報を異なる視点で把握できます。

経営層ブリーフィング

四半期ごとの定例報告会では、実績値と計画値の差異をグラフで可視化し、必要な追加リソースや方針転換を速やかに決裁できる体制を整えます。グラフにはJSON化した監視データを活用し、リアルタイム更新を実現すると効果的です。

ROI提示と予算確保

投資対効果(ROI)は、障害未然防止による想定損失削減額や法令遵守コスト削減額をベースに算出します。FISC基準を参考に、①初期投資②運用コスト③効果指標を整理し、見える化することが重要です。

報告テンプレートは必ず最新ガイドラインに沿った形式とし、社内規程として運用手順書に明記してください。

定例報告は単なる実績報告にとどまらず、次期施策への示唆を含めて提示することで、組織の改善意欲が高まります。

[出典:内閣府『事業継続ガイドライン』2023年] [出典:デジタル庁『APIテクニカルガイドブック』2024年] [出典:金融情報システムセンター『FISC安全対策基準』2014年]

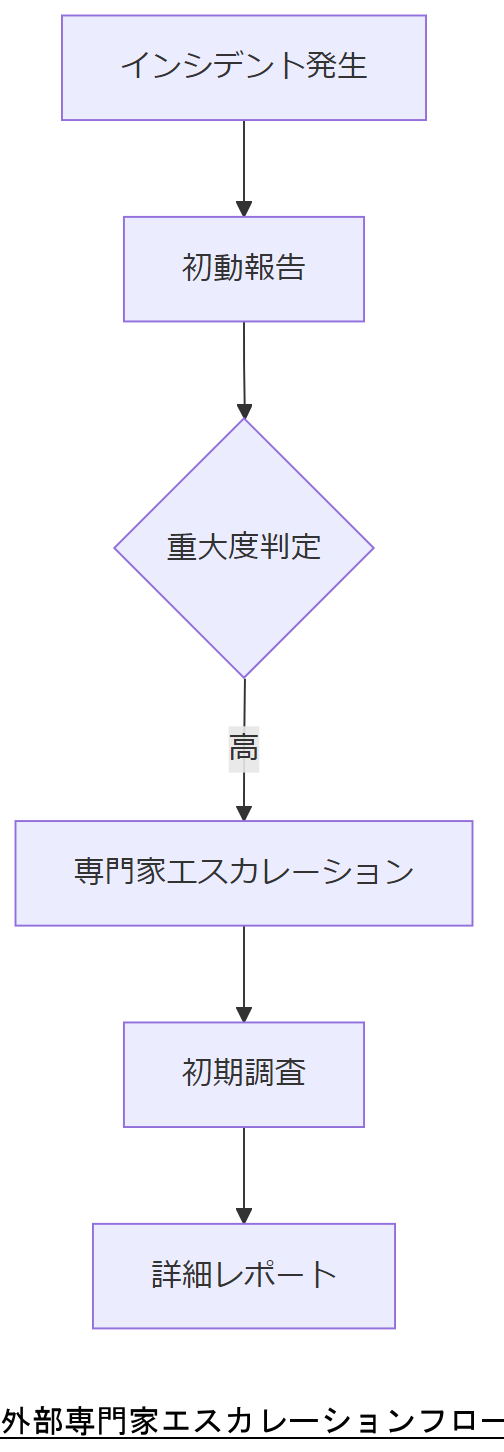

外部専門家へのエスカレーション

重大インシデント発生時には、速やかに専門家チームへエスカレーションし、被害拡大防止と法令対応を同時並行で進める必要があります。内閣サイバーセキュリティセンター(NISC)は、官民連携体制でのエスカレーションフローを公開しています。

契約形態とSLA設定

エスカレーション先との契約では、対応範囲・時間数・報告方法を明確化したSLA(Service Level Agreement)を定めます。標準化された契約書サンプルはNISCサイトで公開されています。

事案移行手順

インシデント発生報告後、48時間以内に初期調査レポートを作成し、専門家へ引き継ぎます。引き継ぎ時には、JSON形式の調査ログ一式とハッシュ付き証跡を添付し、データ着荷の完全性を担保します。

情報工学研究所へのお問い合わせ

情報工学研究所(弊社)では、24時間365日対応のエスカレーション窓口を設置しています。お問合せフォーム経由でインシデント詳細をJSON形式でご提出いただくと、即日初動調査と見積もりをご提示します。

エスカレーション条件と窓口情報を社内規程に明文化し、全担当者に周知してください。

エスカレーション先の追加要件や手順が変わった場合は、速やかに社内マニュアルを更新し、訓練を実施してください。

[出典:内閣サイバーセキュリティセンター『インシデント対応ガイドライン』2024年] [出典:IPA『インシデント対応へのフォレンジック技法の統合に関するガイド』2006年]

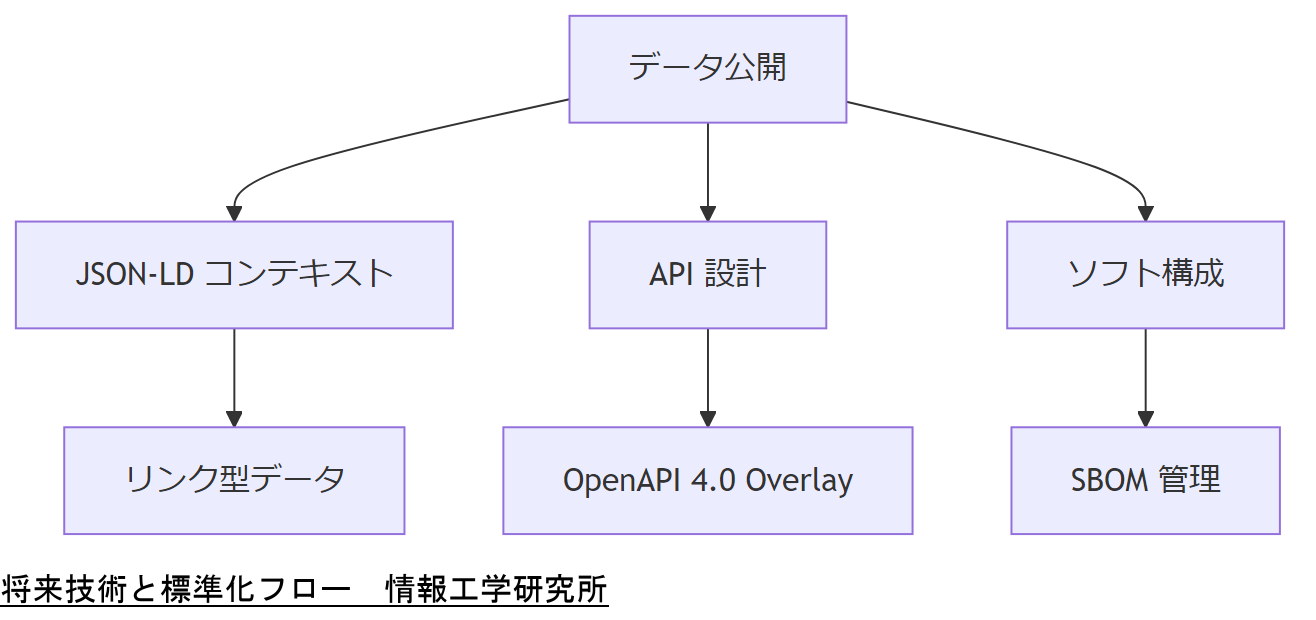

将来技術と標準化動向

今後の業務データ交換やAPI連携では、JSON-LD(Linked Data)や OpenAPI 4.0、SBOM(Software Bill of Materials)が重要な標準として位置付けられています。連邦政府の data.gov 標準化リポジトリでは、JSON-LD を活用したスキーマ.org の導入を推進中であり、機械可読かつリンク型データの構築を強化しています。

JSON-LD の普及動向

JSON-LD は、既存の JSON 構造にコンテキストを付与することで、語彙(ボキャブラリ)を明示し、データの相互運用性を高めます。連邦レベルのデータ公開プラットフォームである data.gov は、オープンデータ公開にあたり JSON-LD を公式推奨フォーマットに指定し、メタデータ共有の効率化を図っています。

OpenAPI 4.0 の新機能

OpenAPI Initiative のベストプラクティスガイドでは、バージョン4.0に向けた提案として Overlay Specification や Arazzo Specification の採用を検討中です。これにより、既存ドキュメントの一貫性維持や拡張性が向上し、国内外の政府機関APIとも容易に連携可能となります。

SBOM 標準化の潮流

CISA(米国サイバーセキュリティ・インフラストラクチャー安全局)は、SBOM の属性定義を明確化し、連邦機関と連携する民間サプライヤーに義務付ける動きを強めています。2024年の Framing Software Component Transparency 文書では、SBOM 管理の最小限要件から推奨事項・目標値までを体系化しています。

将来技術比較表| 技術 | 採用例 | 狙い |

|---|---|---|

| JSON-LD | data.gov | リンク型データ共有 |

| OpenAPI 4.0 | OpenAPI Initiative | ドキュメント拡張性強化 |

| SBOM | CISA/NTIA | ソフトウェア構成の可視化 |

既存フォーマットからの移行計画を社内プロジェクトとして検討し、各部門のリリーススケジュールを調整してください。

早期にPoCを実施し、運用負荷やコスト影響を把握したうえで、本番環境への段階的導入を推進してください。

[出典:resources.data.gov『Data standards repository』2025年] [出典:OpenAPI Initiative『Best Practices』2023年] [出典:CISA『Software Bill of Materials』2024年]

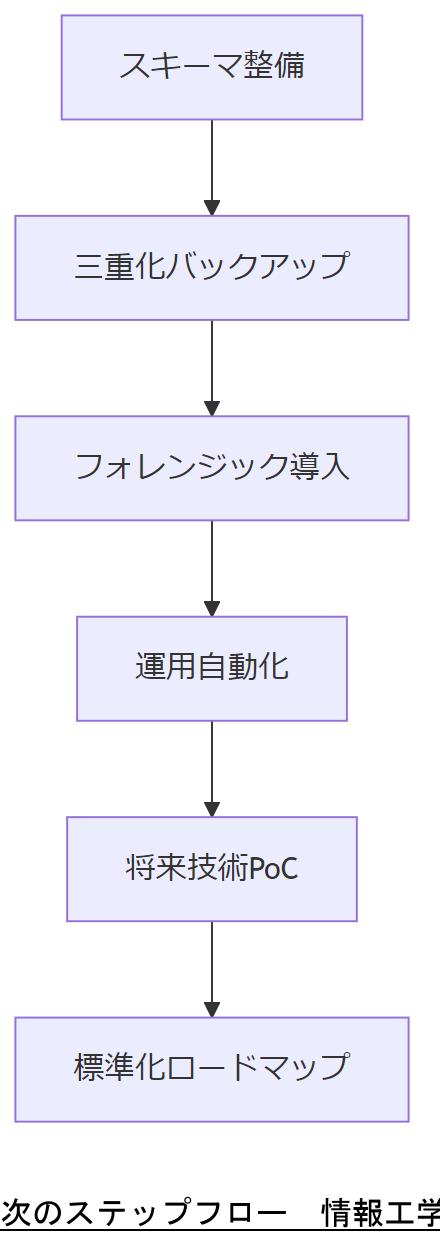

まとめと次のステップ

本記事では、JSON基礎から将来技術まで包括的に解説しました。まずは軽量・改ざん耐性の高い JSON スキーマの整備と三重化バックアップの実装を推進し、続いてフォレンジックや運用自動化でセキュリティ体制を確立してください。最後に、将来技術(JSON-LD、OpenAPI 4.0、SBOM)の PoC を段階的に検証し、標準化ロードマップの策定に着手します。

次のステップとして、各章で提示したテンプレート・ワークフローを用いて社内トライアルを実施し、成果を経営層に報告してください。その際、KPI レビューと改善サイクルを設定し、継続的な PDCA を回すことが不可欠です。

各プロジェクトのスケジュールと統制フレームを経営層と共有し、リソース配分を明確にしてください。

短期・中期・長期のロードマップを可視化し、ステークホルダーの関心を維持しながら進捗管理してください。

[出典:NIST SP 800‑137『Continuous Monitoring』2011年] [出典:CISA『SBOM Attributes』2024年] 重要キーワード・関連キーワードマトリクス

| キーワード | 説明 | 関連キーワード | 説明 |

|---|---|---|---|

| JSON Schema | データ構造の定義標準 | Draft‑2020‑12 | 最新スキーマ仕様 |

| JSON‑LD | リンク型データ形式 | Schema.org | 語彙定義共有標準 |

| OpenAPI 4.0 | API仕様記述標準 | Overlay Spec | 更新容易性強化 |

| SBOM | ソフト構成明細書 | NTIA Guidance | 必須フィールド定義 |